“情感计算”的版本间的差异

(→集智课程) |

(→机器中的情感) |

||

| 第59行: | 第59行: | ||

| − | 人工智能领域的计算机科学先驱之一[https://zh.wikipedia.org/wiki/%E9%A9%AC%E6%96%87%C2%B7%E9%97%B5%E6%96%AF%E5%9F%BA 马文•明斯基 | + | 人工智能领域的计算机科学先驱之一[https://zh.wikipedia.org/wiki/%E9%A9%AC%E6%96%87%C2%B7%E9%97%B5%E6%96%AF%E5%9F%BA 马文•明斯基 Marvin Minsky]在[[wikipedia:The_Emotion_Machine|《情绪机器(The Emotion Machine)》]]一书中将情绪与更广泛的机器智能问题联系起来。他在书中表示,情绪“与我们所谓的‘思考’过程并没有特别的不同。'"<ref name=":6">{{cite news|url=https://www.washingtonpost.com/wp-dyn/content/article/2006/12/14/AR2006121401554.html|title=Mind Over Matter|last=Restak|first=Richard|date=2006-12-17|work=The Washington Post|access-date=2008-05-13}}</ref> |

| − | |||

== 技术 == | == 技术 == | ||

2021年8月29日 (日) 00:23的版本

情感计算 Affective computing (也被称为人工情感智能或情感AI)是基于系统和设备的研究和开发来识别、理解、处理和模拟人的情感。这是一个融合计算机科学、心理学和认知科学的跨学科领域[1]。虽然该领域的一些核心思想可以追溯到早期对情感[2] 的哲学研究,但计算机科学的现代分支研究起源于罗莎琳德·皮卡德1995年关于情感计算的论文[3]和她的由麻省理工出版社[4][5]出版的《情感计算》[6]。这项研究的动机之一是赋予机器情感智能,包括具备同理心。机器应能够解读人类的情绪状态,适应人类的情绪,并对这些情绪作出适当的反应。

研究范围

检测和识别情感信息

检测情感信息通常从被动式传感器开始,这些传感器捕捉关于用户身体状态或行为的数据,而不解释输入信息。收集的数据类似于人类用来感知他人情感的线索。例如,摄像机可以捕捉面部表情、身体姿势和手势,而麦克风可以捕捉语音。一些传感器可以通过直接测量生理数据(如皮肤温度和电流电阻)来探测情感信号[7]。

识别情感信息需要从收集到的数据中提取出有意义的模式。这通常要使用多模态机器学习技术,如语音识别、自然语言处理或面部表情检测等。大多数这些技术的目标是给出与人类感情相一致的标签: 例如,如果一个人做出皱眉的面部表情,那么计算机视觉系统可能会被教导将他们的脸标记为“困惑”、“专注”或“轻微消极”(与象征着积极的快乐微笑相反)。这些标签可能与人们的真实感受相符,也可能不相符。

机器中的情感

情感计算的另一个研究领域是设计出能够展示天然的感情(或令人信服地模拟情感)的计算设备。基于当前的技术,一个更加可行的方法是模拟对话机器人的情感,以丰富和促进人与机器之间的互动[8]。

人工智能领域的计算机科学先驱之一马文•明斯基 Marvin Minsky在《情绪机器(The Emotion Machine)》一书中将情绪与更广泛的机器智能问题联系起来。他在书中表示,情绪“与我们所谓的‘思考’过程并没有特别的不同。'"[9]

技术

在心理学、认知科学和神经科学中,描述人类如何感知和分类情绪的方法主要有两种: 连续的和分类的。连续的方法倾向于使用诸如消极与积极、平静与激动之类的维度。

分类方法倾向于使用离散的类别,如快乐,悲伤,愤怒,恐惧,惊讶,厌恶。不同类型的机器学习回归和分类模型可以用于让机器产生连续或离散的标签。有时还会构建跨类别组合的模型,例如 一张高兴而惊讶的脸或一张害怕而惊讶的脸。[10]

接下来将讨论用于情感识别的不同种类的输入数据。

语音情感

自主神经系统的各种变化可以间接地改变一个人的语言,情感技术可以利用这些信息来识别情绪。例如,在恐惧、愤怒或高兴的状态下发言变得快速、响亮、清晰,音调变得越来越高,音域越来越宽;而诸如疲倦、厌倦或悲伤等情绪往往会产生缓慢、低沉、含糊不清的语音[11]。有些情绪更容易被计算识别,比如愤怒[12] 或赞同[13]。

情感语音处理技术通过对语音特征的计算分析来识别用户的情感状态。通过模式识别技术[12][14]

可以分析声音参数和韵律特征,如音调高低和语速等。

语音分析是一种有效的情感状态识别方法,在最近的研究中,语音分析的平均报告准确率为70%-80%.[15][16]。这些系统往往比人类的平均准确率(大约60%[12])更高,但是不如使用其他情绪检测方式准确,比如生理状态或面部表情。然而,由于许多言语特征是独立于语义或文化的,这种技术被认为是一个很有前景的研究方向。

算法

语音/文本的情感检测程需要创建可靠的数据库、知识库或者向量空间模型[17],为了适应各种应用,这些数据库的范围需要足够广泛;同时还需要选择一个又快又准的分类器,这样才能快速准确地识别情感。

目前常用的分类器有线性判别分类器(LDC)、 k- 近邻分类器(k-NN)、高斯混合模型(GMM)、支持向量机(SVM)、人工神经网络(ANN)、决策树算法和隐马尔可夫模型(HMMs)。各种研究表明,选择合适的分类器可以显著提高系统的整体性能。下面的列表给出了每个算法的简要描述:

- LDC:特征以向量形式表示,通过计算特征的线性组合来分类。

- k-NN:计算并选取特征空间中的点,将其与k个最近的数据点相比较,频数最大的类即为分类结果。

- GMM:是一种概率模型,用于表示总体中子群的存在。 利用特征的多个高斯概率密度函数混合来分类[18]。

- SVM:是一种(通常为二分的)线性分类器,它决定每个输入可能属于两个(或多个)可能类别中的哪一个。

- ANN:是一种受生物神经网络启发的数学模型,能够更好地处理特征空间可能存在的非线性。

- 决策树算法:在一颗树中,每个叶子结点都是一个分类点,分支(路径)代表了一系列相邻接的特征,最终引向叶子节点实现分类。

- HMMs:一种统计马尔可夫模型,其中的状态和状态转变不能直接用于观测。相反,依赖于状态的一系列输出是可见的。在情感识别领域,输出代表了语音特征向量的序列,这样可以推导出模型所经过的状态序列。这些状态包括情感表达中的各中间步骤,每个状态在输出向量上都有一个概率分布。状态序列是我们能够预测正在试图分类的情感状态,这也是语音情感识别中最为常用的技术之一。

研究证明,如果有足够的声音样本,人的情感可以被大多数主流分类器所正确分类。分类器模型由三个主要分类器组合而成: kNN、 C4.5和 SVM-RBF 核。该分类器比单独采集的基本分类器具有更好的分类性能。另外两组分类器为:1)具有混合内核的一对多 (OAA) 多类 SVM ,2)由C5.0 和神经网络两个基本分类器组成的分类器组,所提出的变体比这两组分类器有更好的性能[19]。

数据库

绝大多数现有系统都依赖于数据。 选择一个恰当的数据库来训练分类器因而成为语音情感识别的首要问题。 目前拥有的大部分数据都是从演员那里获得的,都是一些典型的情绪表现。这些所谓的行为数据库通常是基于基本情绪理论(保罗 · 埃克曼) ,该理论假定存在六种基本情绪(愤怒、恐惧、厌恶、惊讶、喜悦、悲伤) ,其他情绪只是前者的混合体[20]。尽管如此,这仍然提供较高的音质和均衡的类别(尽管通常太少),有助于提高识别情绪的成功率。

然而,对于现实生活应用,自然数据是首选的。自然数据库可以通过在自然环境中观察和分析对象来产生。最终,自然数据库会帮助系统识别情境下的情绪,也可以用来发现交互的目标和结果。由于这类数据的自然性,可以真实自然地反映人机交互下的情感状态,也就可以应用于现实生活中的系统实现。

尽管自然数据比表演数据具有许多优势,但很难获得并且通常情绪强度较低。此外,由于环境噪声的存在、人员与麦克风的距离较远,在自然环境中获得的数据具有较低的信号质量。埃尔朗根-纽约堡大学的AIBO情感资料库(FAU Aibo Emotion Corpus for CEICES, CEICES: Combining Efforts for Improving Automatic Classification of Emotional User States)是建立自然情感数据库的首次尝试,其采集基于10—13岁儿童与索尼AIBO宠物机器人玩耍的真实情境。[21]同样,在情感研究领域,建立任何一个标准数据库,都需要提供评估方法,以比较不同情感识别系统的差异。

语音叙词

情感识别过程的复杂性随着分类器中使用的类(情感)和语音叙词的数量的增加而增加。因此,为了保证模型能够成功地识别情绪并提高性能,只选择最相关的特征,这对于实时检测尤为重要。可选择范围很广,有些研究提到使用了200多种不同的特征。识别冗余的情感信息对于优化系统、提高情感检测的成功率至关重要。最常见的言语特征可分为以下几类[21]。

- 频率特性[22]

- 音调形状(Accent shape ):受基础频率变化的影响。

- 平均音调(Average pitch):描述说话者相对于正常语言的音调高低。

- 音调轮廓(Contour slope):描述频率随时间变化的趋势,可以是上升、下降或持平。

- 尾音下降(Final lowering):一段话末尾频率下降的多少。

- 音域(Pitch range):一段话语的最高和最低频率之间的差距。

- 时间相关特征:

- 语速(Speech rate):单位时间内发出词数或音节数。

- 重音频率(Stress frequency):重读发生的频率

- 音质参数和能量叙词:

- 呼吸音(Breathiness):说话中的呼吸噪声

- 亮度(Brilliance):语音中高频和低频的占比

- 响度(Loudness):语音的振幅,亦为话音的能量

- 暂停不连续性(Pause Discontinuity):描述声音和静音之间的转换

- 音调不连续性(Pitch Discontinuity):描述基本频率的转换。

面部情感检测

面部表情的检测和处理通过光流、隐马尔可夫模型、神经网络或主动外观模型等多种方法实现。可以组合或融合多种模态(多模态识别,例如面部表情和语音韵律[23]、面部表情和手势[24],或用于多模态数据和元数据分析的带有语音和文本的面部表情),以提供对受试者情绪的更可靠估计。Affectiva 是一家与情感计算直接相关的公司(由 Rosalind Picard 和 Rana El Kaliouby 共同创办) ,旨在研究面部情感检测的解决方案和软件。

面部表情数据库

情感数据库的建立是一项既困难又耗时的工作。然而,情感数据库是创建识别人类情感的系统的关键步骤。大多数公开的情感数据库只包含摆拍的面部表情,在这样的数据库中,参与者被要求展示不同的基本情绪表情;而在自然表情数据库中,面部表情是自发的。自然表情的发生需要选取恰当的刺激,这样才能引起目标表情的丰富展示。其次,这个过程需要受过训练的工作者为数据做标注,以实现数据库的高度可靠。因为表情及其强度的感知本质上是主观的,专家的标注对验证而言是十分重要的。

研究人员使用三种类型的数据库:峰值表情数据库、中性到峰值的情绪图像序列数据库以及带有情绪注释的视频片段。面部表情数据库是面部表情识别领域的一个重要研究课题,两个广泛使用的数据库是 CK+和 JAFFE。

情感分类

二十世纪六十年代末,保罗·埃克曼 (Paul Ekman) 在巴布亚新几内亚的法雷人部落( Fore Tribesmen) 上进行跨文化研究,提出了一种观点,即情感所对应的面部表情不是由文化决定的,而是普遍存在的。因此,他认为面部表情是生物本能,能够可靠地分类。[20]因此,他在 1972 年正式提出了六种基本情绪[25]:

- 愤怒

- 厌恶

- 恐惧

- 快乐

- 悲伤

- 惊喜

然而,在20世纪90年代,埃克曼扩展了他的基本情绪列表,包括一系列积极和消极的情绪,这些情绪并非都对应于面部肌肉。[26]新增的情绪是:

- 娱乐

- 轻蔑

- 满足

- 尴尬

- 兴奋

- 内疚

- 成就感

- 解脱

- 满足

- 愉悦

- 羞耻

面部行为编码系统

心理学家已经构想出一个系统,用来正式分类脸上情绪的物理表达。面部动作编码系统 (FACS) 的中心概念是由保罗·埃克曼( Paul Ekman )和 华莱士·V·弗里森(Wallace V. Friesen) 在 1978 年基于 Carl-Herman Hjortsjö [27]的早期工作创建的,动作单位 (Action unit, AU)是核心概念。它们基本上是一块或多块肌肉的收缩或放松。心理学家根据他们的行为单位,提出了以下六种基本情绪的分类(这里的“ +”是指“和”) :

| 情感 | 行为单位 |

|---|---|

| 快乐 | 6+12 |

| 悲伤 | 1+4+15 |

| 惊喜 | 1+2+5B+26 |

| 恐惧 | 1+2+4+5+20+26 |

| 愤怒 | 4+5+7+23 |

| 厌恶 | 9+15+16 |

| 蔑视 | R12A+R14A |

面部情感检测的挑战

正如计算领域的多数问题一样,在面部情感检测研究中,也有很多障碍需要克服,以便充分释放算法和方法的全部潜力。在几乎所有基于人工智能的检测(语音识别、人脸识别、情感识别)的早期,建模和跟踪的准确性一直是个问题。随着硬件的发展,数据集的完善,新的发现和新的实践的引入,准确性问题逐渐被解决,留下了噪音问题。现有的去噪方法包括邻域平均法、线性高斯平滑法、中值滤波法,或者更新的方法如菌群优化算法。

其他问题:

- 事实上,大多数研究所使用的摆拍表情是不自然的,因此训练这些算法可能不适用于自然表情。

- 缺乏旋转运动的自由度。正面使用时效果检测效果很好,但在将头部旋转 20 度以上时,就会出现问题[28]。

- 面部表情并不总是与对应的情绪相对应(例如,它们可以摆拍或伪装,或者保持“扑克脸”)。

- FACS 不包括动态,而动态可以帮助消除歧义(例如,真正快乐的微笑往往与“尝试看起来快乐”的微笑具有不同的动态)。

- FACS 组合与心理学家最初提出的情绪并不是一一对应的(这种缺乏 1:1 映射的情况也发生在具有同音异义词和许多其他歧义来源的语音识别中,可能通过引入其他信息渠道来缓解)。

- 通过添加上下文提高了识别的准确性; 然而,添加上下文和其他模式增加了计算成本和复杂性

身体姿势

身体姿态可以有效地检测用户特定的情绪状态,特别是与语音和面部识别结合使用时。根据具体的动作,姿态可以是简单的反射性反应,比如当你不知道一个问题的答案时抬起你的肩膀;或者它们可以是复杂和有意义的,比如当用手语交流时。不需要利用任何物体或周围环境,我们可以挥手、拍手或招手。另一方面,当我们借助外物时,可以指向,移动,触摸或者持握。计算机应该能够识别这些姿态,分析情景并作出响应,以便有效地用于人机交互。

身体姿态检测已经提出了许多方法[29] 。 一些文献提出了姿势识别的两种不同方法:基于 3D 模型和基于外观[30]。最重要的方法是利用人体关键部位的三维信息,获得手掌位置、关节角度等重要参数。另一方面,基于外观的系统直接使用图像或视频进行解释。手势一直是身体姿态检测方法的共同焦点[30]。

生理检测

生理信号可用于检测和分析情绪状态。这些生理信号通常包括脉搏、心率、面部肌肉每分钟收缩频率等。这个领域的发展势头越来越强劲,并且已经有了应用这些技术的实际产品。通常被分析的4个主要生理特征是血容量脉冲、皮肤电反应、面部肌电图和面部颜色。

血容量脉冲

概述

血容量脉搏(BVP)可以通过一个叫做光电容积扫描法的技术来测量,该方法产生一个图表来显示通过四肢的血液流动[31]。记录峰值代表着心搏周期中血流被泵到肢体末端。当被试受到惊吓或感到害怕时,他们往往会心跳加速,导致心率加快,从而在光电容积描记图上可以清楚地看到波峰与波谷间的距离变小。被试平静下来后,血液流回末端,心率回归正常。

方法

红外光通过特殊的传感器硬件照射在皮肤上,测量皮肤反射的光量。因为光线被血液中的血红蛋白吸收,所以反射光的数量与 BVP 相关。

劣势

确保发出红外光并监测反射光的传感器始终指向同一个末端可能很麻烦,尤其是观察对象经常伸展并重新调整其位置时。 还有其他因素会影响血容量脉冲,因为它是对通过四肢的血流量的量度,如果受试者感觉热,或特别冷,那么他们的身体可能允许更多或更少的血液流向四肢,所有这一切都与受试者的情绪状态无关。

面部肌电图

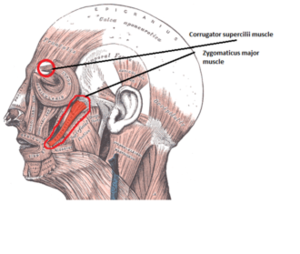

面部肌电图是一种通过放大肌肉纤维收缩时产生的微小电脉冲来测量面部肌肉电活动的技术[32]。面部表达大量情绪,然而,有两个主要的面部肌肉群通常被研究来检测情绪: 皱眉肌和颧大肌。皱眉肌将眉毛向下拉成皱眉,因此是对消极的、不愉快的情绪反应的最好反映。当微笑时,颧大肌负责将嘴角向后拉,因此是用于测试积极情绪反应的肌肉。

皮肤电反应

皮肤电反应(Galvanic skin response,GSR)是一个过时的术语,更一般的现象称为[Electrodermal Activity,皮肤电活动]或 EDA。EDA 是皮肤电特性改变的普遍现象。皮肤受交感神经支配,因此测量皮肤的电阻或电导率可以量化自主神经系统交感神经分支的细微变化。当汗腺被激活时,甚至在皮肤出汗之前,EDA 的水平就可以被捕获(通常使用电导) ,并用于辨别自主神经唤醒的微小变化。一个主体越兴奋,皮肤导电反应就越强烈[31]。

皮肤导电反应通常是通过放置在皮肤某处的小型氯化银电极并在两者之间施加一个小电压来测量的。为了最大限度地舒适和减少刺激,电极可以放在手腕、腿上或脚上,这样手就可以完全自由地进行日常活动。

面部颜色

概述

人脸表面由大量血管网络支配。 这些血管中的血流变化会在脸上产生可见的颜色变化。 无论面部情绪是否激活面部肌肉,都会发生血流量、血压、血糖水平和其他变化。 此外,面部颜色信号与面部肌肉运动提供的信号无关[33]。

方法

方法主要基于面部颜色的变化。 Delaunay 三角剖分用于创建三角形局部区域。 其中一些三角形定义了嘴和眼睛的内部(巩膜和虹膜), 使用左三角区域的像素来创建特征向量[33]。它表明,将标准 RGB 颜色空间的像素颜色转换为 oRGB 颜色空间[34]或 LMS 通道等颜色空间在处理人脸时表现更好[35]。因此,将上面的矢量映射到较好的颜色空间,并分解为红绿色和黄蓝色通道。然后使用深度学习的方法来找到等效的情绪。

视觉审美

美学,在艺术和摄影界,是指美的本质和欣赏原则。 对美和其他审美特质的判断是一项高度主观的任务。 宾夕法尼亚州立大学的计算机科学家将自动评价图像的审美特质视作机器学习的一大挑战,他们将一个同行评级的在线照片分享网站作为数据源[36],从中抽取了特定的视觉特征,可以区分审美上的愉悦与否。

潜在应用

教育

情感影响学习者的学习状态。利用情感计算技术,计算机可以通过学习者的面部表情识别来判断学习者的情感和学习状态。在教学中,教师可以利用分析结果了解学生的学习和接受能力,制定合理的教学计划。同时关注学生的内心感受,有利于学生的心理健康。特别是在远程教育中,由于时间和空间的分离,师生之间缺乏双向交流的情感激励。没有了传统课堂学习带来的氛围,学生很容易感到无聊,影响学习效果。将情感计算应用于远程教育系统可以有效地改善这种状况[37]。

医疗

社会机器人,以及越来越多的机器人在医疗保健中的应用都受益于情感意识,因为它们可以更好地判断用户和病人的情感状态,并适当地改变他们的行为。在人口老龄化日益严重和缺乏年轻工人的国家,这一点尤为重要[38]。

情感计算也被应用于交流技术的发展,以供孤独症患者使用[39]。情感计算项目文本中的情感成分也越来越受到关注,特别是它在所谓的情感或情感互联网中的作用[40]。

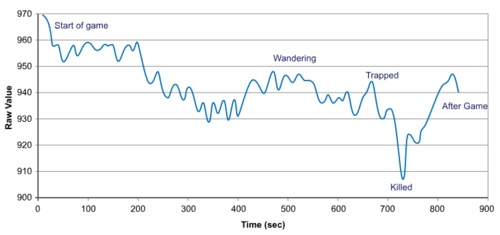

电子游戏

情感型电子游戏可以通过生物反馈设备获取玩家的情绪状态[41]。有一些特别简单的生物反馈形式,如通过游戏手柄来测量按下按钮的压力,来获取玩家的唤醒度水平[42]; 另一方面是脑机接口[43][44] 。情感游戏已被用于医学研究,以改善自闭症儿童的情感发展[45]。

其他应用

其他潜在的应用主要围绕社会监控。例如,一辆汽车可以监控所有乘客的情绪,并采取额外的安全措施。如果发现司机生气,就向其他车辆发出警报[46] 。情感计算在人机交互方面有着潜在的应用,比如情感镜子可以让用户看到自己的表现; 情感监控代理在发送愤怒邮件之前发送警告; 甚至音乐播放器可以根据情绪选择音轨[47]。

罗马尼亚研究人员尼库 · 塞贝博士在一次采访中提出的一个想法是,当一个人使用某种产品时,对他的面部进行分析(他提到了冰淇淋作为一个例子)[48] ,公司就能够利用这种分析来推断他们的产品是否会受到各自市场的欢迎。

人们也可以利用情感状态识别来判断电视广告的影响,通过实时录像和随后对人们面部表情的研究,之后对大量主题的结果进行平均,我们就能知道这个广告(或电影)是否达到了预期的效果,以及观众最感兴趣的元素是什么。

认知主义与交互方法之争

在人机交互领域,罗莎琳德 · 皮卡德的情绪认知主义或“信息模型”概念受到了实用主义者柯尔斯滕 · 博纳等人的批判和对比,他们坚信“后认知主义”和“交互方法”[49]。

皮卡德的研究重点是人机交互,她研究情感计算的目标是“赋予计算机识别、表达、在某些情况下‘拥有’情感的能力”[6]。相比之下,交互式的方法旨在帮助“人们理解和体验他们自己的情绪”[50],并改善以电脑为媒介的人际沟通。它认为不一定将情感映射到机器解释的客观数学模型中,重要的是让人类畅通无阻地理解彼此的情感,而这些情感信息往往会是歧义的、主观的或上下文敏感的[50]。

皮卡德的批评者将她的情感概念描述为“客观的、内在的、私人的和机械的”。他们认为她把情绪简化为发生在身体内部的一个离散的心理信号,这个信号可以被测量,并且是认知的输入,削弱了情绪体验的复杂性。[50][50]

交互方法断言,虽然情绪具有生物物理性,但它是“以文化为基础的,动态体验的,并在某种程度上构建于行动和互动中”[50]。换句话说,它认为“情感是一种通过我们的互动体验到的社会和文化产物”[51][50][52]。

另外参阅

- Affect control theory

- Affective design

- Affective haptics

- Chatterbot

- CyberEmotions

- Character Computing

- Emotion Markup Language (EmotionML)

- Kismet (robot)

- Multimodal sentiment analysis

- Sentiment analysis

- Wearable computer

其他资源

- Hudlicka, Eva (2003). "To feel or not to feel: The role of affect in human–computer interaction". International Journal of Human–Computer Studies. 59 (1–2): 1–32. CiteSeerX 10.1.1.180.6429. doi:10.1016/s1071-5819(03)00047-8.

- Scherer, Klaus R; Bänziger, Tanja; Roesch, Etienne B (2010). A Blueprint for Affective Computing: A Sourcebook and Manual. Oxford: Oxford University Press.

其他链接

- Affective Computing Research Group at the MIT Media Laboratory

- Computational Emotion Group at USC

- Emotion Processing Unit – EPU

- Emotive Computing Group at the University of Memphis

- 2011 International Conference on Affective Computing and Intelligent Interaction

- Brain, Body and Bytes: Psychophysiological User Interaction CHI 2010 Workshop (10–15, April 2010)

- IEEE Transactions on Affective Computing (TAC)

- openSMILE: popular state-of-the-art open-source toolkit for large-scale feature extraction for affect recognition and computational paralinguistics

- Affective Computing Research Group at the MIT Media Laboratory

- Computational Emotion Group at USC

- Emotion Processing Unit – EPU

- Emotive Computing Group at the University of Memphis

- 2011 International Conference on Affective Computing and Intelligent Interaction

- Brain, Body and Bytes: Psychophysiological User Interaction CHI 2010 Workshop (10–15, April 2010)

- IEEE Transactions on Affective Computing (TAC)

- openSMILE: popular state-of-the-art open-source toolkit for large-scale feature extraction for affect recognition and computational paralinguistics

- MIT 媒体实验室情感计算研究小组

- USC 计算情感小组

- 情感处理单元-EPU

- 曼菲斯大学情感计算小组

- 2011年国际情感计算和智能交互会议

- 大脑,身体和字节: 精神生理学用户交互 CHI 2010研讨会(10-15,2010年4月)

- IEEE 情感计算会刊(TAC)

- openSMILE: 流行的最先进的开源工具包,用于大规模的情感识别和计算语言学特征提取

参考文献

- ↑ Tao, Jianhua (2005). "Affective Computing: A Review". Affective Computing and Intelligent Interaction. Vol. LNCS 3784. Springer. pp. 981–995. doi:10.1007/11573548.

- ↑ James, William (1884). "What Is Emotion". Mind. 9 (34): 188–205. doi:10.1093/mind/os-IX.34.188. Cited by Tao and Tan.

- ↑ "Affective Computing" MIT Technical Report #321 (Abstract), 1995

- ↑

Kleine-Cosack, Christian (October 2006). "Recognition and Simulation of Emotions" (PDF). Archived from the original (PDF) on May 28, 2008. Retrieved May 13, 2008.

The introduction of emotion to computer science was done by Pickard (sic) who created the field of affective computing.

- ↑

Diamond, David (December 2003). "The Love Machine; Building computers that care". Wired. Archived from the original on 18 May 2008. Retrieved May 13, 2008.

Rosalind Picard, a genial MIT professor, is the field's godmother; her 1997 book, Affective Computing, triggered an explosion of interest in the emotional side of computers and their users.

- ↑ 6.0 6.1 Picard, Rosalind (1997). Affective Computing. Cambridge, MA: MIT Press. p. 1.

- ↑ Garay, Nestor; Idoia Cearreta; Juan Miguel López; Inmaculada Fajardo (April 2006). "Assistive Technology and Affective Mediation" (PDF). Human Technology. 2 (1): 55–83. doi:10.17011/ht/urn.2006159. Archived (PDF) from the original on 28 May 2008. Retrieved 2008-05-12.

- ↑ Heise, David (2004). "Enculturating agents with expressive role behavior". Agent Culture: Human-Agent Interaction in a Mutlicultural World. Lawrence Erlbaum Associates. pp. 127–142.

- ↑ Restak, Richard (2006-12-17). "Mind Over Matter". The Washington Post. Retrieved 2008-05-13.

- ↑ Aleix, and Shichuan Du, Martinez (2012). "A model of the perception of facial expressions of emotion by humans: Research overview and perspectives" (PDF). The Journal of Machine Learning Research. 13 (1): 1589–1608.

- ↑ Breazeal, C. and Aryananda, L. Recognition of affective communicative intent in robot-directed speech. Autonomous Robots 12 1, 2002. pp. 83–104.

- ↑ 12.0 12.1 12.2 Dellaert, F., Polizin, t., and Waibel, A., Recognizing Emotion in Speech", In Proc. Of ICSLP 1996, Philadelphia, PA, pp.1970–1973, 1996

- ↑ Roy, D.; Pentland, A. (1996-10-01). Automatic spoken affect classification and analysis. pp. 363–367.

- ↑ Lee, C.M.; Narayanan, S.; Pieraccini, R., Recognition of Negative Emotion in the Human Speech Signals, Workshop on Auto. Speech Recognition and Understanding, Dec 2001

- ↑ Neiberg, D; Elenius, K; Laskowski, K (2006). "Emotion recognition in spontaneous speech using GMMs" (PDF). Proceedings of Interspeech.

- ↑ Yacoub, Sherif; Simske, Steve; Lin, Xiaofan; Burns, John (2003). "Recognition of Emotions in Interactive Voice Response Systems". Proceedings of Eurospeech: 729–732. CiteSeerX 10.1.1.420.8158.

- ↑ Charles Osgood; William May; Murray Miron (1975). Cross-Cultural Universals of Affective Meaning. Univ. of Illinois Press. https://archive.org/details/crossculturaluni00osgo.

- ↑ "Gaussian Mixture Model". Connexions – Sharing Knowledge and Building Communities. Retrieved 10 March 2011.

- ↑ S.E. Khoruzhnikov; et al. (2014). "Extended speech emotion recognition and prediction". Scientific and Technical Journal of Information Technologies, Mechanics and Optics. 14 (6): 137.

- ↑ 20.0 20.1 Ekman, P. & Friesen, W. V (1969). The repertoire of nonverbal behavior: Categories, origins, usage, and coding. Semiotica, 1, 49–98.

- ↑ 21.0 21.1 Steidl, Stefan (5 March 2011). "FAU Aibo Emotion Corpus". Pattern Recognition Lab.

- ↑ Singh, Premjeet; Saha, Goutam; Sahidullah, Md (2021). "Non-linear frequency warping using constant-Q transformation for speech emotion recognition". 2021 International Conference on Computer Communication and Informatics (ICCCI). pp. 1–4. arXiv:2102.04029.

- ↑ Caridakis, G.; Malatesta, L.; Kessous, L.; Amir, N.; Raouzaiou, A.; Karpouzis, K. (November 2–4, 2006). Modeling naturalistic affective states via facial and vocal expressions recognition. International Conference on Multimodal Interfaces (ICMI'06). Banff, Alberta, Canada.

- ↑ Balomenos, T.; Raouzaiou, A.; Ioannou, S.; Drosopoulos, A.; Karpouzis, K.; Kollias, S. (2004). "Emotion Analysis in Man-Machine Interaction Systems". In Bengio, Samy; Bourlard, Herve. Machine Learning for Multimodal Interaction. Lecture Notes in Computer Science. 3361. Springer-Verlag. pp. 318–328. http://www.image.ece.ntua.gr/php/savepaper.php?id=334.

- ↑ Ekman, Paul (1972). Cole, J. (ed.). Universals and Cultural Differences in Facial Expression of Emotion. Nebraska Symposium on Motivation. Lincoln, Nebraska: University of Nebraska Press. pp. 207–283.

- ↑ Ekman, Paul (1999). "Basic Emotions". In Dalgleish, T; Power, M. Handbook of Cognition and Emotion. Sussex, UK: John Wiley & Sons. http://www.paulekman.com/wp-content/uploads/2009/02/Basic-Emotions.pdf..

- ↑ "Facial Action Coding System (FACS) and the FACS Manual". A Human Face. Retrieved 21 March 2011.

- ↑ Williams, Mark. "Better Face-Recognition Software – Technology Review". Technology Review: The Authority on the Future of Technology. Retrieved 21 March 2011.

- ↑ J. K. Aggarwal, Q. Cai, Human Motion Analysis: A Review, Computer Vision and Image Understanding, Vol. 73, No. 3, 1999

- ↑ 30.0 30.1 Pavlovic, Vladimir I.; Sharma, Rajeev; Huang, Thomas S. (1997). "Visual Interpretation of Hand Gestures for Human–Computer Interaction: A Review" (PDF). IEEE Transactions on Pattern Analysis and Machine Intelligence. 19 (7): 677–695. doi:10.1109/34.598226.

- ↑ 31.0 31.1 Picard, Rosalind (1998). Affective Computing. MIT.

- ↑ Larsen JT, Norris CJ, Cacioppo JT, "Effects of positive and negative affect on electromyographic activity over zygomaticus major and corrugator supercilii", (September 2003)

- ↑ 33.0 33.1 Carlos F. Benitez-Quiroz, Ramprakash Srinivasan, Aleix M. Martinez, Facial color is an efficient mechanism to visually transmit emotion, PNAS. April 3, 2018 115 (14) 3581–3586; first published March 19, 2018 https://doi.org/10.1073/pnas.1716084115.

- ↑ M. Bratkova, S. Boulos, and P. Shirley, oRGB: a practical opponent color space for computer graphics, IEEE Computer Graphics and Applications, 29(1):42–55, 2009.

- ↑ Hadas Shahar, Hagit Hel-Or, Micro Expression Classification using Facial Color and Deep Learning Methods, The IEEE International Conference on Computer Vision (ICCV), 2019, pp. 0–0.

- ↑ Ritendra Datta, Dhiraj Joshi, Jia Li and James Z. Wang, Studying Aesthetics in Photographic Images Using a Computational Approach, Lecture Notes in Computer Science, vol. 3953, Proceedings of the European Conference on Computer Vision, Part III, pp. 288–301, Graz, Austria, May 2006.

- ↑ http://www.learntechlib.org/p/173785/

- ↑ Yonck, Richard (2017). Heart of the Machine: Our Future in a World of Artificial Emotional Intelligence. New York: Arcade Publishing. pp. 150–153.

- ↑ Projects in Affective Computing

- ↑ Shanahan, James; Qu, Yan; Wiebe, Janyce (2006). Computing Attitude and Affect in Text: Theory and Applications. Dordrecht: Springer Science & Business Media. p. 94.

- ↑ Gilleade, Kiel Mark; Dix, Alan; Allanson, Jen (2005). Affective Videogames and Modes of Affective Gaming: Assist Me, Challenge Me, Emote Me (PDF). Proc.DiGRA Conf. Archived from the original (PDF) on 2015-04-06. Retrieved 2016-12-10.

- ↑ Sykes, Jonathan; Brown, Simon (2003). Affective gaming: Measuring emotion through the gamepad. CHI '03 Extended Abstracts on Human Factors in Computing Systems. CiteSeerX 10.1.1.92.2123. doi:10.1145/765891.765957.

- ↑ Nijholt, Anton; Plass-Oude Bos, Danny; Reuderink, Boris (2009). "Turning shortcomings into challenges: Brain–computer interfaces for games" (PDF). Entertainment Computing. 1 (2): 85–94. Bibcode:2009itie.conf..153N. doi:10.1016/j.entcom.2009.09.007.

- ↑ Reuderink, Boris; Nijholt, Anton; Poel, Mannes (2009). Affective Pacman: A Frustrating Game for Brain–Computer Interface Experiments. Intelligent Technologies for Interactive Entertainment (INTETAIN). pp. 221–227. doi:10.1007/978-3-642-02315-6_23.

- ↑ Khandaker, M (2009). "Designing affective video games to support the social-emotional development of teenagers with autism spectrum disorders". Studies in Health Technology and Informatics. 144: 37–9. PMID 19592726.

- ↑ "In-Car Facial Recognition Detects Angry Drivers To Prevent Road Rage". Gizmodo. 30 August 2018.

- ↑ Janssen, Joris H.; van den Broek, Egon L. (July 2012). "Tune in to Your Emotions: A Robust Personalized Affective Music Player". User Modeling and User-Adapted Interaction. 22 (3): 255–279. doi:10.1007/s11257-011-9107-7.

- ↑ "Mona Lisa: Smiling? Computer Scientists Develop Software That Evaluates Facial Expressions". ScienceDaily. 1 August 2006. Archived from the original on 19 October 2007.

- ↑ Battarbee, Katja; Koskinen, Ilpo (2005). "Co-experience: user experience as interaction" (PDF). CoDesign. 1 (1): 5–18. CiteSeerX 10.1.1.294.9178. doi:10.1080/15710880412331289917.

- ↑ 50.0 50.1 50.2 50.3 50.4 50.5 Boehner, Kirsten; DePaula, Rogerio; Dourish, Paul; Sengers, Phoebe (2007). "How emotion is made and measured". International Journal of Human–Computer Studies. 65 (4): 275–291. doi:10.1016/j.ijhcs.2006.11.016.

- ↑ Boehner, Kirsten; DePaula, Rogerio; Dourish, Paul; Sengers, Phoebe (2005). "Affection: From Information to Interaction". Proceedings of the Aarhus Decennial Conference on Critical Computing: 59–68.

- ↑ Hook, Kristina; Staahl, Anna; Sundstrom, Petra; Laaksolahti, Jarmo (2008). "Interactional empowerment" (PDF). Proc. CHI: 647–656.

编者推荐

集智课程

使用网络的人经常被邀请与世界其他地方分享他们的观点和偏好,而这种基于Web的个人生成信息越来越多地被看作是为多个应用领域增加价值的数据源,而对其中的情感分析与计算变得越来越重要。为此,我们以文本数据为中心,以情绪生理理论和情绪认知理论为基础,利用知识学习与融合的方法,把情绪词典应用、情绪词嵌入学习、情绪认知推理等角度作为研究内容,探讨并验证了情绪心理与知识融合理论相结合的可能途径。

本课程中,我们以文本数据为中心探讨并验证了情绪心理与知识融合理论相结合的可能途径。

如果一个人发表这样评论:“这个加湿器看起来不错,用起来差点”,该如何定义其对这款产品的情感?对类似问题的分析,需要用到细粒度情感分析的方法。基于属性的情感分析是一种细粒度的情感分析任务,比传统的句子级别、文章级别的情感分析任务更加复杂,首先需要识别句子或文章讨论的属性,然后识别具体属性的情感极性,得出结论。细粒度的情感分析具有巨大的商业应用价值,使其成为 NLP 实战竞赛项目的热门赛题。本课程中,将讲解基于属性的细粒度情感分析该如何实施。

课程大纲:

- 多分类:情感分析的基础

- 细粒度:基于属性的细粒度情感分析

- 多媒介:社交网络等用户生成文本的情感分析

在移动互联网时代,人们已经习惯于在网络上表达对事物的评价,比如外卖平台对商家、菜品的评价,购物网站对商品的评价,社交媒体的话题出现等。这些评价中具有巨大的商业价值,其隐藏的情感,可以帮助决策者做出可靠的选择。情感分析具有巨大的工业应用价值。

本课程中,尹相志老师将分享在餐饮、服饰、汽车等领域的情感分析项目落地经验。

课程大纲:

- 文字情绪分类的主要思路

- 文字情绪分类以及如何标注数据

- 通篇文章情绪与逐字情绪

- 基于RNN与CNN的 Seq2Seq 情绪建模

集智文章

情绪是一个非常主观的事情。不同的读者在阅读同一篇文章时可能会有不同的反应。以往的研究表明,不同人对文本情感的典型认同低于 85%。根据我们自己的经验,这个数字对于更复杂的话题甚至更低。例如,在我们的一个项目中,分析社交媒体的用户对股票交易的看法,参与者之间达成共识的仅仅占不到 65%。由于任何自动化情感分析引擎的准确性都是相对于人为判断(所谓的黄金标准)进行衡量的,因此重要的是要根据多个注释者相互同意的标注数据进行衡量,而不是仅依赖唯一的注释者;同样重要的是:85%(即人类情感共识水平)通常被认为是任何自动化情绪分析引擎的准确性的理论上限。针对一个小型封闭的测试数据集,或者基于一个人的判断,引擎可以达到高于 85% 甚至 90% 的情感分析准确度。然而,在针对开放领域数据的时候,任何超过 90% 分析准确率的说法都更像是幻想,而不具有现实性。

本中文词条由11编译,CecileLi、 栗子CUGB审校,糖糖编辑,如有问题,欢迎在讨论页面留言。

本词条内容源自wikipedia及公开资料,遵守 CC3.0协议。