“随机迭代系统的因果涌现”的版本间的差异

(→应用案例) |

|||

| 第375行: | 第375行: | ||

== 应用案例 == | == 应用案例 == | ||

| − | |||

| − | |||

=== 随机游走 === | === 随机游走 === | ||

随机游走的分析侧重于噪声<math> | 随机游走的分析侧重于噪声<math> | ||

| 第399行: | 第397行: | ||

\kappa_i,i=1,\dots,n | \kappa_i,i=1,\dots,n | ||

</math>的方差越大,产生因果涌现的潜在可能性就越高。 | </math>的方差越大,产生因果涌现的潜在可能性就越高。 | ||

| − | [[文件: | + | [[文件:C3d90f04-1536-4e92-a438-41d1213f2f81.png|缩略图|590x590px|随机游走相关实验结果|替代=|居中]] |

=== 热量耗散 === | === 热量耗散 === | ||

| − | |||

随机游走侧重于确定性和噪声,而第二种情况将侧重于非简并性和参数矩阵<math> | 随机游走侧重于确定性和噪声,而第二种情况将侧重于非简并性和参数矩阵<math> | ||

A | A | ||

| 第411行: | 第408行: | ||

散热模型的实验结果显示,4个节点在不同时间点的温度微观状态数据都处于下降趋势的情况下,通过粗粒化可以将微观态数据直接映射成宏观状态数据,也可以只粗粒化起始时刻由宏状态动力学生成之后的演化数据,而两者趋势接近,可以验证宏观动力学的有效性。将宏观状态不同维度下因果涌现程度进行比较。<math> | 散热模型的实验结果显示,4个节点在不同时间点的温度微观状态数据都处于下降趋势的情况下,通过粗粒化可以将微观态数据直接映射成宏观状态数据,也可以只粗粒化起始时刻由宏状态动力学生成之后的演化数据,而两者趋势接近,可以验证宏观动力学的有效性。将宏观状态不同维度下因果涌现程度进行比较。<math> | ||

k | k | ||

| − | </math>越小,系统的简并性越弱,最优的因果涌现的程度会越强。我们还可以将依赖数据的因果涌现数值解,和不依赖数据的因果涌现解析解进行比较,可以发现随着样本量的增加,因果涌现的数值解逐渐接近解析解。 | + | </math>越小,系统的简并性越弱,最优的因果涌现的程度会越强。我们还可以将依赖数据的因果涌现数值解,和不依赖数据的因果涌现解析解进行比较,可以发现随着样本量的增加,因果涌现的数值解逐渐接近解析解。[[文件:Output.png|缩略图|601x601px|热量耗散模型相关实验结果|替代=|居中]] |

=== 三维空间的旋转模型 === | === 三维空间的旋转模型 === | ||

| 第418行: | 第415行: | ||

通过实验结果可以发现,其实因果涌现的主要原因就是在空间中,系统的演化虽然处于三维空间中,但是只依托于一条一维的直线或者一个二维平面,就可以近似出系统的演化规律。如果粒子在三维空间中,围绕一条直线进行运动,并且收敛于该直线,那么直线方向的演化可以视为梯度流,而与直线垂直的平面上的演化可以视为螺线管流,简言之,就是直线上可以更清晰的观测到系统的演化方向。因此会在压缩到一维时产生较大的因果涌现。 | 通过实验结果可以发现,其实因果涌现的主要原因就是在空间中,系统的演化虽然处于三维空间中,但是只依托于一条一维的直线或者一个二维平面,就可以近似出系统的演化规律。如果粒子在三维空间中,围绕一条直线进行运动,并且收敛于该直线,那么直线方向的演化可以视为梯度流,而与直线垂直的平面上的演化可以视为螺线管流,简言之,就是直线上可以更清晰的观测到系统的演化方向。因此会在压缩到一维时产生较大的因果涌现。 | ||

| − | 如果系统是收敛到一个平面,那么该平面能反映系统的演化方向,这时压缩到二维,会产生最大的因果涌现。由于旋转矩阵会出现复数特征根,我们根据特征根的模长计算因果涌现,之所以不压缩到一维,是因为前两个特征值是共轭复数,模长相等,压缩到一维不会增强因果涌现,反而会使误差变得更大。 | + | 如果系统是收敛到一个平面,那么该平面能反映系统的演化方向,这时压缩到二维,会产生最大的因果涌现。由于旋转矩阵会出现复数特征根,我们根据特征根的模长计算因果涌现,之所以不压缩到一维,是因为前两个特征值是共轭复数,模长相等,压缩到一维不会增强因果涌现,反而会使误差变得更大。[[文件:0300b2a3-8a32-4c57-a956-553b7fb92a6f.png|缩略图|722x722px|旋转模型相关实验|替代=|居中]]旋转模型为因果涌现的意义提供了最直观且可视化的理解方式,也为拓展到高维空间的变量与数据提供了入门的基础。 |

| − | |||

| − | 旋转模型为因果涌现的意义提供了最直观且可视化的理解方式,也为拓展到高维空间的变量与数据提供了入门的基础。 | ||

2024年8月18日 (日) 11:23的版本

随机迭代系统的因果涌现指的是针对形如[math]\displaystyle{ x_{t+1}=f(x_t)+\varepsilon_t, f:\mathcal{R}^n\to\mathcal{R}^n, \varepsilon_t\sim\mathcal{N}(0,\Sigma),{\rm rk}(\Sigma)=n }[/math]的动力系统,在降维粗粒化之后,展现出的系统在宏观尺度因果特性强于微观尺度的程度的度量。在对复杂系统进行粗颗粒化后,其宏观状态的动力学可能比其微观状态的动力学表现出更明显的因果效应。这种现象被称为因果涌现,该指标通过有效信息指标来量化,若出现宏观有效信息大于微观有效信息,则意味着因果涌现的产生。这一理论一定程度上解决了Erik Hoel提出了因果出现理论面临的两个挑战:连续随机动力系统缺乏完善的框架,以及对粗粒度方法的依赖。

历史

2014年至今,计算神经科学家 Erik Hoel 、伦敦帝国理工学院复杂系统中心的 Fernado E. Rosas 等人相继提出并拓展了基于信息论的因果涌现理论框架,因果涌现的定义以及度量的方法给出了定量的描述,为现实中关于生态环境、气候、城市、大脑、细胞、分子等复杂系统的演化规律研究方法提供了全新的评判指标和思路方向,而且还有望为回答关于生命、意识、自由意志等哲学问题。只要有两个个体共同演化,就会产生个体与两个人组成的整体演化规律的差异。比如空中比翼双飞的两只鸟,整体会有一套属于自己的飞行轨迹,如果单独观察一只鸟我们会发现,由于另一只鸟与之产生个体之间相互的影响,该鸟飞行的轨迹与其独立飞行,就会产生很大的差异。由于相互作用的存在,两只鸟整体的飞行轨迹亦不能简单的归因到一只鸟独立飞行的轨迹与路线。像这样,后一时刻的宏观态演化无法归因到前一时刻的微观态,这种现象被我们称为因果涌现。

其中Erik Hoel提出了因果出现的最初定量理论,建立在有效信息([math]\displaystyle{ EI\equiv I(Y;X|do(X\sim U)) }[/math])的基础上,原始框架仅限于量化时域和状态空间中的离散马尔可夫链。为了在连续空间中扩展因果涌现理论,Hoel又提出了因果几何理论,其中他们设计了一种计算连续状态空间上函数映射中有效信息的方法。尽管如此,该理论只探索了一般的函数映射,而忽略了多步动力学演化,使其不适用于连续状态空间中的动力学系统。同时Erik Hoel的理论还有一个共同问题就是粗粒化策略必须预先给定,而缺少优化方法。

粗粒化复杂系统的策略,包括手动设计的重整化方法,传统的降维技术,以及基于机器学习的粗粒化或重整化方法。为了自动发现优化因果出现的粗粒度策略,张江和刘凯威引入了一种机器学习框架,称为神经信息挤压器(NIS),采用可逆神经网络。该框架有助于自动提取有效的粗粒度策略和宏观状态动力学,从而能够从不同的时间序列数据中直接识别因果关系。随后,研究团队提出了增强的NIS+框架,该框架将通过有效信息最大化的粗粒度优化集成到机器学习中,成功地解决了识别数据中因果出现的挑战。尽管如此,基于机器学习的方法在很大程度上依赖于数据的充分性和神经网络训练的水平。虽然它们可以提供数字解决方案,但缺乏评估模型训练质量和结果指标可靠性的基本事实。

简介

随机迭代系统形如

[math]\displaystyle{ x_{t+1}=f(x_t)+\varepsilon_t, f:\mathcal{R}^n\to\mathcal{R}^n, \varepsilon_t\sim\mathcal{N}(0,\Sigma),{\rm rk}(\Sigma)=n }[/math]

现实中诸多复杂系统的动力学模型都可以转化成迭代系统来表达系统的演化,比如经济学的商品价格、粒子的随机游走、导热体热量的耗散以及空间中的旋转模型,虽然时间是离散的,但是其分布状态空间属于连续空间,而不是马尔科夫链或者复杂网络一样可以将状态确定在有限的状态点位上,整个迭代系统自身的因果效应也需要相关的指标来针对性的进行量化。

现实中诸多复杂系统的动力学模型都可以转化成迭代系统来表达系统的演化,比如粒子的随机游走、导热体热量的耗散以及空间中的旋转模型,虽然时间是离散的,但是其分布状态空间属于连续空间,而不是马尔科夫链或者复杂网络一样可以将状态确定在有限的状态点位上,整个迭代系统自身的因果效应也需要相关的指标来针对性的进行量化。为了解决以上问题,随机迭代系统的因果涌现作为一个精确的理论框架,可被应用于研究具有连续状态空间和高斯噪声的线性随机迭代系统中的因果涌现。该框架不仅可以给出线性线性随机迭代系统有效信息和因果涌现的解析表达式,还可以确定最佳线性粗粒化策略,当粗粒化消除的维度平均不确定性有上限时,该策略可最大限度地提高因果涌现的程度。解析表达式本身可以拓展到一般动力学的空间上,但是其因果涌现的大小和最优粗粒化策略会受到时间和迭代函数本身的影响。

粗粒化策略

在《复杂》一书中,提到的用来跨越层级并辅助研究不同层级规律的“分类器”,就是粗粒化策略重要的应用领域,“分类器”可以通过类似自催化集的方式进行组织和再组织,文章的体现就是针对某种指标对粗粒化策略的优化。粗粒化策略,就是将系统从微观转化为宏观的操作,直观的体现就是对数据、变量、以及动力系统的降维。例如:生存分析中对于生存数据的断尾删失策略,控制论中对数据与动力系统的模型约减,以及马尔科夫动力系统中对马尔科夫链的分块。传统的指标往往是随时函数。

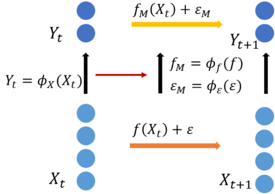

对于随机迭代系统,可以通过粗粒化策略

[math]\displaystyle{ y_t=\phi(x_t), \phi: \mathcal{R}^{n}\to\mathcal{R}^{k},k\lt n }[/math]

得到同为随机迭代系统但变量维数降低的宏观动力学

[math]\displaystyle{ y_{t+1}=f_M(y_t)+\varepsilon_{M,t}, f_M:\mathcal{R}^k\to\mathcal{R}^k, \varepsilon_{M,t}\sim\mathcal{N}(0,\Sigma_M),{\rm rk}(\Sigma_M)=k }[/math]

其中宏观映射

[math]\displaystyle{ f_M(y_t)=\phi(f(\phi^\dagger(y_t))), \phi^\dagger: \mathcal{R}^{k}\to\mathcal{R}^{n}, \phi(\phi^\dagger(y_t))=y_t }[/math]

有效信息与因果涌现

微观上我们将[math]x[/math]干预成[math]\displaystyle{ [-L/2,L/2]^n\subset\mathcal{R}^n }[/math]上的均匀分布,[math]\displaystyle{ [-L/2,L/2]^n }[/math]表示n维空间中的超立方体,我们假设[math]\displaystyle{ y\in\mathcal{R}^k }[/math],其中[math]\displaystyle{ n }[/math]和[math]\displaystyle{ k }[/math]是正整数。有效信息EI可以推广为以下形式:

[math]\displaystyle{ EI(f,\Sigma)\approx \ln\left(\frac{L^n}{(2\pi e)^{n/2}}\right)+\frac{1}{L^n}\int_{[-\frac{L}{2},\frac{L}{2}]^n}\ln\left|\det\left(\frac{\partial_{x_t} f(x_t)}{\Sigma^{1/2}}\right)\right| dx, }[/math]

其中,[math]\displaystyle{ |\cdot| }[/math]是绝对值运算,[math]\displaystyle{ \det }[/math]是行列式。

EI的计算公式中包含着[math]\ln L^n[/math]项。由于L为一个很大的正数,因而EI的计算结果将会受到L的严重影响,为了降低维度本身对有效信息的影响,我们采用平均维度的有效信息

[math]\displaystyle{ \mathcal{J}(f,\Sigma)=\frac{EI(f,\Sigma)}{n}\approx \ln\left(\frac{L}{(2\pi e)^{1/2}}\right)+\frac{1}{L^n}\int_{[-\frac{L}{2},\frac{L}{2}]^n}\ln\left|\det\left(\frac{\partial_{x_t} f(x_t)}{\Sigma^{1/2}}\right)\right|^\frac{1}{n} dx, }[/math]

宏观态同理。

计算因果涌现我们只需要在宏观微观分别计算维度平均后的有效信息并用宏观的有效信息与微观作差,即可计算出因果涌现的度量

[math]\displaystyle{ \Delta\mathcal{J}=\mathcal{J}_M(f_M,\Sigma_M)-\mathcal{J}_m(f,\Sigma) }[/math]

由于一般情况下有效信息与因果涌现受映射[math]\displaystyle{ f:\mathcal{R}^n\to\mathcal{R}^n }[/math]影响较大,而映射自身会受状态[math]\displaystyle{ x_t }[/math]本身以及其所处时间[math]\displaystyle{ t }[/math]影响,故很多性质我们很难直接研究。但如果是线性随机迭代系统,映射函数及其导函数相对固定,我们就可以从中挖掘更多的信息。

近似化简

依据拉格朗日中值定理,存在[math]\displaystyle{ x_t\in[-\frac{L}{2},\frac{L}{2}]^n }[/math]有效信息EI可以推广为以下形式:

[math]\displaystyle{ EI(f,\Sigma)\approx \ln\left(\frac{L^n}{(2\pi e)^{n/2}}\right)+\ln\left|\det\left(\frac{\partial_{x_t^*} f(x_t^*)}{\Sigma^{1/2}}\right)\right|, }[/math]

当L较小时可以简写成

[math]\displaystyle{ EI(f,\Sigma)\approx \ln\left(\frac{|\det(\nabla f(x_t))|L^n}{(2\pi e)^{n/2}\det(\Sigma^\frac{1}{2})}\right) }[/math]

从中我们可以清楚地看到,一个系统有效信息的大小主要由两个因素决定,一个是迭代函数梯度的大小,另一个就是随机噪声协方差的大小,梯度越大,协方差越小,意味着有效信息越大,因果效应越强。

在得知有效信息的基础上,因果涌现就可以写成

[math]\displaystyle{ \Delta\mathcal{J}(x_t)=\ln\frac{|\det(\nabla f_M(y_t)|^\frac{1}{k}}{|\det(\nabla f(x_t)|^\frac{1}{n}}+\ln\frac{|\det(\Sigma)|^\frac{1}{2n}}{|\det(\Sigma_M)|^\frac{1}{2k}}. }[/math]

这种形式和现行情况更为接近,因此可以从线性系统的性质,对非线性情况进行类比和推论。

线性随机迭代系统

线性随机迭代系统是指形如

[math]\displaystyle{ x_{t+1}=Ax_t+\varepsilon_t, A\in\mathcal{R}^{n\times n}, \varepsilon_t\sim\mathcal{N}(0,\Sigma), {\rm rk}(A)={\rm rk}(\Sigma)=n }[/math]

的迭代系统,此时迭代映射函数的参数可以与变量分离,我们可以单独研究参数本身对有效信息以及因果涌现的影响。

微观和宏观动力学的有效信息

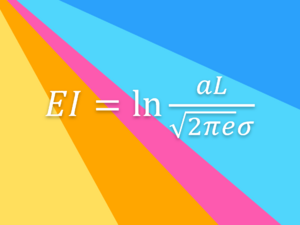

线性映射下效信息EI可以推广为以下形式:

[math]\displaystyle{ EI(A,\Sigma)=\ln\displaystyle\frac{|\det(A)|L^n}{(2\pi e)^\frac{n}{2}\displaystyle \det(\Sigma)^\frac{1}{2}} }[/math]

但是有效信息受向量维数n影响很大,会陷入维度越高有效信息越大的误区,因此需要单独引入线性随机迭代系统的有效信息这一指标来解决该问题。

随机迭代系统的因果涌现由宏观态的有效信息[math]\displaystyle{ \mathcal{J}_M }[/math]和微观态的有效信息[math]\displaystyle{ \mathcal{J}_m }[/math]做差得到

[math]\displaystyle{ \Delta \mathcal{J} = \mathcal{J}_M-\mathcal{J}_m }[/math]

两项都是随机迭代系统的有效信息。

而因果涌现由宏观态和微观态的有效信息作差得到。对于线性随机迭代系统,对于单步的映射我们可以得到有效信息

[math]\displaystyle{ \mathcal{J}(A,\Sigma)\equiv \frac{EI(A,\Sigma)}{n}=\frac{1}{n}\ln\displaystyle\frac{|\det(A)|L^n}{(2\pi e)^\frac{n}{2}\displaystyle \det(\Sigma)^\frac{1}{2}}=\ln\displaystyle\frac{|\det(A)|^\frac{1}{n}L}{(2\pi e)^\frac{1}{2}\displaystyle \det(\Sigma)^\frac{1}{2n}}. }[/math]

随机迭代系统的有效信息可以分解确定性和简并性为两项,

[math]\displaystyle{ \mathcal{J}=\mathcal{J}_1-\mathcal{J}_2 }[/math]

确定性

[math]\displaystyle{ \mathcal{J}_1\equiv-\left\lt H(p(x_{t+1}|x_t))\right\gt =-\ln\left[(2\pi e)^\frac{n}{2}\det(\Sigma)^\frac{1}{2}\right] }[/math]

描述系统前一时刻状态已知的情况下,后一时刻的随机性,确定性越强,随机性越小,越容易对系统未来趋势进行预测。

简并性

[math]\displaystyle{ \mathcal{J}_2\equiv-H(E_D(x_{t+1}))=-\ln\left(|det(A)|L^n\right) }[/math]

描述后一时刻已知的情况下,对前一时刻的可追溯性,简并性越弱,系统越容易推断系统以往的演化路径。

确定性越强,简并性越弱,有效信息则会越大,因果效应越强。

宏观有效信息与微观有效信息做差之后就可以得到随即迭代系统的因果涌现。而微观、宏观的确定性和简并性分别做差就可以得到确定性、简并性涌现。

因果涌现

为了克服先前研究中发现的局限性,随机迭代系统

[math]\displaystyle{ x_{t+1}=Ax_t+\varepsilon_t, A\in\mathcal{R}^{n\times n}, \varepsilon_t\sim\mathcal{N}(0,\Sigma), {\rm rk}(A)={\rm rk}(\Sigma)=n }[/math]

通过粗粒化策略

[math]\displaystyle{ y_t=Wx_t, W\in R^{k\times n},k\lt n }[/math]

得到宏观动力学

[math]\displaystyle{ y_{t+1}=A_M y_t+\varepsilon_{M,t}, A_M=WAW^\dagger\in \mathcal{R}^{k\times k}, \varepsilon_{M,t}\sim \mathcal{N}(0,\Sigma_M), \Sigma_M=W\Sigma W^{T} }[/math]

后的因果涌现

[math]\displaystyle{ \Delta\mathcal{J}=\mathop{\ln\frac{|\det(\Sigma)|^\frac{1}{2n}}{|\det(W\Sigma W^{T})|^\frac{1}{2k}}}_{Determinism Emergence}-\mathop{\ln\frac{|\det(A)|^\frac{1}{n}}{|\det(WAW^\dagger)|^\frac{1}{k}}}_{Degeneracy Emergence} }[/math]

及其相关研究一定程度上可以解决上述问题。

确定性和简并性

随机迭代系统的因果涌现还可以分解成两项,确定性涌现

[math]\displaystyle{ \Delta\mathcal{J}_1=\ln\frac{|\det(\Sigma)|^\frac{1}{2n}}{|\det(W\Sigma W^{T})|^\frac{1}{2k}} }[/math]

和简并性涌现

[math]\displaystyle{ \Delta\mathcal{J}_2=\ln\frac{|\det(A)|^\frac{1}{n}}{|\det(WAW^\dagger)|^\frac{1}{k}} }[/math]

两者分别是微观态、宏观态的确定性、简并性做差产生。粗粒化造成的确定性涌现越大、简并性涌现越小、因果涌现也会越大。

因果涌现最大化

为了找到不依赖粗粒化策略的因果涌现,我们可以通过优化粗粒化策略得到因果涌现的最优解

[math]\displaystyle{ \Delta\mathcal{J}^{*}=\frac{1}{k}\sum_{i=1}^{k}\ln\displaystyle|\lambda_i|-\frac{1}{n}\sum_{i=1}^{n}\ln\displaystyle|\lambda_i|+\eta }[/math]

其中[math]\displaystyle{ |\lambda_1|\geq|\lambda_2|\geq\dots\geq|\lambda_n|\geq 0 }[/math]是参数矩[math]\displaystyle{ A\in\mathcal{R}^{n\times n}, {\rm rk}(A)={\rm rk}, }[/math]的特征值,[math]\displaystyle{ \eta }[/math]是粗粒化造成的信息熵损失[math]\displaystyle{ \frac{1}{n}H(p(x_{t+1})|p(x_t))-\frac{1}{k}H(p(y_{t+1}|y_t)) }[/math]的下界。

因果涌现的最优化

对于因果涌现,我们可以对确定性和简并性分别最优化,确定性涌现越大,简并性涌现越小,则因果涌现会最大

确定性涌现

[math]\displaystyle{ \Delta\mathcal{J}_1=\ln\frac{|\det(\Sigma)|^\frac{1}{2n}}{|\det(W\Sigma W^{T})|^\frac{1}{2k}}\leq\frac{1}{n}H(p(x_{t+1})|p(x_t))-\frac{1}{k}H(p(y_{t+1}|y_t))\leq\eta }[/math]

简并性涌现

[math]\displaystyle{ \Delta\mathcal{J}_2=\ln\frac{|\det(A)|^\frac{1}{n}}{|\det(WAW^\dagger)|^\frac{1}{k}}\geq\ln\frac{|\prod_{i=1}^n\lambda_i|^\frac{1}{n}}{|\prod_{i=1}^k\lambda_i|^\frac{1}{k}}=-\frac{1}{k}\sum_{i=1}^{k}\ln\displaystyle|\lambda_i|+\frac{1}{n}\sum_{i=1}^{n}\ln\displaystyle|\lambda_i| }[/math]

因果涌现最大值为

[math]\displaystyle{ \Delta\mathcal{J}^{*}=\Delta\mathcal{J}_1^{*}-\Delta\mathcal{J}_2^{*}=\frac{1}{k}\sum_{i=1}^{k}\ln\displaystyle|\lambda_i|-\frac{1}{n}\sum_{i=1}^{n}\ln\displaystyle|\lambda_i|+\eta }[/math]

因果涌现最优化时粗粒化参数的解集

在优化确定性涌现和退化性涌现后,我们可以找到与最优解相对应的两个解集。因此,两个解集的交集是对应于因果涌现的最大程度的[math]\displaystyle{ W }[/math]的解集。

当[math]\displaystyle{ \varepsilon_t\sim N_\mathcal{N}(0,\Sigma) }[/math]时,若使因果涌现度达到其最大值时,[math]\displaystyle{ W }[/math]需要满足

[math]\displaystyle{ \begin{cases} WV=(\tilde{W}_k,O_{k\times{(n-k)}}),\\ \det{(W\Sigma W^{T})}^\frac{1}{k}=\epsilon\det{(\Sigma)}^\frac{1}{n}, \end{cases} }[/math]

其中[math]\displaystyle{ V=(V_1,\dots,V_n) }[/math],[math]\displaystyle{ V_i }[/math]是与矩阵[math]\displaystyle{ A }[/math]的特征值[math]\displaystyle{ \lambda_i }[/math]相对应的特征向量,[math]\displaystyle{ i=1,\dots,n, \lambda _1\geq\dots\geq\lambda_n }[/math],[math]\displaystyle{ \tilde{W}_k\in \mathcal{R}^{k\times k} }[/math]可以是任何可逆矩阵。

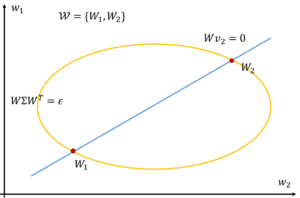

二维到一维的粗粒化

在平面上[math]\displaystyle{ k=1,n=2 }[/math],粗粒化参数矩阵就是一个行向量[math]\displaystyle{ W=(w_1,w_2)\in\mathcal{R}^{1\times 2} }[/math],特征向量矩阵[math]\displaystyle{ V=(v_1,v_2)\in\mathcal{R}^{2\times 2} }[/math]可以视为2个二维向量的组合。如果特征值[math]\displaystyle{ \lambda_1\gt \lambda_2 }[/math],我们只需要保留第一个特征值,舍弃第二个特征值,因此只需要满足在二维平面上[math]\displaystyle{ Wv_2=w_1v_{12}+w_2v_{22}=0 }[/math],不难发现此方程刚好代表一条直线。

与此同时,还需要[math]\displaystyle{ W\Sigma W^{T}=\epsilon }[/math],解集刚好是个椭圆。因此最终的解空间可以表示为

[math]\displaystyle{ \begin{cases} Wv_2=0,\\ W\Sigma W^{T}=\epsilon, \end{cases} }[/math]

即一个椭圆与一条直线的两个交点。

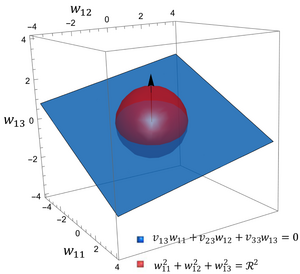

三维到二维的粗粒化

在三维空间中的特定情况下,当[math]\displaystyle{ k=2,n=3 }[/math],矩阵[math]\displaystyle{ W=(w_1^{T},w_2^{T})^{T}\in\mathcal{R}^{2\times 3} }[/math]可以拆分为两个行向量,[math]\displaystyle{ w_i=(w_{i1},w_{i2},w_{i3}),i=1,2 }[/math],在[math]\displaystyle{ \mathcal{R}^3 }[/math]中,特征向量矩阵[math]\displaystyle{ V=(v_1,v_2,v_3)\in\mathcal{R}^{3\times3} }[/math]可以视为三个向量的组合,[math]\displaystyle{ v_j=(v_{1j},v_{2j},V_{3j})^T\in\mathcal{R}^3,j=1,2,3 }[/math]。[math]\displaystyle{ w_1w_2^{T}=0, \Sigma=\sigma^2I_3 }[/math]我们可以将解空间写成

[math]\displaystyle{ \begin{cases} w_1v_3=0,\\ w_2v_3=0,\\ (w_1w_1^{T})(w_2w_2^{T})=\epsilon, \end{cases} }[/math]

其中对于单独一个向量[math]\displaystyle{ w_1 }[/math]的解空间我们可以写成

[math]\displaystyle{ w_{11}v_{13}+w_{12}v_{23}+w_{13}v_{33}=0,\\ w_{11}^2+w_{12}^2+w_{13}^2=R^2, }[/math]

该结果是解析几何中一个平面和球的交线即一个圆。

因此我们可以类推,在一盘情况下,三维空间中的解集就是椭球和平面的交线,也就是椭圆,整个粗粒化矩阵的解集就是两个椭圆各自的空间。高维空间中就是[math]\displaystyle{ k }[/math]个[math]\displaystyle{ n }[/math]维空间中的超椭圆组成的空间。

从中我们可以发现,因果涌现最大化的条件有两点,第一,我们需要保留迭代参数矩阵最大的[math]\displaystyle{ k }[/math]个特征值,舍弃较小的[math]\displaystyle{ n-k }[/math]个特征值;第二,我们要将我们的随机噪声进行降噪,在保留一定信息熵的基础上,将噪声最小化。

应用案例

随机游走

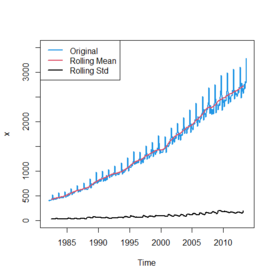

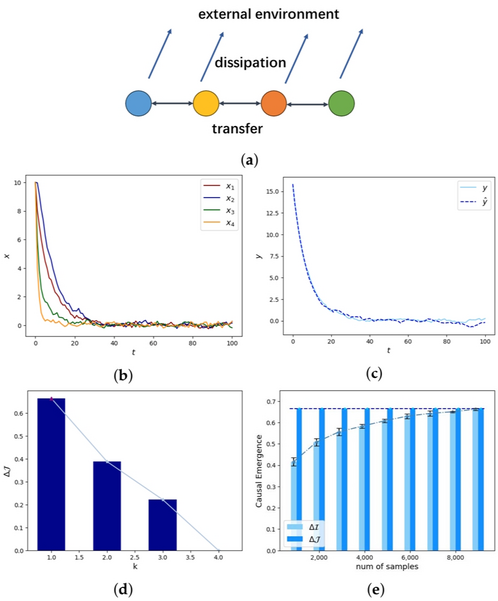

随机游走的分析侧重于噪声[math]\displaystyle{ \varepsilon_t }[/math]和协方差矩阵[math]\displaystyle{ \Sigma }[/math],它们主要影响确定性的出现。随机行走模型是一种数学模型,用于描述物体在特定空间中的随机运动,其中,步行者在一系列位置之间移动,每次移动的方向和距离都是随机的。该模型可以研究各种现象,如金融市场中资产价格的变化、流体中粒子的扩散等。在随机游走模型中,步行者每次只能向左或向右移动一定距离,距离服从正态分布。当多个因子共存时,可以形成一个变化参数矩阵作为恒等矩阵。

观察主要受噪声影响的随机游走因子在不同维度上的轨迹与微观状态噪声[math]\displaystyle{ \varepsilon_t }[/math]和宏观状态噪声[math]\displaystyle{ \varepsilon_t }[/math]的四维概率密度函数,不难看出粗粒化策略对于系统有降噪的作用。观察不同宏观状态维度[math]\displaystyle{ k }[/math]下的因果涌现程度。在粗粒化参数矩阵[math]\displaystyle{ W }[/math]的奇异值均为1的条件下,[math]\displaystyle{ k }[/math]越小,系统的确定性越强,因果涌现的程度会越强。同时可以发现[math]\displaystyle{ \Sigma }[/math]的特征值[math]\displaystyle{ \kappa_i,i=1,\dots,n }[/math]的方差越大,产生因果涌现的潜在可能性就越高。

热量耗散

随机游走侧重于确定性和噪声,而第二种情况将侧重于非简并性和参数矩阵[math]\displaystyle{ A }[/math]。这种情况被称为离散化热传导模。在这种离散情况下,热传导主要反映在相应观测节点处随时间变化的温度上。我们可以使用矩阵[math]\displaystyle{ A }[/math]来表示温度的变化,其中包括变化率的信息。该矩阵通常对应于正定稀疏矩阵,可用于描述系统的温度变化过程。

散热模型的实验结果显示,4个节点在不同时间点的温度微观状态数据都处于下降趋势的情况下,通过粗粒化可以将微观态数据直接映射成宏观状态数据,也可以只粗粒化起始时刻由宏状态动力学生成之后的演化数据,而两者趋势接近,可以验证宏观动力学的有效性。将宏观状态不同维度下因果涌现程度进行比较。[math]\displaystyle{ k }[/math]越小,系统的简并性越弱,最优的因果涌现的程度会越强。我们还可以将依赖数据的因果涌现数值解,和不依赖数据的因果涌现解析解进行比较,可以发现随着样本量的增加,因果涌现的数值解逐渐接近解析解。

三维空间的旋转模型

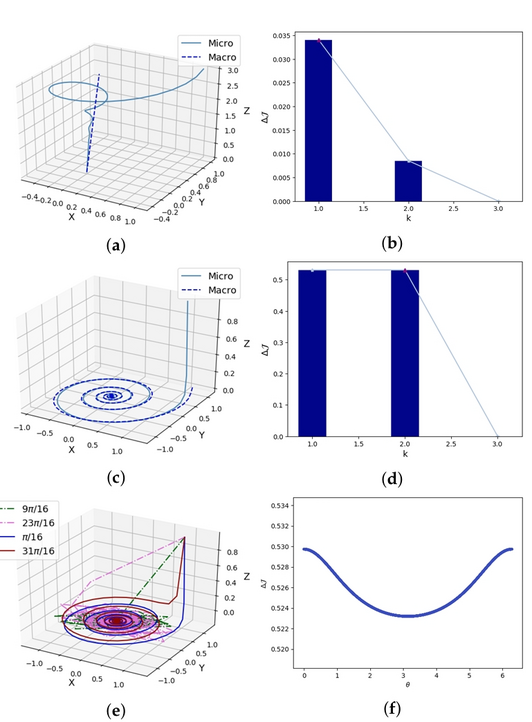

除了针对特定模型获得的结果外,我们还需要更直观地理解粗粒化和因果出现的含义。在这里,以解析几何中的螺旋旋转模型为例,在三维空间中可视化模型系统,并分析因果涌现在三维空间是如何反映的。

通过实验结果可以发现,其实因果涌现的主要原因就是在空间中,系统的演化虽然处于三维空间中,但是只依托于一条一维的直线或者一个二维平面,就可以近似出系统的演化规律。如果粒子在三维空间中,围绕一条直线进行运动,并且收敛于该直线,那么直线方向的演化可以视为梯度流,而与直线垂直的平面上的演化可以视为螺线管流,简言之,就是直线上可以更清晰的观测到系统的演化方向。因此会在压缩到一维时产生较大的因果涌现。

如果系统是收敛到一个平面,那么该平面能反映系统的演化方向,这时压缩到二维,会产生最大的因果涌现。由于旋转矩阵会出现复数特征根,我们根据特征根的模长计算因果涌现,之所以不压缩到一维,是因为前两个特征值是共轭复数,模长相等,压缩到一维不会增强因果涌现,反而会使误差变得更大。

旋转模型为因果涌现的意义提供了最直观且可视化的理解方式,也为拓展到高维空间的变量与数据提供了入门的基础。