“基于信息分解的因果涌现理论”的版本间的差异

| 第61行: | 第61行: | ||

<math> Syn(X_{t}; X_{t+1}) > 0 </math>. | <math> Syn(X_{t}; X_{t+1}) > 0 </math>. | ||

| − | 在这种背景下,因果涌现被理解为在马尔可夫动力系统中,先前时刻和后续时刻变量之间的协同效应。然后,Rosas在<math> \Phi ID </math>框架中进一步将因果涌现分为两个部分,向下因果性和因果解耦,这是基于信息原子的不同特征。通过使用<math> \Phi ID </math>分解互信息<math> I(X_{t}; X_{t+1}) </math> | + | 在这种背景下,因果涌现被理解为在马尔可夫动力系统中,先前时刻和后续时刻变量之间的协同效应。然后,Rosas在<math> \Phi ID </math>框架中进一步将因果涌现分为两个部分,向下因果性和因果解耦,这是基于信息原子的不同特征。通过使用<math> \Phi ID </math>分解互信息<math> I(X_{t}; X_{t+1}) </math>得到的十六个信息原子中,有四个信息原子对应于协同效应,这被视为因果涌现的组成。这些原子表示为,其中<math>\alpha \in A = \{\{\{1\}\{2\}\}, \{1\}, \{2\}, \{12\}\} </math>。 |

| − | 此外,Rosas还提供了一种量化特定宏观变量(即粗粒化策略)因果涌现的方法。如果一个系统具有产生因果涌现的能力,那么它可能会有一些表现出因果涌现的宏观特征。如果一个特征变量V在系统在时间t的完整状态X已知且精确度完美的情况下,对于时间t+1的未来状态没有提供任何预测能力,那么这个特征变量V被认为是依赖于底层系统的。这等同于Vt在给定Xt的情况下与Xt+1统计独立。然后,对于由Xt描述的系统,如果一个依赖特征Vt表现出因果作用,当且仅当:

<math> \text{Un}(V_{t}; X_{t+1} \mid X_{t}) > 0 </math> | + | 此外,Rosas还提供了一种量化特定宏观变量(即粗粒化策略)因果涌现的方法。如果一个系统具有产生因果涌现的能力,那么它可能会有一些表现出因果涌现的宏观特征。如果一个特征变量V在系统在时间t的完整状态X已知且精确度完美的情况下,对于时间t+1的未来状态没有提供任何预测能力,那么这个特征变量V被认为是依赖于底层系统的。这等同于Vt在给定Xt的情况下与Xt+1统计独立。然后,对于由Xt描述的系统,如果一个依赖特征Vt表现出因果作用,当且仅当:

<math> \text{Un}(V_{t}; X_{t+1} \mid X_{t}) > 0 </math>。 |

| − | 对于这个定义,系统的因果涌现能力是必需的,其中 <math> \text{Syn}(X_{t}; X_{t+1}) > 0 </math> | + | 对于这个定义,系统的因果涌现能力是必需的,其中 <math> \text{Syn}(X_{t}; X_{t+1}) > 0 </math> ,因为对于任何超涌现特征 Vt,都有 <math> \text{Un}(V_{t}; X_{t+1} \mid X_{t}) \leq \text{Syn}(X_{t}; X_{t+1}) </math>成立。对应于系统能力的分类,当 <math> \text{Un}(V_{t}; X_{t+1} \mid X_{t}) > 0 </math>或者 <math> \text{Un}(V_{t}; X_{t}^{2} + 1 \mid X_{t}) > 0 </math>时,特征变量 V 存在向下的因果作用。 |

| + | |||

| + | 当 <math> \text{Un}(V_{t}; V_{t+1} \mid X_{t}, X_{t+1}) > 0 </math> 时,存在因果解耦,这也取决于系统的容量。此外,如果 <math> \text{Un}(V_{t}; X_{t}^{\alpha} + 1 \mid X_{t}) = 0 </math>且 ,则称 Vt 具有纯粹的因果解耦。如果所有涌现特征都表现出纯粹的因果解耦,则称系统是完全解耦的。 | ||

| − | |||

| 第77行: | 第78行: | ||

三个指标如下: | 三个指标如下: | ||

| − | 1. <math> \Psi_{t, t+1}(V) := I(V_{t}; V_{t+1}) - \sum_{j} I(X_{tj}; V_{t+1}) </math> | + | 1. <math> \Psi_{t, t+1}(V) := I(V_{t}; V_{t+1}) - \sum_{j} I(X_{tj}; V_{t+1}) </math>,这个指标衡量的是两个时间步长之间宏观变量的互信息减去每个微观状态与宏观状态之间的互信息。 |

| − | 2. <math> \Delta_{t, t+1}(V) := \max_{j} I(V_{t}; X_{tj+1}) - \sum_{i} I(X_{ti}; X_{tj+1}) </math> | + | 2. <math> \Delta_{t, t+1}(V) := \max_{j} I(V_{t}; X_{tj+1}) - \sum_{i} I(X_{ti}; X_{tj+1}) </math>,这个指标是Vt与Xtj+1之间互信息的最大值与Xti与Xtj+1之间互信息总和之间的差的最大值。 |

| − | 3. <math> \Gamma_{t, t+1}(V) := \max_{j} I(V_{t}; X_{tj+1}) </math> | + | 3. <math> \Gamma_{t, t+1}(V) := \max_{j} I(V_{t}; X_{tj+1}) </math>,这个指标是Vt与Xtj+1之间最大互信息。 |

对于上述指标,V是一个预定义的宏观变量。

这些指标的具体用途如下:

| 对于上述指标,V是一个预定义的宏观变量。

这些指标的具体用途如下:

| ||

| − | 1. 当<math> \Psi_{t, t+1}(V) > 0 </math> | + | 1. 当<math> \Psi_{t, t+1}(V) > 0 </math> ,这是Vt因果涌现的充分条件。 |

| − | 2. 当<math> \Delta_{t, t+1}(V) > 0 </math> | + | 2. 当<math> \Delta_{t, t+1}(V) > 0 </math> ,这是Vt表现出向下因果的充分条件。 |

| − | 3. 当<math> \Psi_{t, t+1}(V) > 0 | + | 3. 当<math> \Psi_{t, t+1}(V) > 0 </math>且Γt,t+1(V) = 0时,这构成了因果解耦的充分条件。 |

总的来说,Rosas提出了一种基于<math> \Phi ID </math>的定量表征和分类因果涌现的方法,通过建立因果涌现与不同时间点变量的协同效应之间的关系,并进一步对因果涌现进行了分类。该定义不仅提供了对系统因果出现能力的客观评估,而且能够衡量与特定宏观特征相关的因果出现。他的重要贡献包括弥合因果出现研究与定量实证研究之间的差距,对不同类型的因果出现进行分类,以及补充关于这一主题的哲学讨论。 | 总的来说,Rosas提出了一种基于<math> \Phi ID </math>的定量表征和分类因果涌现的方法,通过建立因果涌现与不同时间点变量的协同效应之间的关系,并进一步对因果涌现进行了分类。该定义不仅提供了对系统因果出现能力的客观评估,而且能够衡量与特定宏观特征相关的因果出现。他的重要贡献包括弥合因果出现研究与定量实证研究之间的差距,对不同类型的因果出现进行分类,以及补充关于这一主题的哲学讨论。 | ||

2024年11月3日 (日) 03:27的版本

简介

基于信息分解的因果涌现理论是一种用于理解和量化复杂系统中因果关系的理论框架。该理论通过信息分解的方法,将系统中多个目标变量与源变量之间的互信息分解为不重叠的信息原子,包括独特信息、冗余信息和协同信息。基于这些信息原子的内在特性,该理论提供了一种量化因果涌现的定义,即通过测量源和目标变量之间的协同信息来确定因果涌现。该理论不仅能够识别出数据中的因果涌现现象,还能够基于特定的宏观动态来量化数据中的因果涌现。这为理解复杂系统中的因果关系提供了新的视角。

相关概念

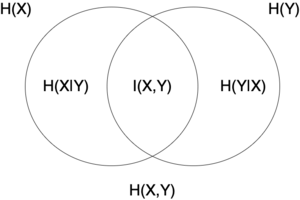

信息熵与互信息

在信息论中,随机变量的熵(entropy,又称信息熵、信源熵、平均自信息量)量化了变量的不确定性。考虑到变量所有潜在状态的概率分布,该指标衡量了描述变量状态所需的预期信息量。

给定一个离散随机变量 [math]\displaystyle{ X }[/math],其取值于集合 [math]\displaystyle{ \mathcal{X} }[/math],且服从 [math]\displaystyle{ p\colon \mathcal{X}\to[0, 1] }[/math] 分布,则熵为 [math]\displaystyle{ \Eta(X) := -\sum_{x \in \mathcal{X}} p(x) \log p(x), }[/math] 其中 [math]\displaystyle{ \Sigma }[/math] 表示变量可能值的总和。[math]\displaystyle{ \log }[/math] 的底数(即 对数)的选择因应用不同而不同(通常采用2)。

与熵紧密相关的是互信息(mutual Information,MI)。对于两个随机变量,互信息度量了两者间相互依赖的程度(成对关系)。具体来说,互信息测量了一个随机变量由于已知另一个随机变量而减少的“信息量”。离散随机变量 X 和 Y 的互信息可以计算为:

-

[math]\displaystyle{ \operatorname{I}(X; Y) = \sum_{y \in \mathcal Y} \sum_{x \in \mathcal X} { P_{(X,Y)}(x, y) \log\left(\frac{P_{(X,Y)}(x, y)}{P_X(x)\,P_Y(y)}\right) }, }[/math]

({{{3}}})

-

其中 [math]\displaystyle{ P_{(X,Y)} }[/math] 是 [math]\displaystyle{ X }[/math] 和 [math]\displaystyle{ Y }[/math] 的 联合概率 mass 函数,并且[math]\displaystyle{ P_X }[/math] 和 [math]\displaystyle{ P_Y }[/math] 分别是 [math]\displaystyle{ X }[/math] 和 [math]\displaystyle{ Y }[/math] 的 边际概率 质量函数。

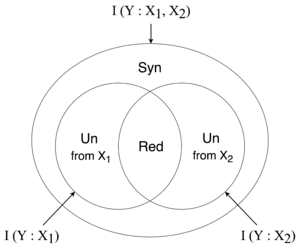

部分信息分解

在信息熵与互信息的基础上,部分信息分解(Partial Information Decomposition)是信息论的进一步扩展,旨在将信息论所关注的成对关系拓展到多个变量间的复杂相互作用。

在两变量场景下,信息论可以通过相互信息 [math]\displaystyle{ I(X_1;Y) }[/math] 量化单个源变量 [math]\displaystyle{ X_1 }[/math] 对目标变量 [math]\displaystyle{ Y }[/math] 的信息量。如果我们考虑加入第三个变量 [math]\displaystyle{ X_2 }[/math]并探讨其中某一变量与另两个变量的关系时,经典信息论则只能描述联合变量 [math]\displaystyle{ \{X_1,X_2\; }[/math] 与 [math]\displaystyle{ Y }[/math] 的相互信息,由 [math]\displaystyle{ I(X_1,X_2;Y) }[/math] 给出,而无法深入探究 [math]\displaystyle{ X_1 }[/math] 和 [math]\displaystyle{ X_2 }[/math] 及其相互作用与 [math]\displaystyle{ Y }[/math] 间存在何种关系。

这种传统测度局限性的一个体现就是变量间的协同效应:假设我们有两个独立的布尔变量作为源变量 [math]\displaystyle{ X_1, X_2 \in \{0,1\; }[/math] 和一个通过对源变量进行抑或操作所得到的目标变量 [math]\displaystyle{ Y=XOR(X_1,X_2) }[/math]。在这种情况下,总互信息 [math]\displaystyle{ I(X_1,X_2;Y)=1 }[/math],而个体互信息 [math]\displaystyle{ I(X_1;Y)=I(X_2;Y)=0 }[/math]。也就是说,[math]\displaystyle{ X_1,X_2 }[/math] 关于 [math]\displaystyle{ Y }[/math] 的相互作用产生了协同信息,而这无法用经典信息论中的互信息或是信息熵量轻易捕捉到。

对于更加一般的三变量场景而言,部分信息分解将源变量 [math]\displaystyle{ \{X_1,X_2\; }[/math] 与目标变量 [math]\displaystyle{ Y }[/math] 之间的互信息分解为四个部分:

[math]\displaystyle{ I(X_1,X_2;Y)=\text{Unq}(X_1;Y \setminus X_2) + \text{Unq}(X_2;Y \setminus X_1) + \text{Syn}(X_1,X_2;Y) + \text{Red}(X_1,X_2;Y) }[/math]

此处各个信息原子定义为

- [math]\displaystyle{ \text{Unq}(X_1;Y \setminus X_2) }[/math] 表示特有信息,是指每一个微观态变量单独给宏观态提供的信息:[math]\displaystyle{ X_1 }[/math] 具有的关于 [math]\displaystyle{ Y }[/math] 的“独特”信息,而 [math]\displaystyle{ X_2 }[/math] 中没有这些信息。

- [math]\displaystyle{ \text{Syn}(X_1,X_2;Y) }[/math] 表示协同信息,是指所有微观态 [math]\displaystyle{ X_1 }[/math] 和 [math]\displaystyle{ X_2 }[/math] 联合在一起给宏观态 [math]\displaystyle{ Y }[/math] 提供的信息。

- [math]\displaystyle{ \text{Red}(X_1,X_2;Y) }[/math] 表示冗余信息,是指两个微观态[math]\displaystyle{ X^1 }[/math]和[math]\displaystyle{ X^2 }[/math]重复地给宏观态 [math]\displaystyle{ Y }[/math] 的“冗余”信息。

其中 [math]\displaystyle{ \text{Red}(X_1,X_2;Y) + \text{Unq}(X_1;Y \setminus X_2) = I(X_1;Y) }[/math] , [math]\displaystyle{ \text{Red}(X_1,X_2;Y) + \text{Unq}(X_2;Y \setminus X_2) = I(X_2;Y) }[/math]。

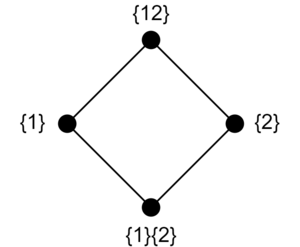

信息分解除了能够被韦恩图所直观的呈现,更常被表示为晶格图的形式以在更多变量的情况下维持简洁的结构。晶格图(lattice)是抽象代数中研究的一种抽象结构,它由一个偏序集组成。信息分解所得到的信息原子也可以被描述为一组冗余晶格。该晶格图包含了由源变量集合的所有非空子集所组合构成的所有(无重复变量的)集合,每一个这种集合对应了一个节点。以两变量 [math]\displaystyle{ \{X_1,X_2\; }[/math] 为例,集合 {1,2} 的所有非空子集包含 {1,2} {2} 和 {1},因此所能构成的无重复变量的集合包括 {{1,2}} {{2}} {{1}} 和 {{1}{2}}。如下图所示,这些反链(anti-chain)与上图的信息原子一一对应,既{{1,2}} 对应协同信息,{{2}} 和 {{1}} 对应特有信息,{{1}{2}}对应冗余信息。

整合信息分解

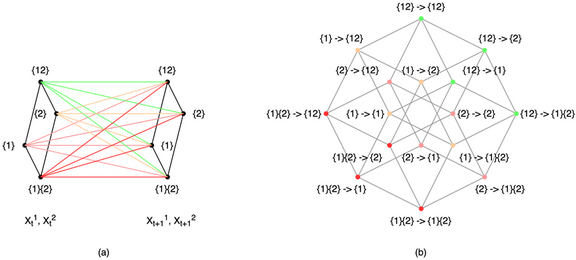

整合信息分解(Integrated Information Decomposition)是Rosas等[1]对于信息分解理论的进一步拓展。与部分信息分解关注一组变量与一个变量间的互信息不同,整合信息分解关注于两组变量间互信息的更细致划分。具体而言,该框架对两组变量间的互信息进行了两次不同方向的部分信息分解,分别是 1)将第一组的变量视为源变量,第二组的联合变量视作目标变量进行部分信息分解。2)反之,将第二组的变量视为源变量,第一组的联合变量视作目标变量进行部分信息分解。由于两次分解都是针对相同的两组变量间的互信息,因此我们得到了对该互信息的两种划分方式,通过对这两种划分方式进行组合,我们便得到了更加细粒度的信息分解框架。该框架对部分信息分解框架中目标变量的数量进行了进一步的拓展,使得我们能够分析源变量等于目标变量的场景。而其中最重要的应用场景之一就是马尔科夫系统的上下时刻间子系统间的关系,这也奠定了整合信息分解框架作为因果涌现框架的理论基础。

以两变量系统 [math]\displaystyle{ \{X_1,X_2\; }[/math] 为例,下图a中是前后向视角下分别对系统上下时刻互信息的分解结果,通过对这两种视角进行结合便得到了下图b中的16个信息原子。

基本概念

因果涌现框架

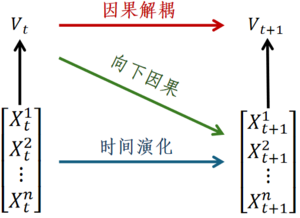

Rosas等[2]从整合信息分解理论的视角出发,提出一种基于信息原子定义因果涌现的方法,并将因果涌现进一步区分为:因果解耦(Causal Decoupling)和向下因果(Downward Causation)两部分。其中因果解耦表示当前时刻宏观态对下一时刻宏观态的因果效应,向下因果表示上一时刻宏观态对下一时刻微观态的因果效应。因果解耦和向下因果的示意图如下图所示,其中微观状态输入为[math]\displaystyle{ X_t\ (X_t^1,X_t^2,…,X_t^n ) }[/math],宏观状态是[math]\displaystyle{ V_t }[/math],它由微观态变量[math]\displaystyle{ X_t }[/math]粗粒化而来,因而是[math]\displaystyle{ X_t }[/math]的随附特征(Supervenience),[math]\displaystyle{ X_{t+1} }[/math]和[math]\displaystyle{ V_{t+1} }[/math]分别表示下一时刻的微观和宏观状态。

因果涌现定义

具体而言,作者基于系统上下时刻间互信息的整合信息分解后的信息原子提出了两种因果涌现的定义方法:

1)在指定了系统的宏观随附特征[math]\displaystyle{ V_t }[/math]时,当特有信息[math]\displaystyle{ Un(V_t;X_{t+1}| X_t^1,\ldots,X_t^n\ )\gt 0 }[/math],表示当前时刻的宏观态[math]\displaystyle{ V_t }[/math]能超过当前时刻的微观态[math]\displaystyle{ X_t }[/math]给下一时刻的整体系统[math]\displaystyle{ X_{t+1} }[/math]提供更多信息,这时候系统存在着因果涌现;

2)在未指定系统的宏观随附特征时,基于系统当前时刻的微观态[math]\displaystyle{ X_t }[/math]和下一时刻的微观态[math]\displaystyle{ X_{t+1} }[/math]之间的协同信息[math]\displaystyle{ Syn(X_t^1,…,X_t^n;X_{t+1}^1,…,X_{t+1}^n )\gt 0 }[/math],若该协同信息大于零,则系统发生了因果涌现。

值得注意的是,对于方法一判断因果涌现的发生需要依赖宏观态[math]\displaystyle{ V_t }[/math]的选择,其中方法二是方法一的下界。这是因为,[math]\displaystyle{ Syn(X_t;X_{t+1}\ ) ≥ Un(V_t;X_{t+1}| X_t\ ) }[/math]衡成立。所以,如果[math]\displaystyle{ Un(V_t;X_{t+1}| X_t\ ) }[/math]大于0,则系统必然会出现因果涌现。然而[math]\displaystyle{ V_t }[/math]的选择往往需要预先定义粗粒化函数,因此方法一无法回避Erik Hoel因果涌现理论的局限。而另外一种借助协同信息来判断因果涌现发生的方法同样存在不足,既协同信息的计算是非常困难的,存在着组合爆炸问题。因此,第二种方法基于协同信息的计算往往也是不可行的。总之,这两种因果涌现的定量刻画方法都存在一些弱点,因此,更加合理的量化方法有待被提出。

因果涌现充分指标

在PID框架中,基于协同信息的概念,Rosas引入了使用 [math]\displaystyle{ \Phi ID }[/math] 框架的因果涌现的定量定义,以应对确定适当粗粒化策略的挑战。该定义包括两个方面:首先,确定系统是否具有生成因果涌现的能力;其次,评估在特定宏观特征下因果涌现的发生。 关于系统展示因果涌现的能力,该定义建立了因果涌现与不同时间点变量之间协同关系之间的联系。因此,如果且仅当系统Xt被表示为具有因果涌现特征的能力时: [math]\displaystyle{ Syn(X_{t}; X_{t+1}) \gt 0 }[/math].

在这种背景下,因果涌现被理解为在马尔可夫动力系统中,先前时刻和后续时刻变量之间的协同效应。然后,Rosas在[math]\displaystyle{ \Phi ID }[/math]框架中进一步将因果涌现分为两个部分,向下因果性和因果解耦,这是基于信息原子的不同特征。通过使用[math]\displaystyle{ \Phi ID }[/math]分解互信息[math]\displaystyle{ I(X_{t}; X_{t+1}) }[/math]得到的十六个信息原子中,有四个信息原子对应于协同效应,这被视为因果涌现的组成。这些原子表示为,其中[math]\displaystyle{ \alpha \in A = \{\{\{1\}\{2\}\}, \{1\}, \{2\}, \{12\}\} }[/math]。

此外,Rosas还提供了一种量化特定宏观变量(即粗粒化策略)因果涌现的方法。如果一个系统具有产生因果涌现的能力,那么它可能会有一些表现出因果涌现的宏观特征。如果一个特征变量V在系统在时间t的完整状态X已知且精确度完美的情况下,对于时间t+1的未来状态没有提供任何预测能力,那么这个特征变量V被认为是依赖于底层系统的。这等同于Vt在给定Xt的情况下与Xt+1统计独立。然后,对于由Xt描述的系统,如果一个依赖特征Vt表现出因果作用,当且仅当: [math]\displaystyle{ \text{Un}(V_{t}; X_{t+1} \mid X_{t}) \gt 0 }[/math]。

对于这个定义,系统的因果涌现能力是必需的,其中 [math]\displaystyle{ \text{Syn}(X_{t}; X_{t+1}) \gt 0 }[/math] ,因为对于任何超涌现特征 Vt,都有 [math]\displaystyle{ \text{Un}(V_{t}; X_{t+1} \mid X_{t}) \leq \text{Syn}(X_{t}; X_{t+1}) }[/math]成立。对应于系统能力的分类,当 [math]\displaystyle{ \text{Un}(V_{t}; X_{t+1} \mid X_{t}) \gt 0 }[/math]或者 [math]\displaystyle{ \text{Un}(V_{t}; X_{t}^{2} + 1 \mid X_{t}) \gt 0 }[/math]时,特征变量 V 存在向下的因果作用。

当 [math]\displaystyle{ \text{Un}(V_{t}; V_{t+1} \mid X_{t}, X_{t+1}) \gt 0 }[/math] 时,存在因果解耦,这也取决于系统的容量。此外,如果 [math]\displaystyle{ \text{Un}(V_{t}; X_{t}^{\alpha} + 1 \mid X_{t}) = 0 }[/math]且 ,则称 Vt 具有纯粹的因果解耦。如果所有涌现特征都表现出纯粹的因果解耦,则称系统是完全解耦的。

尽管提出了因果涌现的严格定量定义,但[math]\displaystyle{ \Phi ID }[/math]可能很复杂且计算量很大,因此很难将该方法应用于实际系统。此外,PID 计算的不一致性导致因果涌现的定义依赖于特定的 PID 计算。

为了解决这些问题,Rosas简化了因果涌现的计算,并建立了一套基于因果解耦和向下因果的识别标准。具体来说,为了避免深入探讨协同信息和冗余信息的具体量化方法,这套标准通过反复减去冗余信息,使得结果成为因果涌现的充分条件,这样做虽然牺牲了一些普遍性,但提高了可靠性。

三个指标如下:

1. [math]\displaystyle{ \Psi_{t, t+1}(V) := I(V_{t}; V_{t+1}) - \sum_{j} I(X_{tj}; V_{t+1}) }[/math],这个指标衡量的是两个时间步长之间宏观变量的互信息减去每个微观状态与宏观状态之间的互信息。

2. [math]\displaystyle{ \Delta_{t, t+1}(V) := \max_{j} I(V_{t}; X_{tj+1}) - \sum_{i} I(X_{ti}; X_{tj+1}) }[/math],这个指标是Vt与Xtj+1之间互信息的最大值与Xti与Xtj+1之间互信息总和之间的差的最大值。

3. [math]\displaystyle{ \Gamma_{t, t+1}(V) := \max_{j} I(V_{t}; X_{tj+1}) }[/math],这个指标是Vt与Xtj+1之间最大互信息。

对于上述指标,V是一个预定义的宏观变量。 这些指标的具体用途如下:

1. 当[math]\displaystyle{ \Psi_{t, t+1}(V) \gt 0 }[/math] ,这是Vt因果涌现的充分条件。

2. 当[math]\displaystyle{ \Delta_{t, t+1}(V) \gt 0 }[/math] ,这是Vt表现出向下因果的充分条件。

3. 当[math]\displaystyle{ \Psi_{t, t+1}(V) \gt 0 }[/math]且Γt,t+1(V) = 0时,这构成了因果解耦的充分条件。

总的来说,Rosas提出了一种基于[math]\displaystyle{ \Phi ID }[/math]的定量表征和分类因果涌现的方法,通过建立因果涌现与不同时间点变量的协同效应之间的关系,并进一步对因果涌现进行了分类。该定义不仅提供了对系统因果出现能力的客观评估,而且能够衡量与特定宏观特征相关的因果出现。他的重要贡献包括弥合因果出现研究与定量实证研究之间的差距,对不同类型的因果出现进行分类,以及补充关于这一主题的哲学讨论。

PID和[math]\displaystyle{ \Phi ID }[/math]框架在各种应用中解释数据方面具有潜力。例如,Luppi等人最近使用[math]\displaystyle{ \Phi ID }[/math]方法来分析大脑的BOLD信号,旨在识别大脑的协同核心。他们的发现揭示了协同信息促进了不同大脑区域的整合,而冗余有助于稳健性。这项研究为理解大脑的潜在机制提供了宝贵的见解。

部分信息分解技术的进步使得进一步分析变量之间的互信息成为可能,从而从多个角度更深入地理解系统属性。在Varley等人的研究中,作者应用部分信息分解来分解系统的互信息。他们使用Williams和Beer提出的方法计算了一个协同偏差指标,以评估协同信息如何在系统的不同层级之间分布。更高的协同偏差表明在协同关系中涉及更多的部分信息。随后,作者观察到,在某些表现出因果涌现的系统中,当系统被简化或减少时,协同偏差会增加。这表明随着我们对系统进行粗粒度化处理,部分信息从冗余转变为协同。得出的总体结论是,涌现可以被理解为一种信息转换的形式。

因果涌现识别

在前面的部分中,我们介绍了几个通过因果关系和其他信息论概念来量化涌现性。所有这些作品都试图提出定量的度量、概念框架和基于马尔可夫动力学的涌现因果性的数值示例。然而,在实际应用中,为了实施一个理论框架,我们需要能够自动地从真实数据中识别因果涌现,特别是动态系统的时序数据,并对结果提供解释。

因果涌现识别的第一种方法是在罗萨斯关于因果涌现的论文中介绍的,涉及由方程式定义的三个指标。识别标准在三个案例研究中得到了例证,得出以下结论:粒子碰撞在康威的生命游戏(Conway’s Game of Life)中作为一个独特的特征出现,鸟群动态在模拟的鸟类行为中作为一个特征出现,皮层中运动行为的表示从神经活动出现。

尽管这三个指标避免了冗余信息计算的问题,但重要的是要注意,它们作为充分条件,而不是涌现性的决定性证明。换句话说,大于0的指标可以表明存在涌现性,但小于0的指标并不一定意味着不存在涌现性。这个指标的构建在识别具有大量冗余信息或大量变量的系统中的涌现性时面临挑战,这在许多现实世界系统中通常是常见的情况。此外,这种方法的一个局限性是需要预先确定粗粒化变量V,而这个变量的不同选择可能会显著影响结果。因此,基于数据开发一个自动粗粒化策略仍然是一个未解决的问题。

因此,当前的因果涌现理论框架缺乏一个实用和有效的识别算法。尽管以前的研究提出了基于静态网络结构和信息分解近似的方法,但仍然需要一个全面的方法,可以应用于一般的马尔可夫动态系统。主要挑战之一是,需要在数据中搜索粗粒度或分解子集的所有可能功能,以识别复杂系统中的因果关系。然而,传统的数值方法无法处理与在广阔的函数空间中进行如此广泛的搜索相关的计算成本。因此,开发新的方法来解决这些问题势在必行。我们探索了机器学习技术的应用,以解决在时间序列数据中识别因果出现的挑战。

应用案例

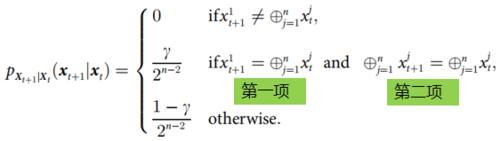

文[2]中作者列举了一个具体的例子(如上式),来说明什么时候发生因果解耦、向下因果以及因果涌现。该例子是一个特殊的马尔科夫过程,这里,[math]\displaystyle{ p_{X_{t+1}|X_t}(x_{t+1}|x_t) }[/math]表示动力学关系,[math]\displaystyle{ X_t=(x_t^1,…,x_t^n )\in \left\{0,1\right\}^n }[/math]为微观态。该过程的定义是通过检查前后两个时刻的变量[math]x_t[/math]和[math]x_{t+1}[/math]的取值,也就是判断[math]x_t[/math]的所有维度模2求和是否与[math]x_{t+1}[/math]的第一个维度相同来确定下一时刻状态[math]x_{t+1}[/math]取不同数值概率的:如果不同,则概率取0;否则则再判断[math]x_t,x_{t+1}[/math]在所有维度上是否都有相同的模2和,如果两个条件都满足,则取值概率为[math]\gamma/2^{n-2}[/math],否则取值概率为[math](1-\gamma)/2^{n-2}[/math]。这里[math]\gamma[/math]为一个参数,[math]n[/math]为x的总维度。

实际上,如果[math]\displaystyle{ \sum_{j=1}^n x^j_t }[/math]是偶数或者0时[math]\displaystyle{ \oplus^n_{j=1} x^j_t:=1 }[/math],反之[math]\displaystyle{ \oplus^n_{j=1} x^j_t:=0 }[/math],因此[math]\displaystyle{ \oplus^n_{j=1} x^j_t }[/math]的结果是X整体序列的奇偶性,而第一个维度则可以看作是一个奇偶校验位。[math]\displaystyle{ \gamma }[/math]实际上表示X序列某两个位产生了突变,并且该突变却能够保证整体序列的奇偶性不变,以及序列的奇偶校验位也符合序列整体的实际奇偶性的概率。

因而该过程的宏观态可以就看做是整个序列所有维度和的奇偶性,该奇偶性的概率分布是微观态的异或计算的结果。[math]x_t^1[/math]是一个特殊的微观态,它始终与上一时刻序列的宏观态保持一致。因此,当第二个判断条件中只有第一项成立时该系统发生向下因果条件,只有第二项成立时系统发生因果解耦,两项同时成立时则称系统发生因果涌现。

与同类框架的比较

与Hoel 的框架的比较

将 Hoel 的框架与 Rosas 的因果涌现量化框架进行比较,可以发现后者有几个明显的优势。首先,Rosas 的理论不需要预先确定的粗粒化方法,这使得它在数学上更加严谨和正式。其次,它对因果涌现进行了详细的分解,特别是向下因果关系和因果解耦。最后,它有效地避免了伪因果涌现的情况,即宏观变量仅依赖于微观变量中的独特或冗余信息。然而,也有一些缺点需要考虑。首先,为了获得完整的信息格,需要对所有变量组成进行系统迭代。此外,尽管使用了公式,但仍需要定义一个宏变量。不幸的是,作者没有提供任何方法来识别这样的变量。其次,所有互信息及其分解都是基于相关性而不是因果关系。讨论如何将因果因素(例如干预和反事实)纳入框架至关重要。最后,前面的讨论并没有解决根据给定的行为时间序列数据来识别系统中是否发生因果涌现的问题。为了解决这个问题,需要应用机器学习和人工智能等新兴技术。这些技术可以为检测和分析因果涌现提供有价值的工具和技术。

附录

关联关键词解析:

1. 因果涌现:在复杂系统中,宏观层面的因果关系可能比微观层面更加明显,即宏观层面的因果关系能够解释更多的现象。

2. ϕID(phiID):一种用来衡量因果涌现的方法,但其数学公式复杂且计算量大,难以应用于现实世界系统。

3. PID计算:一种计算方法,由于其不一致性,导致因果涌现的定义依赖于特定的PID计算方法。

4. 因果解耦:宏观变量与微观变量之间的因果关系被削弱或消除。

5. 向下因果:宏观层面的因果关系对微观层面产生影响。

6. 互信息:衡量两个变量之间共享信息量的指标。

参考文献

- ↑ P. A. Mediano, F. Rosas, R. L. Carhart-Harris, A. K. Seth, A. B. Barrett, Beyond integrated information: A taxonomy of information dynamics phenomena, arXiv preprint arXiv:1909.02297 (2019).

- ↑ 2.0 2.1 Rosas F E, Mediano P A, Jensen H J, et al. Reconciling emergences: An information-theoretic approach to identify causal emergence in multivariate data[J]. PLoS computational biology, 2020, 16(12): e1008289.