数据分析

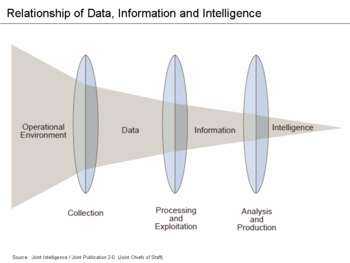

数据分析Data analysis是一个对数据进行检查、清洗、转换 transformation和建模的过程,其目的是收集有用的信息并得出结论,为决策作出信息支撑。数据分析涉及个方面并且有多种方法,涵盖了不同名称的技术,被用于商业、自然科学和社会科学等不同领域。在当今的商业世界,数据分析在帮助人们更科学地做出的决策和帮助企业更有效地运营方面发挥着重要作用。[1]

数据挖掘 Data mining是一种特殊的数据分析技术,侧重于统计建模和探索未来知识前景(而不仅仅是的描述行为目的)。同时,现代智能商业严重依赖于聚合的数据分析,尤其是在商业信息方面。[2] 在统计应用中,数据分析可以分为描述性统计学descriptive statistics、探索性数据分析exploratory data analysis (EDA)和实证性数据分析 confirmatory data analysis (CDA)。EDA 侧重于发现数据中的新特征,而 CDA 侧重于确认或证伪现有的假设。预测分析Predictive analytics的重点是应用统计模型进行预测或分类,而文本分析text analytics则应用统计学、语言学和结构化技术从文本源中提取和分类信息(文本是一种非结构化数据)。以上就是各种各样的数据分析。

数据整合 Data integration是数据分析的先驱,数据分析与数据可视化同数据传播data dissemination密切相关。[3]

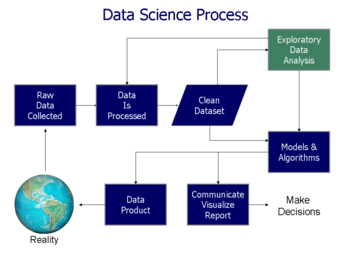

数据分析的流程

分析是指将一个整体分解成独立的部分来进行个别检查。数据分析是获取原始数据并将其转化为用户决策有用信息的过程。通过收集和分析数据来回答问题、检验假设或推翻理论。[4]

统计学家 John Tukey 在1961年将数据分析定义为“分析数据并解释这些过程所产生结果的技术,同时规划数据收集以使数据分析过程更容易、更精确或更准确的方法,以及所有适用于数据分析的(数学)统计的机制和结果。”[5]

数据分析可以分为以下几个步骤,如下所述。这些阶段是迭代的iterative,因为后期阶段的反馈可能会导致重复额外的与前期阶段相同的工作。用于数据挖掘的 CRISP 框架有类似的步骤。[6]

数据要求

有用以分析的输入数据是必须的,因为分析是基于数据来指导分析的人或客户的需求(这些人将使用分析的最终产品)而规定的。收集数据的一般实体类型称为实验单元experimental unit (例如,一个人或一群人)。关于总体 population的具体变量(例如,年龄和收入)可以被指定和获得。数据可以是数值变量的或分类变量的(也就是数字的文本标签)。[6]

数据收集

数据可以通过各种来源收集。需求可以由分析人员传达给数据保管人,例如组织内的信息技术人员。这些数据可以从环境中的传感器,如交通摄像机、卫星、记录设备等接收,也可以通过访谈、从网上资源下载或阅读文档而获得。[6]

数据处理

一开始获得的数据必须经过处理整合以便进行分析。以电子表格或统计软件为例,这可能涉及到将数据以表格格式放置到行和列中(即结构化数据 structured data)以便后续分析。[6]

数据筛选

一旦经过处理和组织,就会发现数据可能不完整、重复或含有错误。由于输入和存储数据的方式的问题,因此我们需要进行数据清理。数据筛选是预防和纠正这些错误的过程。常见的任务包括匹配记录、识别不准确的数据、监控现有数据的整体质量、处理数据重复和分割列等。[7]这样的数据问题也可以通过很多种分析技术来识别。例如,利用财务信息,可以将特定变量的与被所有数据认为可靠的单独公布的数字进行比较。[8] 高于或低于预先确定的阈值的异常数额可能会被核查。有几种类型的数据清理依赖于数据的类型,如电话号码,电子邮件地址,雇主等。异常值检查outlier detection的定量方法可以用来去除可能的输入错误的数据。文本数据拼写检查器Textual data spell checkers可以用来减少拼写错误单词的数量,但是很难判断这些单词本身是否正确。[9]

探索性数据分析

数据被筛选之后就可以进行分析。分析者可能会运用各种被称为探索性数据分析的技术着手理解数据中包含的信息。[10][11] 发现的过程可能导致额外的数据清洗或数据请求,因此这些活动可能具有迭代性质。在描述统计学量,例如平均值或中位数时,就可以用来帮助理解数据。数据可视化还可以被用于检查图形格式的数据,以获得关于数据中的信息的额外的洞察力。[6]

建模和算法

数学公式或被称为算法的模型可用于在数据中识别变量之间的关系,如相关性或因果关系。一般来说,模型可以根据以下规则建立:根据数据中的其他变量来评估数据中的某一特定变量,并用基于模型的准确性设置残差(即数据 = 模型 + 误差)。[4]

统计推断 Inferential statistics包括测量特定变量之间关系的技术。例如,回归分析可以用来建立广告的变化的模型,可以知道广告的变化(独立变量 [math]\displaystyle{ x }[/math])是否可以解释销售的变化(因变量 [math]\displaystyle{ y }[/math])。用数学术语来说,[math]\displaystyle{ y }[/math](销售)是 [math]\displaystyle{ x }[/math] (广告)的函数。它可以被描述为[math]\displaystyle{ Y = aX + b + error }[/math],其中模型的设计使得 [math]\displaystyle{ a }[/math] 和 [math]\displaystyle{ b }[/math] 在模型某预测给定范围 [math]\displaystyle{ x }[/math] 的 [math]\displaystyle{ y }[/math] 时具有最小的误差。分析人员可能会尝试建立描述数据的模型,以简化分析和表示结果。[4]

数据产品

数据产品是一种计算机应用程序,它接收数据输入并产生输出,将它们反馈回到环境中。它可能基于一个模型或算法。一个例子是一种可以分析客户购买历史并推荐客户可能喜欢的其他物品的应用程序。[6]

交流

数据被分析后可以用多种格式报告给分析的用户,以支持他们的需求。这些用户可能会有一些反馈,从而需要进行额外的分析。因此,大部分的分析周期是迭代的。[6]

在决定如何传达结果的时候,分析师可能会考虑数据可视化 data visualization技术来帮助清晰有效地向听众传达信息。数据可视化使用信息显示(如表格和图表)来帮助传递数据中的关键信息。表格对查找特定数字的用户很有帮助,而图表(例如柱状图或折线图)可以帮助解释数据中的定量信息。

定量数据

Stephen Few 描述了用户可能试图从一组数据以及用于帮助传达信息的相关图表中理解或传达的八种定量信息。指定需求的客户和执行数据分析的分析人员可以在分析过程中考虑这些消息。

- 时间序列: 在一段时间内捕捉单一变量,如10年间的失业率。可以用折线图来说明趋势。

- 排名: 按升序或降序对分类子类目进行排名,例如按销售人员(即类别,每个销售人员都有一个分类子类目)对一个时期内的销售业绩(即测量)进行排名。条形图可以用来在销售人员之间比较。

- 部分对整体: 分类子类目是以部分占整体的比例来衡量的(即占100% 的百分比)。饼图或条形图可以用来显示比率的比较,例如市场中竞争对手所占的市场份额。

- 偏差 Deviation: 将分类子类目与参考数据进行比较,例如对一个企业的几个部门在给定时间内实际支出与预算支出进行比较。条形图可以比较实际金额与参考金额的差异。

- 频率分布 Frequency distribution: 显示特定变量在给定时间间隔内的观测数量,例如股票市场回报率在0-10% 、11-20% 等时间间隔内的年数。直方图作为一种条形图可以用来进行这种分析。

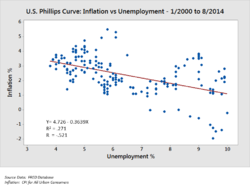

- 相关性: 用两个变量[math]\displaystyle{ (x,y) }[/math]表示的观测值之间的比较,以确定它们是否倾向于朝相同或相反的方向移动。例如,通常使用散点图绘制几个月的失业率x和通货膨胀率[math]\displaystyle{ y }[/math]之间的关系。

- 名义变量的比较 Nominal comparison: 比较分类子类目而没有特定的顺序,例如按产品代码标注的销售量。条形图可能被用于作这种比较。

分析定量数据的技术

作者Jonathan Koomey推荐了一系列理解定量数据的最佳方法。其中包括:

- 在实施数据分析之前检查原始数据中的异常值 anomalies;

- 重新执行重要的计算,例如验证公式驱动formula driven的数据列;

- 确认总和是部分的和;

- 检查那些可以通过一些方法预测的数字之间的关系,例如随时间变化的比例;

- 使数字正态化以便于比较,例如分析每个人的数量,或相对于GDP 的数量,或相对于基准年的数量指数;

- 通过分析导致结果的因素将问题整体分解为几个部分,如净资产收益率return on equity的杜邦分析DuPont analysis[8]。

对于被调查的变量,分析师通常会得到它们的描述统计 descriptive statistics变量,比如平均数、中位数和标准差。他们还可以分析关键变量的分布情况,来看各个值是如何围绕平均数聚集的。

一个用于数据分析的MECE 原理MECE principle的说明。麦肯锡咨询公司的顾问们提出了一种将定量问题分解为其组成部分的技术,称为 MECE 原理。每一层都可以分解成它的组成部分; 每一个子组成部分必须相互排斥,共同构成它们上一级的层次。这种关系被称为相互独立,完全穷尽 Mutually Exclusive and Collectively Exhaustive或 MECE。例如,根据定义,利润可以分为总收入和总成本。反过来,总收入可以通过其组成部分进行分析,如部门 A、 B 和 C 的收入(它们相互独立),并且它们的总和应该是总收入(总体上完全穷尽)。

分析师可能会使用稳健的统计测量来解决特定的分析问题。当分析师对事件的真实状态做出特定假设,并收集数据以确定事件的真实状态时,就使用假设检验Hypothesis testing。例如,一个假设可能是“失业对通货膨胀没有影响” ,这个假设与一个叫做菲利普斯曲线Phillips Curve的经济学概念有关。假设检验包括考虑第一类和第二类错误的可能性,这些错误与数据是否支持接受或拒绝假设有关。

当分析师试图确定自变量[math]\displaystyle{ X }[/math]对因变量[math]\displaystyle{ Y }[/math]的影响程度时,可以使用回归分析Regression analysis的方法(例如,“失业率([math]\displaystyle{ X }[/math])的变化对通货膨胀率([math]\displaystyle{ Y }[/math])的影响程度如何?”)。这是一种建模或拟合一个方程直线(或曲线)数据的尝试,使得 [math]\displaystyle{ Y }[/math] 是 [math]\displaystyle{ X }[/math] 的一个函数。

当分析师试图确定自变量[math]\displaystyle{ X }[/math]在多大程度上允许变量[math]\displaystyle{ Y }[/math]的出现时,可以使用必要条件分析Necessary condition analysis(NCA),(例如,“某个失业率[math]\displaystyle{ X }[/math]在多大程度上对某个通货膨胀率[math]\displaystyle{ Y }[/math]是必要的? ”)。 (多重)回归分析分析使用加法逻辑additive logic,其中每个 [math]\displaystyle{ X }[/math] 变量可以产生结果,[math]\displaystyle{ X }[/math] 之间可以相互补偿(这些[math]\displaystyle{ X }[/math]都是充分的,但不是必要的) ,然而必要条件分析使用必要逻辑necessity logic,其中一个或多个[math]\displaystyle{ X }[/math] 变量允许结果的存在,但也可能不产生这个结果(它们是必要不充分的关系)。每个单一的必要条件都必须存在,变量之间不允许补偿。

数据用户的分析活动

与上面概述的一般的消息传递不同,用户可能对数据集当中的特定数据点感兴趣。下表介绍了这种低层次的用户分析活动。分类可以由活动的三个极来组织: 检索值retrieving values、查找数据点finding data points和排列数据点arranging data points。[15][16][17][18]

| # | Task | General Description |

Pro Forma Abstract |

Examples |

|---|---|---|---|---|

| 1 | Retrieve Value | 给定特定的一组案例,找出这些案例的属性。 | 数据案例{A, B, C, ... }中属性{ X, Y, Z, ... }的值是什么? | “-每加仑汽油在福特Mondeo车上的行驶里程是多少?”

“-电影《乱世佳人》有多长?” |

| 2 | 过滤Filter | 给定属性值的一些具体条件,找出满足这些条件的数据案例。 | 哪些数据案例满足条件{A, B, C... } ? | “什么家乐氏麦片含有高纤维?(注:Kellogg‘s (家乐氏) 公司为全球知名谷物早餐和零食制造商。)”

“哪些喜剧获了奖?” “-哪些基金的表现不如 SP-500?” |

| 3 | 计算派生值Compute Derived Value | 给定一组数据案例,计算这些数据案例以聚合形式表示的数值。 | 聚合函数aggregation function F 在给定数据集 S 上的值是多少? | “-波斯特谷物Post cereals的平均热量是多少?”

“-所有商店的总收入是多少?” “-有多少汽车制造商?” |

| 4 | 寻找极值Find Extremum | 查找数据集中在某属性的某范围内具有极端取值的数据案例。 | 属性 A 的顶部或底部的 N 个数据案例是什么? | “- 有最高 MPG 的汽车是什么?”

“- 哪个导演/哪部电影获奖最多?” “- 哪部漫威电影公司的电影具有最近上映的日期?” |

| 5 | 排序 Sort | 给定一组数据案例,根据某种顺序度量对它们进行排序。 | 根据属性 A 的值,一组数据案例 S 怎样排序? | “-按重量给汽车排序。”

“- 按卡路里排列谷物。” |

| 6 | 确定范围 Determine Range | 给定一组数据案例和一个感兴趣的属性,查找该组中的值的范围。 | 在一组数据案例 S 中,属性 A 的值范围是多少? | “-胶卷的长度范围是多少?”

“-汽车的马力范围是多少?” “-数据库里有哪些女演员?” |

| 7 | 特征分布 Characterize Distribution | 给定一组数据案例和一个感兴趣的定量属性,刻画该属性值在该集上的分布情况。 | 属性 A 的值在一组数据案例 S 中的分布情况如何? | “-谷物中碳水化合物的分布情况如何?”

“-购物者的年龄分布情况如何?” |

| 8 | 寻找异常值 Find Anomalies | 识别给定数据集中与给定关系或期望有关的任何异常值,例如统计异常值。 | 在一组数据案例中,哪些数据案例具有意外的或异常的取值? | “-马力和加速度之间的关系有例外吗?”

“-蛋白质是否有异常值?” |

| 9 | 集群 Cluster | 给定一组数据案例,找出相似属性值的集群。 | 一组数据案例中的哪些数据案例在属性{ X, Y, Z, ... }的值上相似? | “-有没有含脂肪 / 卡路里 / 糖类似的谷类食物?”

“-是否有一组典型的电影长度?” |

| 10 | 相关 Correlate | 给定一组数据案例和两个属性,确定这些属性值之间的有用关系。 | 在给定的数据案例集 S 中,属性 X 和 Y 之间的相关性是什么? | “-碳水化合物和脂肪之间有关系吗?”

“-起源国和 MPG 之间有联系吗?” “- 不同性别是否倾向不同的付款方式?” “- 电影长度是否有逐年增加的趋势?” |

| 11 | 语境化 Contextualization[18] | 给定一组数据案例,找出数据与用户语境化的相关性。 | 一组数据案例中的哪些数据案例与当前用户的语境相关? | “-是否有几组餐馆根据我目前摄入的热量来提供食物?” |

有效分析中存在的问题

数据的分析人员之间或分析结果的受众之间可能存在有效分析的障碍。区分'事实fact与观点opinion 、认知偏差cognitive biases 和数学盲innumeracy都是对一个好的数据分析的挑战。

混淆事实和观点

有效分析 Effective analysis需要获得相关的事实来回答问题、支持结论、支持正式的观点,或者检验假设。事实的定义是不可辩驳的,这意味着任何参与分析的人都应该能够同意它们。例如,2010年8月,美国国会预算办公室Congressional Budget Office(CBO)估计,延长布什2001年和2003年的2011-2020年减税政策将使国家债务增加约3.3万亿美元。[19]每个人都应该能够同意这确实是国会预算办公室报告的;他们都可以检查报告。这使该报告的内容成为一个事实。人们可以选择自己观点:是否同意国会预算办公室的报告。

另一个例子是,上市公司的审计师必须就上市公司的财务报表是否“在所有重大方面得到公允陈述”达成正式意见,这需要对事实数据和证据进行广泛的分析,以支持他们的观点。在从事实到观点的飞跃中,总是存在着观点错误的可能性。

认知偏差

各种各样的认知偏差cognitive biases会对分析产生不利影响。例如,证实偏见confirmation bias是指人们倾向于以确认自己先入之见的方式来寻找或解释信息。此外,人们都可能会质疑那些与他们观点不相符的信息。

为了了解和克服这些偏见,分析师可能会接受专门培训。退休的美国中情局分析师Richards Heuer在他的《情报分析心理学Psychology of Intelligence Analysis》一书中写道,分析师应该清楚地描述他们的预设和推断链,明确结论中包含的不确定性的程度和来源。他强调有助于提出和辩论不同观点的程序。[20]

数学盲

高效的分析师通常善于使用各种数字的技术。然而,受众可能没有这样的数字和算术读写能力;他们被认为是数学盲Innumeracy。或者是传递数据的人的数据分析技术过于糟糕,会导致出现误导mislead或误报misinform的情况。[21]

例如,一个数是上升还是下降可能不是关键因素。更重要的可能是相对于另一个数的数,例如相对于经济规模(国内生产总值)的政府收入或支出,或者公司财务报表中相对于收入的成本金额。这种数的技术称为归一化normalization[8] 或共同比common-sizing。分析师们通常都会使用这样的数据分析技术来进行调整,无论是对通货膨胀进行调整(如,比较实际数据与名义上的数据) ,还是考虑人口增长、人口统计学信息等。

数据分析人员应该要能应用各种技术来处理上面一节中提到的描述的各种定量信息的问题。

分析师也可能在不同的假设或情景下分析数据。例如,当分析师进行财务报表分析时,他们通常会根据不同的假设重新编制财务报表,以得出对未来现金流的估计,然后根据一定的利率贴现到现在的价值,以确定公司或其股票的估价。同样,国会预算办公室分析了各种政策选择对政府收入、支出和赤字的影响,为关键措施创造了可供选择的方案。

其他主题

智能建筑

数据分析方法可以用来预测建筑物的能源消耗。[22]

数据分析过程的不同步骤是为了实现智能建筑,建筑的管理和控制操作,包括供暖heating、通风ventilation、空调air conditioning、照明lighting和安保security,都是通过模拟大厦使用者的需要和优化能源和时间等资源来自动实现的。

分析和商业智能

分析是“广泛使用数据、统计和定量分析、解释和预测模型,以及基于事实的管理来驱动决策和行动。”它是商业智能的一个子集,而商业智能是一组使用数据来理解和分析商业表现的技术和流程。[23]

教育

在教育方面,大多数教育工作者都可以使用数据系统来分析学生的数据。[24] 这些数据系统以场外交易数据格式over-the-counter data format(嵌入标签、补充文件和帮助系统,并作出关键的包装 / 展示和内容决策)向教育工作者提供数据以提高其数据分析的准确性。[25]

从业者注意事项

这个部分包含了一些技术性的解释,它们可能对从业者有所帮助,但是超出了维基百科文章的典型范围。

初始数据分析

在初始数据分析阶段和主要分析阶段之间最重要的区别是,在初始数据分析阶段,人们不进行任何旨在回答原始研究问题的分析。初始数据分析阶段由下列四个问题指导:

数据质量

应尽早检查数据的质量。数据质量可以通过几种方式,使用不同类型的分析进行评估: 频数、描述统计学量(平均值、标准差、中位数)、正态性(偏态、峰度、频率直方图)、 n: 变量与数据集外部变量的编码方案进行比较,如果和编码方案不具有可比性,则可能对数据进行修正。

- 检验共同方法变异common-method variance

在初始数据分析阶段,评估数据质量的分析方法的选择取决于将在主要分析阶段进行的分析。

测量的质量

当测量仪器的质量不是研究的重点或研究问题的时候,它只能在初始数据分析阶段进行检验。从业者应该检查测量仪器的结构是否符合文献报告的结构。

有两种方法来评估测量: [注意: 似乎只列出了一种方法]

- 同质性检验(内部一致性internal consistency)用来表示测量仪器的可靠性Reliability。在这个分析过程中,我们会检查各个项目的变异和量尺刻度,量尺的克隆巴赫α系数 Cronbach’s alpha ,以及当一个项目从量尺上被删除时克隆巴赫α系数的变化。

初始的转换

在对数据和测量的质量进行评估之后,从业者可能会决定填补缺失的数据,或者对一个或多个变量进行初始的转换initial transformations,尽管这也可以在主要分析阶段进行。

变量可能的转换如下:[26]

- 平方根转换(如果数据分布与正态分布略有不同)

- 对数转换(如果数据分布与正态分布大不相同)

- 倒数转换(如果分布与正态分布严重不同)

- 分类变量处理(顺序或二元变量)(如果分布与正态分布严重不同,且没有转换方法可以补救)

研究的实施是否完成了研究设计的目的?

从业者应该检查随机化程序是否成功,例如通过检查背景变量background variables和实质变量substantive variables是否在组内和组间均匀分布。

如果研究不需要或不使用随机化程序,则应检查非随机抽样是否成功,例如检查样本是否代表了相关总体的所有分组。

其他应该检查的可能的数据扭曲有:

- 数据遗失Dropout(这应该在初始数据分析阶段进行识别)

- 项目回收率Response rate(是否随机,应在初始数据分析阶段进行评估)

- 操纵质量Treatment quality (使用操纵检验manipulation check)

数据样本的特征

在任何报告或文章中,样本的结构必须被准确描述。在主要分析阶段进行子群subgroups分析时,准确确定样本的结构(特别是子群的大小)尤为重要。

数据样本的特征可以通过以下几个方面进行评估:

- 重要变量的基本统计学特征

- 散点图

- 相关性和联系

- 交叉表Cross-tabulations

初始数据分析的最后阶段

在最后阶段,从业者需要记录初始数据分析的结果,并采取必要的、可取的和可能的纠正措施。

此外,主要数据分析的原始计划可以而且应该更详细地说明或重写。

为了做到这一点,应该对主要数据分析作出以下几个决定:

- 在非正态分布的情况下,是否应该:有数据转换变量;使变量分类化(序列化/二分类);改进分析方法?

- 在有缺失数据的情况下:是否应该忽视或插补缺失数据?应该使用哪种插值方法?

- 在有异常值的情况下:是否应该使用稳健的分析技术?

- 在项目和测量量尺不匹配的情况下:是否应省略项目以对测量仪器进行调整,还是应确保与其他(用途的)测量仪器具有可比性?

- 在具有(太)小的子群的情况下:是否应该放弃群体间差异的假设,或者使用小样本技术,比如精确检验exact tests或者bootstrapping?

- 在随机化程序似乎有缺陷的情况下:能够而且应该计算倾向分数propensity scores并将其作为协变量包括在主要分析中吗?

分析

在初始数据分析阶段可以使用以下几种分析:

- 单变量统计学(单变量)

- 双变量关联(相关)

- 图表技术(散点图)

在进行分析时必须考虑到变量的测量水平,因为每个水平都有专门的统计方法:

- 名义变量和顺序变量

- 频数(数和百分比)

- 相关

- circumambulations (交叉表crosstabulations)

- 层次对数线性分析hierarchical loglinear analysis(最多只能有8个变量)

- 对数线性分析 loglinear analysis(确定相关/重要的变量及可能的混淆因素)

- 精确检验exact tests或者bootstrapping(当子群很小时)

- 计算新变量

- 连续变量

- 分布

- 统计学量(均值M,标准差SD,方差,偏度,峰度)

- 茎叶图Stem-and-leaf displays

- 箱图Box plots

非线性分析

非线性分析Nonlinear analysis通常是必要的,当数据是从非线性系统中获取的时候。非线性系统可以表现出复杂的动力学效应,包括分岔bifurcations、混沌 chaos、谐波harmonics和次谐波subharmonics,这些效应不能用简单的线性方法进行分析。非线性数据分析与非线性系统辨识密切相关。[27]

主要数据分析阶段

主要分析阶段进行旨在回答研究问题的分析,以及撰写研究报告初稿所需的其他相关分析。

探索性和验证性方法

在主要的分析阶段,可以采用探索性或验证性的方法。通常方法是在收集数据之前决定的。探索性分析中,分析数据之前没有明确的假设,分析人员搜索能够很好地描述数据的模型。验证性分析对数据进行明确的假设检验。

对探索性数据分析的解释应该非常谨慎。当同时测试多个模型时,发现其中至少一个模型具有统计学意义显著的几率很高,但这可能是由于第Ⅰ 类错误。在测试多个模型时,总是调整显著性水平很重要,例如,使用Bonferroni校正。

另外,数据的探索性分析和验证性分析不应该在同一数据集中进行。

探索性分析是用来为一个理论寻找想法,但不是用来检验这个理论的。当一个数据集中使用探索性分析发现了一个模型,然后在同一个数据集中进行验证性分析,这可能仅仅意味着验证性分析的结果首先是由于和探索性分析中同样的 第Ⅰ类错误而导致的。因此,验证性分析不会比最初的探索性分析更有用。

结果的稳定性

得到一些能说明结果普适性的指标是非常重要的。虽然普遍性通常很难检验,但有表示结果的可靠性的一些方式。有两种主要的方法来保证结果的可靠和可重复性。

- 交叉验证Cross-validation。通过将数据分成多个部分,我们可以检查基于一部分数据的分析(如拟合模型)是否也可以推广到另一部分数据。不过如果数据内部(例如与面板数据panel data)存在相关性,那么交叉验证通常是不适当的。因此,有时需要使用其他验证方法。有关此主题的更多信息,请参阅统计模型验证statistical model validation。

- 灵敏度分析 Sensitivity analysis。一种在全局变量(系统地)变化时研究系统或模型的行为的程序。一种方式就是通过 Bootstrapping 方法。

用于数据分析的免费软件

著名的数据分析免费软件包括:

- DevInfo -联合国发展集团United Nations Development Group认可的用于监测和分析人类发展的数据库系统。

- ELKI -面向数据挖掘的可视化功能的 Java 数据挖掘框架。

- KNIME -Konstanz Information Miner,一个用户友好和综合的数据分析框架。

- Orange -可视化编程工具,具有交互式数据可视化interactive data visualization、数据可视化和统计数据分析方法、数据挖掘和机器学习的特点。

- 物理学分析工作站Physics Analysis Workstation(PAW)- CERN 开发的 FORTRAN/C 数据分析框架。

- R -用于统计计算和图形处理的编程语言和软件环境。

- ROOT - CERN ]开发的 C++ 数据分析框架

- SciPy -用于数据分析的 Python 库

- Julia - 一种非常适合数值分析和计算科学的编程语言。

国际性的数据分析比赛

很多的公司或组织纷纷举办数据分析竞赛,以鼓励研究人员利用他们的数据,或利用其数据分析技能解决特定的问题。以下是一些著名的国际数据分析比赛的例子。

- 由 FHWA 和 ASCE 举办的 LTPP国际数据分析竞赛。[29][30]

参见

- Actuarial science 精算学

- Analytics 分析

- Big data 大数据

- Business intelligence 商业智能

- Censoring (statistics) 截尾(统计学)

- Computational physics 计算物理学

- Data acquisition 数据采集

- Data blending 数据融合

- Data governance 数据治理

- Data mining 数据挖掘

- Data Presentation Architecture 数据展示架构

- Data science 数据科学

- Digital signal processing 数字信号处理

- Dimension reduction 降维

- Early case assessment 早期案件评估

- Exploratory data analysis 探索性数据分析

- Fourier analysis 傅里叶分析

- Machine learning 机器学习

- Multilinear principal component analysis|Multilinear PCA 多线性主成分分析

- Multilinear subspace learning 多线性子空间学习

- Multiway data analysis 多路数据分析

- Nearest neighbor search 最近邻搜索

- Nonlinear system identification 非线性系统识别

- Predictive analytics 预测分析

- Principal component analysis 主成分分析

- Qualitative research 量化研究

- Scientific computing 科学计算

- Structured data analysis (statistics) 结构化数据分析(统计学)

- System identification 系统识别

- Test method 文本方法

- Text analytics 文本分析

- Unstructured data 非结构化数据

- Wavelet 小波

- List of big data companies 大数据公司列表

参考文献

引用

- ↑ Xia, B. S., & Gong, P. (2015). Review of business intelligence through data analysis. Benchmarking, 21(2), 300-311. doi:10.1108/BIJ-08-2012-0050

- ↑ Exploring Data Analysis

- ↑ Sherman, Rick,. Business intelligence guidebook : from data integration to analytics. Amsterdam. ISBN 978-0-12-411528-6. OCLC 894555128. https://www.worldcat.org/oclc/894555128.

- ↑ 4.0 4.1 4.2 Judd, Charles and, McCleland, Gary (1989). Data Analysis. Harcourt Brace Jovanovich. ISBN 0-15-516765-0.

- ↑ John Tukey-The Future of Data Analysis-July 1961

- ↑ 6.0 6.1 6.2 6.3 6.4 6.5 6.6 Doing Data Science. O'Reilly Media. 2013. ISBN 978-1-449-35865-5.

- ↑ "Data Cleaning". Microsoft Research. Retrieved 26 October 2013.

- ↑ 8.0 8.1 8.2 Perceptual Edge-Jonathan Koomey-Best practices for understanding quantitative data-February 14, 2006

- ↑ Hellerstein, Joseph (27 February 2008). "Quantitative Data Cleaning for Large Databases" (PDF). EECS Computer Science Division: 3. Retrieved 26 October 2013.

- ↑ Stephen Few-Perceptual Edge-Selecting the Right Graph For Your Message-September 2004

- ↑ Behrens-Principles and Procedures of Exploratory Data Analysis-American Psychological Association-1997

- ↑ Grandjean, Martin (2014). "La connaissance est un réseau" (PDF). Les Cahiers du Numérique. 10 (3): 37–54. doi:10.3166/lcn.10.3.37-54.

- ↑ Stephen Few-Perceptual Edge-Selecting the Right Graph for Your Message-2004

- ↑ Stephen Few-Perceptual Edge-Graph Selection Matrix

- ↑ Robert Amar, James Eagan, and John Stasko (2005) "Low-Level Components of Analytic Activity in Information Visualization"

- ↑ William Newman (1994) "A Preliminary Analysis of the Products of HCI Research, Using Pro Forma Abstracts"

- ↑ Mary Shaw (2002) "What Makes Good Research in Software Engineering?"

- ↑ 18.0 18.1 "ConTaaS: An Approach to Internet-Scale Contextualisation for Developing Efficient Internet of Things Applications". ScholarSpace. HICSS50. Retrieved May 24, 2017.

- ↑ "Congressional Budget Office-The Budget and Economic Outlook-August 2010-Table 1.7 on Page 24" (PDF). Retrieved 2011-03-31.

- ↑ "Introduction". cia.gov.

- ↑ Bloomberg-Barry Ritholz-Bad Math that Passes for Insight-October 28, 2014

- ↑ González-Vidal, Aurora; Moreno-Cano, Victoria (2016). "Towards energy efficiency smart buildings models based on intelligent data analytics". Procedia Computer Science. 83 (Elsevier): 994–999. doi:10.1016/j.procs.2016.04.213.

- ↑ Davenport, Thomas and, Harris, Jeanne (2007). Competing on Analytics. O'Reilly. ISBN 978-1-4221-0332-6.

- ↑ Aarons, D. (2009). Report finds states on course to build pupil-data systems. Education Week, 29(13), 6.

- ↑ Rankin, J. (2013, March 28). How data Systems & reports can either fight or propagate the data analysis error epidemic, and how educator leaders can help. Presentation conducted from Technology Information Center for Administrative Leadership (TICAL) School Leadership Summit.

- ↑ Tabachnick & Fidell, 2007, p. 87-88.

- ↑ Billings S.A. "Nonlinear System Identification: NARMAX Methods in the Time, Frequency, and Spatio-Temporal Domains". Wiley, 2013

- ↑ "The machine learning community takes on the Higgs". Symmetry Magazine. July 15, 2014. Retrieved 14 January 2015.

- ↑ Nehme, Jean (September 29, 2016). "LTPP International Data Analysis Contest". Federal Highway Administration. Retrieved October 22, 2017.

- ↑ "Data.Gov:Long-Term Pavement Performance (LTPP)". May 26, 2016. Retrieved November 10, 2017.

自传

- Adèr, Herman J. (2008a). "Chapter 14: Phases and initial steps in data analysis". Advising on research methods : a consultant's companion. Huizen, Netherlands: Johannes van Kessel Pub. pp. 333–356.

- Adèr, Herman J. (2008b). "Chapter 15: The main analysis phase". Advising on research methods : a consultant's companion. Huizen, Netherlands: Johannes van Kessel Pub. pp. 357–386.

- Tabachnick, B.G. & Fidell, L.S. (2007). Chapter 4: Cleaning up your act. Screening data prior to analysis. In B.G. Tabachnick & L.S. Fidell (Eds.), Using Multivariate Statistics, Fifth Edition (pp. 60–116). Boston: Pearson Education, Inc. / Allyn and Bacon.

进一步阅读

- Adèr, H.J. & Gideon J. Mellenbergh (with contributions by D.J. Hand) (2008). Advising on Research Methods: A Consultant's Companion. Huizen, the Netherlands: Johannes van Kessel Publishing.

- Chambers, John M.; Cleveland, William S.; Kleiner, Beat; Tukey, Paul A. (1983). Graphical Methods for Data Analysis, Wadsworth/Duxbury Press.

- Fandango, Armando (2008). Python Data Analysis, 2nd Edition. Packt Publishers.

- Juran, Joseph M.; Godfrey, A. Blanton (1999). Juran's Quality Handbook, 5th Edition. New York: McGraw Hill.

- Lewis-Beck, Michael S. (1995). Data Analysis: an Introduction, Sage Publications Inc.

- NIST/SEMATECH (2008) Handbook of Statistical Methods,

- Pyzdek, T, (2003). Quality Engineering Handbook.

- Richard Veryard (1984). Pragmatic Data Analysis. Oxford : Blackwell Scientific Publications.

- Tabachnick, B.G.; Fidell, L.S. (2007). Using Multivariate Statistics, 5th Edition. Boston: Pearson Education, Inc. / Allyn and Bacon.

编者推荐

- 数据科学心法与机器学习实战 本课程是由具有 16 年数据科学工作经验的尹相志老师亲自教授的,以数据科学方法论与机器学习理论实践为主要内容的课程。从“数据科学的方法论”入手,向大家介绍数据科学的概念及技巧,同时凭借多年数据科学工作积累下的经验,给学员指出在数据科学任务中最易容遇到的错误。待学员逐渐熟悉数据科学的基本原理后,引出分类问题、推估问题、相似性问题这三种机器学习中最常见问题的解决方案,每个问题都配以实验案例来讲解。最后再以三个实际案例,“运营商通过数据设定留存客户的方法”、“基于大数据和深度学习的金融评级策略”、“产品内容推荐系统”,将数据科学的方法论与机器学习解决方案应用于实战。这三个案例涵盖了当前数据科学中最常见的应用场景,每个案例中都充满了主讲老师多年积累下的丰富经验与独创的技巧。

- 讲给文科生的 R 语言 本课程的主要目标是介绍R语言的基本操作,帮助上课的同学了解并掌握数据清理、数据可视化、统计分析以及文学式编程的初步技能。学完本课程,你就可以通过一个简单的项目入手,从问题理解、数据清洗、数据分析、数据可视化、数据展示等流程,完整的实现一个项目。

- 数据分析2020 这个课程是由北京师范大学系统科学学院樊瑛教授开设的研究生课程《数据分析》课程回放。课程通过理论、案例、实践三方面,介绍统计分析及其在实际领域中的应用。

本中文词条由嘉树编译,思无涯咿呀咿呀编辑,CecileLi审校。欢迎在讨论页面留言。

本词条内容源自wikipedia及公开资料,遵守 CC3.0协议。