控制理论 Control theory

控制理论 Control Theory 研究机器和工程过程中连续运行的动态系统的控制。控制理论旨在开发一种以最优动作控制此类系统的控制模型,避免出现 延迟 或 超调 ,并确保控制的稳定性。由于非常依赖相关学科的理论和实际应用,控制理论可以被视为控制工程、计算机工程、数学,控制论和运筹学的分支[1]。

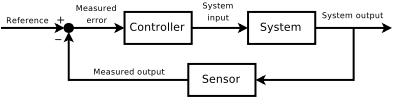

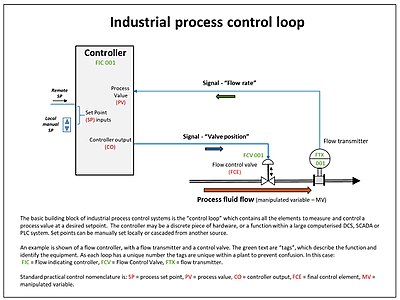

为了达到控制的目的,我们需要一个在必要时具有纠正行为的 控制器 。一个优秀的控制器应当监视受控过程变量 Process Variable PV ,并将其与参考值或设定值 Set Point SP 进行比较。在控制过程中,过程变量的实际值和期望值之间的差被称为 误差 信号(或称 SP-PV 误差),被作为反馈来产生控制效果,使被控制的过程变量达到与设定点相同的值;此外,控制理论中也引入了能控性和能观性。控制理论是高级自动化的基础,为制造、航空、通信和其他行业带来了革命性的影响。具有反馈作用的控制器的系统被称为反馈控制系统。反馈控制通常是 连续 的,使用[传感器]测量控制变量,并通过诸如控制阀等“最终控制元件”的计算调整,使被测变量保持在一定范围内[2]。

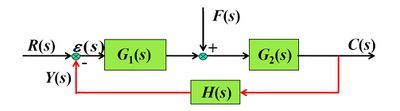

控制理论广泛使用方框图 Block Diagram 作为图解表示。其中,利用微分方程描述系统输入输出关系的数学模型一般被称为传递函数 Transfer Function ,也称系统函数 System Function 或网络函数 Network Function 。

控制理论的研究可以追溯到19世纪。麦克斯韦 James Clerk Maxwell 最先描述了调速器运行的理论基础[3]。控制理论分别被爱德华·劳斯 Edward Routh、查理斯·斯图姆 Charles Sturm在1874年、阿道夫·赫维兹 Adolf Hurwitz在1895年进一步发展,三人都为建立控制理论的稳定性判据做出了贡献;而[尼古拉斯·米诺尔斯基 Nicolas Minorsky ]在1922年发明的PID控制又将控制理论的发展向前推进了一大步[4]。虽然控制理论主要应用在工业界设计过程控制系统的控制系统工程领域,但其他的应用领域远远超出了这一范畴。作为反馈系统的一般理论,控制理论在反馈出现的任何场合都是适用的。

历史

虽然各种类型的控制系统可以追溯到远古时期,但是对控制领域进行形式化的分析则始于1868年物理学家詹姆斯·克拉克·麦克斯韦 Maxwell, J.C. 题为“On Governors”[5]的对离心式调速器的动力学分析。这个时候,离心式调速器已经被用来调节风车的速度。麦克斯韦描述并分析了自激振荡现象——系统的时滞效应可能导致系统的过度补偿和不稳定的后果。这项研究引起了人们的浓厚兴趣,这段时间麦克斯韦的同学劳斯 Routh 将前者的研究成果抽象成了关于线性系统的一般结果。 [6] 1877年,阿道夫·赫维兹 Hurwitz, A. 独立地利用微分方程对系统稳定性进行了分析,得出了现在的劳斯-赫维兹定理。 [7][8]

动态控制的一个著名应用场景是在载人飞行领域。1903年12月17日,莱特兄弟的飞行器首次试飞成功,他们的杰出之处在于所制作的飞行器的控制器具有在相当长的时间内控制飞机飞行的能力(据称比他们用机翼产生升力的能力要更强),连续、可靠地控制飞机对于长时间的飞行是非常重要的。

二战时期,控制理论的研究变得愈发重要。厄马加德·弗拉格·勒茨 Irmgard Flügge-Lotz 发明了非连续自动控制系统理论,并将 bang-bang 原理应用于飞机自动飞行控制装置的开发[9][10]。不连续控制的其他应用领域包括火控系统、制导系统和电子学等。

有时,我们也可以使用机械方法来提高系统的稳定性。例如,船舶稳定器——安装在吃水线下方并横向放置的鳍片,就是一种典型的机械控制应用。在现代船舶中,陀螺仪控制的活动鳍片具有改变其迎角的能力,以抵消风或波浪作用在船上引起的侧倾。

二战后的太空竞赛也非常依赖于精确的航天器控制。当代,控制理论在经济学和人工智能等领域的应用也越来越多。至此,我们也许可以认为控制的目标是找到一个遵循良好控制器定理的内部模型。比如,在经济学中,一个(股票或商品)交易模型越能准确地反映了市场的行为,它就越容易控制市场(并从中获取利润);在人工智能领域中,一个聊天机器人可以模拟人类的语言表达:它越能精确地模拟人类的状态(例如:在语音支持热线上的交互),就能越好地帮助人类(例如:采取各种措施来解决人们打电话时想解决的问题)。上述两个例子采用了历史上对控制理论的狭义解释,将其视为利用一组微分方程对运动和动力进行建模和调控的过程,并将其扩展为广义的调节器与受控对象的交互过程。

开环和闭环(反馈)控制

从根本上讲,控制回路有两种类型:开环控制和闭环(反馈)控制。

在开环控制中,来自控制器的控制动作独立于“过程输出”(或“受控过程变量 Controlled Process Variable”)。一个很好的例子是仅由计时器控制的中央供暖锅炉,因此无论建筑物的温度如何,都将热量恒定地施加。控制动作是定时打开/关闭锅炉,过程变量是建筑物温度,但两者都不相关。

在闭环控制中,来自控制器的控制动作取决于过程变量值的反馈。在类似于锅炉的情况下,闭环回路将包括一个恒温器,以将建筑物温度与恒温器上设定的温度(设定值)进行比较。这将产生一个控制器输出,通过打开和关闭锅炉来将建筑物维持在所需温度。因此,闭环控制器具有反馈回路,可确保控制器施加合适的控制动作,将过程变量操纵为与“参考输入”或“设定点”相同。因此,闭环控制器也称为反馈控制器[11]。

根据英国标准协会,闭环控制系统的定义是“一个具有监视反馈的控制系统,该反馈形成的偏差信号被用于控制最终控制元件的动作,从而尽可能使偏差减小到零。”[12]

同样,“反馈控制系统是一种倾向于通过比较变量的函数,并用差异作为控制手段,维护一个系统变量与另一个系统变量之间的预设关系的系统。” [13]

其他例子

控制系统的一个例子是汽车的巡航控制系统,该系统是一种将车速保持在驾驶员提供的期望速度或参考速度的设备。该系统的控制器是巡航控制器,受控对象是汽车,而系统是汽车和巡航控制器。系统输出是汽车的速度,控制变量本身是发动机的油门位置,用于确定发动机提供多少动力。

实现巡航控制的一个原始方法是在驾驶员启动巡航控制时锁定油门位置。不过,如果巡航控制系统运行在一段不平坦的道路上,车辆上山时行驶速度会较慢,下山时则较快。这种类型的控制器被称为开环控制器,因为没有反馈,没有测量系统输出(汽车的速度)来改变控制量(油门位置)。因此,控制器不能补偿作用在汽车上的变化,比如道路坡度的变化。

在闭环控制系统中,来自监测汽车速度(系统输出)的传感器的数据进入控制器,控制器连续比较代表速度的量和代表期望速度的参考量,计算得到的差称为误差,决定了气门的位置(控制量)。输出结果是匹配的汽车的速度参考速度(保持所需的系统输出)。现在,当汽车上坡时,输入(感知速度)和参考速度之间的差异持续地决定油门位置——当感觉到的速度低于参考值,差值增加,油门打开,发动机功率增加,加速车辆。这样,控制器动态地抵消汽车速度的变化。这些控制系统的中心思想是反馈回路:控制器影响系统的输出,反过来对输出进行测量并反馈给控制器。

经典控制理论

为了克服开环控制器的局限性,控制理论引入了反馈。闭环控制器利用反馈来控制动力系统的状态或输出。它的名字来源于系统中的信息传递路径: 过程输入(例如,电动机的电压)对过程输出(例如,电动机的速度或扭矩)的影响被传感器测量并经控制器处理;结果(控制信号)作为过程的输入被“反馈” ,形成闭环。

闭环控制器相对于开环控制器有以下优点:

- 干扰抑制(例如上述巡航控制示例中的山丘)

- 当模型结构与实际过程不完全匹配且模型参数不精确时,也可以在不确定的情况下保证系统性能。

- 不稳定的过程可以稳定下来

- 对参数变化的敏感性降低

- 参考跟踪性能得到改善

一些系统同时使用闭环控制和开环控制。在这样的系统中,开环控制被称为前馈,用于进一步改善参考跟踪性能。

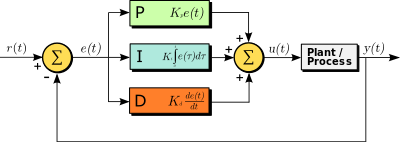

常用的闭环控制器架构是 PID 控制器。

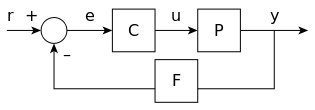

闭环传递函数

系统的输出 [math]\displaystyle{ y(t) }[/math] 通过传感器测量值 [math]\displaystyle{ F }[/math] 反馈给参考值 [math]\displaystyle{ r(t) }[/math] 进行比较。然后,控制器 [math]\displaystyle{ C }[/math] 利用参考和输出之间的误差 [math]\displaystyle{ e }[/math] (差值)来改变输入 [math]\displaystyle{ u }[/math] 到受控系统 [math]\displaystyle{ P }[/math] 。 如图所示。这种控制器是一种闭环控制器或反馈控制器。

上图是一种单输入单输出 SISO 控制系统; 另一种常见的控制系统为多输入多输出系统 MIMO ,具有多个输入/输出。在这种情况下,变量通过向量表示,而不是简单的标量值。对于一些分布参数系统,向量可能是无限维的(通常为函数)。

如果我们假设控制器 [math]\displaystyle{ C }[/math]、受控对象 [math]\displaystyle{ P }[/math] 和传感器 [math]\displaystyle{ F }[/math] 是线性时不变 LMI的(即它们的传递函数 [math]\displaystyle{ C(s) }[/math]、[math]\displaystyle{ P(s) }[/math] 和 [math]\displaystyle{ F(s) }[/math] 不依赖于时间),那么上述系统可以用拉普拉斯变换来分析。这就产生了以下关系:

- [math]\displaystyle{ Y(s) = P(s) U(s) }[/math]

- [math]\displaystyle{ U(s) = C(s) E(s) }[/math]

- [math]\displaystyle{ E(s) = R(s) - F(s)Y(s). }[/math]

用给定的 [math]\displaystyle{ R(s) }[/math] 解出 [math]\displaystyle{ Y(s) }[/math]。

- [math]\displaystyle{ Y(s) = \left( \frac{P(s)C(s)}{1 + P(s)C(s)F(s)} \right) R(s) = H(s)R(s). }[/math]

表达式 [math]\displaystyle{ H(s) = \frac{P(s)C(s)}{1 + F(s)P(s)C(s)} }[/math] 称为系统的闭环传递函数。分子是从 [math]\displaystyle{ r }[/math] 到 [math]\displaystyle{ y }[/math] 的正向(开环)增益,分母是1加上反馈回路中的增益,即所谓的回路增益。如果[math]\displaystyle{ |P(s)C(s)| \gg 1 }[/math],就是对于每个 [math]\displaystyle{ s }[/math] ,传递函数都有很大的范数。若存在 [math]\displaystyle{ |F(s)| \approx 1 }[/math],那么 [math]\displaystyle{ Y(s) }[/math] 大约等于 [math]\displaystyle{ R(s) }[/math],即输出紧密跟踪参考输入。

PID 反馈控制

比例-积分-微分控制器(PID 控制器)是一种广泛应用于控制系统的控制回路反馈控制器。

PID 控制器计算连续误差值 [math]\displaystyle{ e(t) }[/math] 作为期望的设定点和被测过程变量之间的差值,并根据比例、积分和微分项进行修正。PID 是比例-积分-微分 Proportional-Integral-Derivative 的缩写,对应于利用误差信号产生反馈控制信号的三项操作。

该理论的研究和应用可以追溯到20世纪20年代。PID控制几乎在所有的模拟控制系统中都得到了实现与应用:最初是在机械控制器中应用,后来又结合了离散电子学机型模拟控制系统的实施,之后在工业过程计算机中也得到了应用。PID 控制器是最常用的反馈控制器。

如果 [math]\displaystyle{ u(t) }[/math] 是发送到系统的控制信号,[math]\displaystyle{ y(t) }[/math] 是测量得到的输出,[math]\displaystyle{ r(t) }[/math] 是期望输出,[math]\displaystyle{ e(t)=r(t)- y(t) }[/math] 是跟踪误差,则 PID 控制器具有一般形式

- [math]\displaystyle{ u(t) = K_P e(t) + K_I \int e(\tau)\text{d}\tau + K_D \frac{\text{d}e(t)}{\text{d}t}. }[/math]

我们期望得到的闭环传递函数输出是通过调整三个参数 [math]\displaystyle{ K_P }[/math]、 [math]\displaystyle{ K_D }[/math]和 [math]\displaystyle{ K_I }[/math]得到的。通常我们用迭代式的“调参”法,而不需要依赖具体的受控对象模型知识。稳定性往往可以通过只使用比例项来保证,按照比例调节对系统偏差进行快速调节,减少误差,但是过大的比例会导致系统的稳定性下降;积分项可以消除稳态误差,提高无差度一般会同其他俩个调节方式组成PI或者PID调节器;微分项反映系统偏差信号的变化率,可以预见偏差变化的取试,可以产生超前控制作用,改善系统动态性能并减少超调量和调节时间,但是对噪声干扰有放大作用,不能单独使用,一般通过PD或PID两种形式进行应用。PID控制器是最成熟的一类控制器,但是PID并不适用于一些复杂的被控系统,特别是需要考虑 MIMO 系统时。

应用拉普拉斯变换得到变换后的 PID 控制器方程

- [math]\displaystyle{ u(s) = K_P e(s) + K_I \frac{1}{s} e(s) + K_D s e(s) }[/math]

- [math]\displaystyle{ u(s) = \left(K_P + K_I \frac{1}{s} + K_D s\right) e(s) }[/math]

具有 PID 控制器的传递函数

- [math]\displaystyle{ C(s) = \left(K_P + K_I \frac{1}{s} + K_D s\right). }[/math]

作为闭环系统[math]\displaystyle{ H(s) }[/math]中 PID 控制器调参的一个例子,考虑一个一阶被控对象

- [math]\displaystyle{ P(s) = \frac{A}{1 + sT_P} }[/math]

其中[math]\displaystyle{ A }[/math]和[math]\displaystyle{ T_P }[/math]是常数。被控对象的输出通过

- [math]\displaystyle{ F(s) = \frac{1}{1 + sT_F} }[/math]

反馈给输入,其中[math]\displaystyle{ T_F }[/math]也是常数。现在如果我们设[math]\displaystyle{ K_P=K\left(1+\frac{T_D}{T_I}\right) }[/math],[math]\displaystyle{ K_D=KT_D }[/math],和[math]\displaystyle{ K_I=\frac{K}{T_I} }[/math],我们就可以将 PID 控制器传递函数表示成如下序列形式

- [math]\displaystyle{ C(s) = K \left(1 + \frac{1}{sT_I}\right)(1 + sT_D) }[/math]

把 [math]\displaystyle{ P(s) }[/math], [math]\displaystyle{ F(s) }[/math],[math]\displaystyle{ C(s) }[/math] 输入到闭环传递函数 [math]\displaystyle{ H(s) }[/math] 中,我们发现,通过设置

- [math]\displaystyle{ K = \frac{1}{A}, T_I = T_F, T_D = T_P }[/math]

可以得到 [math]\displaystyle{ H(s) = 1 }[/math]。通过本例中的这个调参,系统输出精确地跟随参考输入。

然而,在实践中,由于噪声放大效应和谐振模式的影响,纯微分器既无法在物理上可实现的,得到的对应结果往往不符合控制的期望[14] 。因此我们使用相位超前补偿的方法,或者具有低通衰减性质的微分器来作为替代方案。

线性控制和非线性控制

控制理论可分为两个分支:

- 线性控制理论——适用于符合叠加原理的系统,这意味着输出大致与输入成比例。线性系统由线性微分方程决定,该分类中的最重要的子类是不随时间变化的参数的系统,称为线性时不变 LTI 系统。这些系统使用通用且功能强大的频域数学方法进行表示与计算,例如拉普拉斯变换,傅立叶变换,Z-变换,Bode图,根轨迹和奈奎斯特稳定性判据。使用这些技术有助于使用带宽,频率响应,特征值,增益,谐振频率,零点和极点等术语对系统进行描述,从而为大多数目标系统提供系统响应的解决方案和设计方式。

- 非线性控制理论——涵盖了更广泛的不遵循叠加原理的系统类别,并适用于更多实际系统,因为所有实际控制系统都是非线性的。这些系统通常由非线性微分方程决定。这些本就为数不多的数学方法针对此类问题,描述起来不仅更加困难,而且通用性较低,通常仅适用于很少类别的系统。非线性控制理论包括极限环理论,庞加莱图,李雅普诺夫稳定性定理和描述函数等。非线性系统通常用数值方法在计算机上进行分析,例如用仿真语言来对系统的运行进行仿真。如果仅关注稳定点附近的解,则通常可以使用微扰理论,用线性系统近似非线性系统,这样就可以使用线性系统的方法进行求解。[15]

分析技术-频域和时域

分析和设计控制系统的数学技术可分为两类:

- 频域表示法——在这类表示法中,状态变量的值,即代表系统输入、输出和反馈的数学变量用频率的函数来表示。输入信号与系统的传递函数是从时域方程经时域-频域变换而来,如拉普拉斯变换,傅立叶变换和Z-变换。这种变换的优点是可以简化数学公式的表达:在频域中,系统的微分方程被替换为代数方程,极大的方便了数学求解。一般来说,频域分析技术只适用于线性系统。

- 时域状态空间表示法——在这种类型中,状态变量的值被表示为时间的函数。在时域模型中,系统可以表示为一个或多个微分方程。由于频域分析仅限于线性系统,时域分析技术被广泛用于分析现实世界的非线性系统。尽管这些问题更难解决,但通过现代计算机仿真技术使得相应的分析变得相对常规化。

与经典控制理论的频域分析相反,现代控制理论利用时域状态空间表示法,用一个经一阶微分方程关联的一组输入、输出和状态变量构成的数学模型来描述对应的物理系统。为了将输入、输出和状态的数量值抽象出来,状态变量被表示为矢量,微分和代数方程以矩阵形式表达(后者仅在动力系统为线性时才可行)。状态空间表示法(也称为“时域方法”)提供了一种方便而紧凑的方式来建模并分析具有多个输入和输出的系统。对于具有输入输出的时域系统,可以使用拉普拉斯变换对系统进行计算。与频域方法不同,状态空间表示法的使用不限于线性和零初始条件的系统。“状态空间”是指其轴为状态变量的空间。系统的状态可以表示为该空间内的一个点[16][17]。

系统界面——SISO和MIMO

根据输入和输出的数量,控制系统可以分为不同的类别。

- 单输入单输出 SISO——这是最简单,最常见的类型,其中一个输出由一个控制信号控制。示例是上面的巡航控制示例,或者音频系统,其中控制输入是输入音频信号,输出是来自扬声器的声波。

- 多输入多输出 MIMO——见于更复杂的系统。例如,现代大型望远镜(例如Keck和MMT)具有由许多独立的部分组成的反射镜,每个部分都由一个执行器控制。整个反射镜的位置由MIMO主动光学控制系统使用焦平面上多个传感器的输入不断调整,以补偿由于热膨胀、收缩,旋转应力以及大气扰动引起的波阵面扭曲。复杂系统,例如核反应堆和人体细胞可以被视为大型MIMO控制系统,由计算机进行模拟。

控制理论主题

稳定性

零输入的一般动力系统的稳定性可以用李雅普诺夫稳定性标准来描述。

- 一个线性系统被称为有界输入有界输出 BIBO 稳定的,若系统对于任何有界输入的输出都是有界的。

- 非零输入的非线性系统的稳定性由输入-状态稳定性 ISS 表示,它结合了李雅普诺夫稳定性和一个类似于 BIBO 稳定性的概念。

为简单起见,下面的描述集中于连续和离散时间线性系统。

在数学上,这意味着一个线性系统若要稳定,其传递函数的所有极点都必须有负实部,即每个极点的实数部分必须小于零。实际上,稳定性意味着传递函数的复极点:

- 当使用拉普拉斯变换获得传递函数时,位于连续时间复平面的左半开平面。

- 当使用Z-变换时,位于离散时间平面的单位圆内。

这两种情况之间的区别仅仅是连续时间和离散时间传递函数的表示方法。连续的拉普拉斯变换是在笛卡尔直角坐标系中,其中[math]\displaystyle{ x }[/math]轴是实轴,离散的Z-变换是在极坐标系中,其中[math]\displaystyle{ \rho }[/math]轴是实轴。

当满足合适的条件时,系统被称为渐近稳定的,渐近稳定系统的变量总是自初值不断减少,且不会出现永久的振荡。当极点的实部精确等于零(连续情况)或模量等于1(离散情况)时,就会发生永久振荡。如果一个简单稳定系统的响应既不随时间衰减也不随时间增长,并且没有振荡,那么它是临界稳定的;在这种情况下,系统传递函数在复平面原点处具有非重极点(即在连续时间情况下,它们的实数和复数分量为零)。当实部等于零的极点的虚部不等于零时,就存在振荡。

如果一个系统的冲激响应为

- [math]\displaystyle{ \ x[n] = 0.5^n u[n] }[/math]

其Z-变换(参见[本例])为

- [math]\displaystyle{ \ X(z) = \frac{1}{1 - 0.5z^{-1}} }[/math]

在[math]\displaystyle{ z = 0.5 }[/math] (虚部为0)处有一个极点。因此这个系统是 BIBO(渐近)稳定的,因为极点在单位圆内。

然而,如果冲激响应是

- [math]\displaystyle{ \ x[n] = 1.5^n u[n] }[/math]

那么其Z-变换

- [math]\displaystyle{ \ X(z) = \frac{1}{1 - 1.5z^{-1}} }[/math]

极点在[math]\displaystyle{ z = 1.5 }[/math]上。因为极点的模严格大于1,所以系统不是BIBO稳定的。

有许多工具可用来分析系统的极点。包括根轨迹,波特图或奈奎斯特图等图形表示方法。

机械的改变可以使设备(和控制系统)更加稳定。水手们增加压舱物以改善船只的稳定性。游轮使用从船侧横向延伸约30英尺(10米)的防侧翻鳍,并不断地绕轴旋转,以产生阻止侧翻的力。

能控性和能观性

能控性和能观性是系统分析中的主要问题,它影响着我们选用何种方式的控制策略,以及系统是否可控和稳定。能控性与使用适当的控制信号使系统进入特定状态的可能性有关。如果一个状态是不能控的,那么没有信号将永远能够控制该状态。如果一个状态是不能控的,但它的动力学特性是稳定的,那么这个状态称为能镇定的。相反,能观性与通过输出量度观测系统状态的可能性有关。如果一个状态不能观,控制器将永远不能确定一个不能观的行为,因此不能使用它来稳定系统。然而,类似于上面的镇定性条件,如果一个状态不能被观察到,它仍然可能是能检测的。

如果从几何的角度来看待控制系统中每个变量的状态,这些变量的每个“坏”状态必须是能控和能观的,以确保闭环系统中的良好行为。也就是说,如果闭环系统的特征值之一不是能控能观的,则这部分的动力学性能在闭环系统中保持不变。如果这样一个特征值不稳定,这个特征值将在闭环系统中体现出不稳定行为。在状态空间表示的传递函数中,不能观的极点并不存在,这就是在动力系统分析中有时倾向于使用后者的原因。

解决不可控或不可观测系统问题的方法包括增加执行器和传感器。

控制规范

自始至今,人们已经发明了许多不同的控制策略,其中有诸如PID一类应用及其广泛的控制器,也有针对特定系统设计的控制器(尤其是在机器人或飞行器巡航控制领域)。

控制问题的解决方式可以有不同方式,但是系统稳定性始终是最重要的。无论开环稳定性如何,控制器都必须确保闭环系统稳定。控制器选择不当甚至会恶化开环系统的稳定性,因此在控制器选择过程中应该极力避免选择错误的控制器。有时,我们希望在闭环系统中获得特定的动力学特征,即极点满足[math]\displaystyle{ Re[\lambda] \lt -\overline{\lambda} }[/math],而不是简单地要求[math]\displaystyle{ Re[\lambda] \lt 0 }[/math],其中 [math]\displaystyle{ \overline{\lambda} }[/math] 是一个严格大于零的固定值。

另一个典型的案例是抑制阶跃扰动;抑制阶跃扰动的方式非常简单,可以通过在开环系统中(即直接在受控系统之前)添加一个积分器来实现。其他类型的扰动则需要添加不同类型的子系统来实现扰动的抑制。

其他“经典”控制理论规范与闭环系统的时域响应有关。其中包括上升时间(控制系统在扰动后达到期望值所需的时间)、超调量(响应达到期望值之前达到的最高值)和其他性能指标(稳定时间、1/4衰减等)。频域规范通常与鲁棒性有关(见后文)。

现代的性能评估使用一些集成的跟踪误差的变体(IAE,ISA,CQI)。

模型辨识与鲁棒性

控制系统必须具有一定的鲁棒性。鲁棒的控制器可以保证在其被应用于与数学模型略微不同的物理系统时其特性不发生明显变化。这一要求很重要,因为没有任何一个真正的物理系统的行为和数学上用于表示它们的微分方程所描述的行为完全一致。为了简化计算,我们通常会选择简化的数学模型,否则,真正的系统动力学特性会复杂到不可能为其建立一个完整的模型。

系统辨识

确立决定模型动力学方程的过程称为系统辨识。这个过程可以离线完成:例如,执行一系列测量,从测量结果中计算近似的数学模型,通常是传递函数或传递矩阵。但是,从输出中进行的这种辨识无法包括不可观部分的动力学特性。有时,模型是直接从已知的物理方程式开始构建的,例如,我们知道对于质量-弹簧-阻尼器系统,[math]\displaystyle{ m \ddot{{x}}(t) = - K x(t) - \beta \dot{x}(t) }[/math]。即使假设在设计控制器时使用了“完整”的模型,我们也不可能知道这些方程中包含的所有参数(称为“标称/名义参数”)的绝对精确值;而控制系统即使在所连接的物理系统的真实参数值与标称值不同的情况下也必须正确运行。

一些先进的控制策略包括“在线”识别过程(见后文),其中模型的参数在控制器本身运行时就被计算(“辨识”)。在这种方式下,如果参数发生剧烈变化,例如,如果机器人的手臂释放一个重物,控制器将自我调整以确保自身正确运作。

分析

SISO控制系统的鲁棒性可以通过在频域内使用传递函数,并结合奈奎斯特和波特图进行分析。这一部分关心增益、相位裕度以及幅值裕度。对于MIMO系统,以及一般而言更复杂的控制系统,设计者必须考虑每种控制策略对应的理论结果(见下一节)。也即,如果需要特殊的鲁棒性,工程师必须将注意力转移到可以将其属性囊括进去的控制策略上。

约束条件

一个特殊的鲁棒性问题是要求控制系统在有输入和状态约束的情况下正确运行。在物理世界中,每个信号都是有限的。控制器可能会发送物理系统无法跟踪的控制信号,例如,试图以超高速旋转阀门。这可能会导致闭环系统发生不良行为,甚至损坏执行器或其他子系统。有一些特定的控制策略可以解决该问题:模型预测控制(见下文)和抗饱和系统。后者包括一个附加的控制块,可确保控制信号不会超过给定的阈值。

系统分类

线性系统控制

对于MIMO系统,我们可以使用开环系统的状态空间表示法,通过计算期望极点位置对应的反馈矩阵,在数学上设计极点的配置方案。在复杂的系统中,这可能需要计算机辅助计算,并且不一定能确保鲁棒性。此外,一般情况下不会测量所有的系统状态变量,因此观测器也必须包括在极点配置设计中。

非线性系统控制

机器人和航空航天等领域的过程通常具有强烈的非线性动力特性。在控制理论中,有时可以将这类系统线性化并应用线性分析策略,但在许多情况下,从头设计允许控制非线性系统的理论是有其必要的。这些控制方法,例如反馈线性化控制、反推控制、滑动模式控制、轨迹线性化控制通常利用了基于李亚普诺夫理论的结果。微分几何已经被广泛应用于将线性控制概念推广到非线性情况,以及展示那些使非线性问题更加复杂的细节层面的原因。控制理论也被用来解释决定认知状态的神经机制[18]。

分布式系统控制

当系统由多个控制器控制时,问题就变成了分布式控制问题。去中心化在许多方面都很有帮助,例如,它可以使控制系统在更大的地理范围内运行。分布式控制系统中的智能体可以利用通信信道进行交互并协调其行为。

确定性和随机性系统控制

随机控制问题研究的是状态变量的演变受到系统外部随机冲击的问题。确定性控制问题不受外部随机信号的影响。

主要控制策略

每个控制系统首先必须保证闭环稳定性。对于线性系统,这可以通过直接配置极点来实现。非线性控制系统使用特定的理论(通常基于李亚普诺夫理论)以在不考虑系统内部动力学特性的前提下确保系统的稳定性。实现不同规范的可能性随模型和控制策略的不同而不同。

主要控制策略列表

- 自适应控制使用在线方法识别过程参数,或修改控制器的增益,借此获得了强大的鲁棒性。1950年代,自适应控制首次应用于航空航天领域,并取得了极大成功。

- 分层控制系统是设备和控制软件按照层级树结构组织的一类控制系统。当树中的链接由计算机网络实现时,该分层控制系统也是网络控制系统的一种形式。

- 智能控制使用各种人工智能计算方法来控制动态系统,例如人工神经网络,贝叶斯概率,模糊逻辑,[19] 机器学习,进化计算和遗传算法或这些方法的组合(例如神经模糊算法)。

- 最优控制是一种利用控制信号优化某个“成本指标”的特殊控制技术:例如,卫星进入指定轨迹所需的喷射推力消耗的燃料需要最小化。由于已经证明可以保证闭环稳定性,有两种最优控制设计方法已在工业界广泛使用:模型预测控制 MPC和线性二次高斯控制 LQG。前者可以更明确地考虑对系统中信号的约束,而这是许多工业过程中的重要特征。但是,MPC中的“最佳控制”结构只是实现目标的手段之一,因为它没有最优化闭环控制系统的实际性能指标。MPC系统与PID控制器是过程控制中使用最广泛的控制技术。

- 鲁棒控制明确地解决了控制器设计方法的不确定性。使用鲁棒控制方法设计的控制器往往能够应对真实系统与用于设计的标称模型之间的微小差异。[20] 波特 Bode 和其他人使用的早期方法相当鲁棒;而1960年代和1970年代发明的状态空间方法有时则缺乏鲁棒性。现代鲁棒控制技术的例子包括邓肯·麦克法兰 Duncan McFarlane 和基思·格洛弗 Keith Glover 开发的H-infinity控制,由瓦迪姆·乌特金 Vadim Utkin 开发的滑动模式控制 SMC,以及旨在控制智能电网应用中的大量异构负载[21] 的安全协议。鲁棒控制的目标是在存在微小建模误差的情况下实现稳健性和/或稳定性。

- 随机控制处理模型内部存在不确定性的控制设计。在典型的随机控制问题中,我们假设模型和控制器中存在随机噪声和干扰,并且控制设计必须考虑这些随机偏差。

- 能量成型控制将受控对象和控制器视为能量转换设备。控制策略根据能实现目标行为的互联模式(以一种节省能源的方式)构建。

- 自组织临界控制可以定义为试图干扰自组织系统耗散能量的过程。

系统和控制领域的科学家

许多活跃的历史人物对控制理论作出了重要贡献,其中包括

- 皮埃尔·西蒙·拉普拉斯 Pierre-Simon Laplace 在概率论研究中发明了Z-变换,现在用于解决离散时间控制理论问题。Z-变换是以他名字命名的拉普拉斯变换的离散时间等价表达。

- 厄马加德·弗拉格·勒茨 Irmgard Flugge-Lotz 提出了不连续自动控制的理论,并将其应用于飞行器自动控制系统。

- 1890年代的亚历山大·李雅普诺夫 Alexander Lyapunov标志着稳定性理论的诞生。

- 哈罗德·史蒂芬·布莱克 Harold S. Black 在1927年发明了负反馈放大器的概念。他在1930年代成功开发了稳定的负反馈放大器。

- 哈里·奈奎斯特 Harry Nyquist 在1930年代为反馈系统开发了奈奎斯特稳定性判据。

- 理查德·贝尔曼 Richard Bellman 从1940年代开始开发动态编程[22]。

- 安德雷·柯尔莫哥洛夫Andrey Kolmogorov 于1941年共同开发了维纳-柯尔莫哥洛夫滤波器。

- 诺伯特·维纳 Norbert Wiener 共同开发了维纳-柯尔莫哥洛夫滤波器,并在1940年代创造了控制论一词。

- 约翰·拉加齐尼 John R. Ragazzini 在1950年代在控制理论中引进了数字控制和Z-变换(由Laplace发明)。

- 列夫·庞特里亚金 Lev Pontryagin 引进了最大原理和bang-bang原理。

- 皮埃尔-路易·利翁 Pierre-Louis Lions 将粘性解发展为随机控制和最优控制方法。

- 鲁道夫·卡尔曼 Rudolf Kalman 率先在系统和控制领域采用状态空间方法。他引进了可控性和可观察性的概念,开发了用于线性估计的卡尔曼滤波器。

- 阿里·奈飞 Ali H. Nayfeh 是非线性控制理论的主要贡献者之一,并出版了许多有关微扰方法的书。

- 简·卡米尔·威廉姆斯 Jan C. Willems 引入了耗散性概念,将李雅普诺夫方程推广到输入/状态/输出系统。构造类似李雅普诺夫函数的存储函数引发了控制理论中线性矩阵不等式(LMI)的研究。他开创了数学系统理论的行为方法。

另请参阅

- 控制系统的例子

- 控制理论主题

- 其他相关话题

参考资料

- ↑ GND. "Katalog der Deutschen Nationalbibliothek (Authority control)". portal.dnb.de. Retrieved 2020-04-26.

{{cite web}}: CS1 maint: url-status (link) - ↑ Bennett, Stuart (1992). A history of control engineering, 1930-1955. IET. p. 48.

- ↑ James Clerk Maxwell, J. C. (1868). "On Governors" (PDF). Proceedings of the Royal Society. 100.

- ↑ Minorsky, Nicolas Minorsky (1922). "Directional stability of automatically steered bodies". Journal of the American Society of Naval Engineers. 34 (2): 280–309. doi:10.1111/j.1559-3584.1922.tb04958.x.

{{cite journal}}: Invalid|ref=harv(help) - ↑ Maxwell, J.C. (1868). "On Governors". Proceedings of the Royal Society of London. 16: 270–283. doi:10.1098/rspl.1867.0055. JSTOR 112510.

- ↑ Routh, E.J.; Fuller, A.T. (1975). Stability of motion. Taylor & Francis.

- ↑ Routh, E.J. (1877). A Treatise on the Stability of a Given State of Motion, Particularly Steady Motion: Particularly Steady Motion. Macmillan and co.. https://archive.org/details/atreatiseonstab00routgoog.

- ↑ Hurwitz, A. (1964). "On The Conditions Under Which An Equation Has Only Roots With Negative Real Parts". Selected Papers on Mathematical Trends in Control Theory.

- ↑ Flugge-Lotz, Irmgard; Titus, Harold A. (October 1962). "Optimum and Quasi-Optimum Control of Third and Fourth-Order Systems" (PDF). Stanford University Technical Report (134): 8–12.

- ↑ Hallion, Richard P. (1980). Sicherman, Barbara; Green, Carol Hurd; Kantrov, Ilene et al.. eds. Notable American Women: The Modern Period: A Biographical Dictionary. Cambridge, Mass.: Belknap Press of Harvard University Press. pp. 241–242. ISBN 9781849722704. https://archive.org/details/notableamericanw00sich.

- ↑ "Feedback and control systems" - JJ Di Steffano, AR Stubberud, IJ Williams. Schaums outline series, McGraw-Hill 1967

- ↑ Mayr, Otto (1970). The Origins of Feedback Control. Clinton, MA USA: The Colonial Press, Inc..

- ↑ Mayr, Otto (1969). The Origins of Feedback Control. Clinton, MA USA: The Colonial Press, Inc..

- ↑ Ang, K.H.; Chong, G.C.Y.; Li, Y. (2005). "PID control system analysis, design, and technology". IEEE Transactions on Control Systems Technology. 13 (4): 559–576. doi:10.1109/TCST.2005.847331.

- ↑ trim point

- ↑ Donald M Wiberg. State space & linear systems. Schaum's outline series. McGraw Hill. ISBN 978-0-07-070096-3.

- ↑ Terrell, William (1999). "Some fundamental control theory I: Controllability, observability, and duality —AND— Some fundamental control Theory II: Feedback linearization of single input nonlinear systems". American Mathematical Monthly. 106 (9): 705–719 and 812–828. doi:10.2307/2589614.

- ↑ Gu Shi; et al. (2015). "Controllability of structural brain networks (Article Number 8414)". Nature Communications. 6 (6): 8414. arXiv:1406.5197. Bibcode:2015NatCo...6E8414G. doi:10.1038/ncomms9414. PMC 4600713. PMID 26423222. Lay summary.

Here we use tools from control and network theories to offer a mechanistic explanation for how the brain moves between cognitive states drawn from the network organization of white matter microstructure.

{{cite journal}}: Cite uses deprecated parameter|lay-url=(help) - ↑ Liu, Jie; Wilson Wang; Farid Golnaraghi; Eric Kubica (2010). "A novel fuzzy framework for nonlinear system control". Fuzzy Sets and Systems. 161 (21): 2746–2759. doi:10.1016/j.fss.2010.04.009.

- ↑ Melby, Paul; et., al. (2002). "Robustness of Adaptation in Controlled Self-Adjusting Chaotic Systems". Fluctuation and Noise Letters. 02 (4): L285–L292. doi:10.1142/S0219477502000919.

- ↑ N. A. Sinitsyn. S. Kundu, S. Backhaus (2013). "Safe Protocols for Generating Power Pulses with Heterogeneous Populations of Thermostatically Controlled Loads". Energy Conversion and Management. 67: 297–308. arXiv:1211.0248. doi:10.1016/j.enconman.2012.11.021.

- ↑ Richard Bellman (1964). "Control Theory" (PDF). Scientific American. Vol. 211, no. 3. pp. 186–200.

进一步阅读

- Levine, William S., ed. (1996). The Control Handbook. New York: CRC Press. ISBN 978-0-8493-8570-4.

- Karl J. Åström; Richard M. Murray (2008). Feedback Systems: An Introduction for Scientists and Engineers.. Princeton University Press. ISBN 978-0-691-13576-2. http://www.cds.caltech.edu/~murray/books/AM08/pdf/am08-complete_28Sep12.pdf.

- Christopher Kilian (2005). Modern Control Technology. Thompson Delmar Learning. ISBN 978-1-4018-5806-3.

- Vannevar Bush (1929). Operational Circuit Analysis. John Wiley and Sons, Inc..

- Robert F. Stengel (1994). Optimal Control and Estimation. Dover Publications. ISBN 978-0-486-68200-6.

- Franklin (2002). Feedback Control of Dynamic Systems (4 ed.). New Jersey: Prentice Hall. ISBN 978-0-13-032393-4.

- Joseph L. Hellerstein; Dawn M. Tilbury; Sujay Parekh (2004). Feedback Control of Computing Systems. John Wiley and Sons. ISBN 978-0-471-26637-2.

- Diederich Hinrichsen and Anthony J. Pritchard (2005). Mathematical Systems Theory I – Modelling, State Space Analysis, Stability and Robustness. Springer. ISBN 978-3-540-44125-0.

- Andrei, Neculai (2005). "Modern Control Theory – A historical Perspective" (PDF). Retrieved 2007-10-10.

{{cite journal}}: Cite journal requires|journal=(help) - Sontag, Eduardo (1998). Mathematical Control Theory: Deterministic Finite Dimensional Systems. Second Edition. Springer. ISBN 978-0-387-98489-6. http://www.sontaglab.org/FTPDIR/sontag_mathematical_control_theory_springer98.pdf.

- Goodwin, Graham (2001). Control System Design. Prentice Hall. ISBN 978-0-13-958653-8.

- Christophe Basso (2012). Designing Control Loops for Linear and Switching Power Supplies: A Tutorial Guide.. Artech House. ISBN 978-1608075577. http://cbasso.pagesperso-orange.fr/Spice.htm.

- Boris J. Lurie; Paul J. Enright (2019). Classical Feedback Control with Nonlinear Multi-loop Systems (3 ed.). CRC Press. ISBN 978-1-1385-4114-6.

其他链接

- Control Tutorials for Matlab, a set of worked-through control examples solved by several different methods.

- Control Tuning and Best Practices

- Advanced control structures, free on-line simulators explaining the control theory

- The Dark Side of Loop Control Theory, a professional seminar taught at APEC in 2012 (Orlando, FL).

编者推荐

优秀教学视频

现代控制理论

《现代控制理论》课程是电气工程、自动化、信息技术等相关学科的专业基础课程。本课程的核心内容为状态空间法和最优控制。本课程主要学习现代控制理论的建模、分析和综合的方法。

自动控制理论

本课程是电气工程及自动化专业一门重要的技术基础课,涵盖了古典控制的主要内容。围绕控制系统稳定性、动态特性和稳态特性,从时域和频域的角度讲授控制系统分析和综合的基本原理和方法。主要内容包括:反馈的基本概念、控制系统的数学模型、控制系统的时域分析方法、根轨迹法、频率特性法等。

集智相关课程

赵博:强化学习与最优控制系统

动态规划和最优化控制可以解决大型的多阶段决策问题,在计算资源有限的情况下,如何获得获得近似解,并且要求找到的近似解达到一定的性能需求。这类方法通常被统称为强化学习,有时也会被叫做近似动态规划或神经动态规划。从最优控制的角度解读强化学习,探索其中的内在联系。

本中文词条由打豆豆翻译编辑,欢迎在讨论页面留言。

本词条内容源自wikipedia及公开资料,遵守 CC3.0协议。