倾向得分匹配

在观察数据的统计分析中,倾向性评分匹配 Propensity Score Matching (PSM)是一种用于估计治疗、政策或其他干预的效果统计匹配技术,方法是将协变量对样本“是否接受处理”的影响考虑在内。PSM试图减少由于混杂变量造成的偏倚。这些偏倚一般会在那些只对处理单元和对照单元的结果做简单对比的评估中出现。保罗·罗森鲍姆 Paul R. Rosenbaum和唐纳德·鲁宾 Donald Rubin在1983年介绍了这项技术。[1]

出现偏倚的原因可能是某个因素通过决定样本是否接受处理而导致了处理组和对照组的效果(如平均处理效果)差异,而不是处理本身导致了差异。在随机实验中,随机化选择样本可以做到对处理效果的无偏估计,根据大数定律,随机化分配机制意味着每个协变量将在处理组和对照组中呈现类似的分布。不幸的是,对于观察性研究来说,研究对象通常不是随机接受处理的。匹配就是要减少对象非随机接受处理产生的偏倚,并模拟随机试验,方法是从处理组和对照组中分别取样,让两组样本的全部协变量都比较接近。

例如,人们想知道吸烟的后果。但是随机分配让患者“吸烟”是不道德的,所以需要做一个观察性研究。简单地通过对比评估吸烟者和不吸烟者来估计平均处理效果将产生偏差,它会受到能影响吸烟行为的因素的影响(例如:性别及年龄)。PSM要做的是通过让处理组和对照组的控制变量尽量相似来达到控制这些偏差的目的。

综述

PSM适用于非实验环境中因果推断和简单选择偏差的情况,其中: (i)对照组与处理组中的类似单元很少; (ii)选择与处理单元类似的对照单元集合很困难,因为必须对一组高维的协变量特征进行比较。

在常规的匹配机制中,对一组能够区分处理组和对照组的特征做匹配,以使两组的特征更加相似。但如果这两个组的特征没有显著的重叠,那么可能会引入实质性的错误。例如,拿对照组最糟的病例和处理组最好的病例进行比较,结果可能倾向于回归均值,这会让对照组看起来比实际情况更好或更糟。

PSM利用观察数据预测样本落入不同分组(例如,处理组与控制组)的概率,通常用Logistic回归方法,然后利用此概率创造一个反事实的群体。倾向性评分可用于匹配,也可作为协变量,可以单独使用,也可以与其他匹配变量或协变量一同使用。

一般步骤

1. 做Logistic回归:

- 因变量:参与处理(属于处理组),则Z = 1;未参与处理(属于对照组),则Z = 0。

- 选择合适的混杂因素(既影响处理方式又影响处理结果的变量)

- 计算倾向性评分的估计量:预测概率(p)或log[p/(1 − p)]。

2. 依照倾向性评分的估计量进行分层,检查协变量的倾向性评分的估计量在每层处理组和对照组是否均衡

- 使用标准化差异指标或者图形来检验分布情况

3. 根据倾向性评分的估计量,将每个处理组个体与一个或多个对照组个体进行匹配,使用以下方法之一:

4. 对比处理组和对照组的匹配样本或加权样本,验证协变量是否均衡

5. 基于新样本的多变量分析

- 如果每个参与者都匹配了多个非参与者,则适当应用非独立匹配样本分析

注意:当一个处理样本有多个匹配时,则必须用加权最小二乘法,而不能用普通最小二乘法。

形式定义

基本设置

基本场景[1]是,有两种处理方式(分别记为1和0),N个独立同分布个体。每个个体i如果接受了处理则响应为[math]\displaystyle{ r_{1i} }[/math],接受控制则响应为[math]\displaystyle{ r_{0i} }[/math]。被估计量是平均处理效应:[math]\displaystyle{ E[r_1]-E[r_0] }[/math]。变量[math]\displaystyle{ Z_i }[/math]指示个体i接受处理(Z = 1)还是接受控制(Z = 0)。让[math]\displaystyle{ X_i }[/math]代表第i个个体处理前观测值(或者协变量)的向量。对[math]\displaystyle{ X_i }[/math]的测量发生于处理前,但是[math]\displaystyle{ X_i }[/math]中也可以不包括那些决定是否接受处理的特征。个体编号(即:i = 1, ..., i = N)不包含任何[math]\displaystyle{ X_i }[/math]所包含信息之外的的信息。以下部分在讨论某些个体的随机行为的时候将省略索引i。

强可忽略处理分配

设某个物体有协变量X(即:条件非混杂变量)向量,以及对应着控制和处理两种情况的潜在结果r0和r1。如果潜在结果在给定背景变量X的条件下独立于处理举动(Z),则可以说样本是否接受处理分配是强可忽略的。可简洁表述为

- [math]\displaystyle{ r_0, r_1 \perp \!\!\!\! \perp Z \mid X }[/math]

这里[math]\displaystyle{ \perp \!\!\!\! \perp }[/math]代表统计独立.[1]

平衡得分

平衡得分b(X)是观测协变量X的函数。在给定b(X)时,处理单元和控制单元的X有相同的条件分布:

- [math]\displaystyle{ Z \perp \!\!\!\! \perp X \mid b(X). }[/math]

最一般的平衡得分函数是[math]\displaystyle{ b(X) = X }[/math].

倾向性评分

倾向性评分是根据协变量观测值计算得出的一个单元(例如:个人,教室,学校)被指配接受特定处理的概率。倾向性评分匹配将使得处理组和对照组的协变量分布趋同,从而减少选择偏差。

假设有一个二值处理标识Z,一个响应变量r,以及被观测的背景协变量X。倾向性评分定义为,在给定背景变量条件下单元接受处理的条件概率:

- [math]\displaystyle{ e(x) \ \stackrel{\mathrm{def}}{=}\ \Pr(Z=1 \mid X=x). }[/math]

在因果推断和调查方法的范围内,通过Logistic回归、随机森林或其他方法,利用一组协变量估计倾向性评分。然后这些倾向性评分即可作为用于逆概率加权方法的权重估计量。

主要定理

以下是Rosenbaum和Rubin于1983年首次提出并证明的:[1]

- 倾向性评分[math]\displaystyle{ e(x) }[/math]是平衡得分。

- 任何比倾向性评分更“精细”的得分都是平衡得分(即:对于函数f,[math]\displaystyle{ e(X)=f(b(X)) }[/math])。倾向性评分是最粗粒度的平衡得分函数,因为它把一个(可能是)多维的对象(Xi)转换成只有一维(尽管其他维度显然也存在),而[math]\displaystyle{ b(X)=X }[/math]则是最细粒度的平衡得分函数(保留全部维度)。

- 如果对于给定的X,处理分配满足强可忽略条件,则:

- 给定任何的平衡函数,具体来说,给定倾向性评分,处理分配也是强可忽略的:

- [math]\displaystyle{ (r_0, r_1) \perp \!\!\!\! \perp Z \mid e(X). }[/math]

回归

- 对于有相同平衡得分值的处理样本和对照样本,它们响应变量均值之差(即:[math]\displaystyle{ \bar{r}_1-\bar{r}_0 }[/math]),可以作为平均处理效应的无偏估计量:[math]\displaystyle{ E[r_1]-E[r_0] }[/math]。

- 利用平衡得分的样本估计可产生在X上均衡的样本

与充分性的关系

如果我们把Z的值想成影响X分布的群体参数,则平衡得分充当了Z的充分统计量。进一步,上述定理指出,如果把Z视为X的参数,则倾向性评分就是最小充分统计量。最后,给定X,如果Z是强可忽略的,则倾向性评分是[math]\displaystyle{ (r_0, r_1) }[/math]联合分布的最小充分统计量。

混杂变量的图检测方法

朱迪亚·珀尔 Judea Pearl已经表明存在一个简单的图检测方法,称为后门准则,它可以检测到混杂变量的存在。为了估计处理效果,背景变量X必须阻断图中的所有后门路径。通过把混杂变量加入回归的控制变量,或者在混杂变量上进行匹配可以实现后门路径的阻断。[2]

缺点

PSM已经被证明会加剧模型的“不平衡性、低效率、模型依赖性和偏差”,这与大多数其他匹配方法不同。匹配方法背后的直观仍然成立,但应该与其他匹配方法一起应用;倾向得分在加权和双重稳健估计方面也有其他有益的用途。

与其他匹配过程一样,PSM也是从观测数据中估计平均处理效应。在引入PSM之时,它的主要优点是,通过使用协变量的线性组合得到一个单一评分,以大量的协变量为基础平衡了处理组和对照组,却不大量损失观测数据。如果在有众多协变量的情况下,对每一个协变量都分别做处理单元和对照单元平衡的话,就需要大量的观测数据来克服”维数问题“,即每引入一个新的平衡协变量都会在几何上增加最小所需的观测样本数量。

PSM的一个缺点是它只能涵盖已观测的(和可观测的)协变量,而无法涵盖潜在变量。那些能影响处理分配却不可观测的因素无法被纳入匹配过程的考量范围。由于匹配过程只控制可观测变量,那些隐藏的偏差在匹配后依然可能存在。另一个问题是PSM还要求在大量样本中,在处理组和对照组之间有大量的重叠。

Judea Pearl也提出了关于匹配方法的普遍担忧,他认为对可观测变量进行匹配可能会让那些原本处于休眠状态的混杂因素被释放,从而实际上可能加剧隐藏的偏差。同样,Pearl认为,只有通过对处理、结果、可观测和不可观测的协变量之间的定性因果关系进行建模,才能确保(渐进地)减少偏差。当试验者无法控制对独立变量和因变量之间观察到的关系的替代性、非因果性解释时,混杂就会发生。这样的控制应该满足Pearl的“后门准则”。它也很容易地手动实现。

参考文献

- ↑ 1.0 1.1 1.2 1.3 Rosenbaum, Paul R.; Rubin, Donald B. (1983). "The Central Role of the Propensity Score in Observational Studies for Causal Effects". Biometrika. 70 (1): 41–55. doi:10.1093/biomet/70.1.41.

- ↑ Pearl, J. (2000). Causality: Models, Reasoning, and Inference. New York: Cambridge University Press. ISBN 978-0-521-77362-1. https://archive.org/details/causalitymodelsr0000pear.

编者推荐

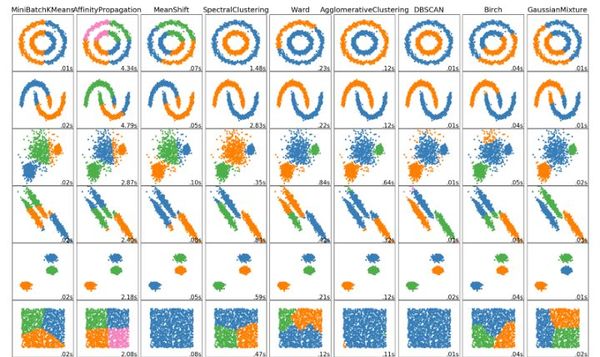

数据科学家需要了解的5种聚类算法

聚类是一种涉及数据点分组的机器学习技术。《数据科学家需要了解的5种聚类算法》介绍了k-means聚类、Mean-Shift聚类、具有噪声的基于密度的聚类方法(DBSCAN)、EM聚类和层次聚类5种常见实用聚类算法及其原理,并且对比了其优缺点。

k-means 聚类算法原理及优化(贪心学院)

《k-means 聚类算法原理及优化》从以传统的k-means算法为基础,介绍了k-means的优化变体方法,包括初始化优化k-means++, 距离计算优化elkan k-means算法和大数据情况下的优化Mini Batch k-means算法。

无监督学习|聚类算法综述

《无监督学习|聚类算法综述》介绍了多种无监督学习的聚类算法的原理、相关概念及实现代码,包括邻近算法、GMM算法、BIRCH算法等。

相关课程

基于Julia的KMeans并行化

本课程首先讲解了k-means聚类算法的相关思想,然后对使用Julia并行化实现k-means算法的方法进行了详细的介绍。

本中文词条由Xushuxu、计算士参与编译,薄荷编辑,欢迎在讨论页面留言。

本词条内容源自wikipedia及公开资料,遵守 CC3.0协议。