计算社会科学:发现与预测

《Computational Social Science: Discovery and Prediction》部分章节翻译

The application of big data in surveys to the study of elections, public opinion, and representation

Introduction

翻译by yogy

直到现在,政治学家依赖于局限于大小和范围的少量学术研究。他们小样本使得他们不适合检查各亚裔民意变化,比如西班牙裔和亚洲美裔。这些调查过去也是不适合检查地方性的公共舆论的。最近,有一种革命性的方法,使得学术研究者可以接触大量公共舆论数据并且是在他们能力范围内可调研的数据。

在过去的数十年中,由于在过去75年中收集的大量可使用的的商业投票结果,可利用的民意调查数量已经大量增长。除此之外,在合作的调查研究的进展已经戏剧性的扩大了独立学术研究中的样本数量(亚瑟拉伯和瑞文,2013)。在此同时,一个显著的统计学进展已经提高了学术研究者在从全部可使用的调研数据矩阵中实现实质性的推理的能力。研究人员已经研发了新的机遇模型权重去弥补从更早时间段获得的不相关的调查数据(如,贝瑞斯凯,2006;贝瑞斯凯等,2011)。不仅如此,他们已经发展了新的机器去预估所有小地域区域和统计群组(吉尔曼和李特里,1997;帕克,吉尔曼和巴福米,2004)。这些方法的成绩已经确保了学术研究者在丰富的地域变化上可以预估大量群众的意识形态和民众意见,如州,国会选区,国家立法区,和甚至大的城市和乡镇。不仅如此,学术研究者已经使用的新的方法,利用历史调研数据检查民意随着时间的变化(斯提森,1991;凯歌海和华斯哈弗,2015;伊恩萨和科赫,2013)。

在民意调研的评估方式上的进展,确保了研究人员去开展在政治表现和责任在当地(洛桑维斯和华沙夫,2014),州(拉斯和飞利浦,2009a;帕池克,2013),和联邦层(俺斯拉贝黑尔和徼恩,2010;巴福米会让黑瑞恩,2010;克林顿,2006;黑尔,2014) 细微性研究。研究人员发现在不同地域层次的公共舆论对应着不同政策长处。研究人员也检验过,无论特殊政策制度,如直接民主或者无党派选举,提高了公共舆论和显著政治结果的关系(卡利斯-吴荣,科莱克,凯莉,2014;拉克丝和飞利浦,2011)。这项工作最终提供了在制度改革如何可能提高民主政府新的角度。除此之外,研究人员已经发展了创新型的方法将民意调研数据和预测选拔结果联合在一起(林泽,2013;洛克和捷尔曼,2010)在表现上的未来工作将继续检验越来越多样性民意调研和政治结果关系。这也将研究数据和来自政治文本信息组合起来(戈瑞门和思特华特,2013),如同竞选贡献(伯尼克,2014)和投票人(安瑟拉赫尔和黑斯,2012)。

Big data in public opinion

翻译by yogy

可能调研的大部分基础功能是总结民意调研和确保调查人员随着时间或者空间检查变化,如同跨过地域性和统计学的亚种。然而,传统的学术研究,如美国国家竞选调查,只是局限于这些目的使用。这些调研给研究人员对大范围丰富的主题的民众意见的掠影。但是他们只是每两年或者每四年进行一次,这使得他们对检验长期确实很有用,但对研究更细粒度的公众舆论不适合。他们的小样本也使得他们对检验跨地域和统计学亚种的公众舆论不利(安瑟拉赫尔和瑞文,2013)。

在过去的数十年中,研究人员可用的研究数据的数量已经得到了惊人的增长。这个过程的大部分主要发展是由于若普公共舆论研究中心的投入。若普中心已经收集了来自数百家调研公司超过20000的民意反馈,来自这些调研的数据是个人可用的。例如,若普中心有来自超过2500的盖洛普民意调研,调研来自如纽约时代,CBS新闻,ABC新闻,今日美国,洛杉矶时代等其他商业民意测试机构也一样。

这些商业民意调查机构有巨大的研究潜能。这些研究的是时间覆盖率回溯到大萧条时间,他们包括来自回答者对数千个不同政治问题的意见,这能保障调研这检验对该问题的态度随着时间的变化。此外,他们包括大量关于不同层次选举的问题。最终,他们包括大量公众的党派偏见的改变这类有用的信息(恩尼斯和科赫,2013;威尔斯金,2014)。

当然,这些商业调查并不是非常适合一些调研问题。例如,他们很少包含媒体使用的问题,这就限制了交流学者对他们的利用。他们也只有对民众对国会成员的意见的有限制的问题和在亚国家层次的推选出的在职领导人。为了解决诸如此类的问题,学者们已经发展了几个新颖的大规模的调查在过去的15年中。在2000,和有一次在2004和2008,在宾利法尼亚大学安娜堡交流学院的研究人员调查了超过50000人在选举期间对总统选举他们的意见,就像一些其他问题一样。例如,学术人员利用他们利用国家安嫩伯格选举调查大量样本去估计亚国家层次的民众意见(例如卡瑞思和哈登,2010;陶撒诺威驰和华沙夫,2013).然而,尽管全国安纳伯格选举调查比之前学术调查的方法有很大的优势,但是也有很多限制。最重要的是,它首先关注的是总统选举并且只有少部分调研问题是关于国会或者州选举。

在最近几年,在调研中涌现出新的创新方法。最显著的例子是合作国会选举研究。合作国会选举研究的构想于2005提出,作为一个能过产生大量样本并产生大量小样本的研究集团(安瑟拉赫尔和黑斯,2013)。在它最初的七年,合作国会选举研究已经产生超过150对立的团队调查,和一个超过200000聚集调研的主文件对回答者的投票行为、党派验证、问题喜好的普通问题的回答。

尽管国家安嫩伯格选举调查全国和合作国会选举研究对很多目的都很适合,他们深入该领域太迟而不能在竞选之前预测竞选结果。因此,对于很多商业选举调查(林泽,2013;洛克和捷尔曼,2010)。最近更多的是,研究者已经寻求利用便利样本区预测选举结果,例如,王等人(2015)利用来自成千上百的Xbox游戏端的反馈预测2012年总统预选的结果。这些便利严格不能经常比传统调研更快更方便使用的有的,他们也非常适合实验性研究(如,贝瑞斯凯,胡贝尔和兰泽,2012)。然而,为了调整响应偏差使其达到最好效果,这个建模是很有挑战性的。

Survey and sampling design

翻译by yogy

现在存在许多取样和设计问题等待研究者们一起解决,学术界经常想从不同问题中获得一个特定情况的共同面板数据,然而,对问题的描述在不同的调查中可能有轻微的不同。这经常给决定是否这个对相似问题的描述接近到能证明能池化这个响应增添了难度。此外,研究者还需要对不同物体的不同响应分类保持警觉,比如说,LIKERT响应分类一般与叉状类或其他非LIKERT响应分类不具有可比性(BISHOP,1978)。为了缓和这些问题,研究者应该仅仅用相似描述和相似响应分类来归结问题。

有一个更难的问题,不同的调查采用种种不同的采样方法,在很早的调查研究中,民意调查人很少有企图去收集人口中具有代表性的样本。在1930年中,GEORGE GALLUP和其他同行介绍了一个称为定额取样的技术。在基于定额的样本中,调擦研究者从一部分不均分的人口中寻找并调查已经决定的人的比例。虽然这个方法产生的更好的结果,但是也产生了这样一个问题:采访者对各个分割的人群的选择考虑的非常周到。不幸的是,被选取的人趋向于更受教育,也更富有。很多年后,这个响应的偏差导致学术界避开了基于定额的调查。然而在最近几年,研究者开发了基于模型的权衡技术来缓和选择偏差。一个由ROPERCENTER主持的研究团队目前在开发对于定额取样方法的权衡,即将问世。

在1950年代,许多调查转变到地区可能性,或者叫簇取样。通过这种方法,研究者取样了一系列地区的集合,比如城市或者人口普查区。然后,他们随机创建各个采访的社区中人的集合。这个方法极大的由高花费面对面的采访来驱动。当适当的权衡后,这些调查很好的在国家层面上适应了公共意见。然而,地区可能性取样不是地方性级别的必然表达。为了解决这个问题,学术界可以使用基于模型的权衡或者聚集有时间跨度的地区可能性调查来确定存在取样中多种多样的地区集合。

在1960年代和1970年代,商业调查公司使用随机数字拨号的方式将采访的方式从面对面采访转变为电话采访。这个新方式产生的样本更能表达出不同地理尺度下的人口。然而,电话调查的显著问题就是无人响应。针对这个,研究者分析时应该应用设计或者模型权衡来对电话取样做排序。

RDD调查的低响应率和渴望获得更大样本容量在最近几年中将调查研究者引导向寻找其他取样途径的路途上。重要的是,研究者通过互联网开发了一系列革命性的调查设计,比如之前谈论的CCES。CCES使用 了基于模型的取样设计,其中的成员选择性的加入,并匹配到一个人造的人口框架。这种匹配的取样通常需要对未来的权衡,原因在于此取样选择是不完美的。当然,不能保证这种方法得到的样本能有效表达人口。然而,CCES在近期的选举中表现出准确的预测。一般的说,ANSOLABEHERE和SCHAFFNER发现这个细细执行的网络选择性面板产生的估计与电话调查有相同的精确度。

Small area estimation

翻译by Camille

在很多情况下,研究者希望根据他们的意愿采用较大的调查矩阵来理解地方水平的公众意见。最直接估计这一水平的居民态度的方法是简单随机样本中的数据,样本采集方式是询问被调查者在自身层面上的偏好。Lax和Phillips(2009b)将这一方法称为“分解”。分解的最大好处是研究者能够利用被调查者的调查回复和居住地点来估计公众意见(例如,Erikson,Wright和Mclver,1993和Brace等,2002)因此,对于应用研究者来说,这种方式能够非常直接估算每个地理单元的公众意见。但是,在小地理单元下使用简单分解,较少的被调查者不能产生精确的估算。在每个州的大部分研究仅有极少的被调查者。甚至是一些在特定的国会选区或城市,较大的学术研究通常仅仅有几十个被调查者。

此外,据我们所知,大部分研究要求应用设计权重或者以模型为基础的权重来确保选择出来的被调查者具有代表性。不幸的是,预设定好的权重极少能够确保在地区水平具有代表性。

Gelman、Little(1997)以及Park、Gelman和Bafumi(2004)推荐了一个替代方法,这一方法是利用一个多层次回归(multilevel regression)和后验估计.MRP表征的思路是根据人口预测指数和地理预测指数模拟被调查者意见等级,这些预测指数是根据部分聚集在不同地理位置的被调查者获得。

在每一个地理-人口单元内意见的平滑估计(在德克萨斯受教育的西班牙女性)被赋予权重来匹配单元内人口比例以及每个地区平均意见的收益估计。这些权重通常建立在使用根据后验估算人口目标。但是他们有时候包括跟家复杂的权重设计(Ghitza 和Gelman,2013;Gaughey 和Warshaw,2015)。许多研究团队已经表明以MRP为依据来估计公众观点通常比以来国家调查分解得来的估计值更加准确。此外,MRP模型对地方水平的公众意见预测与实际来自仅有几千人的调查样本中得来的意见联系度非常高(Park,Gelman和Bafumi,2004;Lax和Phillip,2009b;Warshaw和Podden,2012)此外,Wang等(2015)表明MRP模型与方便抽样连用可能会有效。

研究者能够在R或State中构建简单MRP模型。为了使用更高级的模型,他们期望使用完全Bayesian 软件,例如Jags或Stan(参见Gelman和Hill,2006)。这些完全Bayesian软件包同样允许在后验估计公众意见时的不确定性被模拟得更加准确。

作为一个了解MRP模型在实际中的运用的例子,我估算了在人口总量高于50,000人的城市中支持同性恋婚姻的人数比例。在这个研究案例中,每个人对于同性恋婚姻的观点被用一个函数来估算,这个函数的自变量包括他(她)的人口统计特征,城市,洲(对于i个体,有如下指标r,g,e,c以及s分别代表种族,性别,教育类别,城市和洲)。这个信息被包含在一下等级模型中,该模型会给出响应:

城市影响被用一个洲际函数来了解哪个城市指数下降,城市平均收入以及城市中退伍军人比例以及城市中同性恋伴侣的比例。反过来,一个洲的影响被用一个地区的函数进行模拟,来反映各洲的工会成员比例,洲福音派教徒或摩门教徒比例。第二阶段是事后分层。在这一阶段,我用了多层次回归来对每个人口-地理亚型对公众的观点做出预测。最后,这些预测被加合来估计每个城市中支持同性婚姻的人数比例。

图1.1表明城市中支持同性婚姻的公众意见超过250,000人。公众意见对于同性婚姻有一个非常大的变化明尼阿波利斯市,旧金山,华盛顿和西雅图是国家中对同性婚姻最自由的4个城市。孟菲斯,俄荷拉河马,杰克威尔逊是3个最保守的城市。

在研究重申中的最重要的问题是地区层面的政策结果是否能够对公众意见予以回复。图1.2中表明自治州对同性雇员发放补助金的权力和对同性婚姻的公众意见两者之间具有强相关性。那些较强烈支持同性婚姻的城市更有可能对同性恋雇员提供有力保护。这表明城市政府对城市居民的同性恋权力予以回复。(同样参见Palus,2010;Tausanovitch和Warshaw,2014)

最近这些年,使用MRP模型来研究政治表现和可计量性问题非常热门。学者们开始分析导致MRP模型表现变化的影响因子。(Warshaw和Rodden,2012;Buttice和Highton,2013;Lax和Phillips,2013)。这个工作对于很多使用MRP模型的研究者在其实际的工作中给予了很多初步指导。首先MRP模型的效率估计价格与模型假设是相关的,这个在很多的小型调查模型中的精确度较高。例如,一个有1500个被调查者的研究案例在怀俄明洲可能没有任何的回答者。这意味着在怀俄明州的估计意见可能完全由这个模型驱动(例如回答者在人口相似的洲)而不是被在怀俄明州的回答者。这个案例表明虽然MPR模型能够使推论与相对小规模的比例进行,研究者应该对用较少或者无回复者的地理单元做出的回复特别小心。MRP模型和更大规模的可用调查数据设置的结合能够使调查者对于像怀俄明州以及更小地理单元(城镇,学校,邻里和城市政府)做出更加精确的推断。

第二,研究者应该通常单独使用案例在MRP模型,在这一模型中调查的回复者通常是他们地理-人口的随机样本,这个状态不能够被方便样本或者区域概率样本(例如ANES或者GSS)满足。然而,很多学者现在构建具有更加复杂权重的模型,这些模型能用来分析在地区层面上不具有方便代表性(Wang等,2015)和区域概率样本(Stollwerk,2012)。

学者应该通常在多层次模型中每个地理层次使用至少一个预测因子(Lax和Phillips,2013)研究者应该揭示他们为什么认为地理协变量对于被估计的观点有强代表权(Buttice和Highton,2013)。通常来说,在多层次模型中的强预测因子将会对公众意见有更好的估计(Warshaw和Rodden,2012)。然而,研究者应该对内生性(endogeneity concerns?)更加关注.例如,研究应该通常避免在MRP模型(部分被设计成预测其他选举结果)中包含选举结果(例如协变量)。他们同样应该在模型中避免使用公众意见数据(这些模型通常被本质结果估计)(例如政策结果或唱票表决),假定公众意见会影响。

另一个经验是,当实质性目标是在洲层次预测公众意见时,研究通常不需要用一个在预测因子之间具有大量互动关系的一阶模型(Lax和Phillips,2013)。然而,当目标是去模拟在洲或者其他地理单元内小规模人口组时,更多的复杂一阶模型可能会很有用处。例如,Ghita和Gelman(2013)利用一套复杂相互关系建立一个具有细微差别的模型,这些复杂的相互关系使他们能够模拟在每一洲中不同收入与和种族分组中的投票行为。

另外一个问题是研究者需要决定如何在他们研究中的暂时性动力。例如,研究者能够选择去假定公众观点不随时间改变,这一假设能够使他们连续多年收集数据(Erikson,Wright和McIver,1993;Lax和Phillip,2009a).另一种是他们能够假设公众观点随时间强烈变化并分年估计。在这两种极端情况下,研究者能够在研究中部分消除暂时动力。(Pacheco,2011;Caughey和Warshaw,2015)不论他们做出哪种选择,理论上研究者应该证明在他们的分析中哪些数据是被收集到一起的。

研究者应该同样注意在公众意见估计中有来自调查数据的不确定性。在大量分析中将这一种不确定度考虑在内是非常重要的。(Lax和Phillps,2013;Kastellec等)当估计的公众意见呗用来作为回归模型中的预测因子时,以上做法就是特别重要的。(参见Gelman和Hill,2006,542)。

最后,研究者应该估计他们的MRP估计值得质量。理想情况下,他么应该进行收敛和结构验证(Adcock和Collier,2001)为了来评估一个模型的收敛有效性,这对分案例有效性(Lax和phillips,2009b;Buttice 和Highton,2013;但是Wang和Gelman,2014)或者案例外的有效性非常有用.一种来进行外样品有效性是在有洲级选票的特定情况下比较MRP估计公众意见。这对于通过比较理论上的相关概念来评估模型构建的有效性同样有用。例如,研究者应该比较基于MRP对公众意见对于同性婚姻的意见与对禁止(或允许)同性结婚的投票倡议。如果模型估计值是有效的,他们应该与初始结果和其他理论相关的概念紧密相关。

在小区域的下一阶段的工作很可能关注提高研究者在社区尺度下的小 表现,例如西班牙在德克萨斯的投票者和在爱荷华州没有接受高中教育的人(Ghitza和Gelman,2013)。为了做这些,他可能会依靠更加丰富的辅助地理信息资源(Selb和Munzert,2011)。下一阶段的工作将会可能关注提高学者模拟公众意见在地方层次的变化(例如,Pacheco,2011;Caughey和Warshaw,2015)。例如,未来的工作可能验证洲层次的公众意见对于同性恋者的权力或者气候年化在过去几十年中是如何变化的。

Measuring ideology and other latent varaiables

翻译by Taaccoo

5.意识形态和其他潜在变量的测量 尽管在许多用途中,公众的意见在个体问题中非常有用,研究者还是经常更加在意去评估那些无法被直接测量的潜伏构造。例如,研究者们可能希望去测量受访者(Bafumi and Herron,2010;Tausanovitch and Warshaw,2013)和立法者们(Clinton,Jackman,and Rivers,2004)的政治见解19,然而,选举预测可能希望去测量公众们的偏好来得出基于调查的反响的结果。为了去评估这些潜伏构造,学者们已经开发出来了一系列测量模型20。

近几年最常用的几类测量模型来自于条目反响理论理论(item response theory IRT). Clinton,Jackman 和 Rivers 把传统的双参数IRT模型引入到政治科学中,这个模型的特征是每一个反响yji ∈ {0,1},作为主体i的潜在能力参数(θ i),困难参数(αj),条目j的歧视参数(βj)和任期误差参数(eij),公式如下:

Pr[yij == 1] = Φ(βjθ i - αj)

其中Φ是指标准正太CDF值

βj指得是“歧视参数” 因为它捕捉了一个程度(degree),一个潜在会影响得到一个肯定回答的概率的程度。如果βj是0 ,那么问题 j 将不会告诉我们任何被测量的潜在变量的信息。我们将期待 βj非常接近于 0 如果我们问一个完全不相关的问题,例如受访者最喜欢的颜色。“切点”的值是αj/βj ,在这一点得到肯定和否定的回答的概率各占50%。学者们可以运行一个比较简单的IRT模型使用现成的软件,例如在R语言的pscl包中的Simon Jackman的广义函数。对于更加复杂的IRT模型中,他们可以使用全贝叶斯软件例如Jags 或者 Stan。

像其他降维模型,例如相加规模(additive scales)或者因素分析,IRT模型受益于测量误差的减少,主要原因是使用了单一架构的多重指标法(Ansolabehere,Rodden,and Snyder,2008)。然而,IRT模型也提供了一些方法学优势比起一些备选方法。尤其是,他们可以被一个适合于树状数据的详细空间利用模型激活(Clinton,Jackman,and Rivers,2004,356)。贝叶斯IRT模型也允许不确定性的简单特征存在预任何参数估计中(Jackman,2000)。当多条目事件(例如点名投票或者问卷调查)被用来测量潜在的构造和这些条目在处于不同地区规模(Tausanovitch and Warshaw,2011)的个体之间被很好的辨别时,研究者们通常应该忍受IRT模型带来的更小的误差。在政治偏好的例子中,这可能意味着这个问题和左右意识形态更加相关,而且对受访者来说非常容易理解,或者仅仅更加接近政治分歧而不是更多的特殊的问题。

更加常见的是,想要部署IRT模型的研究者们面临的一种重大的挑战是如果他们使用不相邻的人们的数据集去评估,而且这些人的对答案的选择也不相邻,那么直接比较潜伏构造是几乎不可能的。为了克服这一问题,研究者们需要使用公因素或公共条目将受访者们从不同的调查中“桥接”到相同的潜在空间(看,例子,Bafumi and Herron,2010;Bailey,2007)21。如果忽略使用的这个精确桥接方式,一个重要的IRT模型假设就是一些条目参数集合是在不同群体中的常数(Lewis and Tausanovitch,2013)。例如,某个已给的条目集合(例如,调查的问题)的切点应该在不同群体中在截面和时间上都很相似。尽管这个假设可能看起来是良性的,但是在不同的时间点或者不同的群体中这个问题的环境可能不同。例如,随着时间的改变某个特殊条目的状态可能已经改变。在未来,学者们应该试图去明确,对于在不同的群体中的桥接参数,条目参数是常数。学者们也应该进行一些实验,在他们的IRT模型中(Caughey and Warshaw,2015), 个体调查问题的条目参数应该随着时间去革新。

一个前沿的IRT模型是去评估是去评估立法者和其他政治精英作为一个普通的市民在相同的意识形态空间的潜在的政治偏向(Jessee,2009)。这个将使研究者能够直接的比较精英和投票者的政治偏向。例如,他们可以检查在他们的选民中立法者是否更加极端比起投票者(Bafumi and Herron,2010)。更加常见的是,学者们试图使用相同的问题以一种早前已经描述的得方式去一起测量精英和公众。然而,Lewis和Tausanovitch(2013)显示了常条目参数假设经常在这中情况下失效。他们表示这可能是因为立法者在所处的位置和公众意见投票在环境上根本就不一样。最近,这些发现表明研究者需要注意精英和受访者在环境中的差异。

另一个浮现出来的研究路线是将IRT和MRP模型进行整合来在地方级测量公众们潜在的政治见解。例如,Tausanovitch和Warshaw将IRT和MRP模型进行整合来估计过去几十年在不同州、立法街区和城市的政治偏好。他们的方法,仅仅只能被用于特定的情况下22。

一个更加普遍的方法来在一个地理单元级例如州或者国会地区来评估公众们平均的潜在的偏向是使用动态贝叶斯分级IRT模型,这个模型是在人口群体级别进行估计,而不是个体级别进行估计(Lewis,2001;McGann,2014)。这使得学者们可以使用调查来的数据,这些调查仅仅问一个或者两个关于潜在的兴趣构造问题,传统的IRT模型在个体级别是无法实现这个的。例如,Caughey和Warshaw(2015)发明了一个可以在每一年评估潜在群体意见的模型做为人口统计学和地理特征的函数,通过一个动态线性模型来随着时间去平滑了这个分层参数。来自于这个模型的群体级估计可以被所产生的地理单元评估所衡量。这个方法使得学者们可以通过地理空间和时间在一个统一的框架下去测量意识形态和其他潜变量。例如,这个方法在过去五十年里可以被用来在各个州估计大众的政治见解。事实上,图1.3 显示了在1965年到2010年,公众的政治见解已经在洲级发生了改变。这个表明了只有少数洲的政治见解随着时间的发展发生了实质性的转换。南部的洲例如密西西比洲和阿拉巴马州已经随着时间的发展变得更加保守,然而地处新英格兰的洲已经变得更加自由。

图1.3 各个州的平均自由主义政策,1965—2010。 这个估计已经被重定位和标准化在每一年来精确颜色对比度。

Applications

翻译by Taaccoo

6 应用

在这个部分,我回顾了最近的工作,结合大规模调查数据和最近的统计学技术的进步来处理在政治科学领域中更加重要的问题。

6.1 描述性分析

学者们研究早期公众舆论的变化的能力已经被过去半个世纪的成千上万的调查的有效性的增长慢慢的革新。例如,直到最近,学者们已经得到了很多在30年代的新政中的公众意见的信息。然而,Berinsky (2011)汇总了在1936年到1945年间所有实施的超过400份的公众民意调查。他们还开发出了一系列衡量方法来减缓在应用配额抽样过程中所引起的问题。他们检查了在这段时期公众意见在各种不同的政治问题的演变。例如,他们发现尽管大多数美国人表达了对工会的支持,然而在1937年到1941年期间支持度还是掉了10个百分点。Schickler和Caughey显示了在这段时期对工会支持度的降低尤其是在南部更加更加明显。

成千上万的历史调查数据的可用性让学者们能够检查出全体选民的长期的变化的党派组成。Wilkins(2014)汇总了在1950年到2011年中好几百个独立的受访者,这些受访者来自于超过600份盖洛普民意调查中,用来研究全体选民的意识形态和党派组成。他发现在80年代中存在保守派向共和党派的不对称的转换,这个导致了共和党派身份一个非常大的增长。Gillon,Ladder和Meredith(2013) 汇总了在1953年到2012年之间超过1800份的盖洛普民意调查来检查在党派偏见中的性别差异。他们表示现代的党派性别差异在70世纪晚期开始出现,并开始在90年代中期逐渐增加,此后开始平稳。如果没有数百万份追溯到20世纪中期的受访者调查数据的应用,这些研究就变得不可能。

其他最近的工作已经使用了最新的统计工具来描述早期并逐渐增长的调查数据,来以一个逐渐精确的方法检测地理和很多选民的态度。例如,Lax 和 Phillips(2009a) 在20世纪初期使用MRP 在洲级层次上来测量支持同性恋问题上面的公众的意见。Elmendorf 和Spencer使用了一个近似的方法检测了各个州之间种族印象的变化。他们发现在很多南方的洲的反黑人种族印象非常显著,这种现象在几个大平原和多山的洲也非常常见。

另一个研究的主线是检查是否地理和选民的意见随着时间进行改变。很多学者分已经发现很多个体问题的观点已经发生了改变。例如,Pacheco在洲级层次检查了最近几年在教育和福利、流产、死刑和总统批准这几个方面的观点改变。其他学者已经发现了在洲级层次,公众的政治意见的观点或者情绪已经发生了改变。 另一个令人兴奋的研究主线是在洲级层次建立动态的选举结果预测模型。最近,研究者们已经发型了一个创新的方法来将公众的意见数据进行整合来在洲级层次和国家层次预测总统的选举结果。下一代的预测模型将很可能被用来预测国会和州立法选举结果。

6.2 代表性 & 选举

代议制民主的基础是假设公民的偏好应该和选举的官方行为一致。有很多研究着眼在立法者的点名行为和在相应街区的公众意见存在着二值关系。这些研究发现立法者的点名职位和他们所在的行政区的意识形态偏好有很大的相关性。然而,并没有足够的证据表明候选者的位置汇集在中间投票者(Ansolabehere,Snyder,and Stewart,2001;Lee,Moretti,and Butler,2004)。反而,立法者们似乎比起投票者们在意识形态上更加极端。此外,美国明主党和共和党非常不同的代表了相同的选民。一个最近的研究发现,被相同行政区选择的明主党和共和党的立法者将不同意另一个超过1/3的法案(Fowler and Hall,forthcoming)。

如果立法者的职位没有集中在中间选民的手里,也许他们正在聚集在各个行政区其他选民的职位上,例如主要选民,捐助者或者积极分子。当然,这个问题不可能被检测出来,因为没有一个在亚国家层次评估公众意见的方法。结果,研究者们在理解立法者的站位和选民在他们的行政区的偏好做出了很大的努力。Clinton带着他的革命性研究拉开了现代在这个领域的研究序幕,在这项研究中,他将超过100,000份受访者的调查数据进行整合,这些调查数据来自于1999年到2000年的两个不同规模的调查集合。他发现相同党派选民的意识形态已经对第106个众议院成员的点名行为造成了不均匀的影响。与此相似,Bafumi 和 Herron 使用了一个新奇的调查方法在合作国会选举研究中,这个方法表明国会成员,参议员和代表比起他们作为洲人在第109和110次代表大会中更加能代表其党派。更加接近现代的一个关于选民在其代表上性上的影响的研究中,使用了MRP来对明主党和共和党在各个选取的偏好进行建模。Kastellec 发现参议员会更加深入的权衡他们的党派基础当在最高人民法院坚信礼中投放点名票的时候。的确,当他们的洲中间选民和党派中间选民不同意时,参议员会强烈的支持后者。Hill研究了党派选民的意识形态和一个更加广泛的点名投票的关系。和Kastellec的结果进行对比,他发现主要的和一般的选民偏好对国会投票有着大概相等的影响。 尽管研究者们会继续为研究在联邦层级的的代表性做出努力,但是在美国政治中的关于代表的前沿研究是去在洲级和局部地域级检查公众意见和政治结果之间的联系。知道最近,缺少足够的公众意见数据导致了在洲级和局部地方级对代表的研究工作受到了阻碍。就像Jessica Trounstine 在很多年前提出的那样,“为了探索如何更好或者在什么条件下,政策能够影响选民偏好,我们需要...新的关于不同选民偏好的知识在一个地方层级。 一些新的数据和统计方法的可用性,总而言之,已经革新了研究者们在亚国家层级研究代表性的能力。此外,研究者们已经对评估是否特殊的制度会增加公众意见和政治结果的联系做出了巨大的努力。例如,Lax和Phillips在20世纪出使用了MRP模型在洲级层次上来评估在一堆个体问题中的公众意见。之后,他们试图寻找是否公众政策结果在这些问题中具有反响而且和公众意见一致。大体来说,他们发现了公众意见和政策的强烈联系。他们也检查了是否制度会影响公众意见和洲级政策结果的联系。他们发现立法职业特征和任期限制改善了反响性,然而直接民主和选举法院并没有对代表性造成影响。

在另一个最近的研究中,Tausanovitch 和 Warshaw检查了在都市级别的代表性,通过将七个大规模的调查聚集起来和估计每一个受访者的潜在的政治意见在一个公共的场合。之后,他们使用MRP模型去评估在每一个城市超过20,000个人中的公众的平均的政治意愿。他们发现城市的政治结果会强烈的影响公众们的政治偏好。然而,没有一个政治制度,例如任职期限或者直接民主制,持续的增加影响力。Berkman 和 Plutzer 使用了一个近似的方法来检查在政区学校的代表。他们将很多年来综合社会调查(GSS)的数据整合起来并应用类似于MRP的方法来在每一个政区的学校花费评估公众意愿。他们发现学校花费直接影响到了公众意愿。此外,他们发现制度会影响到公众意愿和学校花费之间的关系。

几乎所有的在洲级和局部地方级研究代表性的一个限制是他们使用了一个典型的研究方法。使得检查政策的改变几乎变得不可能,这个有很大的理论限制和强烈的因果论问题由于临时的变化顺序无法被建立(Lowery,Gray,and Hager,1989;Ringquist and Garand,1999)。的确,大多数已经存在的研究无法排除反向因果关系。例如,很多自由政策会导致更加自由的公众意愿。下一代的研究在这个领域应该检查是否公众意愿的改变会影响政策结果的改变。这个将需要新一代的模型方法,这个方法应该可以使研究者去建立动态的评估模型来评估公众意愿随着时间的改变。

Conclusion

翻译by Taaccoo

7.总结

在最近几年,学者们获取大的公众意愿数据集的能力和在他们的处理中全部使用这个数据集的能力都得到了提高。这使得学者们可以在不同的地理级别对逐渐减小的的团体进行公众意愿的评估。此外,它还可以让研究者们去处理精细的问题例如代表性和美国政策的责任。

未来在这一个领域内的工作是去处理几个有联系的方法论挑战。第一,研究者们需要继续去发展更好的工具来整合有代表性的样本和便利的样本。第二,学者们需要克服限制了他们将精英偏好和公众偏好放在同一个空间的能力的挑战。这将能够使他们研究是否一些制度例如直接民主制或者任期限制会改善当选官员和公众之间的意识形态责任水平。第三,他们需要建立更好的模型来评估公众意愿在亚国家层级随着时间的变化。这将使他们能够检查是否公众意愿的改变会影响政策结果的改变。整合调查数据和其他类型的政治数据这一点还有很多工作需要去做。例如,代表学者可能能够通过将公众意愿数据和政治捐助和社会关系网的信息联系起来来改善他们对小区域选民的潜在偏好进行评估。

仍然需要注意的是将因果关系方法和大规模的观察到的调查数据整合到一起。的确,如果这些新的数据没有和强大的研究设计,那么单独的公众意见测量的精度是不足以处理关键理论问题的。例如,研究者可以结合调查数据和因果推理方法来检查是否责任的影响会随着小群体的党派和意识形态进行改变。他们也能够检查出是否各级政府的党派控制会影响到公众舆论。

学者们倾向于在小区域估计中去利用逐渐扩张的大规模的可用的民意数据,和一些新的技术,来检查代表性问题和洲和地方的责任。他们将可能集中在是否小人口群体中的意见会影响政治结果这一问题上。例如,他们可能会检查是否立法者更加欢迎有钱或者受过良好教育的选民。他们同样也检查了是否在小地区精英和捐助者的党派的两极分化的增加会导致国会的两极分化。最后,这个可能会在地方级水平上在即将到来的几年里成为一个新一代的选举预测模型。预测者可能会使用日益增加的调查样本用在他们的模型中去预测州长的、国会的和国家立法机构的选举结果。

Notes

翻译by Taaccoo

注解:

1. 例如,文学文摘组织了一个邮寄调查活动在1936年总统竞选期间,这个活动得到了超过200万的回复的巨大样本。尽管有了这个巨大的样本,这个杂志社还是不正确的预测了共和党派候选人Alf Landon以压倒性的优势超过Franklin Roosevelt取得胜利。问题在于这个杂志的民意调查受访者大部分都是车辆和电话的拥有者还有这个杂志自己的订阅者,这使得代表人数远远超出了伦敦核心选民的数量。

2. 例如,Berinsky(2006)报告了只有10%的人口在1940年最终的受到了大学教育,尽管在1940年中的盖洛普民意调查样本中显示有接近30%的人受到了大学教育。

3. 综合社会普查(GSS) 和 全国大选调查(ANES)继续使用这个方法的一个变种。

4. 例如,想象安阿伯市是一个用来选择访问密歇根的采访者的一个社区。这个社区中的家庭样本肯定不具有代表密歇根的总体人口的代表性。

5. 总而言之,研究者们应该能意识到,如果那里仍然存在响应的非随机概率甚至有条件的协方差在权值模型中,设计和基于模型的加权法的应用将未必会产生公众民意的无偏估计。

6. 例如,在2010年的合作国会选举研究中有大约50,000个受访者。这看起来是一个巨大的样本;然而只有很少的大概100多个受访者在给定的国会行政区而且在单独的国家立法区,城市和县的人数更少。

7.其他学者也已经开发除了一些新的相关的方法在小区域估计中(see ,e.g. , Selb and Munzert, 2011)。但是MRP模型仍然是最杰出的。

8. 看Caughey 和 Wang(2014)在一个关于并发的一个讨论中,当在早期构造基于后层权值模型的时候会出现并发。

9. Kastellec,Lax 和Phillips(2010)提出了一个有用的初级教程关于如何在R中建立MRP模型。另外,Warshaw 和 Rodden(2012)提出了在R中复制代码去建立一个关于在国会和州立法区的公众意见的MRP模型。

10. 我使用来自于2010年,2011年,2012年和2013年合作国会选举研究机构(CCES)中的数据,和在2010年到2013年展开的10个皮尤基金(Pew Foundation)调查数据。

11.基于MRP模型的和简单解聚的对同性婚姻的公众意见的估计的相关性是0.92 。另外,Tausanovitch和Warshaw(2014)在测量每一个城市的政策保守主义的公众中的相关性是0.64。最终,这些估计有很强的表面有效性。因此,有大量的原因去相信这些估计非常精确的的到了再同性婚姻中的公众的意见。

12.城市授权的同性恋雇员的数据来自于人权运动的市政平等指数(MEI),这个将为大约300多个城市的居住和生活在哪里的人们对LGBT的支持度进行打分。

13.注意更多的工作将会被实施去证明在公众意见和同性恋权利政策中存在一个因果联系,但是至少,在图1.2中的相关性证据表明了一个公众意见的强大作用。

14.为了在协变量多级模型和被建模的意见中找出一个更近的理论联系,一些先前的工作表明,学者们应该为他们特殊的真实应用去定制MRP模型。例如,一个在寻找地方级关于气候变化的公众意见的研究可能想要包括污染或者全球变暖的影响的协变量。

15.在未来,研究应该评估是否机器学习算法可以被用来预测MRP模型。(Caughey and Wang,2014;Elmendorf and Spencer,2014).

16.由于已给的数据限制,学者们经常会为他们的MRP模型选择将很多年的公众意见数据进行整合。这这种情况下,学者们应该显示,公众意见在整个事件框架中都相对稳定,而且并没有存在当政策改变导致公众意见的改变反向因果事件。

17.随着时间部分的平衡时空动态的好处是这个模型对代表性的模型假设的敏感度更低。例如,在前一段时间用常规MRP模型对乔治亚的公众意见评估将主要是在乔治亚的意见的作用上,而不是在人口相似的洲的意见上。

18. 不管这个估计来自于使用解聚、MRP或者是其他基于模型的方法,这都是对的。

19. 理想点是对个体的基于他们洲的政治偏好在调查、点名投票和司法裁决中的潜在的自由主义或者保守主义的衡量。

20.看Jackman(2008)更多的测量模型。

21.使用一个重叠的选择或者人的集合去桥接个体到一个公共的空间是一个普遍的做法。在某些情况下,也许有足够的常见调查问题在不同的调查中会在没有额外工作的情况下将潜在的调查构造整合在一起。在其他情况下,也行没有足够的调查项目去将受访者桥接到一起。在这种情况下,一个可能的解决方式是问一个于早些调查重合的一个原始调查问题。例如,Tausanovitch 和 Warshaw(2013) 使用他们在2010年合作国会选举调查的一个模块,将之前七个调查中的受访者联系到了一起。在这个模块中,他们用相同的措辞去问大约1300个人跟其他之前调查中受访者相同的问题。这项相同的问题使他们能够从之前相同规模的调查中将受访者的偏好分辨出来。

22. 首先,这个需要去询问每一个受调查的受访者大量问题。这意味着这将在早期当每个调查仅仅包括了一些政治问题的时候不能够被应用。第二,这需要大量的计算机资源去评估成百上千人潜在的意识形态。

Introduction

翻译by A-Xin

每一天,人们都会产生各种不同形式的大量数据(Lazer et al.,2009)。例如,通过标准的媒体来源比如报纸、新闻格式的推特和博客上的政治言论等产生的数字化文本为政治内容提供了大量的来源。在这一章中,我们分析了一个包含了13246个帖子的语料库,这些帖子是在2008年美国总统大选的时候为6个政治博客写的,但是这只是一个小例子。对美国联邦政府网(voxgov.com)上产生的每一篇文章进行统计,在2010至2014年间共计有超过八百万篇文档,其中包括来自议会成员的超过一百万篇的推特。这些数据使得研究所有层面的政治生活从公众意见(Hopkins and King,2010)到政治控制(King, Pan, and Roberts, 2013)再到政治表现都有了新的可能性。

政治数据新来源的爆发与新的数据分析工具的急速发展共同面临着应对分析“大数据”的挑战。(National Research Council, 2013; Grimmer and Stewart, 2013; Fan, Han, and Liu, 2014)。在文本分析领域一个重要的例子就是文档主题生成模型(LDA)(Blei, Ng, and Jordan, 2003; Blei, 2012),它是在文档中利用词共现模式来发现潜在主题的一种主题模型。主题模型可以帮助我们处理现实中大量的非结构化的文本数据集。在这一章中,我们主要关注LDA模型的一个特别的变体,结构化主题模型(STM)(Roberts et al., 2014),这个模型在联系我们已有的语料库结构(文档类原数据格式)和推测出的模型的主题结构之间提供了一个框架。

自动化文本分析技术已经在别处被完全的回顾过(Grimmer and Stewart, 2013)。我们更多的关注在很少被讨论到的主题模型和隐变量模型的特征上,即多模态。也就是说,在这里讨论的模型具有非凸的优化问题。因此,和主要方法比如线性回归不同,我们发现的模型的解对于初始值是敏感的(技术上来说,我们优化的函数有多种模式)。我们直接引出多模态的这一问题,帮助读者理解问什么它会出现以及应该怎样解决。我们提供了具体的方法来思考主题模型中的多模态,以及处理和产生它的工具。例如,我们使得研究者问出这样的问题:不同的模型解的结果到底有多少实质上的不同?在一个“主题”中,什么可以被启发性的看做是普通的共现词的集合出现在模型的很多解中?以及,我们在一个变量(比如党派归属)和主题的普遍用法之间的关键发现是否在模型的多个解中是稳定的?

我们也讨论了在一个多种模式的模型中选择初始值的初始策略。尽管很少被讨论到,但是这些初始策略随着数据集的增大和在模型一次运行中的计算成本的增加而变得越来越重要。选择一个更好的初始值后开始算法不仅仅会产生更好的结果而且会戏剧性的加快收敛。

这一章的提纲如下:在第2部分我们介绍多模态问题和提供一些带有多种模式的模型的例子;在第3部分我们关注主题模型的特殊案例以及强调一些在应用研究中会出现的实际问题;在第4部分我们介绍一系列的工具,它们可以让使用者通过评估模型多次运行后的结果的稳定性来探索主题模型中的多模态的重要性;第5和第6部分我们讨论了小心地初始化模型进而产生更好的解的步骤;最后在第7部分基于我们分析过的统计的工具,总结大数据带来的限制和机会。

Introduction to multimodality

翻译by A-Xin

当我们尝试优化的函数不是全局凹化的时候,会出现多模态问题。因此,当我们收敛一个解时,我们并不确定我们收敛到的点是全局最大值还是局部最大值。在统计模型中,一般情况下我们尝试最大化的方程是似然方程,当似然方程不收敛的时候说明我们得到的结果与初始值是独立的。这种情况发生在很多种统计模型中,但是在以下情况中是特别相关的:(1)在数据产生过程中,数据来源于一个混合的分布或者是包含似然方程后来会反映出的潜在变量(2)似然方程中出现起伏(本质上是平滑区)由于统计模型中存在约束。(3)一些参数无法确定导致同一个模型存在很多解。对于带有维度的参数空间,诊断和处理多模态的能力会下降,因此在高纬度和更加复杂的模型中,想象和评估似然方程会更加困难。

多模态在大数据文本中是非常普遍的,因为对分析大量的非结构化数据有用的相同的隐变量模型也可以用来应对优化问题。我们在这里使用的模型经常包含多种混合分布、复杂的约束,而且因为模型会包含成百甚至上千的参数所以难以写出似然方程。尽管从指数家族中产生的带有凹似然函数的模型比如回归或者lasso回归(Tibshirani, 1996)比较简单,但是它们在大数据的应用中仍然扮演着重要的角色(Mullainathan, 2014; Belloin, Chernozhukov, and Hansen, 2014),对于使用复杂的模型来发现潜在的模式和结构,人们也越来越感兴趣(National Research Council, 2013)。尽管隐变量模型能够给人们带来新的理解,但是它们也引发了带有多种模式的复杂的优化问题。

在这一部分中,我们会引导读者明白是什么导致了多模态。我们首先讨论一个凸的单变量的易优化的高斯最大似然方程模型,它与本部分后边将会讨论的非凸模型形成对比。然后,我们将单变量高斯模型扩展为一个简单混合的高斯模型并且对为什么混合模型会是多模态进行指导。最后,我们将简单混合高斯模型和主题模型联系起来,然后描述这些模型以及大数据中的一般模型是怎样包含隐变量的(在数据产生过程中无法被观察到的变量),也就是这些模型很有可能是多模态的。

2.1凸集模型

首先,我们先展示一个凸集模型例子,在这个例子中,不存在多模态的问题。在一个严格的凸集函数中,有且最多只有一个最大值,没有局部最大值。这对于优化问题来说是很方便的,因为当在优化过程中发现了一个凸集似然方程的最大值,很明显如果只存在一个的话就已经找到了全局最大值。在指数家族中,带有一个随机分量的回归模型的自然参数空间是凸集,因此很容易进行优化。(Efron et al., 1978)

我们从一个期望为 ,方差为 的高斯分布开始。下一部分我们将会介绍怎样将这个基本的设置推广到更加复杂的高斯混合模型。

正态分布来自于指数家族,因此似然方程是凸集,对数似然之后很容易看出来。

如果我们对对数似然方程二次求导,我们会得到 。因为 和 总是正的,因此二次求导总是负的,在只带有一个参数的方程中比如这一个,负的二次导数可以充分证明似然方程是凸的。因此,这个模型不是多模态。当在估计的时候,即使初始值不同也会返回相同参数的估计值。

2.2混合模型

现在考虑一个模型,它的随机成分是一系列高斯分布,而不是带有一个方差和标准差的高斯分布。想象一种情况,一个因变量可以从两个不同的正态分布中得到。在这个数据产生的过程中,观察所依赖的高斯分布以一个特定的概率被选择。然后,因变量的值由被选择的带有特定的期望和方差的高斯分布得到。

比如,当你在一定的人群中尝试建立人们身高的模型。然后,你只用观察这群人中的人们的身高,而不需要其他任何信息。你可能假定一个模型首先你以0.5的概率来确定这些人是男是女。根据他们的性别,你可能画出来一个身高服从一个“高”期望的分布(如果这些人性别是男的话)或者是一个“矮”期望的正态分布(如果这些人性别是女的话)。这是一个简单的混合模型,因为数据(即身高)会满足一个混合分布。

严格来说,这个模型的数据生成过程,一个简单的高斯模型,是下边这样的:

1.随机选择一个分布 ,概率为 ,并且 。

2.根据已经选择的分布,得到 ,这个模型的似然方程是

这个模型相比较之前部分描述的正态回归模型有更多的参数需要最大化,因为(1)每一个分布的概率需要被确定(2)每一个分布的均值和方差需要被确定。更进一步来说,这个模型被认为是隐变量模型因为隐分布变量 并没有被观察到,但是却作为中间步骤在数据生成过程中出现了。因为每一个数据点服从的分布是不确定的(数据并没有告诉我们哪些数据点是女人哪些是男人),所以我们不能使用熟悉的回归方法来解决这个问题。实际上,最大似然方称估计一般采用探索式的方法,比如期望最大化算法(Dempster, Laird, and Rubin, 1977),该算法是在估计隐变量 (我们案例中未知的性别)和分布的参数(每一个性别期望的身高和方差)之间不断替换。

很容易可以看出来估计一个分布的参数会依赖于它包含的数据点,对隐变量的估计会依赖于分布的参数。因为我们需要一个来很轻松的估计出另外一个,所以我们选择一个初始值来初始化我们的估计对象。不幸的是,当优化模式被局部最大值阻碍的时候,不同的初始值会导致不同的结果。尽管在多模态中存在这样的问题,但是相比较传统的回归模型,混合模型在数据产生过程中通常会有更精确的描述,特别是对于有很复杂的隐含的数据产生过程的数据。

2.3文档主题生成模型(LDA模型)

随后在这一章的核心部分中,我们将会提出一些解决基于文本数据的模型中多模态问题的方法。为了可以进行这项讨论,我们现在先介绍文档主题生成模型(LDA模型)(Blei, Ng, and Jordan, 2003),其中最受欢迎的是文本统计模型。我们用从之前描述的简单混合模型中的得到的灵感来解释为什么LDA及相似的模型是多模态的。

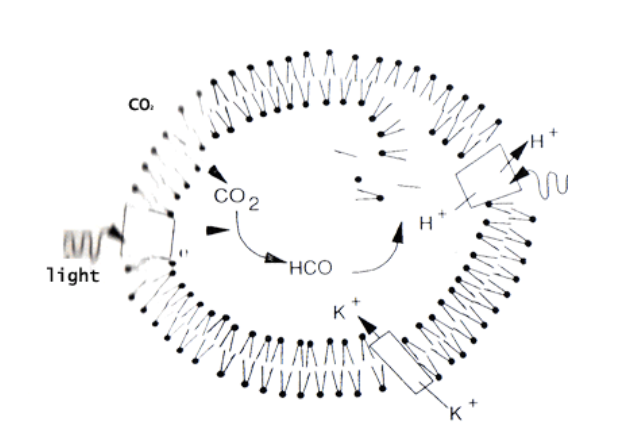

LDA是一个多成分主题模型,也就是说假定每一篇文档都是多主题的。主题在数学上描述为一个语料库中所有的单词的概率向量。比如,以“夏天”为主题,“太阳”、“假期”和“夏天”这些词就有很高的概率出现,“冷”和“下雪”这样的词出现的概率就很低。在每一个主题向量中,语料库中的每一个单词的都有一个概率,因此有一个向量长度V。主题由语料库中概率最大的单词表示,主题矩阵包含k(由数据决定的主题个数)行长度为V的主题向量。

在每一篇文档中,数据生成过程首先决定了文档N中的单词个数,然后它刻画出了在每一个主题包含多少文档(大于K个主题),在a向量中给定K个主题中的每一个主题一个概率,然后给一个主题中的文档中的每一个单词一个概率a,最后得到每一个满足b分布的主题下的文档中的每一个单词。

严格来说,LDA模型中每一篇文档的生成过程如下:

1、首先,文档的长度有由泊松分布决定。

2、然后,确定每一个主题下文档的比例。

3、最后,对于每一个单词:

为每一个单词选择一个主题:

单词从主题矩阵b中选择,选择的主题有zn决定

读者应该已经注意到LDA比先前部分中描述的高斯混合模型更为复杂,首先,我们得到在每一个主题中决定文档比例的分布以及给每一个单词分配的主题。然后,对每一个单词给出这样的主题后,我们得到在文档中观察到的单词。尽管过程更为复杂,但是它和先前部分中我们首先得到一个隐变量(男人和女人的身高分布)然后得到数据(身高)这个过程相似。

与高斯混合模型相似,LDA模型的优化是很困难的,因为隐变量必须在最终数据生成之前得到。在LDA模型中,这些参数包括每一个主题( )中的文档的比例以及由主题决定的每一个单 词都是不确定的。和混合模型的例子相似,我们可以使用一个EM算法的变体,叫做变分EM法。在预期的步骤中,我们首先对每一篇文档中的 和 做一个最好的猜想,我们假定 和 优化现有的参数,在期望和最大步中间不断迭代直至最后收敛。

最大化边际似然方程(给定a和b的数据的概率)的方法可以被用来作为目标方程最大化模型。为了得到边际似然方程,我们首先找到参数和数据联合分布:

为了找到被隐参数边缘化了的单词的概率,我们整合 和 。

边际似然本身在LDA模型中是难以处理的,因为 和 导致了一个棘手的整合问题。变分EM法使用Jensen不等式创造了一个似然方程中的下界,使得可以通过协调递增进行最大化。也就是说,这个算法是在更新主题的内容和文档的主题组成之间交替进行。这种交替最大化策略导致了多种局部最优。如果我们可以同时优化 和 ,我们就可以在本地模式中花费更少的精力,但是边际似然方程中的一对变量使得这成为不可能。

The case of topic models

翻译by A-Xin

多模态在很多统计模型中出现。在本章剩下的内容中,我们将会关注非监督的隐变量模型。在实际中,我们用隐变量模型来发现可以解释高维数据的低纬隐结构。这些模型已经被广泛的应用到社会科学中来分析文本数据(Grimmer and Stewart, 2013),发现疾病类别(Dishi-Velez, Ge, and Kohane, 2014; Ruiz et al., 2014), 研究人类认知(Tenenbaum et al., 2011),发展政治事件中的本体论(O’Connor, Stewart and Smith, 2013),建立推荐系统(Lim and The, 2007)以及揭示生物和社会网络的结构(Airoldi tet al., 2009; Hoff, Raftery, and Handcock,2002)等。正如我们提到的,隐变量模型的灵活性经常会导致困难的统计推理问题,其标准方法总是会受到多模态求解的困扰。

统计主题模型在政治学(Grimmer, 2010a; Quinn et al.,2010; Lauderdale and Clark 2014; Robert et al., 2014)以及其他领域中发展迅速,表现突出()。在这里我们主要关注文档主题生成模型(LDA),正如前边讨论的,文档主题生成模型通过将每一篇文档看做多个主题的混合来建模()。这种多成员混合的模型比单个体混合模型具有更加灵活的表现形式,但是在优化问题中将会有多个局部最优值。

LDA模型的后部不能在闭型中计算,两个受欢迎的近似推理算法分别是吉布斯取样()和变量推理()。在这一部分中,这两种方法都可以被看做是交替求最大值的形式。在吉布斯取样中,我们根据一个变量随机得到另一个变量,在变量推理中,我们根据近似分布中其他变量的平均值来更新一个单独的变量()。这种条件下交替更新的方法在无法进行后部整合时是很必要的,可以导致对初始参数的敏感。计算机科学家对于大量的解是由于不同的初始值这种情况是知道的,但是不经常讨论。

实际上,在引入理论计算机课上上的拓扑学之后,LDA推理问题的难度将会更加精确。非确定性多项式(NP-hard问题)被认为在多项式时间上是不能被解决的。一个更加完整的定义超过了本章的范围,但是这一类别让人感觉到这个问题的困难。在只带有两个主题的LDA模型中,最大似然估计可以被看做NP-hard问题()。这些困难结果不仅表明了为什么局部优化是LDA模型的一个特征,也表明了为什么它们不能通过推理算法中的变化来解决。也就是说,我们可以从这些结果中合理推理,不使用条件假设使问题更加合理,但是对LDA模型发展一个计算上使用的、全局优化推理算法是不可能的。

然后我们怎样处理主题模型中的多模态问题呢?在这一部分,我们提出在一个更广的标准集上选择一个解而不是仅仅根据目标方程的值。在下一部分我们提出在评估本地模式时在目标方程之外寻找解。然后我们将会讨论选择一个单一模式分析时的一些特定的方法。最后我们考虑怎样评估在很多不同的运行中选出的结果的稳定性。我们将会始终以LDA模型作为例子,但是讨论的内容可以有更多的应用。另外,在后边的部分我们将会看到在使用相关的STM时怎样应用它们。

3.1评估本地模式

我们评估主题模型和使用主题模型的方法之间没有联系()。模型的似然方程和常用评价标准可以预测看不见的单词,但是我们的关注点不在与预测一篇文档中的单词,而是想要一个模型可以提供语义上的联系,实际上我们对文档的总结很感兴趣()。这种没有联系的情况不容易修正,而我们的模型和评估标准关注预测,因为预测可以最合理的接近人类对效用的评价并且最后会对每个个体逐个确定()。这种视角提供了一种解决多模态问题的方法,解释了为何选择一个特定的运行方式而不是选择仅仅使目标方程得到最高值的模型,同时也包含了对模型质量的其它外在评估。

如果我们对于成功唯一的标准是最大化目标方程的能力,我们的道路将会是很清晰的。我们只需要简单的对于可选的解通过设置不同的初始值重复运行模型然后选择一个最大值。在变量估计中,这个标准在单一值中被简洁的定义为:边际似然方程的下界。我们可以简单的计算每个模型的下界然后挑选出最大值。

一般来说,这个步骤直观而且很好的被理论支持。不仅是作为我们优化的目标方程的下界,而且作为边际证据(?)的下界,它在贝叶斯选择模型中也经常被用到()。这些方法会选出最好的模型,给出数据生成的假设,但是这可能不是最有意思的()。为了评估模型,我们需要依靠我们在数据生成过程中的假设,在最终选择时我们不需要维持这些约束。这让我们在评估模型质量时有了很多的工具。

这个论断的应用是如果我们找到了全局最优我们可能不会选择使用它。这一开始看起来是违反直觉的,但是这个言论的多种组成内容在统计中是有很长的传统的。考虑到我们应该基于交叉验证或者其他的预测组成方式来选择模型(),这是主题模型最常用的评估标准,而且在政治学中有很长的传统()。选择一个将预测指标最大化的模型表明我们可能不是选择的对样本内进行目标方程最大化的模型。在预测是基本目标的环境中,预测保留样本的能力是黄金准则,然而在主题模型中,预测不是唯一的相关标准。

这个论断中隐含的是说目标方程不需要直接与人类的判断相关。人们评估主题的内在联系时,用模型参数最大化来预测似然方程实际上会导致在评估人们解释能力上的轻微的减少()。对专业评估的控制和对参考概念的校对一致的表明了单独选择目标方程对于在人类选择上产生相同的模型不是必要的。

不是说目标方程是完全没用的,我们毕竟选择了优化它。其实更不如说是在我们声称在局部最优解中,满足统计的模型在人类分析判断问题中对于模型质量的判断很差。由于优化问题的特点,我们发现了很多可选的模型而且我们已经在使用它们,只是基于目标方程来评估它们将会是浪费的。

对于这种情况的一种反应是提高模型的客观性,知道它与人类对于质量的判断相匹配。不幸的是,这在理论上是不可能的()。而且,推理问题已经非常的复杂,更不用说在更加棘手的模型中对结果进行修正()。

最后,我们相信目标方程是足以优化的当它适合模型的时候,但是让它成为挑选模型的方法是不够的。然而,当我们想要探索模型和它的应用时,目标方程可以作为一种方法在后部预测检验的问题中()。在下一部分中,我们提出怎样为分析挑选一个合适的模型的问题,答案是相关模型。在3.3部分,我们解释在多模态模型中怎样评估结果的稳定性。

3.2找到相关模型

选择一个单独的相关模型来分析是很有挑战性的。对分析者来说理想的选择标准是模型的功效,这是一种内在主观的和面向应用的评估()。在基于对于分析者来说时间怎样强化标准以及理想的理论上怎样接近近似值之间两者之间的选择标准上有一个内在的均衡。在这一部分,我们总结了从高质量到高自动化的方法的方法

手动评估

最完全和时间密集的方法是手动评估和修正模型。对每一个主题阅读一些文档案例以及仔细检查主题-单词分布来确定主题的这些需求是为了得到一个很好定义的概念。根据主题的数量和文档的长度,这可能是一个令人怯步的任务。

我们可能想要在文档自身内容之外考虑信息。在社会学中,我们经常对文档原数据有丰富的额外信息,如果模型是可用的,得到主题和文档作者或者数据之间的关系影射对于理解模型来说是很重要的。当文档中存在的象征是有用的,我们可以评估模型对于推测的主题的符合程度有多好()。理想情况下我们希望模型可以传递出我们已经知道的东西,允许我们证实它,同时也可以给我们提供一些新奇的理解。不同类型的证实标准在评价模型和内容分析的书里已经被很好的发展。

这一类手动评估是为特定的分析师设计的基本的常用的方法,并且他们需要花费分析师大量的时间。他们在证实最终模型上是很重要和必要的,但是对于评估每一个参与的模型代价比较高。

半自动分析

一个更少的劳动密集型的方法就是自动模型总结的人类分析。这个想法是为了发展一些可以快速评估一个模型的通用工具,甚至在做一些决定时需要人类参与。对于主题模型,我们可以通过看一些最有可能的或者有特色的单词总结出一个主题。这些单词列表的获取可以通过对文档的阅读高度联系到一个特定的主题。在LDA模型中这些总结的类型会从模型的参数中自然的出现,并且很多隐变量模型中会有一些近似的对应量。

最近的信息可视化工作已经在自动生成主题模型上有了很大的发展()。相似的方法已经被用来提供给关注研究单词应用中协变量效果的浏览者。其中最好的方法使得信息可视化的咒语“先看,放大和过滤,需求的细节”得以实现,这些咒语也表明了系统的目标是可以无缝的从高程度的模式移动到文档阅读经验。一些系统甚至可以将用户反馈合并到允许一个交互式的主题模型经验。主题模型的可视化是研究中很活跃的领域,可以很好的提升分析者与模型的相互作用。

全自动方法

最快的评估标准是全自动的。最自然的标准是目标方程是似然方程的约束或者是近似。在计算机科学作品中默认标准保留似然,即提供一种判断模型对于看不见的文档的预测性如何的方法。评估一个模型预测新数据的好坏程度是在简易程度上的吸引力,但是一个预测模型不需要是语义上最能理解的。

自动标准在缩小候选模型的选择上也是有用的,候选模型然后可以通过使用劳动密集型方法来评估()。我们考虑了两种总结方法:语义粘性,即在相同的文档中具有获得一个主题的高概率单词的趋势;排他性,即确定这些高概率单词在一个主题中是否是特别的。我们使用这些方法作为一个粗糙的过滤使我们的注意力在有希望的候选模型的子集中。

选择一个平衡

这不仅对选择一个模型的策略进行了一个粗糙的回顾。必要的是,模型的选择是由手头具体的问题确定的。一旦模型被选择,总会有一些客观的方法来确定主题的标签,也就间接的包含了这样的证明即模型表示(单词的分布)对于标签表示的概念表示来说是一种很好的代理。无论模型是如何被选择的,仔细确认主题很好的适合理论概念才是关键。

3.3评估稳定性

一旦我们致力于一个特定的模型并且放出可以发表的发现,我们会想知道这些发现在不同的初始值(比如,优化算法的初始值)下的稳定性。这产生了两种不同的假设:首先,我们感觉到我们发现的正在分析的特别的本地模式是多么的不可能,第二,我们了解到这个发现对于其他参数的管理是多么的敏感。

第一个假设最直接的。我们想要为我们的读者建立自信,并且对我们自己来说,我们完全靠运气偶然发现这个结果。LDA模型在单独运行中的不稳定已经因为被批评因为被跨领域的应用型用户扰乱()。理解主题怎样在运行中被映射到结果上可以对结果建立信心。

我们同样可以使用稳定性来评估我们的发现对于主题的配置是怎样敏感的。如果一个研究者将主题评定为“经济”,是否有一些那个主题的其它版本看起来大体上相似但是却产生了相反的结果?当一个特定主题或者主题群是关于利息的时候这些情况会出现,但是模型对于剩余者是分配的这种情况是敏感的。仔细检查主题可能可以确定它是关于“经济”的,但是它却不能揭露看似在主题之内实际在主题之外的相似的内容。通过大量的模型的集合检验“经济”的主题提供了由数据支持的主题一种不同表述方式的感受。

Similarity between topic across modes

翻译by 如是说

众模式topic之间的相似性

在本节中,我们将引入一套工具来评估对不同local modes兴趣发现的稳定性。我们从一个简单的例子——用STM分析一个收纳各类政治博客的文集——讲起。然后,我们将介绍几种评估不同topic之间相似性的指标。接下来,我们将展示如何把这些指标聚合到topic水平、model水平或者跨协变量这几个方面。

我们在文中介绍的方法主要有两个目的:首先,我们把几类解决local modes的方案直观地展现出来。尤其是对于那些十分熟悉全局凸集model的读者,当你使用或读到有关隐变量的model就会不由自主地产生一种预感。model本身会有助于我们的分析诊断。同时,我们也需要通过这些例子来告诉大家,稳定性的检测是如何有助于你发现数据和model中的价值。

2.4.1政治博客 Political Blogs

为了更具体的讨论,我们去看一个数据集:美国政治博客在2008年美国总统大选期间的发表的共计13,246篇博客文集(Esenstein and Xing,2010)。这些博客document来自这6名博主--American Thinker, Digby, Hot Air, Michelle Malkin, Think Progress和Talking Points Memo。我们对每一篇博文都有一个判断:是民主党倾向还是共和党倾向。我们记录了每个博客发布博文的日期。去掉停用词和document中出现频率少于1\% 的word后,还剩下包含2,653词的词汇表。

我们运用STM(Robert et al.,2014)去分析这些文本。STM是一个基于LDA风格的混合topicmodel。它可以包含文档层面的协变量,在本例中的document等级(自由还是保守)和时间(发表日期)。我们使用了R中的stm package,基于一种快速变分EM算法。我们把流行话题定义为一个与政党倾向有关且是关于时间的平滑函数。我们评估了这个model685次,通过快速运行LDA来实现初始化(见第5节)。在这组运行中有很多是不变的,包括预处理时的选择(e.g.,去除停用词,截词处理)和model参数(e.g.,STM的通用表达式,topic数量),这些会导致model拟合时出现差异。

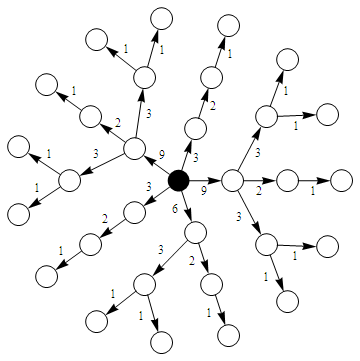

我们定义一些量供下一节使用。记K=100表示被使用者挑选出的topic的数量,V=2,653表示词汇的总数,D=13,246表示document的数量。混合topicmodel,包括LDA和STM,可以被两个参数矩阵描述出来。$\beta$ 是一个按行归一化的K*V的矩阵,用来topic-word的分布。$\beta_{k,v}$表示在第k个topic中观察到第v个word的概率。$\theta$ 是一个按行归一化的D*K的矩阵,用来表示document-topic的分布。$\theta_{d,k}$表示在来自topick的documentd出现的word比率。LDA与STM都可以被一个按行归一化的D*V的经验word统计矩阵 W,$W \approx \theta \beta$。我们使用$\theta$和$\beta$ 比较model。

为了简化求解,我们把样本变动边界的最大值作为我们的参考model。在实际中,我们通常不把样本最大值作为挑选的原则(原因在前一节提到过),但这让我们能快速地比对结果。

model中被评估的数百个topic广泛地覆盖了2008年大选的政治的各个方面。我们挑选其中的5个topic作为例子来说明不同性质的稳定性。 Figure 2.1 展示了这些作为例子的topic中,每个topic对应的前20个最有可能出现的word:Supreme Court rulings, Vice President Cheney, global warming research, nuclear weapons issues in Iran and North Korea, and the controbersy surrounding Barack Obama's former pastor, Jeremiah Wright.\\

2.4.2 比较topic Comparing Topics

我们首先要问这样一个问题:是不是model在不同初设下的运行结果不会有任何改变。如果每一次运行的结果都与先前在数值上相等,那么对多峰性(不同初设)的讨论是没有意义的。为了回答这个问题,我么你需要用一种方式去指标是否两个topic在不同的运行是可以进行实际比较的。

我们可以通过比较topic-word的分布$\beta$或者document-topic的分布$\theta$来比较两个model的相似性。我们可以通过$\beta$来比较两个topic,如果两个topic生成的可观测到的word是相似的话,这意味着它们可以被认为是相似的。同样的,我们也可以用$\theta$来评估两个topic,如果它们的整个语料库有相同的模式,那它们也是相似的。精光两种方式都是有效果的,在实际中使用$\beta$会比$\theta$更快速,会相较有跟少的噪声测量。这是因为document的数量比词汇的unique word的数量增长地要快。在开始生成相似性矩阵之前,我们需要在运行中对topic做些校准。

校准(Alignment)

考虑一个简单的例子,我们的model运行了两次。我们首先需要去确定每次运行中哪两个topic是需要比较的。Topic的数量在每次运行中是任意的,就其本身而言这是不成问题的,但这意味着我们需要去做一些额外的事情去 比较不同运行各自的topic。我们把决定哪一个topic去比较的过程称为校准的过程("process of alignment")。校准本身是由一些对 topic-word分布相似性的指标决定的。这里我们用的是$\beta$的各行的内积。

一旦给定了对相似性的指标方法,这里有至少两种合理的方法校准topic顺序,如果topic是根据topic数量来排序的话,每种方法都会得到相同的结果。首先,我们可以 令每次运行中的每个topic选择它最倾向的方式出现在第二次运行中,甚至有可能会有一个topic会出想许多次。我们把这种过程成为"local alignment",因为每一个topic 在相关的model中都 会在根据其他所有的topic来做自己的选择(“local choice”)。第二种方法是为了需啊在则一个一一匹配使得所有 topic pair的相似性之和最大。我们把这个称为“global alignment”,因为每一个topic的匹配是根据其他topic的选择。 尽管我们构造的解决方案是一个组合优化问题,但我们可以使用匈牙利算法(Kuhn,1995)有效地解决它。我们在求解中使用global alignment。local alignment 的结果本质上会得到相关的解。

Topic之间的相似性(Pairwise Similarity)

一旦我们有了选定的校准方式,我们就可以根据每次model运行中来计算两个topic的距离指标 。一对 距离个常用的(intuitive,直觉的)指标是$L_1$范数,定义为 $L_1=\sum\limits_{v}|\beta_{k,v}^{ref}-\beta_{k,v}^{cand}|$

并且取值范围为:$[0,2]$。我们讨论替代指标,但是我们使用$L_1$因为这个结果是很容易去抽象化的。我们将在4.5节中讨论替代的距离指标的意义。

我们不需要把我们定义的指标放在参数空间上讨论,而只需要去比较相关的topic和它配对的topic各自前10个最可能word中的共同word的数量。结果的取值范围在${0,...,10}$,代表了被匹配的word的数量。

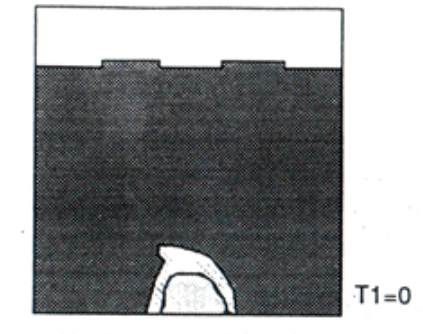

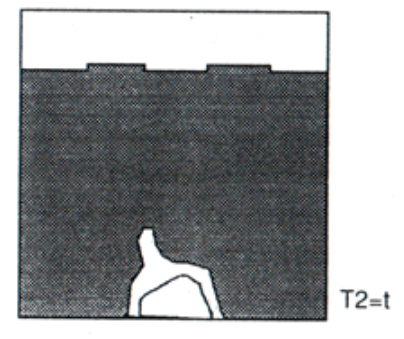

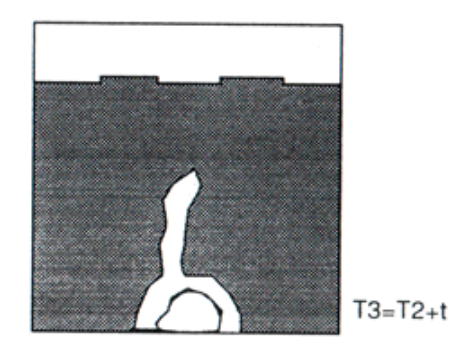

我们可以为document建立比较的指标。通过对使用某个topic的document排序,我们可以统计与一个topic相关度前10的document出现相同的个数。此指标的取值范围为${0,...,10}$,10代表二者完全相同。 Figure 2.2画出了这三个指标对调整后的topic两两的关系。每一对指标从理论角度来看都应该是强相关的。并且,基于document的方法要比基于word的方法在某种程度上噪声更多。 这幅图也为我们提供了不同解决方案的内在相似性。Topic的排序从完全地校准到几乎不一致。这意味着在不同local modes有着本质的语义不同,会导致解释时的显著性差异。\\

2.4.3聚类 (Aggregations)

Figure 2.2显示的每对指标的相似性对研究topic对的上下文语义十分有用;当然,提高这些指标的可解释性会助于在 model层面或topic层面的聚类。在model层面的聚类告诉我们,根据每个topic的平均水平,local mode到底有多接近相关的model。对topic层面的聚类告诉我们,在相关model模拟时,一个给定的topic的稳定性。 Model层面的聚类(Model-Level Aggregations) 我们首先对model层面聚类。这里,我们有一个对完整model的原始求和指标:一个对固定边界的似然的近似 在Figure 2.3中,我们画出了三个相似性指标(Y轴)随着近似边界(X轴)的变化图。异常点(前两幅图中右上方角和第三幅图的右下方)是供参考的model,仅仅与自身匹配。图中的虚线标除了一个自然的参考点(左边两幅图中是10个word或document中的5个,在第三幅图是$L_1$度量的中间值)。实线反映了简单的线性趋势。

下界和另外三个相似性指标之间的趋势反映了目标函数可以用来对相似性做大致的度量。有了每种方式对参考model的约束边界,这三种指标对相似性的度量的平均效果都得到了提升。然而,这只是粗糙的度量,因为相对于趋势的大小,差异还很大。在与候选model相似的model中(被目标函数度量),这一趋势下的高方差显示被发现的topic存在语义的多样性。

Topic层面聚类(Topic-Level Aggregations)

对topic层面聚类为我们提供了一种在参考model下度量一个topic在不同运行中的稳定性。这有助于确定,当研究者发现的有意思topic,它会应用在哪里,并且也能帮助理解在model的多次运行中它产生的频率。

Figure 2.4画出了topic的分布,它展示了每一个topic在不同model的运行中的统计出的均值。途中的5个作为例子的topic都被虚线和标签标明。每一幅图都画出了相应指标的变化范围的分布,可以看到,有一些topic在所有的运行中都是非常稳定的,也有一些指标相较参考model是独立的。

这些topic可以有助于解释之前提到的方差出现的原因。气候变化是在3个度量中最稳定的topic。这反映了这些博客文章的特别之处。在政治语义中,像气候一类的词是非常专门的一类流行topic,这些独特的词会导致更少且不同的局部最优解。

最不稳定topic之一的是Cheney topic。在参考model中,这个topic最初是关于副总统Cheney的,在其他model中包括Bush的执政期。举一个简单的例子,我们选择一个local model,在$L_1$度量中离参考model最远。在表 2.1中,我们通过比较topic在特定topic在18项的概率来比较topic的两个版本。这些项是在2个model中出现概率大于0.01的word的集合。我们可以看到,尽管每个topic都在谈论Cheney,Local model谈论Bush总统时用的是Bush, Bush's, George,而这在参考模型中该topic的版本出现的概论是极低的。

Topic层面的稳定性分析聚焦在一个topic的语义内容。作为一个分析者,我们的责任是每一个topic选择一个标签,可以清晰向读者反映一个topic的内容。我们强调,一个不稳定的topic是不合格的且没有实质意义的。基于这个问题,一个混合了CHeney和Bush执政期的topic远比一个仅仅有副总统的topic要有意义得多。当然,topic中的不稳定性也警示我们,当Bush执政期在另一个独立topic中的时候,参考model中的topic对于Cheney也是特别的。

2.4.4 协相关的稳定性(Covariate Effect Stability)

在STM的应用中,我们经常对在驱动topic流行中的协变量扮演的角色十分 感兴趣。而这是STM框架的核心优势:它包含了在评估过程中的协变量信息,在结果的model中会促进对协变量影响的估计。在Poliblog的语料库中,我们可以测试党派偏见在topic上扮演的角色。我们首先对把参考model中我们举例的topic的党派影响分解开来,然后展示如何获得在不同Local mode中这些发现的稳定性。

分解协变量的影响Unpacking Covariate Effect Figure 2.5画出了在参考model中这些topic在保守党博客中的预期占比与民主党博客的预期占比之差。与保守党博客更有关系的topic在0的右边。

我们把这些topic放在党派背景下来观察。保守党对Supreme Court(最高法院)的topic的提及始于2008年6月Heller v. District of Columbia 的案子中反对Firearms Control Refulations Act of 1975修正案中的部分问题中。而在前一节的讨论中Cheney topic是源于Dick Cheney在担任副总统期间的遗留问题。这部分主要是来自民主党博客,带有浓厚的党派色彩。

保守党对全球变暖问题的极大关注起初是一个很令人惊讶的问题,因为这本身是一个典型的民主党议题,但在2008年这些博客却发表了相关的博文,而 之前,这一般都是民主党的领域。我们通过检测与这个topic最相关的博客文章来探索这一现象。Figure 2.6 展示了与此topic最相关的三篇博文的前300个字符。第一、三篇博文uinta全球变暖表示不满,是来自一个保守党倾向博客;第二篇博文对气候变化发出警告,来自一个民主党倾向博客。

伊朗和北韩核的武器问题显示,保守党更关注安全问题,并且,在他们的传统观点中,领土安全比共产主义更重要。最后,Reverend Jeremeiah Wright 的丑闻,曾遭到过民主党候选人Barack Obama的批评,在保守党倾向的博客中更加流行。

不同model下的稳定性(Stability across Models) 这些影响在在其他看起来可信的local mode中的稳定性如何?一个简单的方法可以根据参考模型调整topic去评估它的稳定性,并能计算不同topic的影响。尽管这个过程会得到超过效应大小的分布,但对于在解释结果中强调概念的挑战十分重要。每个model都可以 估计党派评级的影响,但这要求是在稍不同的topic的版本下。这样的不同源于两个理由:document-topic 的调整是不同的,但topic本身也会有不同的概念。我们做的调整确保了这类概念是与我们的参考model是最相似的(给定一个调整方法和相似性指标),但它们并不要求是同一概念。

Figure 2.7画出了效应大小的分布。起始点位于左上方,我们看到,在参考model中,对Supreme Court(最高法院)的党派影响在所有的local mode中保持的一个最大观测值。不仅仅参考model的效应在尾部逐渐消失,效应的大小的分布也是这样的,包括负效应和正效应。为什么会有这样的不同呢?通过比较参考model中的最可能出现的word与一个有强烈民主党倾向的model中调整后topic包括的word,可以看出一些不同之处:

Reference Model: law, court, rule, constitut, right, judg, decis, suprem, legal, justic, case, feder,requir, amend, protect, protect, gun, govern, allow, appeal, citizen

Local Mode: court, tortur, law, justic, legal, rule, judg, suprem, case, interrog, detaine, lawyer, cia, constitut, guantanamo, decis, prison, violat, prosecut, administr

Local mode包含了对围绕酷刑和关塔纳摩湾运作的法律问题的重要讨论。相比之下,我们的参考 有一个完全独立的topic来发现这些讨论(top words: totur, prison, cia, interrog, detaine, use, guantanamo)。我们发现效应的大小是在直方图的尾部基本消失,但这并不意味着这个发现是没有意义的,它显示对法律案件的内容和法律问题的传播是十分敏感的。

Figure 2.7的第二幅图展示的是Cheney topic。这里,我们看到三个mode下分布,其中,参考model位于最典型的点的正上方。根据前一节的讨论,这反映了topic完全聚焦在Cheney副总统与更广泛的Bush总统任期的不同。

全球变暖的例子(第三幅图)是最明确 的,而大多数结果都有极度相似的效应。这反映了讨论气候变化的词汇大多相对独立,这使得结果中topic的分配会更直接。

伊朗和北韩的topic想最高法院的topic一样,在所有的model中都是大量扩散的。不同于最高法院这个topic的是,参考model与结果中的大多数十分接近。这里变量的大多源于伊朗或者北韩,我们把它们都被归于同一个topic。

最后,关于牧师权利的topic显示,这里的参考model与local model具有很大的一致性。而包含丑闻的topic和包含Barack Obama就“A More Perct Union”的演讲中那些积极民主元素的topic会有一些区别。

这些例子高度展现了local mode针对参考model中的发现进行语义分析的价值。通过观察备选model,比如有关 高等法院的topic是聚焦在枪支管控或者酷刑的使用上,我们能更清楚的知道model中各个概念到底是什么。这反过来会让我们在选择标签时可以更好的反映topic的语义内容。

与真实数据的差异(Differences from Alignment)

这些分析中的大部分内容都对topic调整的方法是敏感的,我们需要关注协变量影响存在的显著不同。全局的调整会导致出现许多根据效应聚类的例子。考虑到Cheney topic的例子(在Figure 2.7中的中心上方位置)。我们在4.3节中讨论过这个例子,我们发现可以在另一个包括Bush任期和Cheney的model中匹配到这个topic。如果全局调整会把该topic匹配到关于Bush的参考model的topic上,就不能匹配到Cheney参考model的topic上。这就会导致在相关效应分布上表现出某些相关效应大小的聚类。我们发现,在确保不会将对照model中任何topic忽略的情况下,全局调整仍是最有用的。

2.4.5 额外的对比与相关的工作(Additional Comparisons and Related Work)

我们提供的例子聚焦在一个有特定数量topic的特殊数据集上。这里我们将探讨在附加的设定后的发现和在文学领域的相关工作。

不同的topic数量(Different Number of Topics

我们运行了一个之前讨论过的一个topic数量K=50的实验数据集,观察到与报道基本相同的模式和趋势。当实验中取更小的K=20,显示,topic的数量增加会带来调整的困难,在不同运行中有更高的不稳定性。我们推测这是依赖于topic的数量与特定的集合的匹配程度而不是通常来说的topic越少导致的。如果不稳定性可以由一个关于topic数量的函数唯一确定,我们预计在这个极端情况下运行的表现会大幅下降。我们很直观地就能感觉到,为给定一个数据集挑选太少的topic与不稳定性有关,但是我们需要额外去求证它。

可替代的距离指标(Alternatie Distance Measure)

在讨论结果之前,我们用两个基本的指标来度量topic-word分布。我们用点积度量来调整topic, 并展示了基于$L_1$距离的计算,同时,我们还用 一个余弦相似指标(用向量的$L_2$范数对点积做调整)来进行实验。

结果如Figure 2.8所示,在相似性指标、top word指标和 top document 指标间没有很明显的相关性。尤其是有很多情况在高余弦相似的topic却伴随着相较很少的top word或 top document的数量。在这些设定中对topic进行人工测试,结果显示,这与那些的大量的概率质量少于10个word的topic有关。

Koltov, Koltsova, and Nikolenko(2014)对稳定性用LDA做的一个类似的研究显示 ,可以通过少量的生成word的长尾方式来防止类 $L_1$度量的计算站主导地位 。为了防止这种情况,我们测试了仅仅计算word的最小集合的距离,这些word占了参考model中75 \%的概率质量。结果大致是相同的,但会噪声会更少。我们选择维持我们之前的版本来寻求对问题更简单的解释。

可替代的方案(Alternatie Approaches)

这里使用的相似性指标是根据语义相似性的自动逼近。所有的指标都会与来自参考model的误差做惩罚,不管它们是否直接与word有语义上的关系。一个方案是把word嵌入向量空间使得语义相关的word彼此相近,然后在计算相对于这个空间的距离(Mikolov et al., 2013)。这种方法的优势是,可以更加精确地区别有相同word但却在语义上不相关的topic。为了嵌入word,我们需要一个极大的文本库,这限制了在短document设定的应用。

最后,我们关心的是,在大量model下如何估计相似性。Chuang et al. (2013) 关注如何比较两个topic model,并介绍了根据参考model的被融合、重复出现、被废弃(匹配失败)或者被解决(匹配成功)的topic对应关系的分类方法。这些对照需要一个多一点的专门技术,但是可以在考虑不同数量的topic的情况下,更加优雅地比较的参考model和候选model之间的差异。

这一节展示了,在同一model的不同运行下,对topic比较的几种方法。这些方法不仅提供了一个对参考model稳定性的度量,还可以为分析者提供对topic内容的有用诊断信息。上述的讨论留下了一个开放且重要的问题,是否有在估计阶段提高model的运行效率。在下一节中,我们将讨论如何初始化来最大化初始运行的效率。

Initilization

翻译by 阿勺

初始化

当我们优化的功能是全球性且运转良好的,任何出发点将导致相同的解答。因此参数初始化成为无关紧要的细节,可能倾向选择节省计算成本。在多形式的初始化设置中,我们的初始化影响最终解决方案,当模型中推导的计算成本相当低,我们可以随意设置初始化参数,重复直到可调用局部大数据。

然而在潜变量模型中,确认几次相同的最大值,我们不仅从未使用重复的解决方案,而且每次模型的解决方案可能是非常昂贵的计算,一个问题是大数据设置繁琐化。如果在1百万文件中安装主题模型需要1周时间,则运行1000次是不合理的策略。一个众所周知但未经热议的统计优化是对不可思议的强大工具初始化持谨慎态度。

在返回主题模型方案前,我们考虑更简单的方式即K-均值, 一种与第2.2节谈论的正混合模型密切相关的聚类核心算法。K-均值有助于提供感知“智能”初始化的作用。在5.2节,我们回到主题模型,探讨LDA如何简单, STM如何应用于初始化更复杂的模型。在5.3节,我们提供的模拟研究展示基于LDA的初始化相对随机初始化可产生更高的价值。

我们在本节中考虑的初始化是随机的,所以我们在每次重复的过程里,会获得不同的解决方案,因此我们的目标是初始化以在期望值内获得更好的解决方案。在特殊情况下,诸如K-均值,我们甚至可能获得证明确保在定量的范围内,存在具兼容性的全球解决方案。

另一种方法是探索初始化的确定性,我们在第6节中概述近期具优良性的确定性初始化。

5.1 K-均值算法

K-均值是具争议性的聚类核心算法,它不仅在聚类算法和几何计算中是重要的问题,还是大型系统通用组成部分。因为K-均值聚类算法相当快速和易并行性,它在大数据设置中有广泛的应用。

K-均值聚类算法使用交互优化的策略,寻找样本聚类成K个截然不同的簇。这样在K-均值目标函数之间的欧几里得距离是一个被称为NP-hard的组合优化问题。这体现K-均值算法陷入局部最优的趋势中,然而它在实践中是应用最广泛的核心算法。

最受欢迎的启发式算法是从数据点随机选择一个类簇中心点,估计通过数据点分至最近中心和重新计算簇的位置的重复迭代。尽管结果是不可思议的快速程序,但相对全局最优可任意产生坏的分区。

随着K-均值算法的发展,问题有了实质性的进展。这个想法相当简单,相对最佳的解决方案,我们可通过使用精细设定的初始化中心恢复概率保证。这种基于从数据点随机 选择初始中心的设定策略,然后随机选择后期中心,但权衡利弊后优先考虑那些无预选中心的数据点。

K-均值算法强调是处理实践中多峰线性的重要工具,对涉及全局凸的问题是一个重大的不同,在那种情况下,起始值仅在加快速度或避免不稳定性数值是重要的,有趣的是,尽管K-均值算法概念简单,处理问题不可思议地高效,但直到劳埃德算法提出的25年后,它才被发现,解决这一问题的启发式算法持续是活跃的研究领域。

5.2 什么促使好的初始化?

一个好的初始化策略是平衡解决目标初始状态期望改进的成本,如果相对模型拟合过程,寻找参数的初始值成本是很高的,那你不妨使用计算时间随机重启原来的算法,因此模型初始化艺术其实是寻找一种尽可能简单的计算程序,将模型置于参数空间的正确区域。K-均值算法是一个不可思议的低成本初始化的最佳例证。

在这种情况下,模型自身是直线上升及推导成本呈单元量级急速攀升。一个简单但强有力的策略是在数据的小样本中运行模型。通常是一个好的默认值,尤其是因规模而价格昂贵的计算中的大数据体系。

在这种情况下,模型自身是直线上升及推导成本呈单元量级急速攀升。一个简单但强有力的策略是在数据的小样本中运行模型。通常是一个好的默认值,尤其是因规模而价格昂贵的计算中的大数据体系。

在STM里,有一个简单的生成模型LDA。由于LDA多项式共轭,我们能使用一个快速折叠的吉布斯抽样器进行推导,他们的关键在于操控大数据的本地模式允许所有参数的模型共轭,除了集成的令牌级主题隐藏变量。结果是一个被大量优化的快速采样,推导个别数量文本单词的成本是线性的。

因为LDA自身是多式联运,每次结果呈现不同的初始化,因此像K-均值算法,尽管靠近参数空间好区域STM,但是仍存在运行的不确定性。LDA算法初始化仅仅是随机分配的令牌,所以我们没有无限回归的问题。

5.3 初始化的影响

不像K-均值算法,我们无法为LDA特性作为初始化STM这种方法提供理论支撑。这自然引导我们询问如何在实践中执行初始化,为调查这个问题,我们对比了在685个模型运行初始化LDA和从随机值抽取50个运行初始化的目标函数值。图2.9描绘以此得出的分布处于目标函数的最终水平之上。

K-均值算法强调是处理实践中多峰线性的重要工具,对涉及全局凸的问题是一个重大的不同,在那种情况下,起始值仅在加快速度或避免不稳定性数值是重要的,有趣的是,尽管K-均值算法概念简单,处理问题不可思议地高效,但直到劳埃德算法提出的25年后,它才被发现,解决这一问题的启发式算法持续是活跃的研究领域。

Global solutions 全局解

翻译by dan

在前面的小节,我们讨论了非凸模型是如何导致推理算法呈现多模态的。对于主题模型的重要例子,我们提供了一系列的工具来研究局部模式,并且通过精细的初始化来提高解的平均精度。如果可以多次运行模型,那么这些方法很有效。然而,在大数据环境下,对模型的每个优化其代价都非常高,我们希望严格地限制模型运行的次数。

在本小节,我们引入了理论计算机科学的最新成果,利用谱学习对非凸模型进行全局优化。我们将展示,这些算法为非凸模型引入附加的假设,从而得到容易处理的推理方法,而且可证地保证恢复全局最优解的参数。根据第5小节的逻辑,我们利用一种LDA的算法作为STM的初始化。我们得到的结果揭示这种混合策略是一种处理大数据问题的有效方法。

我们在此提醒读者,这些技术还是非常前沿的,其课题应用的实质影响还没有完全明了,这些内容超越了本章的范围。而且我们想指出,初始化策略并不能解决多模态问题。这些技术并不给出正确的答案,虽然这些技术有效地提高了近似证据的下界,但这并不表明得到的解在其他准则下也是最优的(如之前讨论)。之前讨论的健壮性训练类型应该是研究过程中重要的一环。而且,我们发现,确定性的初始化过程对主题建模工具有清晰的贡献。

6.1谱学习介绍

当我们定义一个推理过程,我们希望能够证明,此算法能够收敛到全局最优解。对于此刻我们讨论的问题,我们一般满足于启发式算法,比如期望最大化算法,被证明能够收敛到局部最优(Dempster,Laird 和Rubin,1977),还有MCMC算法,虽然没有有限样本保证,但是能够渐进地恢复后验概率(Robert和Casella,2004)。实际上,两种算法都会陷入局部最优。

这里我们给出一类谱学习算法,能够估计隐含变量模型的参数,同时保证收敛到全局最优28。关键点是,通过矩阵(或者数组)分解技术,我们能够从数据的低阶矩恢复参数。这种方法依靠一中阶矩可推理的框架,而不是基于似然的框架(Pearson,1894;King,1989;Anandkumar,Ge,Hsu,Kakade和Telgrasky,2014)。这样,对于有确定结构的模型,就可证明能够保证恢复正确参数,类似自然可扩展的算法。

谱算法已经被应用在一系列的模型上:Gaussian混合模型(Hsu和Kakade,2012),隐含树模型(Song,Xing和Parikh,2011),图上社区检测算法(Anandkumar,Ge,Hsu和 Kakade,2014)字典学习算法(Arora,Ge和Moitra,2014),还有许多其他的模型(Anandkumar,Ge,Hsu,Kakade和Telgrasky,2014)。我们特别感兴趣的是估计主题模型的谱方法的建立(Arora,Ge和Moitra,2012;Anandkumar,Liu,Hsu,Foster和Kakade,2012)。LDA里一共有两种基本的谱学习算法,区别在不同的前提和方法。为了清楚描述,我们专注Arora等人建立的一种简单可扩展的算法(2013)。

这些方法的讨论难免比之前的内容更加具有技术性。然而,共同的题目是明确的:我们对模型进行更强的假设,从而得到一种不会受局部模式损害的算法。尤其是,我们用谱算法作为初始化,而不是一个简单的配合模型的过程。这样我们弱化了谱算法对假设的依赖,同时能够取得满意的特性。在这个意义上,谱学习算法对基于似然的方法是一种补充(Anandkumar,Ge,Hsu,Kakade和Telgrasky,2014)。

6.2 LDA算法

在此我们简单介绍一下Arora,Ge,Halpern等人的推理算法背后的直观思想,此算法用非负矩阵因式分解(NMF)29的方法从词共存矩阵恢复模型参数,并从数据中分离出β参数。算法的主要输入是V×V的词共存矩阵,其中V是词汇表中词的个数。把词共存矩阵正规化,使得所有元素之和为1,称为Q矩阵。如果我们假定Q矩阵由无穷文档构建出来的,那么Q是二阶矩,其中元素Qi,j正好是同一个文档中第i个词和第j个词共同出现的概率。我们用模型参数把Q写作

Q=E[βT θTθβ] (1) =βTE[θT θ]β (2)

(2)式把参数看作固定不变的但是未知的。Arora,Ge,Halpern等人(2013)证明,可以用非负矩阵因式分解的方法从参数中把βT恢复出来。

NMF问题是NP难问题(Vavasis,2009),并且实际上同LDA一样受局部模式的损害(Gillis,2014)。然而Arora,Ge和Moitra(2012)最近的研究工作表明,满足可分性(separability)条件的矩阵可以可证地进行非负矩阵分解(Donoho和Stodden,2003)。在这种上下文,可分性假设每个主题至少有一个词只属于此主题,被称为锚词(anchor)。主题k的锚词不必要出现在主题k相关的每个文档中,但是如果一个文档包含此锚词,此文档至少部分地与主题k相关。可分性隐含着Q矩阵的所有非锚词行能够从锚词行的凸组合恢复出来(Arora,Ge,Halpern等,2013)。这样一来,我们能够定位锚词行,然后用凸优化的方法解出β。

Arora,Ge,Halpern等(2013)建立的算法分两个部分。首先,我们定位锚词,得到锚词后,我们找出模型参数β。关键是这些步骤都不需要循环计算,而且对初始值不敏感。这两个步骤的计算有许多不同的方法,计算复杂度和健壮性也各有不同(Kumar,Sindhwani和Kambadur,2012;Recht等,2012;Gillis和Luce,2014;Ding,Rohban,Ishwar和Saligrama,2013)30。

优点

Arora,Ge,Halpern等人的算法主要的优点是,给定模型和可分性假设,我们能够理论上保证恢复最优参数。实际上,我们能完全绕过本章所说的多模态问题。第二个关键的优点是,此方法非常具有扩展性。注意,Q矩阵是V×V的,所以算法复杂度不会随着文档数量而增加。这样,对于一个大小不变的词汇表,对一百万个文档的推理和对一百个文档的推理实质上是一样的。在大数据环境下,这是最有用的特性。许多之前提到的算法也同样可扩展31。

缺点 自然谱算法也有实践上的不足。因为我们把多阶矩替换为观察到的样本矩,所以谱方法要求数据运行良好。实验中,根据Arora等人(2013)报告的合成数据,谱方法只有在40000个文档上取得Gibbs取样的精度。这个问题很突出,因为自然语言的幂律分布,我们必须非常大的文档量在估计高频词的共存概率。实际上,在锚词选择之前需要把低频词先过滤掉,这个问题才得到解决。

第二个问题是谱方法很倚重模型假设,结果会导致真实数据上得出不好理解的模型(Nguyen,Hu和Boyd-Graber,2014)。最后,实践上的一个问题就是,谱方法只能恢复出主题-词分布β,其他的文档主题特性需要别的方法得出。其他的文档主题特性可以由Gibbs取样或者变分推理取得(Robert等,2014)。

6.3 作为初始化的谱学习

这里,我们应用Arora等人(2013)的算法作为结构主题模型的初始化。用谱方法作为初始化弱化了我们对方法假设的依赖。例如,初始化会有锚词,但是一旦我们开始STM的变分推理,这些锚词能够自由地转换其概率到其他主题。这样,用谱算法能够使得我们站在一个最优的方向上。因为谱算法是确定性的,我们只需要运行模型一次。

我们把之前用过的Poliblog数据库的相同的100个主题的模型,对其用谱算法进行初始化。注意到,大约13000个文档的数据库比之前的发现要少,这结果暗示必须匹配Gibbs取样的精度。

图2.10展示了谱方法初始化模型的结果。不仅在下界上比随机初始化和LDA初始化要好的多,而且模型很快收敛32。因为我们这里的目标是介绍这一类的算法,整个模型的处理过程就不展示了。

6.4 未来方向

当下,谱算法是非常活跃的研究领域。这里我们主要关注其中一种算法:在可分性假设下非负矩阵因式分解算法。从Arora,Ge,Kannan和Moitra(2012)介绍了基于锚的方法之后,已经有许多算法的改进(Recht等,2012;Kumar,Sindhwani和Kambadur,2012;Ding,Rohban,Ishwar和Saligrama,2013;Gillis和Luce,2014;Gillis,2014;Zhou,Bilmes和Guestrin,2014)。同时也有许多工作是在其他问题领域应用此方法(Arora,Ge,Moitra和Sachdeva,2012;Arora,Ge和Moitra,2014;Arora,Bhaskara,Ge和Ma,2014;Zhou,Bilmes和Guestrin,2014)。

另一方面的工作使用数据的高阶矩和数组(张量)分解的方法。(Anandkumar,Ge,Hsu,Kakade和Telgrasky,2014)。这些方法同样能够应用在许多模型上。重要的是,我们一样可以应用这个框架来建立LDA算法,从而保证全局收敛(Anandkumar,Liu,Hsu,Foster和Karade,2012;Anandkumar,Hsu,Javanmard和Karade,2013)33。这些工作其假设和方法都有所不同。尤其关键的是,矩的张量方法使用数据的三阶矩阵,这往往需要更大的样本空间来达到估计精度。

Conclusion 总结

翻译by dan

数据本省和处理能力的快速提升已经促进数据分析新工具的发展和部署。所有这些新工具都能用新的方法和新的思想来看待数据,这在十年前是无法想象的。在本章,我们主要关注多模态问题,其影响了许多工具方法,特别关注文本数据的主题模型。本章的目标是探究多模态问题是从何而来的,然后研究在分析文本数据的时候如何从应用的角度面对多模态问题。

任何模型方法都需要清楚其过程和原理。本章我们关注的主题模型同传统的统计工具一样。在传统的线性模型中,模型的详细设计一直存在如何选择变量和公式的问题。虽然多模态带来了新的问题,研究者的责任还是一样,即小心验证所选的模型。无论是由于非凸隐变量模型,还是由于全局凸优化其中一项重要的模型参数,在候选模型中选择一直是研究者的责任。即使多模态是一个新问题,社会学家依然可以从经验选择最好的办法。

本章一个重要的实际贡献是拓展了研究者用在主题模型上的工具。当我们只关注STM的时候,我们介绍的许多方法对隐变量模型都有帮助。例如,主题对其排列和运行稳定性计算的方法能够直接应用在一大类的统计主题模型,一点微小的修改就可以应用在绝大多数的隐变量模型。

我们看到社会科学的大数据分析的巨大潜力,而不是只关注作为方法论的数据。我们认为这不仅对方法论的发展有重要影响,同时能够规范和结构化问题类型和数据集的类型。我们认为在许多领域都会有重要进展,比如最优初始化策略,在数据集规模越来越大的现在,这尤其重要。从应用的角度,用户不可能愿意为一个结果等更多的时间,虽然数据变多了。计算硬件能力的提升需要同智慧的算法匹配。从研究设计角度,我们认为更多关注会在如何把非结构化的数据变为结构化的。在STM,我们关注建模和测试的元数据,但这只是单一的利用。直接的监督能够帮助我们解决多模态问题吗?当然,当提出问题的人和解决问题的人之间能够积极交互,最后,大数据终于会成功。

Notes 注

翻译by dan

- 本章中,凸优化问题和凸模型指的是似然概率是全局凹的,即有最大值,而不是全局凸有最小值。我们主要的兴趣在于似然概率的模式数目。

- 对于找到一个函数的最优值,已经有大量的优化方法;参见Boyd和Vandenberghe(2009)

- 此模型等价于只对截距建模的正规线性回归,即没有回归量。

- 这个例子深度讨论参见King(1989)

- 对于多模态似然,如果Hessian矩阵是正定的,模型将是严格凸的(只有一个最优);如果半正定,则模型是凸的(同一平面上两点都是最优)

- 其他的用在大数据应用的正规线性回归模型包括lasso(Tibshirani,1996)

- 低维度例子的更多策略参见Kalai,Moitra和Valiant(2012)。

- 变分推理能够对易处理参数集的后验分布进行近似,不同于EM只能对模型参数进行点估计。我们简化了这两种方法之间的区别,认为变分推理能够对模型参数进行估计,而不是后验分布的参数。更多内容参见Jordan等(1998);Grimmer(2010b);Bishop等(2006)。

- LDA的后验概率分布同样可以用Gibbs取样方法来估计,参见Griffiths和Steyvers(2004)

- 举例来说,神经网络模型(Cochocki和Unbehauen,1993)能够对模型矩阵进行层次合并,对复杂数据生成过程的建模是十分有效的(Beck,King和Zeng,2000)。然而,神经网络模型受多模态似然影响十分大,极少能找到全局最优(Bishop等,2006;De Marchi,Gelpi和Grynaviski,2004)。其他的例子包括贝叶斯非参数过程(The等,2006;Griffiths和Tenenbaum,2004),隐Markov模型(Rabiner和Juang,1986;Park,2012),切换时间序列模型(Hamilton,1989),和似不相关回归分析(Srivastava和Giles,1987;Drton和Richardson,2004)等等。在政治科学流行的项目反应理论(IRT)模型(Hambleton,1991)是不确定的,因为彼此循环的解可能是同一数据集的结果(Poole和Rosenthal,1997;Rivers,2003)。为了估计整个模型,一些参数必须在其他参数确定之前被固定下来。实质上,一个问题总有多数相同可能的解。与之前例子的多模态不同,不确定似然的多解问题可以被归在多种模式的模型里面。

- LDA,或者一般的混合模型,从后验不变性到标签交换有K!个相同的模式(主题的排列)。这种多模态是棘手的问题,因为每个模式都给出相同的推理过程。

- 例如,Blei(2012)给出了非常棒的LDA的概述,但是并未提到局部最优的问题。介绍LDA的原始论文仅仅提到注意退化的初始化问题(Blei,Ng和Jordan,2003)。有名的反例是Koltcov,Koltsova和Nikolenko(2014),还有Lancichinetti等(2014),更直接地研究了稳定性,如本章我们做的那样。

- 如果P≠NP,情况就是这样。然而还没有证明P≠NP。

- NP难问题复杂度和局部模式之间的联系是很难说明清楚的。不是所有的凸问题都有多项式复杂度(de Klerk和Pasechnik,2002)。然而,这里我们有足够的证据来说,问题的困难本质说明,没有假设的具有全局收敛特征的实验算法是不太可能的。

- Quinn等(2010)给出了五中主题模型的验证方法:外部的,语义的,判别的,预测的和假设的。

- CMU Poloblog数据库http://sailing.cs.cmu.edu/socialmedia/blog2008.html,博客的文档http://sailing.cs.cmu.edu/socialmedia/blog2008.pdf。 5000个回复的样本在stm包。

- 每个模型都是要收敛的(两次目标差小于〖10〗^(-5))。

- Hungarian算法解决线性和分配问题是多项式时间复杂度。给定K×K矩阵,其元素是匹配i行j列的成本,Hungarian算法找到成本最小的从行到列的最优分配。Hungarian算法保证在O(K^3)时间算完(Papadimitriou和Steiglitz,1998)。我们用R语言的clue包(Hornik,2005)。

- 这同Roberts等建立的排列测试方法很相似。Roberts等(2014)的文章中我们感兴趣的是检测我们发现的二项处理指标的效应是否是由包含主题流行协变量引起的(我们结论错了吗?)。我们在文档中随机排列处理指标,重新运行模型。每次我们都在所有主题的数据中计算最大处理效应,然后同观察情况比较这个分布。如果我们结论错了,实验模型将发现大的处理效应,虽然处理指标是随机分配的。事实上,观察到的效应比随机排列的数据集要大得多,说明模型如期望工作。这里我们首先对齐排列主题,然后在运行之间比较效应大小。

- Roberts等(2014)中我们验证了一个小的回复数据集,其K=3,发现即使在苛求排列测试中,结果都十分稳定。

- Chuang等(2013)相对于人为相似性判断给出了一组不同的距离度量(测试KL发散程度,cos度量和Spearman等级系数)。他们发现cos度量最能直接体现人为判断,甚至能通过他们介绍的重新调整的点乘测量进一步改良。cos度量的强力发现对照于图2.8,说明cos度量能在其他环境下工作更好。

- 另外的策略是把主题距离的观念完全地给认为判断。这其实就是Grimmer和King(2011)的实质方法,他们给出了评价主题相似度的实验性方法。

- 我们说表现良好,因为事实上,由于数值优化的实际问题,即使是全局凸问题都对初始值很敏感。

- 容易并行的,我们指的是,能够方便地匹配Map-Reduce样式(Dean和 Ghemawat,2008)。整个算法依然是串行的,但是在每个循环内部,问题能够并行计算。

- 崩塌取样器比非崩塌取样器混合快得多(Carpenter,2010;Asuncion Jr,2011)。对主题-词分布β进行积分,每次我们在文档级别选取新样本的时候,我们隐式地更新了全局参数。结果,我们只需要对数据运行几次就可以取得满意的参数空间。

- 这样的理论分析在去顶前提下是可行的,但是需要很长的技术讨论。

- 我们用Dirichlet分布对主题-词分布进行初始化,把文档-主题比例先验平均数置为0。LDA的许多变种算法都这样初始化。

- 谱方法的名字从谱理论相关的线性代数的工具来。这里我们用了谱学习的定义,包含了运用矩阵或数组分解技术的许多方法,不止包含规范奇异值分解。

- NMF同奇异值分解很相似,除了分解的所有元素必须是非零的。

- 锚选择方法要么使用稀疏回归的框架(Recht等,2012),要么利用锚的集合特性(Kumar,Sindhwani和Kambadur,2012).参看Gillis(2014)的综述。对于我们的实验,我们集中在Arora,Ge,Halpern等人(2013)的方法上,实际上是利用了几何特性的方法。他们用了基于Gram Schmidt正交化过程的组合搜索来实现锚选择。参数恢复则利用了指数化的梯下降算法度(Kivinen和Warmuth,1997),具有L_2额定损失。

- 一个例子是混合成员随机阻塞模型,粗略地说,比如在网络上社区检测的LDA算法(Airoldi等,2009)。Huang等给出了一个谱算法,能够在10分钟内对百万节点的网络进行社区检测。

- 在谱初始化后,需要25次的循环进行收敛,而LDA算法初始化需要60次循环,随机初始化需要200次。

- 技术严格地说,Anandkumar,Liu,Hsu,Foster和Karade(2012)的工作使用了超相关分析,对数据的二阶矩和三阶矩阵进行两次奇异值分解。阶矩的张量方法由Anandkumar,Ge,Hsu,Karade和Telgarsky(2012)描述,并且应用在更大类的模型上。我们把它们组织在一起,因为他们由相同的研究小组提出,并使用了类似的技术。

- 有关谱方法的相异假设的出色讨论参见Ding,Ishwar,Rohban和Saligrama(2013)。