“NIS”的版本间的差异

| 第269行: | 第269行: | ||

==互信息随尺度的变化== | ==互信息随尺度的变化== | ||

| − | + | 由信息瓶颈理论与互信息理论,论文<ref name="1" />可以推出如下推论: | |

| 第275行: | 第275行: | ||

对于训练充分的NIS模型,宏观动力学<math>f_\beta</math>的互信息将与所有参数(包括刻度<math>q</math>)无关。 | 对于训练充分的NIS模型,宏观动力学<math>f_\beta</math>的互信息将与所有参数(包括刻度<math>q</math>)无关。 | ||

| − | 如果神经网络训练充分,则有关宏观动力学的互信息将接近数据<math>\{\mathbf{x}_t\}</math> | + | 如果神经网络训练充分,则有关宏观动力学的互信息将接近数据<math>\{\mathbf{x}_t\}</math>中的互信息。因此,无论<math>q</math>有多小(或尺度有多大),宏观动力学<math>f_\beta</math>的互信息都会保持恒定。 |

| − | 由此可得,<math>q</math> | + | 由此可得,<math>q</math>是因果涌现的无关参数。但根据EI的定义,较小的<math>q</math>意味着编码器将携带更多有效信息。 |

2024年8月31日 (六) 22:28的版本

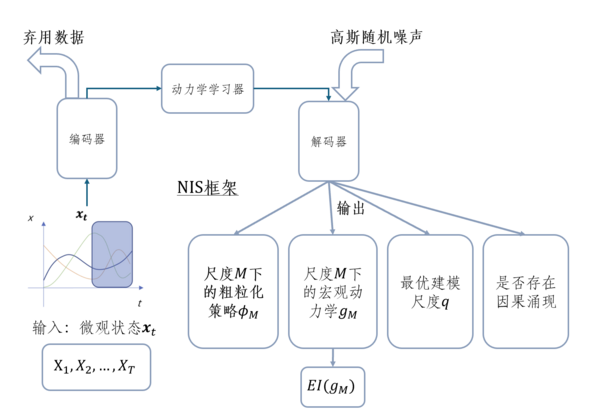

NIS(神经信息压缩器,英文为:Neural Information Squeezer,简称NIS)是一个以解决因果涌现辨识问题为目的的神经网络框架。它由编码器、解码器、动力学学习器三部分组成,其中编码器、解码器共享同一个可逆神经网络。NIS可以通过微观状态时间序列的输入、训练后输出粗粒化策略、宏观动力学、最优建模尺度,并判断是否存在因果涌现。NIS框架可以被视为一个压缩信道,通过投影操作在中间进行信息压缩。这种压缩信息通道通过约束粗粒化策略,将复杂的微观状态映射到简单的宏观状态,从而定义了有效的粗粒化策略和宏观态。通过理论推导可以证明一系列数学结论,例如:通过神经网络的训练过程,宏观动力学的互信息可以逐渐逼近真实数据中微观态在一个时间步内的互信息 [math]\displaystyle{ I(\mathbf{x}_{t+1}; \mathbf{x}_t) }[/math],并且这种逼近程度会随着宏观态维度的增加而减少。验证其性质的实验包括带测量噪声的弹簧振子模型、简单布尔网络等。NIS整体目标在于最大化有效信息,但NIS只通过维度参数寻优的方式部分实现了这一优化目标,关于这一问题更彻底的解决衍生出了NIS+框架。NIS展示了在时间序列数据中发现宏观动力学、粗粒化策略和因果涌现的理论性质和应用潜力。

历史

因果涌现的识别

尽管已经存在许多跨时间和空间尺度的因果涌现的具体例子[1],但是传统方法需要预先指定粗粒化方案和微观动力学的马尔科夫转移矩阵。因此,我们仍然需要一种仅从数据中识别因果涌现的方法,同时找到最优的粗粒化策略和宏观动力学。解决这一问题的困难主要在于,需要一种方法来系统地、自动地搜索所有可能的粗粒化策略(函数、映射),从而得到宏观动力学,以及判断因果涌现。但搜索空间是微观和宏观之间所有可能的映射函数,体量非常巨大。为了解决这个问题,Klein 等人重点研究了具有网络结构的复杂系统,将粗粒化问题转化为节点聚类,即找到一种方法将节点分组,使得簇级别的连接比原始网络具有更大的有效信息。虽然该方法假设底层节点动态是扩散(随机游走)的,它还是被广泛应用于各个领域之中。同时,现实世界中的的复杂系统具有更丰富的节点动力学。对于一般的动态系统,即使我们给定节点分组,粗粒化策略仍然需要考虑如何将簇中所有节点的微观状态映射到簇的宏观状态,也需要在巨大的粗粒化策略函数空间上进行繁琐的搜索。详细方法请参看:复杂网络中的因果涌现

当我们考虑所有可能的粗粒化策略时,另一个难点是如何避免平凡粗粒化策略的出现,即粗粒化策略过于压缩,导致无效的宏观动力学。例如一种可能的粗粒化策略是将所有微观状态的值映射到一个常数值的宏观状态。这样,系统的宏观动力学就只是一个恒等映射,它将具有较大的有效信息 (EI) 度量。但这种方法不能称为因果涌现,因为所有信息都被粗粒化方法本身抹去了。因此,我们必须找到一种方法来排除这种平凡解。这些困难阻碍了基于有效信息的因果涌现理论的发展和应用。

另一种因果涌现是基于信息分解的因果涌现理论,该理论也提供了一种从数据中识别因果涌现的方法[2]。虽然这种方法可以避免对粗粒化策略的讨论,但是如果我们想获得精确的结果,也需要在系统状态空间的各种可能的子集上进行搜索,这将会在大规模的系统上遭遇指数爆炸难题。此外,Rosas提出的数值近似方法只能提供因果涌现的充分条件,而不是必要条件。同时,该方法依赖于研究者给出明确的粗粒化策略和相应的宏观动力学,这在实际中往往是非常困难的。上述两种方法的另一个共同缺点是需要一个明确的宏观和微观动力学的马尔可夫转移矩阵才可以从数据中估计转移概率。因此,上述方法对罕见事件概率的预测将产生几乎无法避免的、较大的偏差,尤其对于连续数据。

近年来,基于神经网络的机器学习方法取得了进展,并催生了许多跨学科应用[3][4][5][6]。借助此方法,以数据驱动的方式自主发现复杂系统的因果关系甚至动力学成为可能。机器学习和神经网络还可以帮助我们找到更好的粗粒化策略。如果将粗粒化映射视为从微观状态到宏观状态的函数,那么人们显然可以用参数化的神经网络来近似这个函数。这些技术也能帮助我们从数据中发现宏观层面的因果机制。

标准化流技术

标准化流(Normalizing Flows,NF)是一类通用的方法,它通过构造一种可逆的变换,将任意的数据分布[math]\displaystyle{ p_x (\mathbf{x}) }[/math]变换到一个简单的基础分布[math]\displaystyle{ p_z (\mathbf{z}) }[/math],因为变换是可逆的,所以[math]\displaystyle{ \mathbf{x} }[/math]和[math]\displaystyle{ \mathbf{z} }[/math]是可以任意等价变换的。之所以叫Normalizing Flows,是因为它包含两个概念:

- 标准化(normalize):它可以将任意的复杂数据分布进行标准化为一个标准的分布(例如正态分布),类似于数据预处理中常用的数据0均值1方差的标准化,但是要精细很多;

- 流(Flows):数据的分布可以非常的复杂,需要多个同样的操作组合来达到标准化的效果,这个组合的过程称为流。

需要说明的是,因为分布间是可以相互变换的,因此对基础分布没有特定的限制,不失一般性,可以使用标准分布(单高斯)分布作为基础分布。另外,在本文中,我们回避使用先验分布(prior distribution)来称呼这个基础分布,是因为这里的变量[math]\displaystyle{ \mathbf{z} }[/math]和其他场合下的隐变量不同,在标准化流模型中,一旦[math]\displaystyle{ \mathbf{x} }[/math]确定了,[math]\displaystyle{ \mathbf{z} }[/math]也随之确定下来,不存在随机性,也没有后验概率这一说法,所以不能称其为隐变量。

王磊、尤亦庄等由标准化流技术提出了使用神经网络来对数据进行重整化的技术,并提出了神经重整化群的技术方案,并将其应用到图像生成、量子场论和宇宙学之中。给定一组图像,或一个场论的模拟数据,训练一个基于流的分层深度生成神经网络模型,这样,神经网络就能开发出最优的重整化群变换。标准化流模型和NIS在某些方面具有相似性。它们都致力于使用可逆神经网络(INN)将复杂的微观状态[math]\displaystyle{ s }[/math]映射到更简单的宏观状态[math]\displaystyle{ S }[/math],即粗粒化过程。在这种粗粒化之后,二者都试图通过优化某损失函数[math]\displaystyle{ L(s,S) }[/math],从而提取出系统中重要的宏观状态特征。这种方法可以帮助理解复杂系统中的涌现现象,在数据建模和分析中有较大应用潜力。

可逆神经网络技术

数学框架:最大化EI

信道具有一定的容量,即将输入以最具信息性和可靠性转换为输出的能力。通过信道传输的信息速率对输入概率分布[math]\displaystyle{ p(X) }[/math]的变化非常敏感。通道的容量([math]\displaystyle{ C }[/math])由最大化互信息的输入集合定义,即信道可靠传输信息的最大速率:

[math]\displaystyle{ C = max _{p(X)} I(X;\mathcal{Y}) }[/math]

因果涌现理论揭示了系统的类似因果容量。因果容量(CC)是系统以最具信息性和高效性的方式将干预转化为效应的能力:

[math]\displaystyle{ CC = max _{I_D}(I_D;E_D). }[/math]

正如改变通道的输入概率分布[math]\displaystyle{ p(X) }[/math]可以增加[math]\displaystyle{ I(X;Y) }[/math],改变干预分布l可以增加[math]\displaystyle{ I_D }[/math]。宏观干预的使用转换或扭曲了[math]\displaystyle{ I_D }[/math],导致因果涌现。相应地,具有EI最大化的宏观因果模型(及其相关的[math]\displaystyle{ I_D }[/math]和[math]\displaystyle{ E_D }[/math])最充分地利用了系统的因果容量。还需注意的是,尽管从某个特定宏观尺度的视角来看,[math]\displaystyle{ I_D }[/math]仍处于[math]\displaystyle{ H }[/math]的最大化状态,即每个[math]\displaystyle{ do(s_m) }[/math]具有相同的概率(而[math]\displaystyle{ E_D }[/math]是宏观效应的集合)。

NIS框架解决的数学问题正是如何最大化这一过程中的有效信息。

简介

NIS是一种将复杂系统数据驱动建模和因果涌现两种任务集于一体的数学优化框架以及神经网络框架。NIS面对的问题是,给定一组复杂系统运行表现的时间序列数据[math]\mathbf{x}_t[/math],例如一组fMRI的时间序列数据,或者一组鸟群的飞行轨迹,或者一组由生命游戏元胞自动机生成的图片序列,我们需要找到它的微观动力学、宏观动力学,以及如何从微观动力学映射为宏观动力学的粗粒化策略,并最终判断出该组数据所反映的真实复杂系统是否发生了因果涌现。

数学定义

NIS定义了一个数学优化框架,即有效信息的最大化,从而实现上述问题的解决。这一问题可以表述为:

[math]\displaystyle{ \max_{\phi_q,\hat{f}_{\phi_q},\phi_q^†,q} \mathcal{I}(\hat{f}_{\phi_q}) }[/math]

其中[math]\displaystyle{ \mathcal{I} }[/math]是维度平均有效信息的度量(参考有效信息);[math]\displaystyle{ \phi_q }[/math]是一种有效的粗粒化策略;[math]\displaystyle{ \hat{f}_{\phi_q}}[/math]是一种有效的宏观动力学,其中q是宏观态的维度,是一个超参;[math]\phi_q^{\dagger}[/math]是反粗粒化函数。这样,NIS的数学框架需要在所有可能的有效策略和动力学中优化有效信息。

神经网络框架

为了解决上述优化问题,NIS提出了一种神经网络架构,从而可以进行数值求解,该网络架构的示意图如下所示:

作为神经网络框架,NIS本质上是一个隐空间动力学学习框架。其中包括编码器、动力学学习器与解码器,可以由微观状态的时间序列输入、经训练后输出如下四个部分:

- 尺度M下的粗粒化策略(由可逆神经网络INN表示);

- 尺度M下的宏观动力学(由动力学学习器得出);

- 最优建模尺度q(由遍历得出最优维数);

- 判断:是否存在因果涌现(当最优尺度下的有效信息[math]\displaystyle{ EI_{M*} }[/math]大于最微观尺度下的有效信息[math]\displaystyle{ EI_m }[/math]时判断存在因果涌现)。

在NIS中,解码器和编码器都使用了可逆神经网络,这样做的好处是,其解码器可由编码器逆转得到,且可以自上而下地从解码器配合随机采样的数据生成微观态细节,属于生成模型的一种。

数学描述

接下来,我们将通过数学定义,详细描述NIS框架的基本概念和优化问题。

基本概念

微观动力学

假设讨论的复杂系统动力学可由如下微分方程组描述:

-

[math]\displaystyle{ \frac{d{\mathbf{x}}}{dt} = g(\mathbf{x}(t),ξ) }[/math]

(1)

其中[math]\displaystyle{ \mathbf{x}(t) ∈ \mathcal{R}^p }[/math] 是系统的微观状态,[math]\displaystyle{ p ∈ \mathcal{Z} }[/math] 是一正整数,表示微观态的维度,[math]\displaystyle{ ξ }[/math] 是一随机噪声,通常满足高斯分布。

不失一般性,微观动力学 [math]\displaystyle{ g }[/math] 总是马尔可夫的,可以等效地建模为条件概率 [math]\displaystyle{ Pr(\mathbf{x}(t + dt)|\mathbf{x}(t)) }[/math] 。

微观态

动力系统状态(式1)[math]\displaystyle{ \mathbf{x}_t }[/math] 的每一个样本称为时间步 [math]\displaystyle{ t }[/math] 的一个微观状态。以相等间隔和有限时间步长 T 采样的多变量时间序列 [math]\displaystyle{ \mathbf{x}_1,\mathbf{x}_2,···,\mathbf{x}_T }[/math] 可形成微观状态时间序列。

如果我们需要以数据驱动的方式重构微观动力学[math]\displaystyle{ g }[/math],则需要大量可观测的微观状态时间序列[math]\mathbf{x}_t[/math],但在噪声较强时,我们很难从微观状态中重建具有强因果特性的信息丰富的动力学。因果涌现的基本思想是,若忽略微观状态数据中的部分信息并将其转换为宏观状态时间序列,则可以重建一个具有更强因果关系的能描述系统演化的宏观动力学。

[math]\displaystyle{ q }[/math] 维粗粒化策略

从微观态到宏观态的信息转化过程即为粗粒化策略(或映射方法)。在宏观状态的维数为 [math]\displaystyle{ 0 \lt q \lt p ∈ \mathcal{Z}^+ }[/math] 的情况下,[math]\displaystyle{ q }[/math] 维粗粒化策略是一个连续可微函数,用于将微观状态 [math]\displaystyle{ \mathbf{x}_t ∈ \mathcal{R}^p }[/math] 映射到宏观状态 [math]\displaystyle{ \mathbf{y}_t ∈ \mathcal{R}^q }[/math]。该粗粒化可以表示为 [math]\displaystyle{ \phi_q }[/math]。

复杂系统经过粗粒化得到一个新的宏观状态时间序列数据,表示为 [math]\displaystyle{ \mathbf{y}_1 = \phi_q(\mathbf{x}_1), \mathbf{y}_2 = \phi_q(\mathbf{x}_2),···,\mathbf{y}_T = \phi_q(\mathbf{x}_T) }[/math] 。

宏观动力学

接着,我们需要寻找另一个动力学模型(或马尔可夫链)[math]\displaystyle{ \hat{f}_{\phi_q} }[/math] 来描述宏观状态 [math]\displaystyle{ \mathbf{y}_t }[/math] 的演变,即宏观动力学。对于给定的宏观状态时间序列 [math]\displaystyle{ \mathbf{y}_1,\mathbf{y}_2,···,\mathbf{y}_T }[/math] ,宏观状态动力学是一组微分方程:

-

[math]\displaystyle{ \frac{d\mathbf{y}}{dt} = \hat{f}_{\phi_q}(\mathbf{y}, ξ') }[/math]

(2)

其中[math]\displaystyle{ \mathbf{y} ∈ \mathcal{R}^q }[/math]为宏观态, [math]\displaystyle{ ξ' ∈ \mathcal{R}^q }[/math] 是宏观状态动力学中的噪声,[math]\displaystyle{ \hat{f}_{\phi_q} }[/math] 是连续可微函数,可通过最小化方程2在任何给定的时间步长 [math]\displaystyle{ t ∈ [1,T] }[/math] 和给定的向量范数[math]\displaystyle{ \Vert \cdot \Vert }[/math] 下的解来得到:

-

[math]\displaystyle{ \mathbf{y}(t) }[/math] :

[math]\displaystyle{ \langle \Vert \mathbf{y}_t-\mathbf{y}(t)\Vert \rangle_{ξ'} }[/math]

(3)

此框架不能排除一些平凡解。例如,假设对于 [math]\displaystyle{ ∀ \mathbf{y}_t ∈ \mathcal{R}^p }[/math] , [math]\displaystyle{ q = 1 }[/math] 维的 [math]\displaystyle{ \phi_q }[/math] 定义为 [math]\displaystyle{ \phi_q(\mathbf{x}_t) = 1 }[/math] 。因此,相应的宏观动力学只是 [math]\displaystyle{ d\mathbf{y}/dt = 0 }[/math] 和 [math]\displaystyle{ \mathbf{y}(0) = 1 }[/math]。由于宏观状态动力学是平凡的,粗粒化映射过于随意,此方程无意义。因此,必须对粗粒化策略和宏观动力学设置限制以避免平凡解和动力学。

有效粗粒化策略

为了规避上述平凡解的问题,NIS提出了有效粗粒化策略和有效宏观动力学的概念。

其中,所谓的有效粗粒化策略应是一个从微观态到宏观态可以尽量多地保存微观态信息的压缩映射。

如果存在一个函数 [math]\displaystyle{ \phi_q^† :\mathcal{R}^q \rightarrow \mathcal{R}^p }[/math],使得对于给定的小实数[math]\displaystyle{ \varepsilon }[/math]和给定的向量范数[math]\displaystyle{ \Vert \cdot \Vert }[/math],以下不等式成立,则 [math]\displaystyle{ q }[/math] 维粗粒化策略[math]\displaystyle{ \phi_q :\mathcal{R}^p \rightarrow \mathcal{R}^q }[/math]是[math]\displaystyle{ \epsilon }[/math]有效的:

-

[math]\displaystyle{ \Vert \phi_q^† ( \mathbf{y}(t) - \mathbf{x}_t \Vert \lt \epsilon , }[/math]

(4)

这里的[math]\phi_q^{\dagger}[/math]即为与[math]\phi_q[/math]相应的反粗粒化策略,如果使用可逆神经网络技术建模[math]\phi_q[/math],且如果[math]p=q[/math],则[math]\phi_q^{\dagger}\equiv \phi_q^{-1}[/math]。

有效宏观动力学

同时,由上面导出的宏观动力学[math]\displaystyle{ \hat{f}_{\phi_q} }[/math]也是[math]\epsilon[/math]有效的(其中[math]\displaystyle{ \mathbf{y}(t) }[/math] 是式2的解)。即对于所有[math]\displaystyle{ t = 1,2,···, T }[/math]:

-

[math]\displaystyle{ \mathbf{y}(t)=\phi_q (\mathbf{x}_{t-1}) + \int_{t-1}^t \hat{f}_{\phi_q}(\mathbf{y}(\tau), \xi') d\tau }[/math]

(5)

可以通过[math]\displaystyle{ \phi_q^† }[/math]重构微观状态时间序列,使得宏观状态变量尽可能多地包含微观状态的信息。

最大化有效信息

为了找到上述各个函数,即有效粗粒化和有效的宏观动力学,NIS提出通过最大化有效信息(EI)来进行求解。

因此,最优的粗粒化策略和宏观动力学可以表述为:在约束方程4和5下,最大化宏观动力学的有效信息,即:

-

[math]\displaystyle{ \max_{\phi_q,\hat{f}_{\phi_q},\phi_q^†,q} \mathcal{I}(\hat{f}_{\phi_q}) }[/math]

(6)

其中[math]\displaystyle{ \mathcal{I} }[/math]是有效信息的度量(这里,因为所有变量都是连续型实数变量,故而NIS使用的是维度平均的有效信息,即dEI)。[math]\displaystyle{ \phi_q }[/math] 是一种有效的粗粒化策略,[math]\displaystyle{ \hat{f}_{\phi_q} }[/math]是一种有效的宏观动力学。

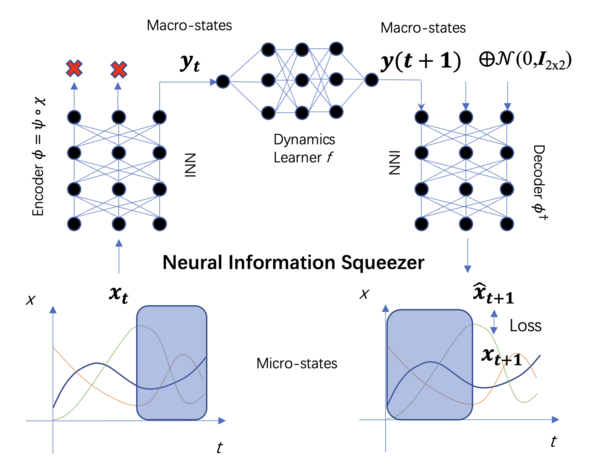

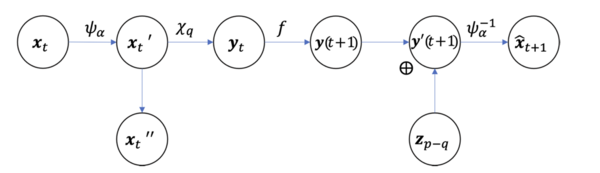

NIS机器学习框架

NIS是一种新的机器学习框架,基于可逆神经网络来解决式6中提出的问题。该框架由三个组件组成:编码器、动力学学习器和解码器。它们分别用神经网络 [math]\displaystyle{ \psi_\alpha , f_\beta , }[/math] 和[math]\displaystyle{ \psi_\alpha^{-1} }[/math] 来实现,其中这些神经网络的参数分别为[math]\displaystyle{ \alpha, \beta }[/math] 和[math]\displaystyle{ \alpha }[/math] 。整个框架如图1所示。接下来将分别描述每个模块。

编码器

首先,编码器又是由可逆函数[math]\psi[/math]与投影操作[math]\chi[/math]两部分构成。

[math]\psi[/math]

这里[math]\psi[/math]是一个从[math]\displaystyle{ \mathcal{R}^p }[/math] 到 [math]\displaystyle{ \mathcal{R}^p }[/math]的可逆函数,它建模了粗粒化过程中,信息转换的操作。由于函数是可逆的,因此,这一步仅仅做信息转换,而不损失任何信息。

投影操作

投影算子[math]\displaystyle{ \chi_{p,q} }[/math] 是一个从[math]\displaystyle{ \mathcal{R}^p }[/math] 到 [math]\displaystyle{ \mathcal{R}^q }[/math]的函数,表达为

-

[math]\displaystyle{ \chi_{p,q}(\mathbf{x}_q \bigoplus \mathbf{x}_{p-q}) = \mathbf{x}_q, }[/math]

(7)

其中[math]\displaystyle{ \bigoplus }[/math] 是向量拼接(concatenate)算符,[math]\displaystyle{ \chi_q \in \mathcal{R}^q , \chi_{p-q} \in \mathcal{R}^{p-q} }[/math]。 [math]\displaystyle{ \chi_p,q }[/math]可简写为[math]\displaystyle{ \chi_q }[/math]。

投影算子则建模了粗粒化过程中的信息丢失的运算。

合成

这样,编码器[math]\displaystyle{ (\phi) }[/math]将微观状态[math]\displaystyle{ \mathbf{x}_t }[/math]映射到宏观状态[math]\displaystyle{ \mathbf{y}_t }[/math],分为两个步骤:

-

[math]\displaystyle{ \phi_q=\chi_q \circ \psi }[/math]

(8)

其中[math]\displaystyle{ \circ }[/math]表示函数复合运算。

第一步是从[math]\displaystyle{ \mathbf{x}_t \in \mathcal{R}^p }[/math] 到 [math]\displaystyle{ \mathbf{x}'_t \in \mathcal{R}^p }[/math]的双射(可逆)映射[math]\displaystyle{ \psi : \mathcal{R}^p \rightarrow \mathcal{R}^p }[/math],等价于向量在高维空间中的旋转,只改变向量与坐标轴的角度,不改变模长,无信息丢失,该过程可以由可逆神经网络实现;第二步是通过将[math]\displaystyle{ \mathbf{x}_t \in \mathcal{R}^p }[/math]映射到[math]\displaystyle{ \mathbf{y}_t \in \mathcal{R}^q }[/math],丢弃[math]\displaystyle{ p-q }[/math]维上的信息,将得到的向量投影到[math]\displaystyle{ q }[/math]维。

动力学学习器

动力学学习器 [math]\displaystyle{ f_\beta }[/math] 是一个带有参数的常见前馈神经网络,它在宏观层面上学习有效的马尔可夫动力学。用 [math]\displaystyle{ f_\beta }[/math] 替换方程2中的 [math]\displaystyle{ \hat{f}_{\phi_q} }[/math],并使用 [math]\displaystyle{ dt = 1 }[/math] 的欧拉方法求解方程 (2)。假设噪声是高斯分布(或拉普拉斯分布),则可以将方程5简化为:

-

[math]\displaystyle{ \mathbf{y}(t+1) = \mathbf{y}_t + \int_t^{t+1} f_\beta (\mathbf{y}(\tau), \xi') d\tau \approx \mathbf{y}_t + f_\beta (\mathbf{y}_t)+\xi' }[/math]

(9)

其中,[math]\displaystyle{ \xi' \sim \mathcal{N}(0,\Sigma) }[/math] 或 [math]\displaystyle{ Laplacian(0, \Sigma), }[/math] [math]\displaystyle{ \Sigma = diag (\sigma_1^2, \sigma_2^2, ···, \sigma_q^2) }[/math] 是协方差矩阵,[math]\displaystyle{ \sigma_i }[/math] 是第 [math]\displaystyle{ i }[/math] 维度的标准差(可以学习或固定)。因此,该动力学的转移概率可被写作:

-

[math]\displaystyle{ P(\mathbf{y}(t+1)|\mathbf{y}_t) = \mathcal{D}(\mu (\mathbf{y}_t), \Sigma) }[/math]

(10)

其中,[math]\displaystyle{ \mathcal{D} }[/math] 指表示高斯分布或拉普拉斯分布的概率密度函数,[math]\displaystyle{ \mu (\mathbf{y}_t) \equiv \mathbf{y}_t+f_\beta(\mathbf{y}_t) }[/math] 是分布的均值向量。

通过端到端的方式训练动力学学习器,可以避免从数据中估计马尔可夫转移概率以减少偏差。

解码器

解码器将宏观状态 [math]\displaystyle{ \mathbf{y}(t + 1) }[/math] 的预测转换为微观状态 [math]\displaystyle{ \hat{\mathbf{x}}_{t+1} }[/math] 的预测。在这个框架中,粗粒化策略 [math]\displaystyle{ \phi_q }[/math] 可以分解为可逆函数 [math]\displaystyle{ \psi }[/math] 和投影器 [math]\displaystyle{ \chi_q }[/math],因此解码器可以直接通过反转 [math]\displaystyle{ \psi }[/math] 得到。然而,由于宏观状态的维度是 [math]\displaystyle{ q }[/math],而 [math]\displaystyle{ \psi }[/math] 的输入维度是 [math]\displaystyle{ p \gt q }[/math],因此需要用 [math]\displaystyle{ p-q }[/math] 维高斯随机向量填充剩余的 [math]\displaystyle{ p-q }[/math] 维。对于任何 [math]\displaystyle{ \phi_q }[/math],解码映射可以定义为:

-

[math]\displaystyle{ \phi_q^† = \psi_\alpha^{-1} \circ \chi_q^† }[/math]

(11)

其中,[math]\displaystyle{ \psi^{-1} }[/math] 是 [math]\displaystyle{ \psi_\alpha }[/math] 的逆函数,[math]\displaystyle{ \chi_q^† : \mathbb{R}^q \rightarrow \mathbb{R}^p }[/math] 定义为:对于任意 [math]\displaystyle{ \mathbf{x} \in \mathbb{R}^p }[/math],有

-

[math]\displaystyle{ \chi_q^†(\mathbf{x}_q \bigoplus \mathbf{z}_{p-q}) }[/math]

(12)

其中,[math]\displaystyle{ \mathbf{z}_{p-q} \sim \mathcal{N}(0, \mathcal{I}_{p-q}) }[/math] 是 [math]\displaystyle{ p-q }[/math] 维的高斯随机噪声,[math]\displaystyle{ \mathcal{I}_{p-q} }[/math] 是同维度的单位矩阵。这样可以结合 [math]\displaystyle{ \mathbf{x}_q }[/math] 和一个来自 [math]\displaystyle{ p-q }[/math] 维标准正态分布的随机样本 [math]\displaystyle{ \mathbf{z}_{p-q} }[/math] 生成微观状态。

解码器可以被视为条件概率 [math]\displaystyle{ Pr(\hat{\mathbf{x}}_{t+1} | \mathbf{y}(t+1)) }[/math] 的生成模型[8][9],而编码器执行粗粒化过程(也可以称为重整化Renormalization)。

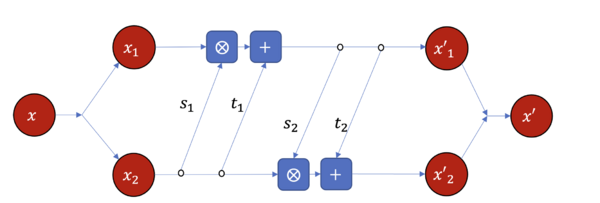

使用可逆神经网络的原因

有多种方法可以实现可逆神经网络[10][11]。这里选择如图2所示的RealNVP模块[12]来具体实现可逆计算。

在该模块中,输入向量[math]\displaystyle{ \mathbf{x} }[/math]被拆分成两部分并缩放、平移、再次合并,缩放和平移操作的幅度由相应的前馈神经网络调整。[math]\displaystyle{ s_1,s_2 }[/math]是用来缩放的共享参数的神经网络,[math]\displaystyle{ \bigotimes }[/math] 表示元素乘积。[math]\displaystyle{ t_1,t_2 }[/math]是用来平移的共享参数的神经网络。这样,我们就可以实现从x到y的可逆计算。同一模块可以重复多次以实现复杂的可逆计算。

两步优化

尽管函数已被神经网络参数化,但由于必须综合考虑目标函数和约束条件,并且超参数 [math]\displaystyle{ q }[/math] 会影响神经网络的结构,因此直接优化式 6 仍然具有挑战性。因此,论文引用错误:无效<ref>标签;name属性不能是单一的数字,请使用可辨识的标题提出了一种两阶段优化方法。在第一阶段,论文固定超参数 [math]\displaystyle{ q }[/math],并优化预测的微观状态和观测数据的差异 [math]\displaystyle{ |\phi_q^† (\mathbf{y}(t))-\mathbf{x}_t| }[/math](即式 4),以确保粗粒化策略 [math]\displaystyle{ \phi_q }[/math] 和宏观动力学 [math]\displaystyle{ \hat{f}_q }[/math] 的有效性。此外,NIS通过搜索所有可能的 [math]\displaystyle{ q }[/math] 值,以找到有效信息的最大值,也就是最大化 [math]\displaystyle{ \mathcal{I} }[/math]。

训练一个预测器

在第一阶段,NIS使用似然最大化和随机梯度下降技术来获得有效的 [math]\displaystyle{ q }[/math] 粗粒化策略和宏观状态动力学的有效预测器。目标函数由微观状态预测的概率定义。

前馈神经网络可以理解为一种用高斯或拉普拉斯分布建模条件概率[13]的机器。因此,整个 NIS 框架可以理解为一个对条件概率[math]\displaystyle{ P(\hat{\mathbf{x}}_{t+dt} | \mathbf{x}_t) }[/math] 建模的模型,神经网络的输出 [math]\displaystyle{ \hat{\mathbf{x}}_{t+1} }[/math] 为此分布的平均值。此外,目标函数方程 14 只是给定分布形式下观测数据的对数似然或交叉熵。

-

[math]\displaystyle{ \mathcal{L} = \sum_t \ln P(\hat{\mathbf{x}}_{t+1} = \mathbf{x}_{t+1} | \mathbf{x}_t) }[/math]

(13)

其中当 [math]\displaystyle{ l=2 }[/math] 时,[math]\displaystyle{ P(\hat{\mathbf{x}}_{t+1} = \mathbf{x}_{t+1} | \mathbf{x}_t) \sim \mathcal{N}(\hat{\mathbf{x}}_{t+1}, \Sigma) }[/math],而当 [math]\displaystyle{ l=1 }[/math] 时概率分布为 [math]\displaystyle{ Laplace(\hat{\mathbf{x}}_{t+1}, \Sigma) }[/math]。[math]\displaystyle{ \Sigma }[/math] 是协方差矩阵。[math]\displaystyle{ \Sigma }[/math] 始终是对角矩阵,其幅度为 [math]\displaystyle{ l = 2 }[/math] 时的均方误差或 [math]\displaystyle{ l = 1 }[/math] 时的绝对值平均值。

如果将高斯或拉普拉斯分布的具体形式带入条件概率,将看到最大化对数似然等同于最小化 [math]\displaystyle{ l }[/math] 范数目标函数:

-

[math]\displaystyle{ \mathcal{L}=\sum_t \Vert \hat{\mathbf{x}}_{t+1} - \mathbf{x}_{t+1} \Vert_l }[/math]

(14)

其中 [math]\displaystyle{ l = 1 }[/math] 或 [math]\displaystyle{ 2 }[/math]。接下来使用随机梯度下降技术来优化方程14。

选择一个最优的尺度

在上一步中,经过大量的训练周期可以得到有效的 [math]\displaystyle{ q }[/math] 粗粒化策略和宏观状态动力学,但训练结果依赖于 [math]\displaystyle{ q }[/math]。

为了选择最优的 [math]\displaystyle{ q }[/math],可以比较不同 [math]\displaystyle{ q }[/math] 维粗粒化的有效信息度量 [math]\displaystyle{ \mathcal{I} }[/math]。由于参数 [math]\displaystyle{ q }[/math] 是一维的,其值范围也有限 [math]\displaystyle{ (0 \lt q \lt p) }[/math],可以简单地迭代所有 [math]\displaystyle{ q }[/math] 以找出最优的 [math]\displaystyle{ q }[/math] 和最优的有效策略。

NIS的理论性质

使用了可逆神经网络作为编码器的基础以后,NIS框架具备很好地数学分析性质。接下来,这里将展示论文引用错误:无效<ref>标签;name属性不能是单一的数字,请使用可辨识的标题的若干重要定理。

压缩信道理论

NIS框架(图 1)可以看作图 3 所示的信道,由于投影操作的存在,通道在中间被压缩。此为压缩信息通道。

信息压缩的信息瓶颈

对于图 3 所示的压缩信道以及任意可逆函数[math]\displaystyle{ \psi }[/math]、投影函数 [math]\displaystyle{ \chi_q }[/math]、宏观动力学 [math]\displaystyle{ f }[/math] 和随机噪声 [math]\displaystyle{ \mathbf{z}_{p-q} \sim \mathcal{N}(0,\mathcal{I}_{p-q}) }[/math],有:

-

[math]\displaystyle{ I(\mathbf{y}_t; \mathbf{y}(t+1) )= I(\mathbf{x}_t, \hat{\mathbf{x}}_{t+1}), }[/math]

(21)

其中[math]\displaystyle{ \hat{\mathbf{x}}_{t+1} }[/math] 是NIS的预测值,[math]\displaystyle{ \mathbf{y}(t+1) }[/math]符合式2。

对于任何实现图 3 中一般框架的神经网络,宏观动力学 [math]\displaystyle{ f_{\phi_q} }[/math] 的互信息与整个动力学模型相同,即对于任意时间从 [math]\displaystyle{ (\mathbf{x}_t) }[/math] 到 [math]\displaystyle{ (\hat{\mathbf{x}}_{t+1}) }[/math] 的映射。此定理是 NIS 中最重要的定理。从这个定理可以看出,实际上,宏观动力学 [math]\displaystyle{ f }[/math] 是整个通道的信息瓶颈[14]。

训练过程的变化

通过信息瓶颈理论,可以直观地理解当神经压缩器框架通过数据进行训练时会发生什么。 首先,在神经网络训练过程中,整个框架的输出[math]\displaystyle{ \hat{\mathbf{x}}_{t+1} }[/math]对任意给定[math]\displaystyle{ \mathbf{x}_t }[/math]都接近于真实数据[math]\displaystyle{ \mathbf{x}_{t+1} }[/math],对互信息同理。即如下定理:

模型的互信息与数据的互信息接近

如果 NIS 框架中的神经网络是训练充分的(即对于任何[math]\displaystyle{ t \in [1,T] }[/math]训练周期结束时有 [math]\displaystyle{ Pr_\tau (\hat{\mathbf{x}}_{t+1} | \mathbf{x}_t) }[/math] 和 [math]\displaystyle{ Pr_\tau (\mathbf{x}_{t+1} | \mathbf{x}_t) }[/math] 之间的 Kullback- Leibler 散度趋近于 0),那么对于任何[math]\displaystyle{ t \in [1, T] }[/math]:

-

[math]\displaystyle{ I(\hat{\mathbf{x}}_{t+1}; \mathbf{x}_t) \simeq I(\mathbf{x}_{t+1} ; \mathbf{x}_t) }[/math]

(22)

其中 [math]\displaystyle{ \simeq }[/math] 表示[math]\displaystyle{ t \rightarrow \infty }[/math] 时的渐近等价。

由于微观状态[math]\displaystyle{ \mathbf{x}_t }[/math]的时间序列包含信息,假设互信息[math]\displaystyle{ I(\mathbf{x}_t,\mathbf{x}_{t+1}) }[/math] 较大,否则不关注[math]\displaystyle{ \mathbf{x}_t }[/math]。因此,随着神经网络的训练,[math]\displaystyle{ I(\hat{\mathbf{x}}_{t+1}; \mathbf{x}_t) }[/math]将增加,直到接近[math]\displaystyle{ I(\mathbf{x}_{t+1} ; \mathbf{x}_t) }[/math]。根据信息瓶颈理论,[math]\displaystyle{ I(\mathbf{y}_{t}; \mathbf{y}_{t+1} ) = I(\mathbf{x}_{t} ; \hat{\mathbf{x}}_{t+1}) }[/math]也将增加,直到接近[math]\displaystyle{ I(\mathbf{x}_{t+1} ; \mathbf{x}_t) }[/math]。

因为宏观动力学是整个通道的信息瓶颈,其信息必然随着训练而增加。同时,[math]\displaystyle{ \psi }[/math]的雅可比矩阵的行列式和[math]\displaystyle{ \mathbf{y}_t }[/math]的熵一般也会增加。

信息瓶颈是编码器的下界

对于图3中的压缩信息信道,[math]\displaystyle{ \psi_\alpha }[/math]的雅可比矩阵的行列式和[math]\displaystyle{ \mathbf{y}_t }[/math]的香农熵的下界是整个信道的信息:

-

[math]\displaystyle{ H(\mathbf{x}_t)+ \mathbb{E}(\ln | \det (J_{\psi_\alpha} (\mathbf{x}_t))|) \geq H(\mathbf{y}_t) + \mathbb{E}(\ln |\det(J_{\psi_\alpha}, \mathbf{y}_t))|) \geq I(\mathbf{x}_t ; \hat{\mathbf{x}_{t+1}}) }[/math]

(23)

其中H为香农熵测度,[math]\displaystyle{ J_{\psi_\alpha}(\mathbf{x}_t) }[/math]为双射[math]\displaystyle{ \psi_\alpha }[/math]输入[math]\displaystyle{ \mathbf{x}_t }[/math] 时的雅可比矩阵,[math]\displaystyle{ J_{\psi_\alpha , \mathbf{y}_t}(\mathbf{x}_t) }[/math] 为[math]\displaystyle{ J_{\psi_\alpha}(\mathbf{x}_t) }[/math]在[math]\displaystyle{ \mathbf{x}'_t }[/math] 投影[math]\displaystyle{ \mathbf{y}_t }[/math]上的子矩阵。

由于给出了[math]\displaystyle{ \mathbf{\mathrm{x}}_t }[/math]的熵,定理4指出 [math]\displaystyle{ |\det(J_{\psi_\alpha}(\mathbf{x}_t))| }[/math]的对数的期望以及[math]\displaystyle{ \mathbf{y}_t }[/math]必然大于整个信道的信息。

因此,若[math]\displaystyle{ \mathbb{E} | \det (J_{\psi_\alpha}(\mathbf{x}_t))| }[/math]的初始值和[math]\displaystyle{ \mathbf{y}_t }[/math]很小,随着模型的训练,整个信道的互信息会增加,此时雅可比矩阵的行列式必然增大,宏观态[math]\displaystyle{ \mathbf{y}_t }[/math]也必然更分散。但若信息[math]\displaystyle{ I(\mathbf{x}_t, \hat{\mathbf{x}}_{t+1}) }[/math]已对[math]\displaystyle{ I(\mathbf{x}_t; \mathbf{x}_{t+1}) }[/math]或[math]\displaystyle{ \mathbb{E} |\det (J_{\psi_\alpha}(\mathbf{x}_t))| }[/math]和[math]\displaystyle{ H(\mathbf{y}_t) }[/math]已足够大,则这些现象可能不会发生。

有效信息主要由粗粒化函数决定

此前分析的是互信息而非宏观动力学的有效信息(因果涌现的关键要素)。实际上可以借助压缩信道的良好属性写出EI的宏观动力学表达式,但这一表达式没有解析的形式。由此得出确定因果涌现的主要成分是依赖于可逆函数[math]\displaystyle{ \psi_\alpha }[/math]的。

宏观动力学有效信息的数学表达式

假设给定[math]\displaystyle{ \mathbf{x}_t }[/math]下[math]\displaystyle{ \mathbf{x}_{t+1} }[/math]的概率密度可以通过函数[math]\displaystyle{ Pr(\mathbf{x}_{t+1} | \mathbf{x}_t) \equiv G(\mathbf{x}_{t+1}, \mathbf{x}_t) }[/math]描述,且神经信息挤压框架训练充分,即可通过以下方式计算[math]\displaystyle{ f_\beta }[/math]的宏观动力学信息:

-

[math]\displaystyle{ EI_L(f_\beta) = \frac{1}{(2L)^p} \cdot \int_\sigma \int_{\mathcal{R}^p} G(\mathbf{y}, \psi_\alpha^{-1}(\mathbf{x})) \ln \frac{(2L)^pG(\mathbf{y, \psi_\alpha^{-1}(\mathbf{x})})}{\int_\sigma G(\mathbf{y}, \psi_\alpha^{-1}(\mathbf{x}'))d\mathbf{x}'}d\mathbf{y} d\mathbf{x} }[/math]

(24)

其中 [math]\displaystyle{ \sigma \equiv [-L,L]^p }[/math] 是[math]\displaystyle{ \mathbf{x} }[/math]与[math]\displaystyle{ \mathbf{x}' }[/math]的积分区间;[math]L[/math]是do成均匀分布时,宏观态区间的线性尺度大小,它是一个充分大的给定常数。

互信息随尺度的变化

由信息瓶颈理论与互信息理论,论文引用错误:无效<ref>标签;name属性不能是单一的数字,请使用可辨识的标题可以推出如下推论:

如果模型训练良好,宏观动力学的互信息不会发生变化

对于训练充分的NIS模型,宏观动力学[math]\displaystyle{ f_\beta }[/math]的互信息将与所有参数(包括刻度[math]\displaystyle{ q }[/math])无关。 如果神经网络训练充分,则有关宏观动力学的互信息将接近数据[math]\displaystyle{ \{\mathbf{x}_t\} }[/math]中的互信息。因此,无论[math]\displaystyle{ q }[/math]有多小(或尺度有多大),宏观动力学[math]\displaystyle{ f_\beta }[/math]的互信息都会保持恒定。

由此可得,[math]\displaystyle{ q }[/math]是因果涌现的无关参数。但根据EI的定义,较小的[math]\displaystyle{ q }[/math]意味着编码器将携带更多有效信息。

信道越窄互信息越小

若[math]\displaystyle{ \mathbf{x}_t }[/math]是[math]\displaystyle{ p }[/math]维的,那么对于 [math]\displaystyle{ 0 \lt q_1 \lt q_2 \lt p }[/math] 有

-

[math]\displaystyle{ I(\mathbf{x}_t; \hat{\mathbf{x}}_{t+1}) \leq I(\mathbf{x}_t ; \mathbf{y}_t^{q_1}) \leq I(\mathbf{x}_t ; \mathbf{y}_t^{q_2}), }[/math]

(25)

其中[math]\displaystyle{ \mathbf{y}_t^q }[/math] 表示 [math]\displaystyle{ \mathbf{y}_t }[/math] 的[math]\displaystyle{ q }[/math] 维向量。

互信息描述了编码器(即在不同维度[math]\displaystyle{ q }[/math]中的微型状态[math]\displaystyle{ \mathbf{x}_t }[/math]和宏观状态[math]\displaystyle{ \mathbf{y}_t }[/math])。该定理指出,随着[math]\displaystyle{ q }[/math]减小,编码器部分的互信息必然减小,且对信息限制[math]\displaystyle{ I( \mathbf{x}_t ; \hat{\mathbf{x}}_{t+1}) \simeq I(\mathbf{x}_t ; \mathbf{x}_{t+1}) }[/math]更封闭。因此,整个信道将更加狭窄,编码器必须携带更有用和有效的信息才能转移到宏观动力学,预测变得更加困难。

数值实验

在几个数据集上测试NIS(所有数据均由模拟动力学模型生成)。此测试还包括连续动力学和离散马尔可夫动力学。

带测量噪声的弹簧振荡器

振荡器符合如下动力学方程组:

-

[math]\displaystyle{ \begin{cases} dz/dt = v \\ dv/dt = -z \end{cases} }[/math]

(26)

其中[math]\displaystyle{ z }[/math]和[math]\displaystyle{ v }[/math]分别是振荡器的一维位置与速度。定义系统状态[math]\displaystyle{ \mathbf{x} = (z,v) }[/math]。

实验数据仅由两个带误差的传感器获得。假设观测模型为

-

[math]\displaystyle{ \begin{cases} \tilde{\mathbf{x}}_1 = \mathbf{x} + \xi \\ \tilde{\mathbf{x}}_2 = \mathbf{x} - \xi \\ \end{cases} }[/math]

(27)

其中[math]\displaystyle{ \xi \sim \mathcal{N}(0,\sigma) }[/math] 是符合二维高斯分布的随机数值,[math]\displaystyle{ \sigma }[/math] 是位置与速度标准差的向量。将状态[math]\displaystyle{ \mathbf{x} }[/math]理解为潜在宏观状态,测量微观状态[math]\displaystyle{ \tilde{\mathbf{x}}_1 }[/math],[math]\displaystyle{ \tilde{\mathbf{x}_2} }[/math]。 NIS从测量值中恢复潜在的宏观X。

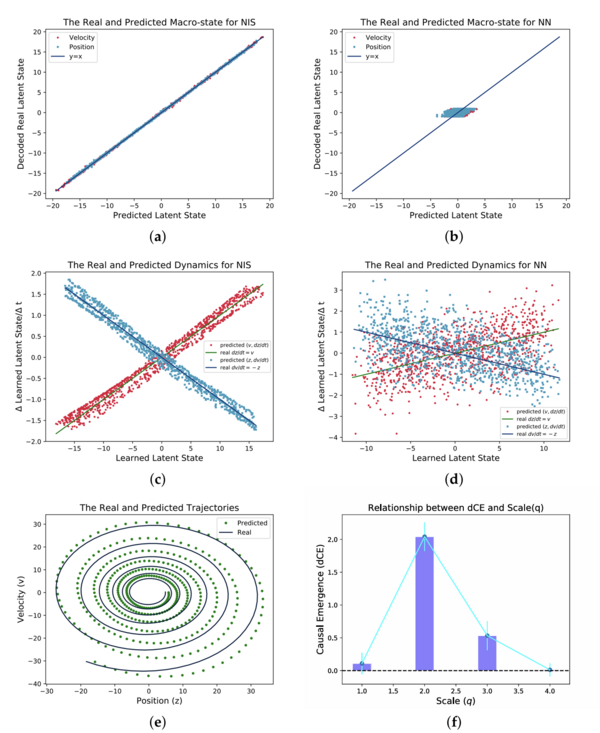

根据式27,影响状态测量的噪音可以通过叠加两通道的数据消除。因此,如果在NIS中输入两个测量值的宏观状态,则可简单地获得正确的动力学。使用Euler方法([math]\displaystyle{ dt = 1 }[/math])采样[math]\displaystyle{ 10,000 }[/math]批批次的数据,并在每个批次中生成100个随机初始状态并执行一个步骤动力学,求得下一个时间步长中的状态。使用这些数据来训练神经网络,同时使用相同的数据集来训练具有相同数量参数的普通前馈神经网络以作比较。 结果如图4所示。

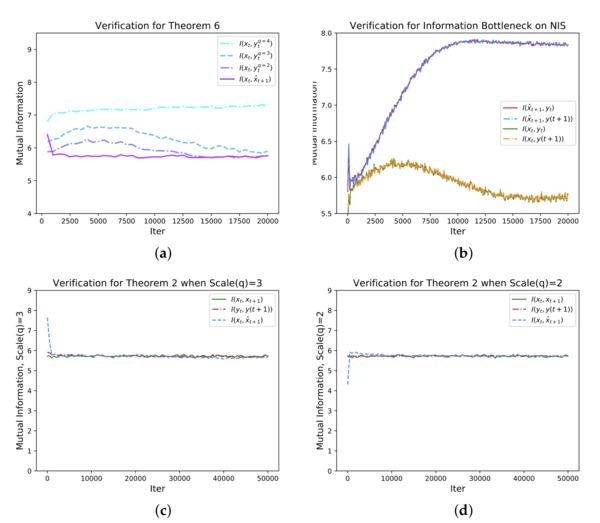

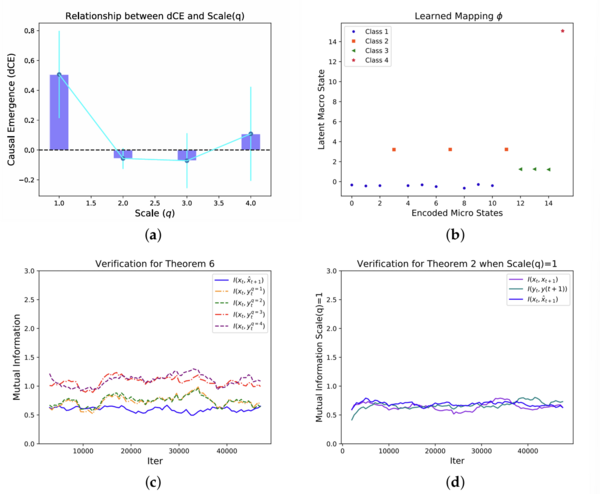

下一组实验结果验证4.1节中提到的定理和信息瓶颈理论。当 q 取不同值时,[math]\displaystyle{ I(\mathbf{x}_t,\mathbf{x}_{t+1}) }[/math]、[math]\displaystyle{ I(\mathbf{y}_t,\mathbf{y}_{t+1}) }[/math]和[math]\displaystyle{ I(\hat{\mathbf{x}}_t,\hat{\mathbf{x}}_{t+1}) }[/math]的互信息随迭代次数的变化情况,如图 5(c)(d)所示,其中所有的互信息的收敛均符合定理2、3。同时绘制不同 [math]\displaystyle{ q }[/math] 下的 [math]\displaystyle{ \mathbf{x}_t }[/math] 和 [math]\displaystyle{ \mathbf{y}_t }[/math] 之间的互信息来检验信道与互信息的关系。如图 5a所示,当 [math]\displaystyle{ q }[/math] 增加时,互信息增加。

根据信息瓶颈理论[15],在训练初期潜变量和输出之间的互信息可能会增加,且输入和潜变量之间的信息必然在增加后随着训练过程的进行而减少。NIS 模型证实了这一结论(图5b),其中宏观状态 yt 和预测 y(t +1) 都是潜变量。由于 [math]\displaystyle{ \mathbf{y}_t }[/math] 和 [math]\displaystyle{ \mathbf{y}(t+1) }[/math] 是瓶颈,而所有其他无关信息都被变量 [math]\displaystyle{ \mathbf{x}''_t }[/math] 弃用,在得到相同结论的情况下,NIS 模型的架构可以比一般的神经网络更清楚地反映信息瓶颈(图3)。

简单马尔可夫链

本案例展示NIS作用于离散马尔可夫链、粗粒化策略可以作用于状态空间的过程。生成数据的马尔可夫链是以下概率转移矩阵:

-

[math]\displaystyle{ \begin{pmatrix} 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 0 \\ 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 0 \\ 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 0 \\ 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 0 \\ 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 0 \\ 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 0 \\ 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 1/7 & 0 \\ 0 & 0 & 0 & 0 & 0 & 0 & 0 & 1 \\ \end{pmatrix} }[/math]

(28)

该系统有 8 个状态,其中 7之间 个可以相互转移,最后一个状态是独立的。使用一个 one-hot 向量编码状态(例如状态2将表示为 (0,1,0,0,0,0,0,0))。对初始状态进行50,000个批次的采样以生成数据,然后将 one-hot 向量输入 NIS 框架,经过50,000个迭代轮次的训练后可以得到一个有效的模型。结果如图 6 所示。

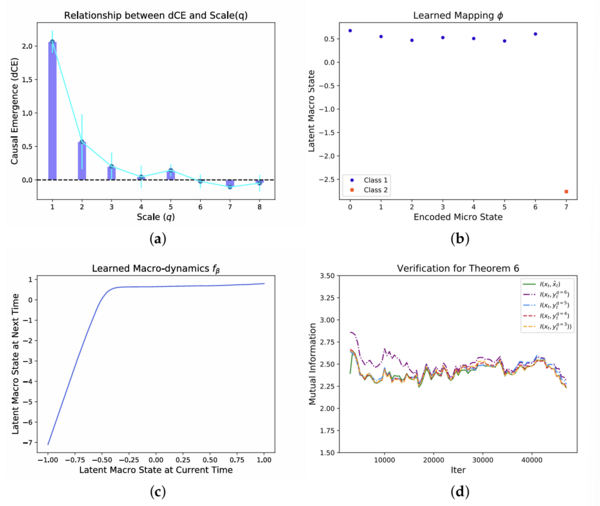

通过系统地搜索不同的 [math]\displaystyle{ q }[/math] 可以发现维度平均因果涌现(dCE)在 [math]\displaystyle{ q=1 }[/math] 处达到峰值(图 6a)。可以通过图 6b 可视化在最佳尺度上的粗粒化策略,其中 [math]\displaystyle{ x }[/math] 坐标是不同状态的十进制编码,[math]\displaystyle{ y }[/math] 坐标表示宏观状态的编码。粗粒化映射成功地将前七个状态分类为一个宏观状态,同时保持最后一个状态不变。这种学习到的粗粒化策略与文献[12]中的示例相同。

将学习到的宏观动力学可视化(图 6c)。 [math]\displaystyle{ y_t \lt 0 }[/math] 时宏观动力学是一个线性映射,[math]\displaystyle{ y_t \gt 0 }[/math] 时它可被视为一个常数。因此,该动力学可以保证所有前七个微观状态都可以与最后一个状态分离。图6d验证了信息压缩的信息瓶颈定理,即宏观动力学 [math]\displaystyle{ f_{\phi_q} }[/math] 的互信息与整个动力学模型相同。

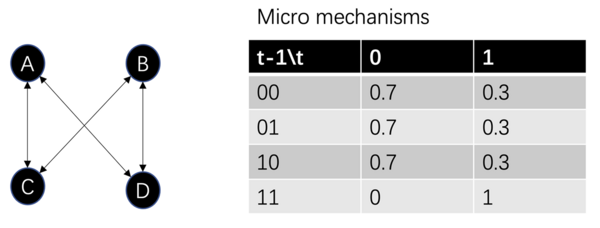

简单布尔网络

布尔网络是离散动力系统的典型例子,其中每个节点有两种可能的状态(0 或 1),且节点状态受其相邻节点状态的影响。该网络的微观机制如下:上图是一个包含四个节点的布尔网络的示例,每个节点的状态受到其相邻节点状态组合的概率影响,具体概率见上图中的表格。将所有节点的机制结合后,可以得到一个具有 [math]\displaystyle{ 2^4 = 16 }[/math] 个状态的大型马尔可夫转移矩阵。

通过对整个网络进行 50,000 次状态转换的采样,将这些数据输入 NIS 模型。通过系统搜索不同的 [math]\displaystyle{ q }[/math] 值,发现维度平均因果涌现峰值出现在 q = 1 处(上图a部分)。可视化结果显示出粗粒化策略(上图b部分),其中 [math]\displaystyle{ x }[/math] 坐标是微观状态的十进制编码,[math]\displaystyle{ y }[/math] 坐标表示宏观状态的编码。数据点根据其 [math]\displaystyle{ y }[/math] 值可以清晰地分为四个簇,这表明 NIS 网络发现了四个离散的宏观状态。16 个微观状态与四个宏观状态之间存在一一对应关系。然而,NIS 算法在处理此问题时并不知道任何先验信息,包括节点分组方法、粗粒化策略和动力学信息。这个示例验证了信息瓶颈理论(NIS中宏观动力学 [math]\displaystyle{ f_{\phi_q} }[/math] 的互信息与整个动力学模型相同)与信道互信息之间的关系(上图c, d部分)。

有效信息的度量

本部分在有效信息词条的5.2节中有详细描述,为NIS框架解决的问题之一。

对于前馈神经网络, 其EI的计算有一些不合理之处:首先EI的计算结果将会受到L的严重影响;其次,如果计算归一化的EI,即Eff,那么会遇到一个问题:对于连续变量来说,其状态空间的元素个数为无穷多个,如果直接使用,势必会引入无穷大量。

此问题的解决方案是,用状态空间维数来归一化EI,从而解决连续状态变量上的EI比较问题,这一指标被称为维度平均的有效信息(Dimension Averaged Effective Information,简称dEI)。在离散的状态空间中,维度平均的EI和有效性指标(Eff)实际上是等价的。在这一定义中L并未消失,但在计算维度平均的因果涌现时,尽管在期望中仍然隐含地包含L,但所有显含L的项就都被消失了。这就展示出来引入维度平均EI的一定的合理性。

总结与展望

NIS的优点

NIS(神经信息压缩器)是一种新的神经网络框架,可被用于发现时间序列数据中的粗粒化策略、宏观动力学和涌现的因果关系。NIS中可逆神经网络的使用通过在编码器和解码器之间共享参数来减少参数数量,且使得分析 NIS 架构的数学特性更加方便。通过约束粗粒化策略来预测具有精度阈值的未来微观状态,从而定义有效的粗粒化策略和宏观动力学,并推出因果涌现识别问题可以理解为在约束条件下最大化有效信息的问题。

NIS的缺点

NIS框架的弱点如下。

- 由于可逆神经网络很难在大数据集上训练,它只能在小数据集上工作,目前的数值实验也集中在弹簧振子和简单布尔网络等环境下;

- 该框架仍然缺乏可解释性[16];

- NIS并未真正地最大化有效信息;

- 该模型可预测的条件分布仅限于高斯或拉普拉斯分布。

未来展望:NIS+框架

为解决这些问题,从NIS框架出发提出NIS+框架。在NIS的基础上,NIS+框架运用了重加权技术,添加了反向动力学、由此产生一个新的损失函数,并对两个损失函数进行加权。其中,新的损失函数产生于神经网框架中添加的部分:通过对[math]\displaystyle{ t+1 }[/math]时刻再次编码,在宏观上来训练一个反向动力学来去预测[math]\displaystyle{ t }[/math]时刻的一个[math]\displaystyle{ \hat{y}(t) }[/math]。将新的损失函数与NIS框架中原有的损失函数加权,可以最大化有效信息的变分下界,解决了NIS框架无法直接最大化EI的问题。

参考文献

- ↑ Hoel, E.P.; Albantakis, L.; Tononi, G. Quantifying causal emergence shows that macro can beat micro. Proc. Natl. Acad. Sci. USA 2013, 110, 19790–19795.

- ↑ Rosas, F.E.; Mediano, P.A.M.; Jensen, H.J.; Seth, A.K.; Barrett, A.B.; Carhart-Harris, R.L.; Bor, D. Reconciling emergences: An information-theoretic approach to identify causal emergence in multivariate data. PLoS Comput. Biol. 2020, 16, e1008289.

- ↑ Silver, D.; Schrittwieser, J.; Simonyan, K.; Antonoglou, I.; Huang, A.; Guez, A.; Hubert, T.; Baker, L.; Lai, M.; Bolton, A.; et al. Mastering the game of Go without human knowledge. Nature 2017, 550, 354–359.

- ↑ LeCun,Y.; Bengio, Y.; Hinton, G. Deep learning. Nature 2015, 521, 436–444.

- ↑ Reichstein, M.; Camps-Valls, G.; Stevens, B.; Jung, M.; Denzler, J.; Carvalhais, N. Deep learning and process understanding for data-driven Earth system science. Nature 2019, 566, 195–204.

- ↑ Senior, A.W.; Evans, R.; Jumper, J.; Kirkpatrick, J.; Sifre, L.; Green, T.; Qin, C.; Žídek, A.; Nelson, A.W.R.; Bridgland, A.; et al. Improved protein structure prediction using potentials from deep learning. Nature 2020, 577, 706–710.

- ↑ Beckers, S.; Eberhardt, F.; Halpern, J.Y. Approximate Causal Abstraction. arXiv 2019, arXiv:1906.11583v2.

- ↑ Li, S.H.; Wang, L. Neural Network Renormalization Group. Phys. Rev. Lett. 2018, 121, 260601.

- ↑ Hu,H.; Wu,D.; You, Y.Z.; Olshausen, B.; Chen, Y. RG-Flow: A hierarchical and explainable flow model based on renormalization group and sparse prior. Mach. Learn. Sci. Technol. 2022, 3, 035009.

- ↑ Teshima, T.; Ishikawa, I.; Tojo, K.; Oono, K.; Ikeda, M.; Sugiyama, M. Coupling-based invertible neural networks are universal diffeomorphism approximators. Adv. Neural Inf. Process. Syst. 2020, 33, 3362–3373.

- ↑ Teshima, T.; Tojo, K.; Ikeda, M.; Ishikawa, I.; Oono, K. Universal approximation property of neural ordinary differential equations. arXiv 2017, arXiv:2012.02414.

- ↑ 12.0 12.1 Dinh, L.; Sohl-Dickstein, J.; Bengio, S. Density estimation using real nvp. arXiv 2016, arXiv:1605.08803.

- ↑ Kingma, D.P.; Welling, M. Auto-encoding variational bayes. arXiv 2013, arXiv:1312.6114.

- ↑ Shwartz-Ziv, R.; Tishby, N. Opening the black box of deep neural networks via information. arXiv 2017, arXiv:1703.00810.

- ↑ Shwartz-Ziv, R.; Tishby, N. Opening the black box of deep neural networks via information. arXiv 2017, arXiv:1703.00810.

- ↑ Williams, P.L.; Beer., R.D. Nonnegative decomposition of multivariate information. arXiv 2017, arXiv:1004.2515.

编者推荐

下面是一些链接能够帮助读者更好的了解NIS的相关信息:

因果涌现读书会

文章推荐

- Zhang, J.; Liu, K. Neural Information Squeezer for Causal Emergence. Entropy 2023, 25, 26.

路径推荐

- 张江老师根据因果涌现读书会第一季梳理的关于因果涌现的学习路径:https://pattern.swarma.org/article/153

- 张江老师根据因果涌现前五季读书会整理的因果涌现入门路径:https://pattern.swarma.org/article/296

此词条由因果涌现第五季读书会词条梳理志愿者刘佳睿编撰,未经专家审核,带来阅读不便,请见谅。