有效信息

有效信息(Effective Information,简称EI)是因果涌现 Causal Emergence理论中的一个核心概念,它可以用来衡量一个马尔科夫动力学的因果效应的强度。这里,因果效应是指这个系统的上一时刻状态的概率分布是如何通过动力学对下一个时刻的状态分布产生影响的。具体地,这种因果效应可以通过强制干预系统处于上一时刻的状态分布为均匀分布,从而观察系统经由动力学的作用产生的下一时刻的状态分布是什么,那么在这种干预下,上一时刻和下一时刻状态分布之间的互信息就被定义为有效信息。尽管在有效信息的定义中引入了干预操作,但是本质上这是一种假想的干预,目的是为了切断因果度量与状态本身分布的联系,从而刻画出系统的动力学特性。另外,有效信息通常可以分解为两个部分:确定性(Determinism)和简并性(Degeneracy)。确定性是指,在动力学的作用下,我们根据系统前一时刻的状态会以多大程度预测它的下一时刻状态;简并性是指:我们能够以多大程度从下一时刻的状态预测上一时刻的状态。如果确定性越大,简并性越小,则系统的有效信息就会越大。在本页中,所有的[math]\log[/math]都表示以2为底的对数运算。

历史渊源

有效信息(effective informaion,EI)这个概念最早由Giulio Tononi等人在2003年提出[1],作为整合信息论中的一个关键指标。当一个系统各个组分之间具有很强的因果关联的时候,可以说这个系统便具备很高的整合程度,而有效信息:EI,便是用来度量这种因果关联程度的关键指标。

到了2013年,Giulio Tononi的学生Erik Hoel等人将有效信息这个概念进一步提炼出来,从而定量地刻画涌现,于是提出了因果涌现理论[2]。在这个理论中,Hoel使用了Judea Pearl的do算子来改造一般的互信息指标[3],这使得EI本质上与互信息不同。互信息度量的是相关性,而有效信息因为引入了do算子,从而可以度量因果性。在这一文章中,作者们同时提出了归一化的有效信息指标Eff。

然而,传统的EI主要被用于具有离散状态的马尔科夫链上。为了能扩充到一般的实数域,P. Chvykov和E. Hoel于2020年合作提出了因果几何理论[4],将EI的定义扩充到了具备连续状态变量的函数映射上,并通过结合信息几何理论,探讨了EI的一种微扰形式,并与Fisher信息指标进行了比较,提出了因果几何的概念。然而,这一连续变量的EI计算方法需要假设方程中的正态分布随机变量的方差是无限小的,这一要求显然过于苛刻了。

到了2022年,为了解决一般前馈神经网络的EI计算问题,张江与刘凯威又将因果几何中的连续变量的EI计算方法的方差限制去掉,探讨了EI的更一般形式[5]。然而,这种扩充仍然存在着一个缺陷,由于实数域上变量的均匀分布严格讲是定义在无穷大空间上的,为了避免遭遇无穷大,EI的计算中就会带着一个参数[math]L[/math],表示均匀分布的区间范围。为了避免这个缺陷,也为了在不同粗粒化程度上比较EI,作者们便提出了维度平均EI的概念,并发现由维度平均EI定义的因果涌现度量是一个仅与神经网络的雅可比矩阵的行列式对数值期望与两个比较维度的随机变量方差有关的量,而与其它参量,如L无关,而且,维度平均EI也可以看作是一种归一化的EI,即Eff。

本质上讲,EI仅仅与一个马尔科夫动力系统的动力学——也就是有关马尔科夫状态转移矩阵有关,而与状态变量的分布无关,然而,这一点在之前的文章中并没有被指出或刻意强调。在2024年的袁冰等人的综述文章,作者们进一步强调了这一点,并给出了EI仅依赖于马尔科夫状态转移矩阵的显式形式[6]。张江等人在最新的讨论动力学可逆性与因果涌现的文章中,又指出EI实际上是对底层马尔科夫状态转移矩阵的可逆性的一种刻画,于是尝试直接刻画这种马尔科夫链的动力学可逆性以替代EI[7]。

简介

有效信息(EI)指标主要用来度量马尔科夫动力学的因果效应强度。与一般的因果度量指标不同,EI主要用于动力学(马尔科夫的转移概率矩阵)已知,且不存在未知变量即混杂因子的情况。其核心目标是度量因果关联强度,而并非是否存在因果效应。也就是说,EI更适用于已经确知了因果变量X和Y之间存在着因果联系的场合。

更正式地,EI是因果机制(在离散状态的马尔科夫链中,是这个马尔科夫链的概率转移矩阵)的函数,而与其它因素无关。EI的正式定义为:

[math]\displaystyle{ EI(P)\equiv I(Y;X|do(X\sim U)) }[/math]

这里,X是因变量,Y是果变量,[math]do(X\sim U)[/math]表示对因变量X进行do干预,将X的分布变为均匀分布,P代表X到Y的因果机制,它是一个概率转移矩阵,即[math]p_{ij}\euiv Pr(Y=j|X=i)[/math]。在这一干预下,同时假设X到Y的因果机制P保持不变,那么,Y就会间接地受到X的do干预的影响而发生变化。则EI度量的是经过干预后的X和Y之间的互信息。

之所以引入do操作,目的是为了消除数据X的分布对EI的影响,以使得最后的EI度量仅仅是因果机制f的函数,而与数据X无关。

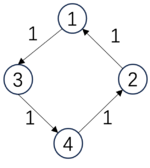

下面,给出三个马尔科夫链的例子,以及相应的EI数值也放到了下面:

|

[math]\displaystyle{ P_1=\begin{pmatrix} 0 &0 &1 &0& \\ 1 &0 &0 &0& \\ 0 &0 &0 &1& \\ 0 &1 &0 &0& \\ \end{pmatrix} }[/math], |

[math]\displaystyle{ P_2=\begin{pmatrix} &1/3 &1/3 &1/3 &0& \\ &1/3 &1/3 &1/3 &0& \\ &1/3 &1/3 &1/3 &0& \\ &0 &0 &0 &1& \\ \end{pmatrix} }[/math], |

[math]\displaystyle{ P_3=\begin{pmatrix} &0 &0 &1 &0& \\ &1 &0 &0 &0& \\ &1 &0 &0 &0& \\ &1 &0 &0 &0& \\ \end{pmatrix} }[/math]. |

| [math]\begin{aligned}&EI(P_1)=2\ bits,\\&Det(P_1)=2\ bits,\\&Deg(P_1)=0\ bits\end{aligned}[/math] | [math]\begin{aligned}&EI(P_2)=0.81\ bits,\\&Det(P_2)=0.81\ bits,\\&Deg(P_2)=0\ bits\end{aligned}[/math] | [math]\begin{aligned}&EI(P_3)=0.81\ bits\\&Det(P_3)=2\ bits,\\&Deg(P_3)=1.19\ bits.\end{aligned}[/math] |

-

(example)

我们可以看到,第一个矩阵[math]P_1[/math]的EI比第二个[math]P_2[/math]的高,这是因为这一概率转移是一个完全确定性的转移,也就是从某一个状态出发,它会以100%的概率转移到另一个状态。然而,并不是所有的确定性转移的矩阵都会对应较大的EI,比如[math]P_3[/math]这个矩阵,虽然它的转移概率也都是100%,但是因为所有后面三种状态都会转移到第1个状态,因此我们将无法区分它上一时刻是处于何种状态的。因此这种情况下它的EI也会比较低。我们称后一种情况存在着简并性。因此,如果一个转移矩阵具有较高的确定性和较低的简并性,则它的EI就会很高。进一步,存在如下对EI的分解:

[math]\displaystyle{ EI=Det-Deg }[/math]

这里,Det是对确定性(Determinism)的缩写,而Deg是对简并性(Degeneracy)的缩写,EI是二者之差。在上面的表格中,我们将矩阵所对应的Det和Deg数值也都列在了下面。

第一个转移概率矩阵是一个置换排列矩阵(Permutation),它是可逆的,因此确定性最高,没有简并性,因而EI最大;第二个矩阵的前三个状态都会以1/3的概率跳转到彼此,因此确定性程度最低,而简并性也很低,EI是0.81;第三个矩阵虽然也是确定性的矩阵,因而确定性最高,但是由于后三个状态都跳转到1,因此,从1状态不能推知它来自于哪个状态,因此简并性最高,最终的EI与第二个相同,仍然是0.81。

下面,我们将进行更详细地讲解。

Do形式及解释

原始的有效信息是定义在离散的马尔科夫链上的。然而,为了能够更广泛地应用,在这里我们探讨有效信息的更一般的形式。

形式定义

考虑两个随机变量:[math]X[/math]和[math]Y[/math],分别代表因变量(Cause Variable)和果变量(Effect Variable),并且假定它们的取值区间分别是[math]\mathcal{X}[/math]和[math]\mathcal{Y}[/math]。同时,[math]X[/math]是通过因果机制[math]f[/math]影响[math]Y[/math]的。所谓的因果机制是指在给定[math]X[/math]取值[math]x\in \mathcal{X}[/math]的情况下,[math]Y[/math]在[math]\mathcal{Y}[/math]上取任意值[math]y\in \mathcal{Y}[/math]的条件概率:

[math]\displaystyle{ f\equiv Pr(Y=y|X=x) }[/math]

则针对这个因果机制[math]f[/math],它所对应的有效信息EI的定义为:

[math]\displaystyle{

EI\equiv I(X:Y|do(X\sim U(\mathcal{X})))=I(\tilde{X}:\tilde{Y})

}[/math]

这里,[math]do(X\sim U(\mathcal{X}))[/math]代表对[math]X[/math]实施do干预(或称do操作),使其服从[math]\mathcal{X}[/math]上的均匀分布[math]U(\mathcal{X})[/math],也即是最大熵分布。[math]\tilde{X}[/math]与[math]\tilde{Y}[/math]分别代表在经过[math]do[/math]干预后的[math]X[/math]和[math]Y[/math]变量,其中,

[math]\displaystyle{ Pr(\tilde{X}=x)=\frac{1}{\#(\mathcal{X})}, }[/math]

也就是,经过干预后的变量[math]X[/math]与干预前的变量[math]\tilde{X}[/math]之间的最大区别就在于分布不同:[math]\tilde{X}[/math]服从[math]\mathcal{X}[/math]上的均匀分布,而[math]X[/math]则可能是任意的分布。这里[math]\#(\mathcal{X})[/math]代表集合[math]\mathcal{X}[/math]的基数。对于有限元素集合来说,这就是集合中元素的个数。

在这个干预中,我们要始终保持因果机制[math]f[/math]不变,这就会导致[math]Y[/math]的概率分布发生变化,即被间接干预成为:

[math]\displaystyle{ Pr(\tilde{Y}=y)=\sum_{x\in \mathcal{X}}Pr(X=x) Pr(Y=y|X=x)=\sum_{x\in \mathcal{X}} \frac{Pr(Y=y|X=x)}{\#(\mathcal{X})}. }[/math]

其中,[math]\tilde{Y}[/math]则代表:在保持因果机制[math]f[/math]不变的情况下,[math]Y[/math]变量被[math]X[/math]的do干预所间接改变的变量,这种变化主要体现在概率分布的变化上。

因此,所谓一个因果机制[math]f[/math]的有效信息EI,就是被干预后的因变量[math]\tilde{X}[/math]和果变量[math]\tilde{Y}[/math]之间的互信息。

为什么要使用do算子?

不难看出,尽管EI本质上就是互信息,但是与传统信息论中的互信息不同,有效信息EI在定义中包含了do操作,即对输入变量做了一个干预操作。为什么要引入这一操作呢?

根据Judea Pearl的因果阶梯理论[3],即变量之间的因果联系可以被划分为三种层次:关联-干预-反事实。阶梯层级越高,因果特征越明显。直接对观测数据估测互信息,便是在度量关联程度;而如果我们能对变量做干预操作,即设定变量为某个值或服从某个分布,便上升到了干预的层级。在EI的定义中引入了[math]do[/math]操作,则使得EI能够比互信息更能体现因果特征。

而从实际意义上来讲,在EI的计算中引入do算子,则可以把数据和动力学分开,从而消除数据分布(即[math]X[/math]的分布)对EI度量所带来的影响。事实上,在一般的因果图上,do算子是一种消除指向被干预变量所有的因果箭头的操作,这种操作可以避免混杂因子造成的虚假关联。因此,EI定义中的do算子也可以消除所有指向因变量[math]X[/math]的因果箭头,包括其它变量(包括不可观测的变量)对[math]X[/math]的影响,从而使得EI更能够刻画动力学本身的特性。

do算子的引入让EI这个指标与其他信息度量指标截然不同,关键在于它是且仅是因果机制的函数,一方面这一特性使得它比其他指标(比如转移熵)更能抓住因果概念的本质,另一方面它需要我们能够已知或获取到因果机制,这在只有观测数据的情况下存在一定的困难。

为什么干预成均匀分布?

在Erik Hoel的原始定义中,do操作是将因变量[math]X[/math]干预成了在其定义域[math]\mathcal{X}[/math]上的均匀分布(也就是最大熵分布)[2][8]。那么, 为什么要干预成均匀分布呢?其它分布是否也可以?

首先,根据上一小节的论述,do操作的实质是希望让EI能够更清晰地刻画因果机制[math]f[/math]的性质,因此,需要切断因变量[math]X[/math]与其它变量的联系,并改变其分布,让EI度量与[math]X[/math]的分布无关。

而之所以要把输入变量干预为均匀分布,其实就是要更好地刻画因果机制的特性。为什么呢?

当[math]\mathcal{X}[/math]和[math]\mathcal{Y}[/math]都是有限可数集合的时候,因果机制[math]f\equiv Pr(Y=y|X=x)[/math]就成为了一个[math]\#(\mathcal{X})[/math]行[math]\#(\mathcal{Y})[/math]列的矩阵,我们可以展开EI的定义:

-

[math]\displaystyle{ \begin{aligned} EI &= I(X,Y|do(X)\sim U)= \sum_{x\in\mathcal{X}}\sum_{y\in\mathcal{Y}}Pr(X=x,Y=y)\log \frac{Pr(X=x,Y=y)}{Pr(X=x)Pr(Y=y)}\\ &= \sum_{x\in\mathcal{X}}\sum_{y\in\mathcal{Y}}Pr(X=x)Pr(Y=y|X=x)\log \frac{Pr(Y=y|X=x)}{Pr(Y=y)}\\ &= \sum_{x\in\mathcal{X}}\sum_{y\in\mathcal{Y}}Pr(X=x)Pr(Y=y|X=x)\log Pr(Y=y|X=x)- \sum_{x\in\mathcal{X}}\sum_{y\in\mathcal{Y}}Pr(X=x)Pr(Y=y|X=x)Pr(Y=y) \\ &=\frac{1}{\#(\mathcal{X})}\left(-\sum_{x\in\mathcal{X}}H(Pr(Y|X)\right) + H(Pr(Y)) \end{aligned} }[/math]

(1)

不难看出,最后得到的等式告诉我们,EI实际上由两项构成,第一项是因果机制矩阵每一行的负熵的平均值,第二项则是变量[math]Y[/math]的熵。 在第一项中,[math]X[/math]的概率分布[math]Pr(X=x)[/math]实际上起到了对每一行的熵求平均时候的权重的作用。只有当我们将该权重取为同样的数值的时候,才能够平等地对待因果机制矩阵中的每一个行,这时就恰好是将[math]X[/math]干预成均匀分布的时候。

如果不是均匀分布,也就意味着某些行的熵就会被乘以一个较大的权重,有的行就会被赋予一个较小的权重,这种权重代表了某种“偏见”,因此也就不能做到让EI能够反映因果机制的天然属性。

马尔科夫链的有效信息

马尔科夫链简介

在本小节中,所有的马尔科夫转移概率矩阵都表示为[math]P[/math]。N为总的状态数量。

最早,Erik Hoel等人是在离散状态的马尔科夫动力学,即马尔科夫链上提出有效信息这一度量因果性的指标的。因此,这一节中,我们介绍有效信息在马尔科夫链上的特殊形式。

所谓的马尔科夫链是指状态离散、时间离散的一种平稳随机过程,它的动力学一般都可以用所谓的转移概率矩阵(Transitional Probability Matrix),简称TPM来表示,有时也叫做概率转移矩阵或状态概率转移矩阵或状态转移矩阵。

具体来讲,马尔科夫链包含一组随机变量[math]X_t[/math],它在状态空间[math]\mathcal{X}=\{1,2,\cdots,N\}[/math]上取值,其中[math]t[/math]往往表示时间。所谓的转移概率矩阵是指一个概率矩阵,其中第[math]i[/math]行,第[math]j[/math]列元素:[math]p_{ij}[/math]表示了系统在任意时刻[math]t[/math]在[math]i[/math]状态的条件下,在[math]t+1[/math]时刻跳转到[math]j[/math]状态的概率。同时,每一行满足归一化条件:

[math]\displaystyle{ \sum_{j=1}^Np_{ij}=1, }[/math]

状态转移矩阵可以看作是马尔科夫链的动力学,这是因为,任意时刻[math]t+1[/math]上的状态概率分布,即[math]Pr(X_t)[/math],可以被上一时刻的状态概率分布,即[math]Pr(X_t)[/math]和状态转移矩阵所唯一确定,并满足关系:

[math]\displaystyle{ Pr(X_{t+1}=j)=\sum_{i=1}^N p_{ij}\cdot Pr(X_t=i), }[/math]

这里的[math]i,j\in \mathcal{X}[/math]都是[math]\mathcal{X}[/math]中的任意状态,且[math]N=\#(\mathcal{X})[/math]即[math]\mathcal{X}[/math]中的总状态数。

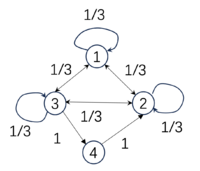

下表展示的是三个不同的转移概率矩阵,以及它们的EI数值:

| [math]\displaystyle{ P_1=\begin{pmatrix} &0 &0 &1 &0& \\ &1 &0 &0 &0& \\ &0 &0 &0 &1& \\ &0 &1 &0 &0& \\ \end{pmatrix} }[/math], |

[math]\displaystyle{ P_2=\begin{pmatrix} &1/3 &1/3 &1/3 &0& \\ &1/3 &1/3 &1/3 &0& \\ &0 &0 &0 &1& \\ &0 &0 &0 &1& \\ \end{pmatrix} }[/math], |

[math]\displaystyle{ P_3=\begin{pmatrix} &1/4 &1/4 &1/4 &1/4& \\ &1/4 &1/4 &1/4 &1/4& \\ &1/4 &1/4 &1/4 &1/4& \\ &1/4 &1/4 &1/4 &1/4& \\ \end{pmatrix} }[/math]. |

| [math]EI(P_1)=2[/math] bits | [math]EI(P_2)=1[/math] bits | [math]EI(P_3)=0[/math] bits |

这三个马尔科夫链的状态空间都是[math]\mathcal{X}=\{1,2,3,4\}[/math],因此它们的TPM的大小都是[math]4\times 4[/math]。

马尔科夫链的EI

在马尔科夫链中,任意时刻的状态变量[math]X_t[/math]都可以看作是原因,而下一时刻的状态变量[math]X_{t+1}[/math]就可以看作是结果,这样马尔科夫链的状态转移矩阵就是它的因果机制。因此,我们可以将有效信息的定义套用到马尔科夫链上来。

[math]\displaystyle{

\begin{aligned}

EI &= I(X_t,X_{t+1}|do(X_t)\sim U(\mathcal{X}))=I(\tilde{X}_t,\tilde{X}_{t+1}) \\

&= \sum^N_{i=1}\sum^N_{j=1}Pr(\tilde{X}_t=i,\tilde{X}_{t+1}=j)\log \frac{Pr(\tilde{X}_t=i,\tilde{X}_{t+1}=j)}{Pr(\tilde{X}_t=i)Pr(\tilde{X}_{t+1}=j)}\\

&= \sum^N_{i=1}Pr(\tilde{X}_t=i)\sum^N_{j=1}Pr(\tilde{X}_{t+1}=j|\tilde{X}_t=i)\log \frac{Pr(\tilde{X}_{t+1}=j|\tilde{X}_t=i)}{Pr(\tilde{X}_{t+1}=j)}\\

&= \frac{1}{N}\sum^N_{i=1}\sum^N_{j=1}p_{ij}\log\frac{N\cdot p_{ij}}{\sum_{k=1}^N p_{kj}}

\end{aligned}

}[/math]

其中[math]\displaystyle{ \tilde{X}_t,\tilde{X}_{t+1} }[/math]分别为把t时刻的[math]X_t[/math]干预为均匀分布后,前后两个时刻的状态。[math]\displaystyle{ p_{ij} }[/math]为第i个状态转移到第j个状态的转移概率。从这个式子,不难看出,EI仅仅是概率转移矩阵[math]P[/math]的函数。

马尔科夫链EI的向量形式

我们也可以将转移概率矩阵[math]P[/math]写成[math]N[/math]个行向量拼接而成的形式,即:

[math]\displaystyle{ P=(P_1,P_2,\cdots,P_N)^T }[/math]

其中,[math]P_i[/math]矩阵[math]P[/math]的第[math]i[/math]个行向量,且满足条件概率的归一化条件:[math]||P_i||_1=1[/math],这里的[math]||\cdot||_1[/math]表示向量的1范数。那么EI可以写成如下的形式:

-

[math]\displaystyle{ \begin{aligned} EI &= \frac{1}{N}\sum^N_{i=1}\sum^N_{j=1}p_{ij}\log\frac{N\cdot p_{ij}}{\sum_{k=1}^N p_{kj}}\\ &=\frac{1}{N}\cdot \sum_{i=1}^N\left(P_i\cdot \log P_i - P_i\cdot\log \bar{P}\right)\\ &=\frac{1}{N}\sum_{i=1}^N D_{KL}(P_i||\bar{P}) \end{aligned} }[/math]

(2)

将矩阵每列求均值,可得到平均转移向量[math]\displaystyle{ \overline{P}=\sum_{k=1}^N P_k/N }[/math]。[math]D_{KL}[/math]便是两个分布的KL散度。因此,EI是转移矩阵每个行转移向量[math]P_i[/math]与平均转移向量[math]\bar{P}[/math]的KL散度的均值。

针对上面所列的三个状态转移矩阵,我们可以分别求出它们的EI为:2比特、1比特和0比特。由此可见,如果转移概率矩阵中出现更多的0或1,也就是行向量多是独热向量(也叫做one-hot向量,即某一个位置为1,其它位置为0的向量),则EI值就会更大。也就是说,如果在状态转移的过程中,从某一时刻到下一时刻的跳转越确定,则EI值就会倾向于越高。但是,这个观察并不十分精确,更精确的结论由后面的小节给出。

归一化

显然,EI的大小和状态空间大小有关,这一性质在我们比较不同尺度的马尔科夫链的时候非常不方便,我们需要一个尽可能不受尺度效应影响的因果效应度量。因此,我们需要对有效信息EI做一个归一化处理,得到和系统尺寸无关的一个量化指标。

根据Erik Hoel和Tononi等人的工作,要用均匀分布即最大熵分布下的熵值,即[math]\displaystyle{ \log N }[/math]来做分母对EI进行归一化,这里的[math]N[/math]为状态空间[math]\mathcal{X}[/math]中的状态的数量[2]。那么归一化后的EI便等于:

[math]\displaystyle{ Eff=\frac{EI}{\log N} }[/math]

进一步定义归一化指标也称为有效性(effectiveness)。

然而,在处理连续状态变量的时候,这种使用状态空间中状态数量的对数值进行归一化的处理方式并不是非常合适,因为这一状态数往往收到变量的维度和实数分辨率的影响。

确定性和简并性

EI的分解

根据公式1,我们发现,EI实际上可以被分解为两项,即:

[math]\displaystyle{ \begin{aligned} EI&=\frac{1}{\#(\mathcal{X})} (-\sum_{x\in\mathcal{X}}H(Pr(Y|X)) + H(Pr(Y))\\ \end{aligned} }[/math]

同样,在马尔科夫链的情景下,EI也可以做这样的分解:

[math]\displaystyle{ \begin{aligned} EI &= \frac{1}{N}\cdot \sum_{i=1}^N\left(P_i\cdot \log P_i - P_i\cdot\log \bar{P}\right)\\ &=\underbrace{-\langle H(P_i)\rangle}_{确定性项}+\underbrace{H(\bar{P})}_{非简并性项} \end{aligned} }[/math]

其中,第一项:[math]-\langle H(P_i)\rangle\equiv \frac{1}{N}\sum_{i=1}^N H(P_i)[/math]为每个行向量[math]P_i[/math]的负熵的平均值,它刻画了整个马尔科夫转移矩阵的确定性(determinism);

第二项:[math]H(\bar{P})[/math]为平均行向量的熵,其中[math]\bar{P}\equiv \frac{1}{N}\sum_{i=1}^N P_i [/math]为所有N个行向量的平均行向量,它刻画了整个马尔科夫转移矩阵的非简并性或非退化性(non-degeneracy)。

确定性与简并性

然而上述定义中的确定性项和非简并性都是负数,为此,我们重新定义一个马尔科夫链转移矩阵P的确定性为:

[math]\displaystyle{ Determinism \equiv \log N - \langle H(P_i)\rangle = \frac{1}{N}\sum_{i=1}^N \sum_{j=1}^N p_{ij}\log \left(N\cdot p_{ij}\right) }[/math]

这一项是一个平均的负熵,为了防止其为负数,所以加上了[math]\log N[/math]引用错误:没有找到与</ref>对应的<ref>标签。这两个基本要素被称为“因果元语”(Causal Primatives),分别是“充分性”和“必要性”。

因果元语的定义

[math]\displaystyle{ \begin{aligned} \text{充分性:}~~~&suff(e,c) = P(e|c) \\ \text{必要性:}~~~&nec(e,c) = 1 - P(e|C \backslash c) \end{aligned} }[/math]

其中[math]\displaystyle{

c

}[/math]和[math]\displaystyle{

e

}[/math]分别表示因事件(cause)和果事件(effect),[math]\displaystyle{

C

}[/math]表示因事件的全部集合,[math]\displaystyle{

C \backslash c

}[/math]则为因事件[math]\displaystyle{

c

}[/math]的补集,即[math]\displaystyle{

c

}[/math]之外的事件,也可记作[math]\displaystyle{

\lnot c

}[/math]。充分性表明当因发生时,果发生的概率,当[math]\displaystyle{

suff = 1

}[/math]时,因发生确定导致果发生;而必要性则衡量当因不发生时,果也不发生的概率;当[math]\displaystyle{

nec = 1

}[/math]时,因不发生则果一定不发生。

有些因果指标中的必要性表现为以下的变型形式,在此也给出定义:

[math]\displaystyle{ \begin{aligned} \text{必要性}' \text{:}~~~nec'(e,c) = 1 - P(e|C) \end{aligned} }[/math]

根据定义,当[math]\displaystyle{ c }[/math]为极小概率事件时,[math]\displaystyle{ nec(e,c) \approx nec^\dagger(e,c) }[/math]。当[math]\displaystyle{ C }[/math]为连续状态空间时,可认为两者等价。

注意:[math]\displaystyle{ nec' }[/math]的定义与文献[9]中定义的[math]\displaystyle{ nec^\dagger = P(e|C\backslash c) }[/math]不同,两者关系为[math]\displaystyle{ net' = 1 - nec^\dagger }[/math]。

因果元语与确定性和简并性

如前所述,EI可被分解为确定性与简并性两项,这两项分别对应充分性和必要性的因果元语表达:

[math]\displaystyle{ \begin{aligned} determinism = 1 - \frac{\log_2{\frac{1}{suff}}}{\log_2{N}} \\ degeneracy = 1 - \frac{\log_2{\frac{1}{1 - nec'}}}{\log_2{N}} \end{aligned} }[/math]

可以看到,充分性和确定性之间,以及必要性和简并性之间存在单调映射关系。充分性越高,确定性也越高;必要性越高,简并性则越小。

因果度量指标的因果元语表示

| 因果指标 | 概率定义 | 因果元语定义 | 参考文献 |

|---|---|---|---|

| 有效信息EI | [math]\displaystyle{ \log_2{\frac{P(e|c)}{P(e|C)}} }[/math] | [math]\displaystyle{ \log_2\frac{suff}{1 - nec'} }[/math] | [2] |

| Suppes度量 | [math]\displaystyle{ P(e|c) - P(e|C) }[/math] | [math]\displaystyle{ suff + nec' - 1 }[/math] | [10] |

| Galton度量 | [math]\displaystyle{ P(c)P(C\backslash c)(P(e|c) - P(e|C\backslash c)) }[/math] | [math]\displaystyle{ P(c)P(C\backslash c)(suff + nec - 1) }[/math] | [11] |

| Eells度量

(即Judea Pearl的充要概率PNS) |

[math]\displaystyle{ P(e|c) - P(e|C\backslash c) }[/math] | [math]\displaystyle{ suff + nec - 1 }[/math] | [3][12] |

| Cheng度量

(即Judea Pearl的充分概率PS) |

[math]\displaystyle{ \frac{P(e|c) - P(e|C\backslash c)}{1 - P(e|C\backslash c)} }[/math] | [math]\displaystyle{ \frac{suff + nec - 1}{nec} }[/math] | [3][13] |

| Lewis度量

(即Judea Pearl 的必要概率PN) |

[math]\displaystyle{ \frac{P(e|c) - P(e|C\backslash c)}{P(e|c)} }[/math] | [math]\displaystyle{ \frac{suff + nec - 1}{suff} }[/math] | [3][14] |

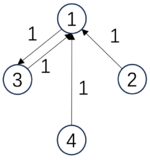

EI与动力学可逆性

正如示例example中的马尔科夫链所示,当概率转移矩阵呈现为一种排列置换矩阵(Permutation matrix)的时候,EI会更大。

可以证明,排列置换矩阵是唯一一种能同时满足如下两个条件的矩阵:

1、矩阵是可逆的; 2、矩阵满足马尔科夫链的归一化条件,也就是对于任意的[math]i\in[1,N][/math]来说,[math]|P_i|_1=1[/math]

我们将这一性质称为动力学可逆性。因此,从某种程度上说,EI衡量的是马尔科夫链的一种动力学可逆性。

需要注意的是,这里所说的马尔科夫链的动力学可逆性与通常意义下的马尔科夫链的可逆性是不等同的。前者的可逆性体现为马尔科夫概率转移矩阵的可逆性,也就是它针对状态空间中的每一个确定性状态的运算都是可逆的,所以也称其为动力学可逆的。但是,一般意义下的可逆的马尔科夫链并不要求转移矩阵是可逆的,而是要以稳态分布为时间反演对称的对称点,正向动力学运转下的状态分布与反向动力学运转下的状态分布完全一致,同时正反两种动力学都是在转移概率矩阵P下作用完成的。

由于排列置换矩阵过于特殊,我们需要能够衡量一般的马尔科夫概率转移矩阵与排列置换矩阵的靠近程度,以度量其近似动力学可逆性。在文献[7]中,作者们提出了一种用矩阵的Schatten范数来度量一个马尔科夫概率转移矩阵的近似动力学可逆性的方法,定义为:

[math]\displaystyle{ \Gamma_{\alpha}=\sum_{i=1}^N\sigma_i^{\alpha} }[/math]

这里,[math]\Gamma_{\alpha}[/math]为近似动力学可逆性指标,[math]\sigma_i[/math]为概率转移矩阵P的奇异值,并且按照从大到小的顺序排列,[math]\alpha\in(0,2)[/math]为一个指定的参数,它起到让[math]\Gamma_{\alpha}[/math]能够更多地反映确定性还是简并性这样一种权重或倾向性。事实上,不难看出,如果让[math]\alpha\rightarrow 0[/math],则[math]\Gamma_{\alpha}[/math]就退化成了矩阵P的秩,即:

[math]\displaystyle{ rank(P)=\sum_{i=1}^N\sigma_i^{0} }[/math]

而矩阵的秩衡量的是矩阵P非退化(也就是可逆)的程度,与Degeneracy有着类似的效果。

而当[math]\alpha\rightarrow 2[/math],则[math]\Gamma_{\alpha}[/math]就退化成了矩阵P的Frobinius范数的平方,即:

[math]\displaystyle{ ||P||_F^2=\sum_{i=1}^N\sigma_i^{2} }[/math] 这一指标衡量的是矩阵P的确定性的程度,这是因为只有当矩阵P中的所有行向量都是独热向量(one-hot)的时候,[math]||P||_F[/math]才会最大,因此它与Determinism有着类似的衡量效果。

所以,当[math]\alpha\in(0,2)[/math]连续变化的时候,[math]\Gamma_{\alpha}[/math]就可以在简并性与确定性二者之间切换。通常情况下,我们取[math]\alpha=1[/math],这可以让[math]\Gamma_{\alpha}[/math]能够在确定性与简并性之间达到一种平衡。

在文献[7]中,作者们证明了EI与动力学可逆性[math]\Gamma_{\alpha}[/math]之间存在着一种近似的关系:

[math]\displaystyle{ EI\sim \log\Gamma_{\alpha} }[/math]

关于马尔科夫链的近似动力学可逆性的进一步讨论和说明,请参考词条:近似动力学可逆性,以及论文:[7]

参考文献

- ↑ Tononi, G.; Sporns, O. (2003). "Measuring information integration". BMC Neuroscience. 4 (31).

- ↑ 2.0 2.1 2.2 2.3 Hoel, Erik P.; Albantakis, L.; Tononi, G. (2013). "Quantifying causal emergence shows that macro can beat micro". Proceedings of the National Academy of Sciences. 110 (49): 19790–19795.

- ↑ 3.0 3.1 3.2 3.3 3.4 Judea Pearl; 刘礼; 杨矫云; 廖军; 李廉 (4 2022). 因果论——模型、推理和推断. 机械工业出版社.

- ↑ Chvykov P; Hoel E. (2021). "Causal Geometry". Entropy. 23 (1): 24.

- ↑ Zhang, Jiang; Liu, Kaiwei (2022). "Neural Information Squeezer for Causal Emergence". Entropy. 25 (1): 26.

- ↑ Yuan, Bing; Zhang, Jiang; Lyu, Aobo; Wu, Jiaying; Wang, Zhipeng; Yang, Mingzhe; Liu, Kaiwei; Mou, Muyun; Cui, Peng (2024). "Emergence and Causality in Complex Systems: A Survey of Causal Emergence and Related Quantitative Studies". Entropy. 26 (2): 108.

- ↑ 7.0 7.1 7.2 7.3 Jiang Zhang; Ruyi Tao; Keng Hou Leong; Mingzhe Yang; Bing Yuan (2024). "Dynamical reversibility and a new theory of causal emergence".

{{cite journal}}: Cite journal requires|journal=(help) - ↑ Hoel, E.P. (2017). "When the Map Is Better Than the Territory". Entropy. 19: 188.

- ↑ 引用错误:无效

<ref>标签;未给name属性为:0的引用提供文字 - ↑ Suppes, P. (1973). A probabilistic theory of causality. British Journal for the Philosophy of Science, 24(4).

- ↑ Fitelson, B., & Hitchcock, C. (2011). Probabilistic measures of causal strength (pp. 600-627). na.

- ↑ Eells, E. (1991). Probabilistic causality (Vol. 1). Cambridge University Press.

- ↑ Cheng, P. W., & Novick, L. R. (1991). Causes versus enabling conditions. Cognition, 40(1-2), 83-120.

- ↑ Lewis, D. (1973). Causation. The journal of philosophy, 70(17), 556-567.