人工神经网络上的有效信息计算

人工神经网络(artificial neural networks)主要通过分析节点与数据集间的互信息(Mutual Information,MI),来研究其对输入的响应。然而,神经网络还可以在因果关系层面进行探讨,揭示网络内部各层间“谁影响谁”及其作用机制。有效信息(Effective Information, EI)作为一种基于信息论的工具,可以通过最大熵扰动下的输入与输出之间的互信息,量化网络层间的因果作用。通过引入EI方法,我们能够在因果平面(Causal Plane)中观察网络训练过程中各层因果结构的演化,从而揭示不同任务对网络结构的需求,提供提升人工神经网络泛化能力和可解释性的新思路。

简介

人工神经网络在语音合成[1]、图像识别[2][3]和翻译[4]等各个领域都表现出了先进的性能。然而,人工神经网络底层机制还存在很多未知。例如,基本的机器学习理论表明,拥有大量参数的模型往往容易记住数据集中的所有信息,导致泛化能力差,特别是在未正则化的模型中[5]。深度神经网络(DNN)的主要原理是将深度学习技术[6]引入人工神经网络,以及将GPU用于高速计算[7]。在实践中,研究者发现即使没有显式正则化的DNN也具有良好的泛化性能[8]。虽然众所周知,尽管人工神经网络可以逼近任何函数[9],但它们得出的函数是如何超越训练数据进行泛化的,仍缺乏清晰的理论解释。

信息瓶颈(information bottleneck)是一种被提出来解释人工神经网络泛化能力的理论框架[10]。它认为神经网络在压缩输入数据与预测输出之间寻找最佳平衡。通过分析网络在信息平面(information plane)上的行为——即输入数据与每层网络之间的互信息,研究者尝试揭示网络的学习机制[11]。虽然寻找信息瓶颈是一个可行的方法,但更大的网络仍然受到信息估计问题的困扰[12],并且某些网络拓扑和激活函数的预测或偏差存在错误[13]。更根本的是,信息瓶颈方法的数学公式是数据依赖的,也就是说,它的互信息得分随着输入分布的变化而变化。然而,从定义上讲,泛化能力是不同数据集(输入频率不同,甚至是未知且尚未定义的未来数据集)性能的函数。因此,为了理解泛化能力,有必要关注神经网络在具有不同属性的不同数据集上的不变性[14]。

为更深入理解神经网络的泛化能力,我们需要关注网络中独立于数据分布的因果结构。因果结构描述了网络中节点间的依赖关系,反映了节点之间的连接机制和作用方式。这里我们介绍一种微扰方法,该方法使用信息理论以逐层的方式跟踪神经网络内的因果作用。具体来说,我们引入了有效信息(Effective Information, EI),它可以捕获因果关系的信息量和强度。EI最初是作为复杂系统两个子集之间因果关系的信息论度量而引入的[15]。已经有学者证明,EI可以量化布尔网络的因果结构[16],也可以量化图形[17]。值得注意的是,EI与信息瓶颈方法在数学上有相似之处,但EI侧重于因果关系。在神经网络中,EI通过对网络层节点施加独立且随机的最大熵噪声,计算扰动后输出与输入之间的互信息,捕捉层间因果结构的信息总量。研究发现,网络训练过程中损失函数的快速下降往往伴随着EI的剧烈变化,揭示了网络因果结构的动态演化。

更重要的是,EI可以帮助我们追踪网络训练过程中各层因果结构的变化路径,称之为因果平面(causal plane)。通过观察网络连接的“敏感度”(Sensitivity,即扰动的传递效果,类似Erik Hoel的Determinism概念[18])和“简并度”(Degeneracy,即连接重叠导致的信息丢失),我们可以看到不同任务如何塑造神经网络的因果结构。复杂任务往往导致网络因果结构分化更明显,而简单任务中这种分化较弱。此外,冗余层通常无法在因果平面中显著变化,显示其对网络功能贡献较小。此外,我们会展示如何使用EI来计算一层中节点的总联合效应和总个体效应之间的差异,从而可以测量神经网络中的前馈集成信息[19]。

这种分析工具为解决人工神经网络的可解释性问题提供了新的思路。由于人工神经网络拥有大量参数,常被视为“黑匣子”,其内部机制难以理解,影响了模型的透明度[20]。缺乏可解释性可能会掩盖其他问题,如数据集[21]或模型选择[22]中的偏见,对于那些想使用人工神经网络做出关于人生命的事情来说是一个重大问题,例如在自动驾驶汽车[23]、自动驾驶无人机[24]或医疗诊断[25]的情况下。因此使用这套技术,研究人员将能够在训练过程中直接观察神经网络的整体因果结构发生变化的过程,这是打开“黑匣子”和了解神经网络中的作用的关键一步。

量化DNN的因果结构

干预(也称为“扰动”)揭示了因果关系。前馈DNN的因果关系集(也称为“因果结构”)由层、它们各自的连接和节点的激活函数组成。我们介绍了一些工具来探索这样一个假设,即DNN的泛化能力取决于它们的因果结构如何区分以适应它们所训练的任务(所有代码都是公开的,请参阅此处的假设)。

为了研究这个问题,我们使用了一种广泛用于研究因果关系的正式方法,其中干预被表示为ado(x)算子的应用[26]。Thedo(x)通常用于将给定系统中的单个变量(如有向无环图)设置为特定值(例如,它以前曾被用于在DNN中应用单个干预[27][28]。为了对DNN层的完整因果结构进行分析理解,我们在这里引入了干预分布ID的使用,而不是跟踪个体干预,ID是do(x)算子上的概率分布。它们只是对一组干预措施的数学描述。在层的输入上应用ID会导致下游输出(theED)的一些效应分布[29]。

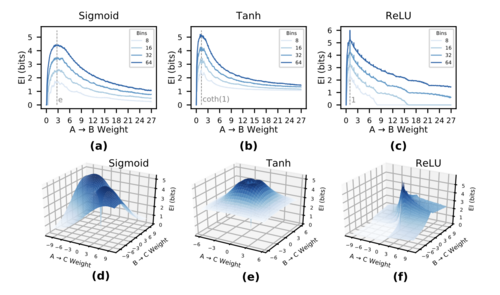

因果关系的信息量可以通过使用ID的信息论来衡量。更多的信息因果关系更强。在这里,我们使用有效信息(EI)来量化和检查一个层的因果结构,有效信息是衡量因果关系信息含量的指标。具体来说,当[math]\displaystyle{ I_D = H^{\max} }[/math],即最大熵分布时,EI是干预和效果之间的相互信息[math]\displaystyle{ I(I_D, E_D) }[/math]。更简单地说,EI是以随机化形式注入噪声后的互信息(MI)。 图1:EI是权重和连接性的函数。图(a-c)显示了EIvs。使用sigmoid、tanh和ReLU激活函数,使用8、16、32和64个区间计算单个输入和输出神经元的权重。标记的是用于传输每个激活函数的一组扰动的最有信息量的权重(单独)。图(d-f)显示了具有两个输入节点a和一个输出节点C的层的EI。不同的激活函数具有不同的特征。

然而,与作为相关性度量的标准MI不同[30],所有具有噪声注入的相互比特都必然是由该噪声引起的。此外,作为信息量最大的干预(就其熵而言),EI表示变量随机化产生的信息,这是科学解释的金标准[31]。它可以被认为是衡量函数的图像在多大程度上可以用于恢复预图像,并且与Kolmogorov复杂性和VC熵有重要关系[32]。最值得注意的是,之前的研究表明,EI反映了因果关系的重要属性,捕捉了因果关系有多信息,例如它们的决定论(缺乏噪声)或简并性(缺乏唯一性)[16]。 首先,我们介绍了一种测量DNN中层间连接性的EIf的方法,捕捉一层对另一层的总联合效应。因此,我们从L1开始,L1是一组与L2有加权前馈连接的节点,我们假设所有节点都有一些激活函数,如sigmoid函数。为了测量EI,L1在最大熵[math]\displaystyle{ do(L_{1}=H^{\max}) }[/math]处受到扰动,这意味着节点的所有激活都被迫进入随机选择的状态。[math]\displaystyle{ L_{1}=H^{\max} }[/math]最大限度地放大了L1中所有节点的同时和独立的最大熵扰动:

[math]\displaystyle{ \begin{equation} EI = I(L_1, L_2) \mid do(L_1 = H^{\text{max}}) \end{equation} }[/math]

也就是说,在[math]\displaystyle{ L_{1}=H^{\max} }[/math]的条件下,通过测量L1和L2的关节状态之间的互信息来进行计算。

EI可跨不同的常用激活函数进行扩展。图1a-c显示了两个节点a和B之间的单条边的EI,其中a→B的权重逐渐增加,每个面板显示了不同的激活函数(sigmoid、tanh、ReLU)。我们可以看到,对于每个具有给定激活函数的孤立边,都存在一条依赖于来自AtoB的连接权重的特征isticEIcurve,并且这条曲线的形状与所选的箱数(8、16、32和64)无关。在低权重下,EI表明B对a中的扰动不敏感,尽管这种敏感性在所有三个激活函数中都达到了峰值。然后,当权重饱和激活函数时,曲线会衰减,使B对A的扰动敏感。

请注意,特征峰值揭示了哪些权重代表(孤立考虑的连接)的强因果关系。例如,一个sigmoid激活函数在等于欧拉数的aweight处具有最具信息量的因果关系,一个tanh激活函数在权重coth(1)处具有信息量,一个ReLU激活函数在重量1处具有信息力。这表明DNN中最重要的权重可能是最具因果效力的,而不是绝对值最高的。例如,对于sigmoid激活函数和连接A→B的极高权重,A的激活对扰动的信息量不大,因为大多数扰动都会导致B的输出在1处饱和。

在多个连接的情况下,EI曲线成为更高维度的EI歧管。图1d-f显示了由两个节点(A、B)组成的层的EI(A,B→C),每个节点都与C有一个连接。由于扰动会相互干扰,EI不仅取决于节点之间关系的敏感性,还取决于网络连接的重叠或通用性,从而形成流形。例如,在sigmoid激活函数中,EI流形大约是2倍对称的,这是由于sigmoid在正负权重周围的对称性,再加上网络本身的对称性(因为神经元A和Bony都连接到C)。

请注意,虽然区间的数量决定了曲线的幅度,但它们之间的上升/下降行为是一致的,这表明只要区间大小固定在某个选定的值,比率和行为就会保持不变(下图显示对a-c使用30000个时间步长进行噪声注入,对d-f使用100000个样本)。如果噪声注入足够长并且箱大小足够高,则DNN层的EI值倾向于收敛到特定值。这可以在SI第1节中找到证据。

然而,首先,我们评估了在常见机器学习任务的训练网络过程中,EI的变化是如何发生的。

训练过程中因果结构的变化

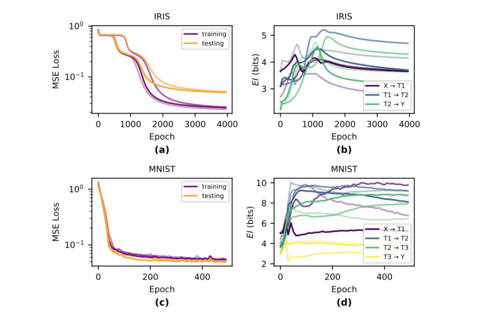

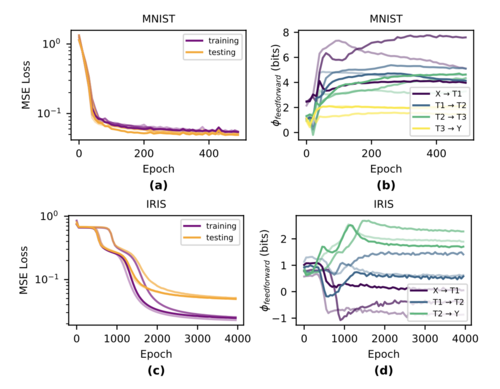

为了了解DNN的因果结构在学习过程中是如何变化的,我们跟踪了用两个基准分类任务训练的EIin网络:Iris[33]和MNIST[34]。对于Iris,我们训练了具有三个密集连接层4→5→5→3的网络,对于MNIST,我们使用了具有四个紧密连接层25→6→6→5的网络,使用sigmoid激活函数,并且两个任务都没有偏差。对于MNIST,我们将输入从28x28整形为5x5,并从数据集中删除了数字5-9的示例,这样最后一层只有5个节点——这是为了降低准确计算EI的计算成本。这两个任务的网络都用MSE损失和香草梯度下降训练,学习率为0.01。我们训练了批量大小为10的Irisnetworks 4000个epoch和批量大小为50的MNIST网络500个epoch。我们通过从均匀分布[math]\displaystyle{ W_{ij} = \mathscr{U}\left([ -\frac{1}{\sqrt{\mathrm{fan}_{\mathrm{in}}}}, \frac{1}{\sqrt{\mathrm{fan}_{\mathrm{in}}}} ]\right) }[/math]中采样来初始化权重。对于每个任务和体系结构,我们执行三次具有不同初始化的运行。使用相同的网络架构,我们还训练了具有tanh和ReLU激活函数的网络——结果可以在SI第7.2节中找到。为了计算EI,我们使用107个样本的固定噪声注入长度。我们发现,在我们的网络中,注入这个长度就足以确保收敛(见SI第7.1节)。然而,请注意,更宽的网络层可能需要更多的样本。

从定性上讲,我们观察到,EI的最大变化与训练过程中损失曲线的最陡部分显著匹配,并且在最大学习期间,EI通常是动态的(如下图所示)。在训练性能与测试性能分离的过拟合期间,EI在所有层上通常都是平坦的,这表明在网络适当拟合后,因果结构中的信息在此期间没有变化。

因果平面中的深度神经网络

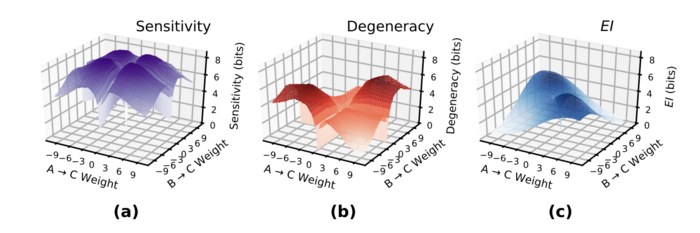

如上文所述,EI取决于连接的权重及其重叠程度,这两者共同构成了EI流形。这表明,EI可以分解为两个属性:由个体权重表示的因果关系的敏感性,以及由于输入权重重叠而导致的这些关系的通用性。这反映了之前将EIin布尔网络或马尔可夫链分解为确定性(这里用灵敏度代替,因为神经网络传统上是确定性的)和简并性[16][17]。

在DNN中,层的灵敏度衡量输入将扰动传输到输出节点的程度,而层的简并性衡量通过检查层输出可以重建输入扰动源的程度。如果扰动源不能很好地重建,则网络被称为扰动。这两个维度的因果关系共同构成了一个所有DNN层都占据的“因果平面”。随着层通过学习而不同,它们的因果结构应该在因果平面中占据独特的位置,反映出它们通过变得更敏感或更退化而对DNN功能的贡献。

为了确定DNN层在因果平面中的位置或轨迹,根据EI的分量明确计算灵敏度和衰减。在参数之间没有相互作用的情况下,通过将每条边的总贡献单独相加来计算灵敏度。因此,层L1到下一层L2的总灵敏度为:

[math]\displaystyle{ \begin{equation} \text{Sensitivity} = \sum_{\substack{i \in L_1 \\ j \in L_2}} I(t_i, t_j) \mid \operatorname{do}(i = H^{\text{max}}) \end{equation} }[/math]

这与计算每个(i,j)对的EI相同,但独立于网络的其他部分。请注意,在每个节点只接收一个唯一输入(即没有重叠)的层中,灵敏度等于EI。 层的简并性衡量因果关系中有多少信息因重叠连接而丢失,并通过代数方法计算其灵敏度-EI,因为灵敏度衡量网络中非重叠连接的信息贡献。下图显示了具有不同连接权重的两个输入节点和一个输出节点(具有S形激活)的层的本质性和简并流形。它们之间的差异形成了EI流形。 一层的简并性衡量因果关系中有多少信息因重叠连接而丢失,并通过代数方法计算其增敏性-EI,增敏性衡量网络中非重叠连接的信息贡献。下图显示了具有不同连接权重的两个输入节点和一个输出节点(具有S形激活)的层的增敏性和简并流形。它们之间的差异形成了EI歧管。

之前对图的EI(基于随机游走动力学)的研究已经找到了一种对不同规范网络进行分类的方法,如Erd̋os-Rényi随机图、无标度网络和轮辐模型,基于它们在随机游走的决定论和简并性方面的位置[17]。在DNN中,一个敏感术语取代了决定论。

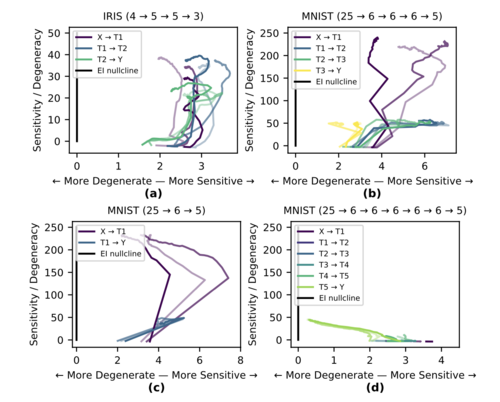

为了可视化灵敏度和简并性之间的层偏移,我们引入了DNN的“因果平面”,其中平面的二维表示两个相应的值。因果平面利用了这样一个事实,即由于EI=灵敏度−简并,如果两者都等量增加,EI本身就不会改变。当绘制简并性与灵敏度时,y=x线上的点表示零EI,我们将这条45◦的线称为EI的“零点斜率”。更倾向于敏感性的路径会增加EI,更倾向于简并的路径会降低EI,而沿着EI零点的路径不会改变EI。

在这里,我们探讨了这样一个假设,即DNN的内部因果结构会发生变化,以匹配它所训练的任务,并且这会在整个训练过程的特定阶段发生。为了研究这一点,我们在训练过程中测量了Iris和MNIST数据集上通过因果平面的三次运行的路径(如图4a-b所示)。在这两项任务中,对MNIST数字进行分类更为退化和复杂,因为网络必须将高维空间中的流形转换为仅10个不同的输出类(或者更确切地说,对于我们简化的MNIST版本,是5个)。对鸢尾花进行分类的任务既不退化也不复杂,因为网络必须将4维空间转换为3个(大多)线性可分的类。如果一个网络通过将其内部因果结构与数据集进行匹配来学习,那么在MNIST上训练的网络将比在Iris上训练的更大程度上塑造自己。这正是我们在图4中观察到的,在MNIST-训练的网络中,因果平面内的差异和运动要大得多,而Iris训练的网络的因果结构中的差异较小,因为它遵循EI零点律。在许多情况下,特别是对于隐藏层和输出层,运行首先表现出灵敏度的增加(增加EI),然后表现出简并性的增加(降低EI)。

为了检验层的因果结构在训练过程中必然会发生差异的假设,对具有sigmoid激活函数的MNIST训练网络进行了两种修改:一种情况下删除了隐藏层,另一种情况是添加了许多冗余的隐藏层(下图c-d)。网络的两个修改都与之前的网络一样准确。在因果平面上,添加的冗余层几乎没有变化,表明在训练过程中对EI的净贡献为零(有关视频,请参阅GitHub)。这显示了与更动态的层相比,对网络因果结构没有贡献的冗余层如何沿着EI零点聚集并且移动很少。

测量层间连通性的联合效应

综合信息理论(IIT)已被用于评估系统中联合效应与独立效应所包含的总信息[35]。它是因果分析的有用工具,分析网络因果结构中整合的信息量[36][37]。以前,综合信息被衡量为给定分区的EI损失[38],使EI成为综合信息的上限。然而,目前还没有一种公认的通用综合信息衡量标准[39]。相反,在不同的系统中提出了各种集成信息的措施[40][41]。传统上,前馈网络中的集成信息量为零,因为没有可重入连接,因为它基于在系统的所有可能子集中找到最小信息分区。然而,即使在前馈网络中,一层的节点仍然可能对另一层产生不可约的联合效应,因此我们引入了一种度量,即前馈集成信息,应用于DNN。

通常,计算集成信息需要检查所有可能分区的集合,这使得这种方法不适用于维数较小的系统。或者,为了评估单个边对EI的协同贡献,可能需要使用多变量信息理论,例如部分信息分解,当包含源时,它会按照Dedekind数的顺序增长[42]

为了避免这些问题,我们引入了一种基于每条边的贡献计算的度量方法[math]\displaystyle{ EI_{parts} }[/math]。也就是说,对于每个节点i∈L1,记录其在该扰动下的激活函数的时间序列估计,以及每个节点j∈L2的激活函数。为了计算EI部分,然后将每个节点的每个单独的时间序列离散为一些共享的选定bin大小,并计算和求和每个(i,j)对的MI:10)。

[math]\displaystyle{ \begin{equation} EI_{\text{parts}}(L_1 \rightarrow L_2) = \sum_{(i \in L_1, j \in L_2)} I(t_i, t_j) \mid \text{do}(L_1 = H^{\max}). \end{equation} }[/math]

请注意,对于具有单个节点的层,EI和EI部分是相同的。当网络的每个节点只接收单个边缘时,情况也是如此。然而,[math]\displaystyle{ EI_{parts} }[/math]措施必然会错过某些积极的联合效应。重要的是,EI和EIparts度量之间的差异可以捕捉到联合效应的量,从而捕捉到逐层以前馈方式整合的信息量。具体来说,我们将EI(综合信息的上限)与第3节中定义的[math]\displaystyle{ EI_{parts} }[/math]进行比较,即[math]\displaystyle{ \Phi_{feedforward} = EI - EI_{parts} }[/math]。应该指出的是,向前的φf虽然旨在捕捉一层到另一层的总联合效应,但不受零的限制,可以是负的。

为了了解DNN训练过程中层间联合效应的变化,我们分析了Iris和MNIST数据集训练过程中[math]\displaystyle{ φ_f }[/math]的前向变化(有关我们测量[math]\displaystyle{ EI_{parts} }[/math]的方法的详细信息,请参阅SI第7.1节)。我们观察到,MNIST训练的网络比Iris训练的网络具有更高的φf前馈,这表明因果结构确实根据任务的复杂性而有所不同,需要更多的联合效应来学习(见下图)。

总结

在这里,我们引入了信息论技术,根据扰动后的信息流对DNN的因果结构进行分类和量化。这些技术是围绕有效信息(EI)构建的,我们将其应用于DNN。它被定义为在一组最大熵扰动之后的互信息,它揭示了层因果结构中包含的信息。对于在Iris和MNIST任务上训练的网络,EI在训练期间发生了变化,特别是在实际发生学习时(如损失函数中的阶跃变化所反映的)。

EI取决于网络的灵敏度和简并性。两个节点之间的灵敏度反映了孤立因果关系的强度,并在不同激活函数的特定特征权重处达到峰值(例如,在sigmoid激活函数中,它达到峰值)。层的退化反映了由于边缘权重的重叠,上游扰动的下游重建的困难。分析EI揭示了网络在灵敏度/简并空间上的位置,我们称之为“因果平面”。将网络架构放置在这个平面上的能力意味着我们可以跟踪任何给定的DNN的因果结构在训练过程中如何在空间中演变。我们的结果表明,DNN的因果结构反映了它所训练的任务。例如,在MNIST任务中,DNN因果结构中的不同层有一个明确的任务,这反映在每一层在因果平面上的不同轨迹上,添加新的冗余层不会对EI产生影响,因此不会向因果结构添加新的信息。

这些技术提供了一种与信息瓶颈研究不同的方法[43],后者侧重于使用互信息来衡量输入和节点活动之间的相关性。这两种方法都有类似的目标来解释DNN的泛化性,并且都有形式上的相似之处,尽管这里的重点是逐层因果结构本身,而不是DNN的输入。未来,这项工作可以扩展到这里考虑的三种激活函数之外的不同激活函数[44][45]、无监督任务[46]、LSTM等循环神经网络[47]和卷积神经网络[2]。

这些技术开辟了评估EI分解和扩展的可能性,例如DNN的集成信息(因为集成信息可以使用网络子集之间的最小EI来计算[15],集成信息也可以分解为类似于灵敏度和简并性的属性[48]。这里,概述了一种综合信息的度量方法φf forward,用于度量前馈层连通性中的不可约联合效应。 所有这些可能有助于理解为什么某些网络架构具有普遍性,为什么有些没有。未来,这些技术也为直接测量DNN中的个别因果关系提供了可能性[37]。

参考文献

- ↑ Zhizheng Wu, Oliver Watts, and Simon King. Merlin: An open source neural network speech synthesis system. In SSW, pages 202–207, 2016.

- ↑ 2.0 2.1 Alex Krizhevsky, Ilya Sutskever, and Geoffrey E Hinton. Imagenet classification with deep convolutional neural networks. In Advances in neural information processing systems, pages 1097–1105, 2012.

- ↑ Edgar Xi, Selina Bing, and Yang Jin. Capsule network performance on complex data. arXiv preprint arXiv:1712.03480, 2017.

- ↑ I Sutskever, O Vinyals, and QV Le. Sequence to sequence learning with neural networks. Advances in NIPS, 2014.

- ↑ Chiyuan Zhang, Samy Bengio, Moritz Hardt, Benjamin Recht, and Oriol Vinyals. Understanding deep learning requires rethinking generalization. arXiv preprint arXiv:1611.03530, 2016.

- ↑ Yann LeCun, Yoshua Bengio, and Geoffrey Hinton. Deep learning. nature, 521(7553):436–444, 2015.

- ↑ Rajat Raina, Anand Madhavan, and Andrew Y Ng. Large-scale deep unsupervised learning using graphics processors. In Proceedings of the 26th annual international conference on machine learning, pages 873–880. ACM, 2009.

- ↑ Behnam Neyshabur, Srinadh Bhojanapalli, David McAllester, and Nati Srebro. Exploring generalization in deep learning. In Advances in Neural Information Processing Systems, pages 5947–5956, 2017.

- ↑ Kurt Hornik, Maxwell Stinchcombe, and Halbert White. Multilayer feedforward networks are universal approximators. Neural networks, 2(5):359–366, 1989.

- ↑ Naftali Tishby, Fernando C Pereira, and William Bialek. The information bottleneck method. arXiv preprint physics/0004057, 2000.

- ↑ Ravid Shwartz-Ziv and Naftali Tishby. Opening the black box of deep neural networks via information. arXiv preprint arXiv:1703.00810, 2017.

- ↑ Kristoffer Wickstrøm, Sigurd Løkse, Michael Kampffmeyer, Shujian Yu, Jose Principe, and Robert Jenssen. Information plane analysis of deep neural networks via matrix-based renyi’s entropy and tensor kernels.arXiv preprint arXiv:1909.11396, 2019.

- ↑ Andrew M Saxe, Yamini Bansal, Joel Dapello, Madhu Advani, Artemy Kolchinsky, Brendan D Tracey, and David DCox. On the information bottleneck theory of deep learning. Journal of Statistical Mechanics: Theory and Experiment, 2019(12):124020, 2019.

- ↑ Chiyuan Zhang, Samy Bengio, Moritz Hardt, Benjamin Recht, and Oriol Vinyals. Understanding deep learning requires rethinking generalization. arXiv preprint arXiv:1611.03530, 2016.

- ↑ 15.0 15.1 Giulio Tononi and Olaf Sporns. Measuring information integration. BMC neuroscience, 4(1):31, 2003.

- ↑ 16.0 16.1 16.2 Erik P Hoel, Larissa Albantakis, and Giulio Tononi. Quantifying causal emergence shows that macro can beat micro. Proceedings of the National Academy of Sciences, 110(49):19790–19795, 2013.

- ↑ 17.0 17.1 17.2 Erik P Hoel, Larissa Albantakis, and Giulio Tononi. Quantifying causal emergence shows that macro can beat micro. Proceedings of the National Academy of Sciences, 110(49):19790–19795, 2013.

- ↑ Hoel, Erik P.; Albantakis, L.; Tononi, G. (2013). "Quantifying causal emergence shows that macro can beat micro". Proceedings of the National Academy of Sciences. 110 (49): 19790–19795.

- ↑ Masafumi Oizumi, Larissa Albantakis, and Giulio Tononi. From the phenomenology to the mechanisms of consciousness: integrated information theory 3.0. PLoS Comput Biol, 10(5):e1003588, 2014.

- ↑ David Gunning. Explainable artificial intelligence (xai). Defense Advanced Research Projects Agency (DARPA), nd Web, 2, 2017.

- ↑ Mohsan Alvi, Andrew Zisserman, and Christoffer Nellåker. Turning a blind eye: Explicit removal of biases and variation from deep neural network embeddings. In Proceedings of the European Conference on Computer Vision(ECCV) , pages 0–0, 2018.

- ↑ Arnaud Mignan and Marco Broccardo. One neuron versus deep learning in aftershock prediction. Nature, 574(7776): E1–E3, 2019.

- ↑ Mariusz Bojarski, Davide Del Testa, Daniel Dworakowski, Bernhard Firner, Beat Flepp, Prasoon Goyal, Lawrence D Jackel, Mathew Monfort, Urs Muller, Jiakai Zhang, et al. End to end learning for self-driving cars. arXiv preprint arXiv:1604.07316, 2016.

- ↑ Dario Floreano and Robert J Wood. Science, technology and the future of small autonomous drones. Nature, 521(7553):460–466, 2015.

- ↑ Hoo-Chang Shin, Holger R Roth, Mingchen Gao, Le Lu, Ziyue Xu, Isabella Nogues, Jianhua Yao, Daniel Mollura, and Ronald M Summers. Deep convolutional neural networks for computer-aided detection: Cnn architectures, dataset characteristics and transfer learning. IEEE transactions on medical imaging, 35(5):1285–1298, 2016.

- ↑ Judea Pearl. Causality. New York: Cambridge, 2000. doi: 10.1017/CBO9780511803161.

- ↑ Michael Harradon, Jeff Druce, and Brian Ruttenberg. Causal learning and explanation of deep neural networks via autoencoded activations. arXiv preprint arXiv:1802.00541, 2018.

- ↑ Tanmayee Narendra, Anush Sankaran, Deepak Vijaykeerthy, and Senthil Mani. Explaining deep learning models using causal inference. arXiv preprint arXiv:1811.04376, 2018.

- ↑ Erik P. Hoel. When the map is better than the territory. Entropy, 19(5):188, 2017. ISSN 1099-4300. doi: 10.3390/e19050188.

- ↑ Claude E. Shannon. A mathematical theory of communication. The Bell System Technical Journal, 27(July 1928): 379–423, 1948. ISSN 07246811. doi: 10.1145/584091.584093.

- ↑ R. A. Fisher. The Design of Experiments. The American Mathematical Monthly, 43(3):180, 1936. ISSN 00029890. doi: 10.2307/2300364.

- ↑ David Balduzzi. Information, learning and falsification. arXiv preprint arXiv:1110.3592, 2011.

- ↑ R. A. Fisher. The Design of Experiments. The American Mathematical Monthly, 43(3):180, 1936. ISSN 00029890. doi: 10.2307/2300364.

- ↑ Yann LeCun, Corinna Cortes, and CJ Burges. Mnist handwritten digit database. ATT Labs [Online]. Available: http://yann.lecun.com/exdb/mnist, 2, 2010.

- ↑ Giulio Tononi. Consciousness as integrated information: a provisional manifesto. The Biological Bulletin, 215(3): 216–242, 2008.

- ↑ William Marshall, Hyunju Kim, Sara I Walker, Giulio Tononi, and Larissa Albantakis. How causal analysis can reveal autonomy in models of biological systems. Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences, 375(2109):20160358, 2017.

- ↑ 37.0 37.1 Larissa Albantakis, William Marshall, Erik Hoel, and Giulio Tononi. What caused what? a quantitative account of actual causation using dynamical causal networks. Entropy, , 21(5):459, 2019.

- ↑ David Balduzzi and Giulio Tononi. Integrated information in discrete dynamical systems: motivation and theoretical framework. PLoS Comput Biol, 4(6):e1000091, 2008.

- ↑ Masafumi Oizumi, Larissa Albantakis, and Giulio Tononi. From the phenomenology to the mechanisms of consciousness: integrated information theory 3.0. PLoS Comput Biol, 10(5):e1003588, 2014.

- ↑ Max Tegmark. Improved measures of integrated information. PLoS computational biology, 12(11):e1005123, 2016.

- ↑ Pedro AM Mediano, Anil K Seth, and Adam B Barrett. Measuring integrated information: Comparison of candidate measures in theory and simulation. Entropy, 21(1):17, 2019.

- ↑ Paul L Williams and Randall D Beer. Nonnegative decomposition of multivariate information. arXiv preprint arXiv:1004.2515, 2010.

- ↑ Naftali Tishby and Noga Zaslavsky. Deep learning and the information bottleneck principle. In 2015 IEEE Information Theory Workshop (ITW) , pages 1–5. IEEE, 2015.

- ↑ Bekir Karlik and A Vehbi Olgac. Performance analysis of various activation functions in generalized mlp architectures of neural networks. International Journal of Artificial Intelligence and Expert Systems, 1(4):111–122, 2011.

- ↑ Vinod Nair and Geoffrey E Hinton. Rectified linear units improve restricted boltzmann machines. In Proceedings of the 27th international conference on machine learning (ICML-10) , pages 807–814, 2010.

- ↑ Laurenz Wiskott and Terrence J Sejnowski. Slow feature analysis: Unsupervised learning of invariances. Neural computation, 14(4):715–770, 2002.

- ↑ Sepp Hochreiter and Jürgen Schmidhuber. Long short-term memory. Neural computation, 9(8):1735–1780, 1997.

- ↑ Erik P Hoel, Larissa Albantakis, William Marshall, and Giulio Tononi. Can the macro beat the micro? Integrated information across spatiotemporal scales. Neuroscience of Consciousness, 2016(1), 2016.