因果涌现

因果涌现(causal emergence)是指动力系统中的一类特殊的涌现现象,即系统在宏观尺度会展现出更强的因果特性。特别的,对于一类马尔科夫动力系统来说,在对其状态空间进行适当的粗粒化以后,所形成的宏观动力学会展现出比微观更强的因果特性,那么称该系统发生了因果涌现[1][2]。同时,因果涌现理论也是一种利用因果效应度量来量化复杂系统中的涌现现象的理论。

历史

相关概念的发展

因果涌现理论是一种试图用基于因果的定量研究方法,从现象学的角度回答什么是涌现这一问题的理论,因此因果涌现的发展与人们对涌现和因果等概念的认识和发展密切相关。

涌现

涌现一直是复杂系统中的一个重要特性,是许多关于系统复杂性,以及宏微观之间关系讨论的核心概念[3][4]。涌现可以简单理解为整体大于部分之和,即整体上展现出构成它的个体所不具备的新特性[5]。尽管学者们在各个领域都指出存在涌现的现象[4][6],如鸟类的群体行为[7],大脑中的意识形成,以及大语言模型的涌现能力[8],但目前还没有对这一现象普遍认可的统一理解。以往对涌现的研究大多停留在定性的阶段,如 Bedau et al[9][10]对涌现进行了分类研究,即将涌现分为名义涌现[11][12]、弱涌现[9][13]与强涌现[14][15]。

- 弱涌现是指宏观层面的属性或过程是通过单个组件之间以复杂相互作用的方式产生的,或者弱涌现也可以被理解为原则上能够被计算机模拟的特性。由于计算不可约性原理,弱涌现特性即使能够被模拟,但仍然不能轻易地简化为微观层面的属性。对于弱涌现来说,其模式产生的原因可能来自微观和宏观两个层面[14][15],因此,涌现的因果关系可能与微观因果关系并存。

- 而对于强涌现来说存在很多的争论,它指的是宏观层面的属性,原则上不能简化为微观层面的属性,包括个体之间的相互作用。此外,Jochen Fromm 进一步将强涌现解释为向下因果的因果效应[16]。向下因果关系是指从宏观层面向微观层面的因果力。然而,关于向下因果关系本身的概念存在许多争议[17][18]。

由这些早期研究可以看出,涌现与因果有着天然的深刻联系。

因果及其度量

所谓的因果就是指事件彼此之间的相互影响。因果不等于相关,这体现为,不仅当 A 发生时 B 会发生,而且如果 A 不发生,则 B 也不发生。人们只有通过干预事件 A,从而考察 B 的结果,才能探测 A 与 B 是否存在着因果关系。

随着近年来因果科学得到了进一步的发展,使得人们可以用数学框架来量化因果,因果描述的是一个动力学过程的因果效应[19][20][21]。Judea Pearl[21]利用概率图模型来描述因果相互作用。Pearl 用不同的模型来区分并量化了三个层次的因果关系,这里我们比较关注因果阶梯中的第二层:对输入分布做干预。此外,由于发现的因果关系背后的不确定性和模糊性,测量两个变量之间的因果效应程度是另一个重要问题。许多独立的历史研究已经解决了因果关系测量的问题。这些测量方法包括休谟的恒定连接概念[22]和基于值函数的方法[23],Eells 和 Suppes 的概率性因果度量[24][25],以及 Judea Pearl 的因果度量指标等[19]。

因果涌现

如前所述,涌现和因果是相互联系的。具体来说,联系存在于以下方面:一方面,涌现可以理解为因果效应的一种,刻画了复杂系统中各组成部分之间复杂的非线性相互作用;另一方面,涌现出的特性也会对复杂系统中的单个个体产生因果作用。此外,以往人们习惯于将宏观因素归因为微观因素的影响,但是宏观涌现出来的模式,往往无法找到微观的归因,所以也就无法找到对应的原因。由此可见,涌现与因果存在着深刻的联系。再者,虽然我们有了对涌现的定性分类,然而却无法定量的刻画涌现的发生。因此,我们可以借助因果来定量刻画涌现的发生。

2013年,美国理论神经生物学家 Erik Hoel 尝试将因果引入涌现的衡量,提出了因果涌现这一概念,并且使用有效信息(Effective Information,简称 EI)来量化系统动力学的因果性强弱[1][2]。因果涌现可以描述为:当一个系统在宏观尺度相较其在微观尺度上具有更强的因果效应的时候,就产生了因果涌现。因果涌现很好的刻画了系统宏观和微观状态之间的区别与联系,同时把人工智能中的因果和复杂系统中的涌现这两个核心概念结合起来,因果涌现也为学者回答一系列的哲学问题提供了一个定量化的视角。比如,可以借助因果涌现框架讨论生命系统或者社会系统中的自上而下的因果特性。这里的自上而下因果指的是向下因果(downward causation)[26],表示存在宏观到微观的因果效应。例如,壁虎断尾现象,当遇到危险时,壁虎不管自己的尾巴怎样,直接将它断掉。这里整体是因,尾巴是果,那么就存在一个整体指向部分的因果力。

早期量化涌现工作

早期已经有一些相关的工作尝试对涌现进行定量的分析。Crutchfield 等[27]提出的计算力学理论考虑了因果态,该方法是在状态空间划分的基础上展开相关概念讨论的,与 Erik Hoel 的因果涌现理论存在着很大的相似性。而 Seth 等人则提出了 G-emergence 理论[28]利用格兰杰因果关系来量化涌现。

计算力学

计算力学理论试图用定量的框架来表述涌现的因果规律,即如何从一个随机过程中构造一种粗粒化的因果模型,从而使得这个模型可以产生已观测的随机过程的时间序列[27]。

这里的随机过程可以用 [math]\displaystyle{ \overleftrightarrow{s} }[/math] 表示,基于时间 [math]\displaystyle{ t }[/math] 可以将随机过程分为两个部分,时间 [math]\displaystyle{ t }[/math] 前的过程 [math]\displaystyle{ \overleftarrow{s_t} }[/math],以及时间 [math]\displaystyle{ t }[/math] 后的过程 [math]\displaystyle{ \overrightarrow{s_t} }[/math] 。计算力学将所有可能的历史过程 [math]\displaystyle{ \overleftarrow{s_t} }[/math] 形成的集合记作 [math]\displaystyle{ \overleftarrow{S} }[/math],所有未来的过程 [math]\displaystyle{ \overrightarrow{s_t} }[/math] 形成的集合记作 [math]\displaystyle{ \overrightarrow{S} }[/math]。

计算力学的目标是建立一个模型,希望以一定的准确度对观察到的随机序列进行重建和预测。然而,序列的随机性使我们无法获得完美的重建,因此,我们需要一个粗粒化的映射来捕获随机序列中的有序结构。这个粗粒化映射可以用一个划分函数 [math]\displaystyle{ \eta: \overleftarrow{S}→\mathcal{R} }[/math] 来刻画,该函数可以将 [math]\displaystyle{ \overleftarrow{S} }[/math] 划分为相互排斥的若干子集(所有的互斥子集形成全集),形成的集合记为 [math]\displaystyle{ \mathcal{R} }[/math]。

计算力学将任意的子集 [math]\displaystyle{ R \in \mathcal{R} }[/math] 看作是一个宏观状态。对于一组宏观状态集合 [math]\displaystyle{ \mathcal{R} }[/math],计算力学使用香农熵定义了指标 [math]\displaystyle{ C_\mu }[/math],用来衡量这组状态的统计复杂性。其中:

[math]\displaystyle{

C_\mu(\mathcal{R})\triangleq -\sum_{\rho\in \mathcal{R}} P(\mathcal{R}=\rho)\log_2 P(\mathcal{R}=\rho)

}[/math]

可以证明,当使用一组状态构建预测模型时,这组状态的统计复杂性就近似等价于预测模型的大小。

此外,为了使宏观状态集在预测性和简约性之间取得最佳平衡,计算力学定义了因果等价的概念,如果 [math]\displaystyle{ P\left ( \overrightarrow{s}|\overleftarrow{s}\right )=P\left ( \overrightarrow{s}|{\overleftarrow{s}}'\right ) }[/math],则 [math]\displaystyle{ \overleftarrow{s} }[/math] 和 [math]\displaystyle{ {\overleftarrow{s}}' }[/math] 是因果等价的,这种等价关系可以将所有的历史过程划分为等价类,并将它们定义为因果态。历史过程 [math]\displaystyle{ \overleftarrow{s} }[/math] 的所有因果态可以被一个映射 [math]\displaystyle{ \epsilon \left ( \overleftarrow{s} \right ) }[/math] 刻画,这里 [math]\displaystyle{ \epsilon: \overleftarrow{\mathcal{S}}\rightarrow 2^{\overleftarrow{\mathcal{S}}} }[/math] 是一个将历史过程 [math]\displaystyle{ \overleftarrow{s} }[/math] 映射成因果态 [math]\displaystyle{ \epsilon(\overleftarrow{s})\in 2^{\overleftarrow{\mathcal{S}}} }[/math] 的函数。

进一步,我们可以将两个因果态 [math]\displaystyle{ S_i }[/math] 和 [math]\displaystyle{ S_j }[/math] 之间的因果转移概率记为 [math]\displaystyle{ T_{ij}^{\left ( s \right )} }[/math],它类似于一个粗粒化后的宏观动力学。而一个随机过程的 [math]\displaystyle{ \epsilon }[/math]-machine 被定义为有序对 [math]\displaystyle{ \left \{ \epsilon,T \right \} }[/math],这是一种模式发现机器,可以通过学习 [math]\displaystyle{ \epsilon }[/math] 和 [math]\displaystyle{ T }[/math] 函数来实现预测。这相当于定义了所谓的涌现因果的识别问题,这里的 [math]\displaystyle{ \epsilon }[/math]-machine 就是一个尝试发现数据中的涌现因果的机器。

计算力学可以证明,通过 [math]\displaystyle{ \epsilon }[/math]-machine 得到的因果态具有最大可预测性、最小统计复杂度以及最小随机性这三个重要特性,并验证了其在某种意义上是最优的。此外,作者引入了一种分层机器重构算法,可以从观测数据中计算因果态和 [math]\displaystyle{ \epsilon }[/math]-machine。尽管该算法可能并不适用于所有场景,但作者以混沌动力学、隐马尔科夫模型和元胞自动机为例,给出了数值计算结果和相应的机器重构路径 [29]。

虽然原始的计算力学没有给出涌现的明确定义和定量理论,但是随后一些研究人员进一步推进了该理论的发展,Shalizi 等[29]在自己的工作中讨论了计算力学与涌现的关系,如果过程 [math]\displaystyle{ {\overleftarrow{s}}' }[/math] 比过程 [math]\displaystyle{ \overleftarrow{s} }[/math] 具有更高的预测效率,那么过程 [math]\displaystyle{ {\overleftarrow{s}}' }[/math] 发生了涌现,其中一个过程的预测效率 [math]\displaystyle{ e }[/math] 被定义为其过剩熵与其统计复杂度之比([math]\displaystyle{ e=\frac{E}{C_{\mu}} }[/math]),[math]\displaystyle{ e }[/math] 是一个介于 0 到 1 之间的实数,我们可以把它看作是存储在过程中的历史记忆的一部分。在两种情况下,[math]\displaystyle{ C_{\mu}=0 }[/math],一种是这个过程是完全统一和确定的;另一种是它是独立同分布的,在这两种情况下都不可能有任何有趣的预测,所以我们设 [math]\displaystyle{ e=0 }[/math]。同时作者解释说,涌现可以被理解为一个动力学过程,在这个过程中,一个模式获得了能适应不同环境的能力。

因果涌现框架与计算力学存在很多相似之处,所有历史过程 [math]\displaystyle{ \overleftarrow{s} }[/math] 可以看作是微观状态,所有 [math]\displaystyle{ R \in \mathcal{R} }[/math] 对应宏观状态,函数 [math]\displaystyle{ \eta }[/math] 可以理解为一种可能的粗粒化函数,因果态 [math]\displaystyle{ \epsilon \left ( \overleftarrow{s} \right ) }[/math] 是一种特殊状态,它至少可以与微观状态 [math]\displaystyle{ \overleftarrow{s} }[/math] 具有相同的预测能力,因此,[math]\displaystyle{ \epsilon }[/math] 可以理解为一种有效的粗粒化策略,因果转移 [math]\displaystyle{ T }[/math] 对应于有效的宏观动力学。最小随机性特征表征了宏观动力学的确定性,在因果涌现中可以用有效信息衡量。

G-emergence

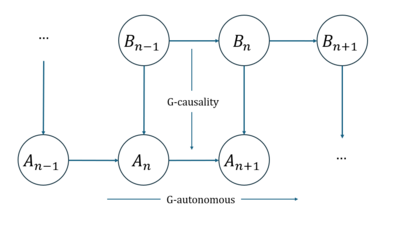

G-emergence 理论是 Seth 于 2008 年提出的,最早从因果的角度对涌现进行定量量化的研究之一[28],基本思想是用非线性格兰杰因果来量化复杂系统中的弱涌现。

具体来说,如果我们使用二元自回归模型进行预测,当只存在两个变量 A 和 B 时,自回归模型存在两个等式,每个等式对应其中一个变量,每个变量的当前时刻值都是由它自身和另外一个变量在滞后一定时间范围内的数值构成。另外,该模型还会计算残差,这里残差可以理解为预测误差,可以用来衡量每一个等式的格兰杰因果效应程度(称为 G-causality)。B 作为 A 的格兰杰因(G-cause)的程度通过两个残差方差之比的对数来计算,其中一个是在省略B时A的自回归模型的残差,另一个是全预测模型(包含了 A 和 B)的残差。此外,作者还定义了“G 自主性(G-autonomous)”的概念,表示一个时间序列的过去值可以预测自身的未来值的度量,可以用类似 G-causality 的方式来刻画这种自主预测的因果效应强度。

如上图所示,我们可以基于上述 G-causality 中的两个基本概念来判断涌现的发生(这里是基于格兰杰因果的涌现的衡量,记作 G-emergence)。如果把 A 理解为宏观变量,B 理解为微观变量。发生涌现的条件包含两个:1)A 是关于 B 的 G-autonomous;2)B 是 A 的 G-cause。其中 G-emergence 的程度是通过 A 的 G-autonomous 的程度与 B 的平均 G-cause 的程度的乘积来计算的。

Seth 提出的 G-emergence 理论首次尝试使用因果度量来量化涌现现象,然而,作者使用的因果关系是格兰杰因果,这不是一个严格的因果关系,同时度量的结果也取决于所使用的回归方法。除此之外,该方法的度量指标是根据变量而不是动力学定义的,这意味着结果会依赖于变量的选择。这些都构成了 G-emergence 理论的弊端。

因果涌现框架与前面提到的 G-emergence 也有相似之处,两个方法的宏观状态都需要人工选择。此外,需要注意的是,上述的一些定量量化涌现的方法往往没有考虑真正的干预式因果。

其他定量刻画涌现的理论

此外,也存在一些其他的涌现定量理论,主要有两种方法被广泛讨论。一种是从无序到有序的过程来理解涌现,Moez Mnif 和 Christian Müller-Schloer[30]使用香农熵来度量有序和无序。在自组织过程中,当秩序增加时就会出现涌现,通过测量初始状态和最终状态之间的香农熵的差异来计算秩序的增加。然而,该方法存在的缺陷是:它依赖于抽象的观察水平以及系统的初始条件。为了克服这两种困难,作者提出了一种与最大熵分布相比的度量方法。受 Moez mif 和 Christian Müller-Schloer 工作的启发,参考文献[31]建议使用两个概率分布之间的散度来量化涌现。他们将涌现理解为在所观察到的样本基础上的一种意想不到的或不可预测的分布变化。但该方法存在计算量大、估计精度低等缺点。为了解决这些问题,文献[32]进一步提出了一种使用高斯混合模型估计密度的近似方法,并引入马氏距离来表征数据与高斯分量之间的差异,从而得到了更好的结果。此外,Holzer 和 de Meer 等人[33][34]提出了另一种基于香农熵的涌现测量方法。他们认为一个复杂的系统是一个自组织的过程,在这个过程中,不同的个体通过通信相互作用。然后,我们可以根据代理之间所有通信的香农熵度量与作为单独源的香农熵总和之间的比率来测量涌现。

另一种方法是从“整体大于部分之和”的角度来理解涌现的[35][36],该方法从交互规则和主体的状态来定义涌现,而不是从整个系统的总体来进行统计度量。具体地说,这个度量需要使两项相减。第一项描述了整个系统的集体状态,而第二项代表了所有组成部分的单个状态的总和。该度量强调涌现产生于系统的相互作用和集体行为。

基于有效信息的因果涌现理论

历史上,第一个比较完整而明确的利用因果来定义涌现的定量理论当属 Erik Hoel, Larissa Albantakis 以及 Giulio Tononi 三人提出的因果涌现理论[1][2]。该理论针对马尔科夫链定义所谓的因果涌现为:粗粒化后的马尔科夫链比原始的马尔科夫链具有更大的因果效应强度的现象。这里,因果效应强度是通过有效信息来衡量的,该指标是对互信息指标的一种改造,主要差别是将 [math]\displaystyle{ t }[/math] 时刻的状态变量进行了 do 干预,干预成了均匀分布(或最大熵分布)。有效信息指标早在2003年就被 Giulio Tononi 在研究整合信息论的时候提出,作为 Giulio Tononi 的学生 Erik Hoel 将有效信息应用到马尔科夫链中,提出了基于有效信息的因果涌现理论。

基于信息分解的因果涌现理论

此外,2020 年,Rosas 等[37]从信息理论视角出发,提出一种基于信息分解的方法来定义系统中的因果涌现,基于协同信息或者冗余信息来定量的刻画涌现。所谓的信息分解是分析复杂系统中各个变量复杂相互关系的一种新方法,通过对信息进行分解,用信息原子来表示每个部分信息,同时借助信息晶格图将每个部分信息投射到信息原子中,其中协同信息以及冗余信息都可以用对应的信息原子来表示。该方法建立在 Williams 和 Beer 等[38]提出的多元信息非负分解理论的基础之上,文中使用部分信息分解(PID)将微观态和宏观态的互信息进行分解。然而,PID 框架只能分解关于多个源变量和一个目标变量之间的互信息,Rosas 扩展了该框架,提出整合信息分解方法 [math]\displaystyle{ \Phi ID }[/math][39]来处理多个源变量和多个目标变量之间的互信息,作者基于分解后的信息提出了两种因果涌现的定义方法。

近期工作

Barnett 等人[40]基于转移熵,通过判断宏观动力学与微观动力学进行解耦来判断涌现的发生,因而提出了动力学解耦的概念。也就是,将涌现刻画为,宏观的变量与微观的变量相互独立,没有因果关系,这也可以看做是一种因果涌现现象。

2024 年,张江等人[26]基于奇异值分解,提出了一套新的因果涌现理论。该理论的核心思想是指出所谓的因果涌现其实等价于动力学可逆性的涌现。给定一个系统的马尔科夫转移矩阵,通过对它进行奇异值分解,将奇异值的 [math]\displaystyle{ \alpha }[/math] 次方的和定义为马尔科夫动力学的可逆性度量([math]\displaystyle{ \Gamma_{\alpha}\equiv \sum_{i=1}^N\sigma_i^{\alpha} }[/math]),这里 [math]\sigma_i[/math] 为奇异值。该指标与有效信息具有高度的相关性,也可以用于刻画动力学的因果效应强度。根据奇异值的谱,该方法可以在不显式定义粗粒化方案的条件下,直接定义所谓清晰涌现(clear emergence)和模糊涌现(vague emergence)的概念。

因果涌现的量化

接下来,我们重点介绍几种利用因果度量来量化涌现现象的研究。

几种因果涌现理论

对于如何定义因果涌现是一个关键问题,有几个代表性工作,分别是 Hoel 等[1][2]提出的基于有效信息的方法、Rosas 等[37]提出的基于信息分解的方法、张江等人[26]基于奇异值分解提出了一套新的因果涌现理论以及一些其他的理论。

Erik Hoel的因果涌现理论

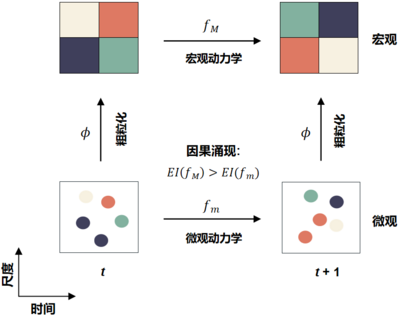

Hoel 等于 2013 年[1][2]提出因果涌现理论,下图是对该理论的一个抽象框架,其中,横坐标表示时间,纵坐标表示尺度(Scale)。该框架可以看成是对同一个动力系统在微观和宏观两种尺度上的描述。其中,[math]f_m[/math] 表示微观动力学,[math]f_M[/math] 表示宏观动力学,二者通过一个粗粒化函数 [math]\phi[/math] 相连。在一个离散状态的马尔科夫动力系统中,[math]f_m[/math] 和 [math]f_M[/math] 都是马尔科夫链,对 [math]f_m[/math] 进行马尔科夫链的粗粒化,就可以得到 [math]f_M[/math]。[math]\displaystyle{ EI }[/math] 是有效信息的度量。由于微观态可能具有更大的随机性,这导致微观动力学的因果性比较弱,所以通过对每一个时刻的微观态进行合理的粗粒化,就有可能得到因果性更强的宏观态。所谓的因果涌现,就是指当我们对微观态进行粗粒化的时候,宏观动力学的有效信息会增加这一现象,并且宏观态与微观态的有效信息之差被定义为因果涌现的强度。

有效信息

有效信息([math]\displaystyle{ EI }[/math])最早由 Tononi 等人在整合信息论的研究中提出[41]。在因果涌现研究中,Erik Hoel 等人将这种因果效应度量指标用于量化一个因果机制的因果性强弱。

具体来说,[math]\displaystyle{ EI }[/math] 的计算为:使用干预操作对自变量做干预,并考察在这一干预下,因和果变量之间的互信息,这种互信息就是有效信息,即因果机制的因果效应度量。

在马尔科夫链中,任意时刻的状态变量 [math]X_t[/math] 都可以看作是原因,而下一时刻的状态变量 [math]X_{t+1}[/math] 就可以看作是结果,这样马尔科夫链的状态转移矩阵就是它的因果机制。因此,针对马尔科夫链的 [math]\displaystyle{ EI }[/math] 的计算公式如下所示:

[math]\displaystyle{

\begin{aligned}

EI(f) \equiv& I(X_t,X_{t+1}|do(X_t)\sim U(\mathcal{X}))\equiv I(\tilde{X}_t,\tilde{X}_{t+1}) \\

&= \frac{1}{N}\sum^N_{i=1}\sum^N_{j=1}p_{ij}\log\frac{N\cdot p_{ij}}{\sum_{k=1}^N p_{kj}}

\end{aligned}

}[/math]

其中 [math]\displaystyle{ f }[/math] 表示一个马尔科夫链的状态转移矩阵,[math]U(\mathcal{X})[/math] 表示状态变量 [math]X_t[/math] 取值空间 [math]\mathcal{X}[/math] 上的均匀分布。[math]\displaystyle{ \tilde{X}_t,\tilde{X}_{t+1} }[/math] 分别为把 [math]\displaystyle{ t }[/math] 时刻的[math]X_t[/math]干预为均匀分布后,前后两个时刻的状态。[math]\displaystyle{ p_{ij} }[/math] 为第 [math]\displaystyle{ i }[/math] 个状态转移到第 [math]\displaystyle{ j }[/math] 个状态的转移概率。从这个式子不难看出,[math]\displaystyle{ EI }[/math] 仅仅是概率转移矩阵 [math]f[/math] 的函数。进行干预操作是为了使得有效信息能客观衡量动力学的因果特性而不受原始输入数据的分布影响。

有效信息可以拆解为确定性和简并性两部分,还可以通过引入归一化从而消除状态空间规模大小的影响。关于有效信息的详细信息请参看词条:有效信息。

为了消除状态数对有效信息的影响,可以定义有效系数概念,公式如下所示:

[math]\displaystyle{

\begin{aligned}

Eff(f) = \frac{EI}{\log_2 N}

\end{aligned}

}[/math]

其中 [math]\displaystyle{ N }[/math]表示状态的数量

因果涌现度量

我们可以通过比较系统中宏微观动力学的有效信息大小来判断因果涌现的发生:

[math]\displaystyle{

CE=EI\left ( f_M \right )-EI\left (f_m \right )

}[/math]

其中 [math]\displaystyle{ CE }[/math] 为因果涌现强度。如果宏观动力学的有效信息大于微观动力学的有效信息(也就是 [math]\displaystyle{ CE\gt 0 }[/math]),那么我们认为在该粗粒化基础上宏观动力学具有因果涌现特性。

进一步,[math]\displaystyle{ CE }[/math]可以拆解成两项之和,[math]\displaystyle{ CE=\Delta I_{Eff}+\Delta I_{Size} }[/math],其中[math]\displaystyle{ \Delta I_{Eff}=(Eff(f_M)-Eff(f_m))\cdot \log_2(M) }[/math],[math]\displaystyle{ \Delta I_{Size}=Eff(f_m)\cdot(\log_2(M)-\log_2(m)) }[/math],其中[math]\displaystyle{ M }[/math]和[math]\displaystyle{ m }[/math]分别表示宏微观的状态大小,由于粗粒化后的宏观状态减小了,[math]\displaystyle{ \Delta I_{Size} }[/math]一定小于 0,为了能发生因果涌现,就要使得[math]\displaystyle{ \Delta I_{Eff} }[/math]的增加大于[math]\displaystyle{ \Delta I_{Size} }[/math]的降低。

马尔科夫链实例

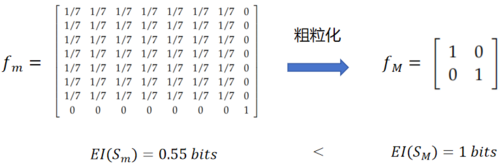

在文献[1]中,Hoel 给出一个含有 8 个状态的马尔科夫链的状态转移矩阵([math]f_m[/math])的例子,如下面左图所示。其中前7个状态之间等概率转移,最后一个状态是独立的,只能转变为自身的状态。

对该矩阵的粗粒化为如下操作:首先,将前 7 个状态归并为一个宏观状态,不妨称为 A,并且将 [math]f_m[/math] 中前 7 行的前 7 列的概率数值加总再除以 7,从而得到宏观态 A 到 A 的状态转移概率,并对 [math]f_m[/math] 矩阵的其它数值保持不变。这样归并后的新的概率转移矩阵如右图所示,记为 [math]f_M[/math] 。这是一个确定的宏观马尔科夫转移矩阵,即系统的未来状态完全可以由当前状态决定。此时 [math]\displaystyle{ EI(f_M\ )\gt EI(f_m\ ) }[/math],系统发生了因果涌现。

然而,对于更一般的马尔科夫链和更一般的状态分组,这种简单的将概率平均化的操作并不都是可行的,这是因为归并后的概率转移矩阵有可能不满足马尔科夫链的条件(如矩阵的行并不满足归一化条件,或元素数值超出 [0,1] 区间范围)。关于什么样的马尔科夫链和状态分组可以得到一个可行的宏观马尔科夫链,请参考本词条后面的马尔科夫链的约简一节,或参看马尔科夫链的粗粒化这一词条。

布尔网络实例

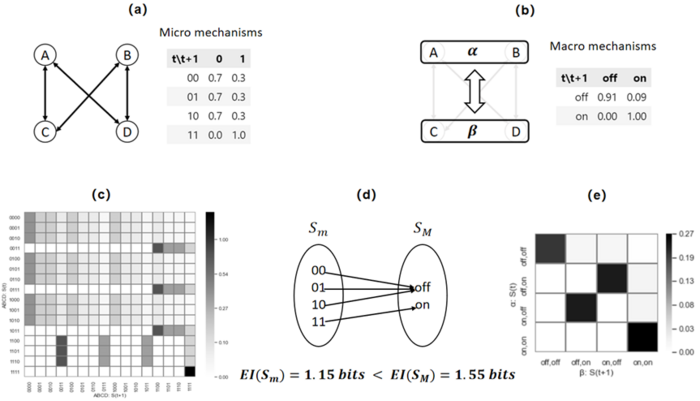

另一个文献[1]中的例子是一个布尔网络中发生因果涌现的例子。如图所示,这是一个含有 4 个节点的布尔网络,每个节点有 0 和 1 两种状态,每个节点与另外两个节点相连,遵循相同的微观动力学机制(a图)。因此,该系统一共含有十六个微观状态,它的动力学可以用一个 [math]\displaystyle{ 16\times16 }[/math] 的状态转移矩阵(c图)表示。

对该系统的粗粒化操作分为两步,第一步是对布尔网络中的节点进行聚类,如下图b所示,将A和B进行合并得到宏观节点 [math]\alpha[/math],C 和 D 进行合并得到宏观节点 [math]\beta[/math];第二步,将每一个分组中的微观节点状态映射为归并后的宏观节点状态,这一映射函数如下图d所示,其中所有包含 0 的微观节点状态都转变为宏观节点的off状态,而微观的 11 状态转变为宏观的 on 状态。这样,我们可以得到一个新的宏观的布尔网络,并根据微观节点的动力学机制得到宏观布尔网络的动力学机制,根据这个机制就可以得到宏观网络的状态转移矩阵(如e图所示)。

通过对比,我们发现宏观动力学的有效信息大于微观动力学的有效信息([math]\displaystyle{ EI(f_M\ )\gt EI(f_m\ ) }[/math]),该系统发生了因果涌现。

连续变量中的因果涌现

进一步,在[42]一文中,Hoel 等人提出了因果几何理论框架,试图将因果涌现理论推广到具有连续状态的函数映射与动力系统之中,该文章对随机函数映射定义了 [math]\displaystyle{ EI }[/math],同时还引入了干预噪音和因果几何的概念,并将这一概念与信息几何进行了对照和类比。刘凯威等人[43]又进一步给出了随机迭代动力系统的精确解析的因果涌现理论。

Rosas的因果涌现理论

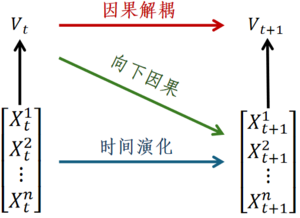

Rosas 等[37]从信息分解理论的视角出发,提出一种基于整合信息分解定义因果涌现的方法,并将因果涌现进一步区分为:因果解耦(Causal Decoupling)和向下因果(Downward Causation)两部分。其中因果解耦表示当前时刻宏观态对下一时刻宏观态的因果效应,向下因果表示上一时刻宏观态对下一时刻微观态的因果效应。因果解耦和向下因果的示意图如下图所示,其中微观状态输入为 [math]\displaystyle{ X_t\ (X_t^1,X_t^2,…,X_t^n ) }[/math],宏观状态是 [math]\displaystyle{ V_t }[/math],它由微观态变量 [math]\displaystyle{ X_t }[/math] 粗粒化而来,因而是 [math]\displaystyle{ X_t }[/math] 的随附特征(Supervenience),[math]\displaystyle{ X_{t+1} }[/math] 和 [math]\displaystyle{ V_{t+1} }[/math] 分别表示下一时刻的微观和宏观状态。

部分信息分解

该方法建立在Williams和Beer等[38]提出的多元信息非负分解理论的基础之上,该文使用部分信息分解(PID)将微观态和宏观态的互信息进行分解。

不失一般性,假设我们的微观态为 [math]\displaystyle{ X(X^1,X^2) }[/math],即它是一个二维的变量,宏观态为 [math]\displaystyle{ V }[/math],则二者之间的互信息可以被分解为四个部分:

[math]\displaystyle{ I(X^1,X^2;V)=Red(X^1,X^2;V)+Un(X^1;V│X^2 )+Un(X^2;V│X^1 )+Syn(X^1,X^2;V) }[/math]

其中 [math]\displaystyle{ Red(X^1,X^2;V) }[/math] 表示冗余信息,是指两个微观态 [math]\displaystyle{ X^1 }[/math] 和 [math]\displaystyle{ X^2 }[/math] 重复地给宏观态 [math]\displaystyle{ V }[/math] 提供的信息;[math]\displaystyle{ Un(X^1;V│X^2 ) }[/math] 和 [math]\displaystyle{ Un(X^2;V│X^1 ) }[/math] 表示特有信息,是指每一个微观态变量单独给宏观态提供的信息;[math]\displaystyle{ Syn(X^1,X^2;V) }[/math] 表示协同信息,是指所有微观态 [math]\displaystyle{ X }[/math] 联合在一起给宏观态 [math]\displaystyle{ V }[/math] 提供的信息。

因果涌现定义

然而,PID 框架只能分解关于多个源变量和一个目标变量之间的互信息,Rosas扩展了该框架,提出整合信息分解方法 [math]\displaystyle{ \Phi ID }[/math][39] 来处理多个源变量和多个目标变量之间的互信息,还可以用来分解不同时刻间的互信息,作者基于分解后的信息提出了两种因果涌现的定义方法:

1)当特有信息 [math]\displaystyle{ Un(V_t;X_{t+1}| X_t^1,\ldots,X_t^n\ )\gt 0 }[/math],表示当前时刻的宏观态 [math]\displaystyle{ V_t }[/math] 能超过当前时刻的微观态 [math]\displaystyle{ X_t }[/math] 给下一时刻的整体系统 [math]\displaystyle{ X_{t+1} }[/math] 提供更多信息,这时候系统存在着因果涌现;

2)第二种方法绕开了选择特定的宏观态 [math]\displaystyle{ V_t }[/math],仅仅基于系统当前时刻的微观态 [math]\displaystyle{ X_t }[/math] 和下一时刻的微观态 [math]\displaystyle{ X_{t+1} }[/math] 之间的协同信息定义因果涌现,当协同信息 [math]\displaystyle{ Syn(X_t^1,…,X_t^n;X_{t+1}^1,…,X_{t+1}^n )\gt 0 }[/math],系统发生了因果涌现。

值得注意的是,对于方法一判断因果涌现的发生需要依赖宏观态 [math]\displaystyle{ V_t }[/math] 的选择,其中方法一是方法二的下界。这是因为,[math]\displaystyle{ Syn(X_t;X_{t+1}\ ) ≥ Un(V_t;X_{t+1}| X_t\ ) }[/math] 衡成立。所以,如果 [math]\displaystyle{ Un(V_t;X_{t+1}| X_t\ ) }[/math] 大于0,则系统出现因果涌现。然而 [math]\displaystyle{ V_t }[/math] 的选择往往需要预先定义粗粒化函数,因此无法回避 Erik Hoel 因果涌现理论的局限。另外一种自然的想法就是使用第二种方法借助协同信息来判断因果涌现的发生,但是协同信息的计算是非常困难的,存在着组合爆炸问题。因此,第二种方法基于协同信息的计算往往也是不可行的。总之,这两种因果涌现的定量刻画方法都存在一些弱点,因此,有待提出更加合理的量化方法。

具体实例

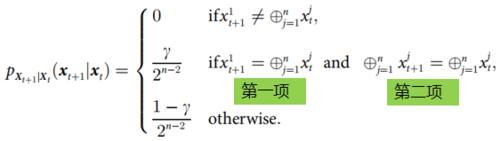

文[37]中作者列举了一个具体的例子(如上式),来说明什么时候发生因果解耦、向下因果以及因果涌现。该例子是一个特殊的马尔科夫过程,这里, [math]\displaystyle{ p_{X_{t+1}|X_t}(x_{t+1}|x_t) }[/math] 表示动力学关系,[math]\displaystyle{ X_t=(x_t^1,…,x_t^n )\in \left\{0,1\right\}^n }[/math] 为微观态。该过程的定义是通过检查前后两个时刻的变量 [math]x_t[/math] 和 [math]x_{t+1}[/math] 的取值,也就是判断 [math]x_t[/math] 的所有维度加和模2是否与 [math]x_{t+1}[/math] 的第一个维度相同来确定下一时刻状态 [math]x_{t+1}[/math] 取不同数值概率的:如果不同,则概率取 0;否则再判断 [math]x_t,x_{t+1}[/math] 在所有维度上是否都有相同的加和模 2 值,如果两个条件都满足,则取值概率为 [math]\gamma/2^{n-2}[/math],否则取值概率为 [math](1-\gamma)/2^{n-2}[/math]。这里 [math]\gamma[/math] 为一个参数, [math]n[/math] 为 x 的总维度。

实际上,如果 [math]\displaystyle{ \sum_{j=1}^n x^j_t }[/math] 是偶数或者 0 时 [math]\displaystyle{ \oplus^n_{j=1} x^j_t:=1 }[/math],反之 [math]\displaystyle{ \oplus^n_{j=1} x^j_t:=0 }[/math],因此 [math]\displaystyle{ \oplus^n_{j=1} x^j_t }[/math] 的结果是 X 整体序列的奇偶性,而第一个维度则可以看作是一个奇偶校验位。[math]\displaystyle{ \gamma }[/math] 实际上表示 X 序列某两个位产生了突变,并且该突变却能够保证整体序列的奇偶性不变,以及序列的奇偶校验位也符合序列整体的实际奇偶性的概率。

因而该过程的宏观态可以就看做是整个序列所有维度和的奇偶性,该奇偶性的概率分布是微观态的异或计算的结果。[math]x_{t+1}^1[/math] 是一个特殊的微观态,它始终与上一时刻序列的宏观态保持一致。因此,当第二个判断条件中只有第一项成立时该系统发生向下因果条件,只有第二项成立时系统发生因果解耦,两项同时成立时则称系统发生因果涌现。

基于奇异值分解的因果涌现理论

Erik Hoel的因果涌现理论存在着需要事先指定粗粒化策略的问题,Rosas 的信息分解理论并没有完全解决该问题,因此,张江等人[26]进一步提出了基于奇异值分解的因果涌现理论。

马尔科夫链的奇异值分解

给定一个系统的马尔科夫转移矩阵 [math]\displaystyle{ P }[/math],我们可以对它进行奇异值分解,得到两个正交且归一化矩阵 [math]\displaystyle{ U }[/math] 和 [math]\displaystyle{ V }[/math],和一个对角阵 [math]\displaystyle{ \Sigma }[/math]:[math]\displaystyle{ P= U\Sigma V^T }[/math],其中 [math]\Sigma=diag(\sigma_1,\sigma_2,\cdots,\sigma_N)[/math],其中 [math]\sigma_1\geq\sigma_2\geq\cdots\sigma_N[/math] 为 [math]\displaystyle{ P }[/math] 的奇异值,并且按照从大到小的顺序排列,[math]\displaystyle{ N }[/math] 为 [math]\displaystyle{ P }[/math] 的状态数量。

近似动力学可逆性与有效信息

我们可以将奇异值的[math]\displaystyle{ \alpha }[/math] 次方之和(也称为矩阵的 [math]\alpha[/math] 阶Schatten范数)定义为马尔科夫链的近似动力学可逆性度量,即:

[math]\displaystyle{

\Gamma_{\alpha}\equiv \sum_{i=1}^N\sigma_i^{\alpha}

}[/math]

这里,[math]\alpha\in(0,2)[/math] 为一个指定的参数,它起到让 [math]\Gamma_{\alpha}[/math] 能够更多地反映确定性还是简并性这样一种权重或倾向性。通常情况下,我们取 [math]\alpha=1[/math],这可以让 [math]\Gamma_{\alpha}[/math] 能够在确定性与简并性之间达到一种平衡。

此外,文献中作者证明了 [math]\displaystyle{ EI }[/math] 与 [math]\Gamma_{\alpha}[/math] 之间存在着一种近似的关系:

[math]\displaystyle{

EI\sim \log\Gamma_{\alpha}

}[/math]

而且,在一定程度上可以用 [math]\Gamma_{\alpha}[/math] 替代 EI 对马尔科夫链的因果效应程度进行度量。因此,所谓的因果涌现也可以被理解为一种动力学可逆性的涌现。

无需粗粒化的因果涌现量化

然而,该理论的最大价值在于无需粗粒化策略,就可以直接量化涌现。如果 [math]\displaystyle{ P }[/math] 的秩为 [math]\displaystyle{ r }[/math],即从第 [math]\displaystyle{ r+1 }[/math] 个奇异值开始,奇异值都为 0,则我们称动力学 [math]\displaystyle{ P }[/math] 存在着清晰的因果涌现(Clear Causal Emergence),并且因果涌现的数值为:

[math]\displaystyle{

\Delta \Gamma_{\alpha} = \Gamma_{\alpha}(1/r-1/N)

}[/math]

如果矩阵 [math]\displaystyle{ P }[/math] 满秩,但是对于任意给定的小数 [math]\displaystyle{ \epsilon }[/math],存在 [math]\displaystyle{ r_{\epsilon} }[/math],使得从 [math]\displaystyle{ r_{\epsilon}+1 }[/math] 开始,所有的奇异值都小于 [math]\displaystyle{ \epsilon }[/math],则称系统存在着程度的模糊的因果涌现(Vague Causal Emergence),且因果涌现的数值为:

[math]\displaystyle{ \Delta \Gamma_{\alpha}(\epsilon) = \frac{\sum_{i=1}^{r} \sigma_{i}^{\alpha}}{r} - \frac{\sum_{i=1}^{N} \sigma_{i}^{\alpha}}{N} }[/math]

总结来看,该定量化因果涌现的方法的好处在于,它可以不依赖于具体的粗粒化策略,因而可以更加客观地量化因果涌现。该方法的缺点是,若要计算 [math]\Gamma_{\alpha}[/math],需要事先对 [math]\displaystyle{ P }[/math] 进行SVD分解,因而计算复杂度为 [math]O(N^3)[/math],比 [math]\displaystyle{ EI }[/math] 的计算复杂度高。而且,[math]\Gamma_{\alpha}[/math] 不能显式地分解为确定度和简并度两个分量。

具体实例

作者给出了四个具体马尔科夫链的例子,该马氏链的状态转移矩阵如图所示。我们可以对比该马氏链的 [math]\displaystyle{ EI }[/math] 和近似动力学可逆性(图中的 [math]\displaystyle{ \Gamma }[/math],即 [math]\displaystyle{ \Gamma_{\alpha=1} }[/math])。对比图 a,b,我们发现对于不同的状态转移矩阵,[math]\displaystyle{ EI }[/math] 降低的时候,[math]\displaystyle{ \Gamma }[/math] 也同步降低。进一步,图 c 和 d 是对比粗粒化前后的效果,其中图 d 是对图 c 状态转移矩阵的粗粒化(将前三个状态归并为一个宏观态)。由于宏观状态转移矩阵图d是一个确定性系统,因此,归一化后的 [math]\displaystyle{ EI }[/math],[math]\displaystyle{ eff\equiv EI/\log N }[/math] 和归一化后的 [math]\Gamma[/math]:[math]\displaystyle{ \gamma\equiv \Gamma/N }[/math] 都达到了最大值 1。

动力学解耦(Dynamic independence)

动力学解耦(Dynamic Independence)是一种刻画粗粒化后的宏观动力学状态独立于微观动力学状态的方法[40],其核心思想是,尽管宏观变量是由微观变量组成,但在预测宏观变量未来状态时,只需要依赖宏观变量历史信息,而不需要微观历史提供额外的信息,这种现象就被作者称为动力学解耦,它是另一种对涌现进行量化的手段,此时的宏观动力学称为涌现动力学。动力学解耦概念中的独立性、因果依赖性等可以通过转移熵(Transfer Entropy)进行量化。

动力学解耦的定量化

转移熵是测量两个随机过程之间有向(时间不对称)信息转移量的一种非参数统计量。过程 [math]\displaystyle{ X }[/math] 到另一个过程 [math]\displaystyle{ Y }[/math] 的转移熵可定义为:在已知 [math]\displaystyle{ Y }[/math] 过去值的情况下,了解 [math]\displaystyle{ X }[/math] 的过去值所能减少对 [math]\displaystyle{ Y }[/math] 未来值不确定性的程度,公式如下所示:

[math]\displaystyle{ T_t(X \to Y) = I(Y_t : X^-_t | Y^-_t) = H(Y_t | Y^-_t) - H(Y_t | Y^-_t, X^-_t) }[/math]

其中,[math]\displaystyle{ Y_t }[/math] 表示 [math]\displaystyle{ t }[/math] 时刻的宏观变量,[math]\displaystyle{ X^-_t }[/math] 和 [math]\displaystyle{ Y^-_t }[/math] 分别表示 [math]\displaystyle{ t }[/math] 时刻之前的微观和宏观变量。[math]I[/math] 为互信息,[math]H[/math] 为香农熵。当且仅当时间 [math]\displaystyle{ t }[/math] 从 [math]\displaystyle{ X }[/math] 到 [math]\displaystyle{ Y }[/math] 的转移熵 [math]\displaystyle{ T_t(X \to Y)=0 }[/math] 时,[math]\displaystyle{ Y }[/math] 相对于 [math]\displaystyle{ X }[/math] 动力学解耦

动力学解耦的概念可以被广泛适用于多种复杂动态系统,包括神经系统、经济过程和进化过程。通过粗粒化方法,可以将高维微观系统简化为低维宏观系统,从而揭示出复杂系统中的涌现结构。

文中,作者在线性系统中进行了实验验证,实验流程是:1)使用线性系统生成参数与规律;2)设定粗粒化函数;3)得到转移熵的表达式;4)优化求解最大去耦合的粗粒化方法(对应最小转移熵)。这里的优化算法可以使用转移熵作为优化目标,然后使用梯度下降算法来求解粗粒化函数,也可以使用遗传算法来优化。

实例

文中举了一个线性动力系统的例子,其动力学是一个向量自回归的模型,通过使用遗传算法对不同的初始条件进行迭代进化,能使得系统的动力学解耦程度也逐渐增加,同时发现不同的粗粒化尺度会影响优化到动力学解耦的程度,实验发现只有在某些尺度下能达到动力学解耦,而在其他尺度则不行,因此尺度的选择也很重要。

几种因果涌现理论比较

我们可以从是否考虑因果、是否需要指定粗粒化函数,适用的动力学系统以及定量化指标这几个不同的维度,对比上述四种不同的定量化因果涌现理论,得到下表:

| 方法 | 是否考虑因果 | 是否涉及粗粒化 | 适用的动力学系统 | 度量指标 |

|---|---|---|---|---|

| Hoel 的因果涌现理论[1] | 动力学因果,EI 定义引入了 do 干预 | 需要指定粗粒化方法 | 离散马尔科夫动力学 | 动力学因果:有效信息 |

| Rosas 的因果涌现理论[37] | 用互信息刻画的相关性近似 | 基于协同信息判断时不涉及粗粒化,基于冗余信息计算则需要指定粗粒化方法 | 任意动力学 | 信息分解:协同信息或冗余信息 |

| 基于可逆性的因果涌现理论[26] | 动力学因果,EI 与近似动力学可逆性等价 | 不依赖于具体的粗粒化策略 | 离散马尔科夫动力学 | 近似动力学可逆性:[math]\displaystyle{ \Gamma_{\alpha} }[/math] |

| 动力学解耦[40] | 格兰杰因果 | 需要指定粗粒化方法 | 任意动力学 | 动力学独立性:转移熵 |

因果涌现的识别

前面已经介绍了一些通过因果度量和其他信息论指标来量化涌现的工作。然而,在实际应用中,我们往往只能收集到观测数据,而无法得到系统的真实动力学。因此,从可观测数据中辨别系统是否发生了因果涌现是一个更为重要的问题。下面介绍两种因果涌现的识别方法,包括基于 Rosas 因果涌现理论的近似方法(基于互信息近似的方法和基于机器学习的方法)和我国学者提出的神经信息压缩(NIS,NIS+)方法。

基于 Rosas 因果涌现理论的近似方法

Rosas 的因果涌现理论包含了基于协同信息的量化方法和基于特有信息的量化方法,其中第二种方法可以绕开多变量的组合爆炸问题,但是依赖粗粒化方法和宏观态变量 [math]\displaystyle{ V }[/math] 的选择。为了解决这个问题,作者给出了两种解决方案,一种是通过研究者指定一个宏观态 [math]\displaystyle{ V }[/math],另一种是基于机器学习的方法,通过最大化 [math]\displaystyle{ \mathrm{\Psi} }[/math],让系统自动学习到宏观态变量 [math]\displaystyle{ V }[/math]。下面我们分别介绍这两种方法:

基于互信息近似的方法

Rosas 的因果涌现理论虽然已经给出了因果涌现的严格定义,但在计算中涉及到很多变量的组合爆炸问题,因此难以将该方法应用于实际系统。为了解决这个问题,Rosas 等绕开了特有信息和协同信息的精确计算[37],而提了一种只需要计算互信息的近似公式,并推导出一个判定因果涌现发生的充分条件。

作者们基于互信息提出了三个新指标,[math]\displaystyle{ \mathrm{\Psi} }[/math] ,[math]\displaystyle{ \mathrm{\Delta} }[/math] 和 [math]\displaystyle{ \mathrm{\Gamma} }[/math] 可以分别用于识别系统中的因果涌现、因果解耦和向下因果,三种指标的具体计算公式分别如下所示:

- 判断因果涌现的指标:

-

[math]\displaystyle{ \Psi_{t, t+1}(V):=I\left(V_t ; V_{t+1}\right)-\sum_j I\left(X_t^j ; V_{t+1}\right) }[/math]

(1)

其中 [math]\displaystyle{ X_t^j }[/math] 表示第 j 维 t 时刻的微观变量,[math]\displaystyle{ V_t ; V_{t+1} }[/math] 分别代表两个连续时间的宏观状态变量。Rosas 等人定义,当 [math]\displaystyle{ \mathrm{\Psi}\gt 0 }[/math] 时,系统发生涌现;但是当 [math]\displaystyle{ \mathrm{\Psi}\lt 0 }[/math],我们不能确定 [math]\displaystyle{ V }[/math] 是否发生涌现,这是因为该条件仅仅是因果涌现发生的充分条件。

- 判断向下因果的指标:

[math]\displaystyle{ \Delta_{t, t+1}(V):=\max _j\left(I\left(V_t ; X_{t+1}^j\right)-\sum_i I\left(X_t^i ; X_{t+1}^j\right)\right) }[/math]

当 [math]\displaystyle{ \mathrm{\Delta}\gt 0 }[/math] 时,宏观状态 [math]\displaystyle{ V }[/math] 对微观变量 [math]\displaystyle{ X }[/math] 存在向下因果。

- 判断因果解耦的指标:

[math]\displaystyle{ \Gamma_{t, t+1}(V):=\max _j I\left(V_t ; X_{t+1}^j\right) }[/math]

当 [math]\displaystyle{ \mathrm{\Delta}\gt 0 }[/math] 且 [math]\displaystyle{ \mathrm{\Gamma}=0 }[/math] 时,系统发生因果涌现且存在因果解耦。

之所以我们可以使用 [math]\displaystyle{ \mathrm{\Psi} }[/math] 来识别因果涌现的发生,是因为 [math]\displaystyle{ \mathrm{\Psi} }[/math] 又是特有信息的下界,我们有如下关系:

[math]\displaystyle{ Un(V_t;X_{t+1}|X_t) ≥ I\left(V_t ; V_{t+1}\right)-\sum_j I\left(X_t^j ; V_{t+1}\right) + Red(V_t, V_{t+1};X_t) }[/math]

由于 [math]\displaystyle{ Red(V_t, V_{t+1};X_t) }[/math] 为非负数,所以我们可以据此提出一个充分非必要条件:当 [math]\displaystyle{ \Psi_{t, t+1}(V) \gt 0 }[/math]。

总结来看,该方法因为是基于互信息的,所以计算比较方便,且对系统的动力学没有马尔科夫性的假设和要求。但是,该理论也存在很多缺点:1)该方法提出的三个指标:[math]\displaystyle{ \mathrm{\Psi} }[/math] ,[math]\displaystyle{ \mathrm{\Delta} }[/math] 和[math]\displaystyle{ \mathrm{\Gamma} }[/math] 只是基于互信息的计算而没有考虑因果;2)该方法得到的仅仅是发生因果涌现的充分条件;3)该方法依赖宏观变量的选择,而不同的选择会对结果造成不同的显著影响;4)当系统具有大量冗余信息,或具有许多变量时,该方法的计算复杂度就会很高,同时由于 [math]\displaystyle{ \Psi }[/math] 为近似计算,因此这会让高维系统存在非常大的误差,而且还非常容易得到负值,从而无法判断是否有因果涌现发生。

为了验证猕猴运动有关的信息是其皮层活动的一个涌现特征,Rosas 等做了如下实验:基于猕猴的皮质脑电图(ECoG)作为微观动力学的观测数据。为了得到宏观态变量 [math]\displaystyle{ V }[/math],作者们选择了用动作捕捉(MoCap)得到的猕猴肢体运动轨迹的时间序列数据,其中 ECoG 和 MoCap 分别由 64 个通道和 3 个通道的数据构成的。由于最原始的 MoCap 数据不满足随附特征的条件独立假设,因此,他们利用偏最小二乘和支持向量机算法,推断出与预测猕猴行为有关的编码在 ECoG 信号中的那部分神经活动,并推测该信息是潜在神经活动的涌现特征。最后,作者们基于微观状态和计算所得的宏观特征,验证了因果涌现的存在。

基于机器学习的方法

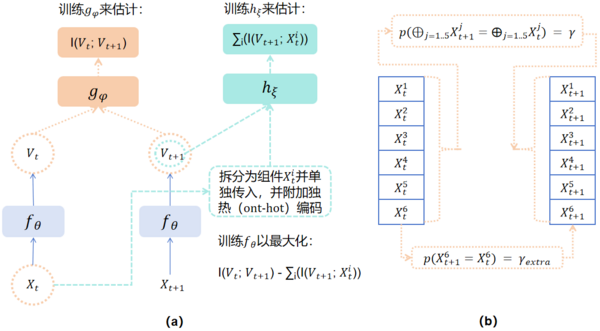

Kaplanis 等人[26]基于表示机器学习(Representation learning)的理论方法,用算法通过最大化 [math]\displaystyle{ \mathrm{\Psi} }[/math](即公式1)而自发学习到宏观态变量 [math]\displaystyle{ V }[/math] 变量。具体的,作者们使用神经网络 [math]\displaystyle{ f_{\theta} }[/math] 来学习将微观输入 [math]\displaystyle{ X_t }[/math] 粗粒化成宏观输出 [math]\displaystyle{ V_t }[/math] 的表示函数,同时使用神经网络 [math]\displaystyle{ g_{\phi} }[/math] 和 [math]\displaystyle{ h_{\xi} }[/math] 来分别学习 [math]\displaystyle{ I(V_t;V_{t+1}) }[/math] 和 [math]\displaystyle{ \sum_i(I(V_{t+1};X_{t}^i)) }[/math] 等互信息的计算,最后该方法通过最大化两者之间的差(即 [math]\displaystyle{ \mathrm{\Psi} }[/math])来优化神经网络。该神经网络系统的架构图如下图a所示。

图b展示了一个 toy 模型实例,微观输入 [math]\displaystyle{ X_t(X_t^1,...,X_t^6) \in \left\{0,1\right\}^6 }[/math] 存在 6 个维度,每个维度存在 0 和 1 两种状态,[math]\displaystyle{ X_{t+1} }[/math] 是 [math]\displaystyle{ X_{t} }[/math] 的下一时刻输出,宏观态为 [math]\displaystyle{ V_{t}=\oplus_{i=1}^{5}X_t^i }[/math],其中 [math]\displaystyle{ \oplus_{i=1}^{5}X_t^i }[/math] 表示微观输入 [math]\displaystyle{ X_t }[/math] 前 5 个维度加和模 2 的结果,前后两个时刻的宏观态存在 [math]\displaystyle{ \gamma }[/math] 概率相等([math]\displaystyle{ p(\oplus_{j=1..5}X_{t+1}^j=\oplus_{j=1..5}X_t^j)= \gamma }[/math]),微观输入的前后两个时刻的第6个维度以 [math]\displaystyle{ \gamma_{extra} }[/math] 概率的可能性相等([math]\displaystyle{ p(X_{t+1}^6=X_t^6)= \gamma_{extra} }[/math])。

结果表明,在图b所示的简单例子中,通过图a构建的模型最大化 [math]\displaystyle{ \mathrm{\Psi} }[/math],实验发现学习出来的 [math]\displaystyle{ \mathrm{\Psi} }[/math] 和真实的 groundtruth [math]\displaystyle{ \mathrm{\Psi} }[/math] 近似相等验证了模型学习的有效性,该系统能够正确地判断出因果涌现的发生。但是该方法也存在着难以应对复杂多变量情形的问题,这是因为图中的右侧的神经网络数量是正比于宏微观变量对的数量的,因此微观变量数(维度)越多,则神经网络的数量就会成比例增长,这会导致计算复杂度的提升。此外,该方法仅在很少的案例上进行测试,因此尚无法规模化。最后,更主要的是,因为网络计算的是因果涌现的近似指标,且得到的是涌现的充分非必要条件,所以上述近似算法的各种弊端会被此方法继承。

神经信息压缩方法

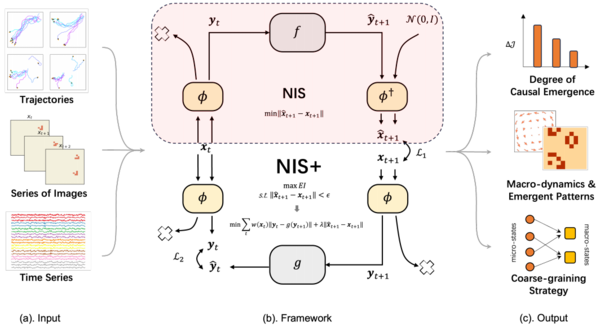

近年来,新兴的人工智能技术已经攻克一系列重大难题,同时机器学习方法配备了各种精心设计的神经网络结构和自动微分技术,可以在巨大的函数空间中逼近任何函数。因此,张江等尝试基于神经网络提出一种基于数据驱动的能够从时间序列数据中识别因果涌现的方法[44][40],该方法能自动提取有效的粗粒化策略和宏观动力学,克服了 Rosas 方法[37]的种种不足。

在该工作中,输入的是时间序列数据 [math]\displaystyle{ (X_1,X_2,...,X_T ) }[/math],且[math]\displaystyle{ X_t\equiv (X_t^1,X_t^2,…,X_t^p ) }[/math],[math]\displaystyle{ p }[/math] 表示输入数据的维数。作者假设,这组数据是由一个一般的随机动力系统产生:

[math]\displaystyle{ \frac{d X}{d t}=f(X(t), \xi) }[/math]

其中 [math]X(t)[/math] 是微观状态变量,[math]f[/math] 是微观动力学,[math]\displaystyle{ \xi }[/math] 表示系统动力学中的噪音,可以建模动力系统中的随机特性。但是,[math]\displaystyle{ f }[/math] 是未知的。

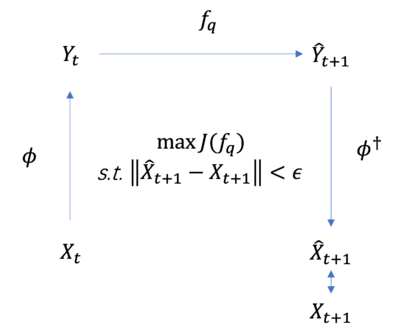

所谓的因果涌现识别问题是指这样的一个泛函优化问题:

-

[math]\displaystyle{ \begin{aligned}&\max_{\phi,f_{q},\phi^{\dagger}}\mathcal{J}(f_{q}),\\&s.t.\begin{cases}\parallel\hat{X}_{t+1}-X_{t+1}\parallel\lt \epsilon,\\\hat{X}_{t+1}=\phi^{\dagger}\left(f_{q}(\phi(X_{t})\bigr)\right).\end{cases}\end{aligned} }[/math]

(2)

这里,[math]\mathcal{J}[/math] 为维度平均的 [math]\displaystyle{ EI }[/math](参见有效信息词条),[math]\displaystyle{ \mathrm{\phi} }[/math] 为粗粒化策略函数,[math]\displaystyle{ f_{q} }[/math] 为宏观动力学,[math]\displaystyle{ q }[/math] 为粗粒化后的宏观态维度,[math]\hat{X}_{t+1}[/math] 是整个框架对 [math]\displaystyle{ t+1 }[/math] 时刻的微观态的预测,这一预测是将 [math]\displaystyle{ t+1 }[/math] 时刻的宏观态预测 [math]\hat{Y}_{t+1}[/math] 进行反粗粒化操作([math]\phi^{\dagger}[/math] 为反粗粒化函数)得到;这里 [math]\hat{Y}_{t+1}\equiv f_q(Y_t)[/math] 为动力学学习器根据 [math]\displaystyle{ t }[/math] 时刻的宏观态 [math]Y_t[/math] 对 [math]\displaystyle{ t+1 }[/math] 时刻宏观态的预测,其中 [math]Y_t\equiv \phi(X_t)[/math] 为 [math]\displaystyle{ t }[/math] 时刻的宏观态,它是对 [math]X_t[/math] 进行粗粒化 [math]\phi[/math] 而得来。最后,将 [math]\hat{X}_{t+1}[/math] 与真实的微观态数据 [math]X_{t+1}[/math] 进行求差比较,即得到微观的预测误差。

整个优化框架如下图所示:

这一优化问题的目标函数为 [math]\displaystyle{ EI }[/math],它是函数 [math]\phi,\hat{f}_q,\phi^{\dagger}[/math] 的泛函(这里宏观维度 [math]q[/math] 是超参),因此较难优化,我们需要使用机器学习的方法来尝试解决。

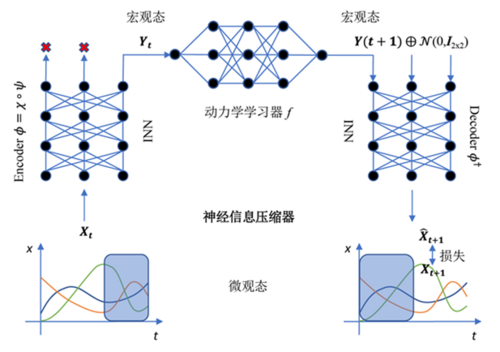

NIS

为了识别系统中的因果涌现,作者提出一种神经信息压缩器(Neural Information Squeezer,NIS)神经网络架构[44],该架构基于一种编码器-动力学学习器-解码器框架,即模型由三个部分构成,分别用于对原始数据进行粗粒化得到宏观态、拟合宏观动力学和反粗粒化运算(将宏观态配合随机噪声解码为微观态)。其中,作者们用可逆神经网络(INN)构建编码器(Encoder)和解码器(Decoder),分别近似对应粗粒化函数[math]\phi[/math]和反粗粒化函数 [math]\phi^{\dagger}[/math]。之所以采用可逆神经网络是因为我们可以简单倒置该网络就可以得到反粗粒化函数(即 [math]\phi^{\dagger}\approx \phi^{-1}[/math])。该模型框架可以看成是一个神经信息压缩器,将包含噪音的微观态数据置入一个狭窄的信息通道,压缩成宏观态,丢弃无用的信息,从而使得宏观动力学的因果性更强,之后再解码成微观状态的预测。NIS方法的模型框架如下图所示:

具体的,编码器函数 [math]\phi[/math] 由两部分构成:

[math]\displaystyle{

\phi\equiv \chi\circ\psi

}[/math]

其中 [math]\psi[/math] 为一个可逆函数,由一个可逆神经网络来实现,[math]\chi[/math] 为投影函数,即去除 [math]p[/math] 维向量中的后 [math]p-q[/math] 个维度分量,这里 [math]p,q[/math] 分别为微观态和宏观态的维度。[math]\circ[/math] 为函数的合成操作。

解码器为函数 [math]\phi^{\dagger}[/math],它定义为:

[math]\displaystyle{

\phi^{\dagger}(y)\equiv \psi^{-1}(y\bigoplus z)

}[/math]

这里 [math]z\sim\mathcal{Ν}\left (0,I_{p-q}\right )[/math] 为一个 [math]p-q[/math] 维随机向量,服从标准正态分布。

然而,如果我们直接优化维度平均的有效信息会存在着一定的困难,文章[44]并没有直接优化公式1,而是采用了一种取巧的方法。为了解决这个问题,作者将优化过程分为两个阶段,第一个阶段为在给定宏观尺度 [math]\displaystyle{ q }[/math] 的情况下最小化微观态预测误差,即 [math]\displaystyle{ \min _{\phi, f_q, \phi^{\dagger}}\left\|\phi^{\dagger}(Y(t+1))-X_{t+1}\right\|\lt \epsilon }[/math] 并得到最优的宏观态动力学 [math]f_q^\ast[/math];第二阶段为搜索超参 [math]\displaystyle{ q }[/math],使得有效信息 [math]\mathcal{J}[/math] 能够最大化,即 [math]\displaystyle{ \max_{q}\mathcal{J}(f_{q}^\ast) }[/math] 。实践证明,这种方法可以有效地找到宏观动力学和粗粒化函数,但是并不能真正地事先使 EI 最大化。

除了能基于时序数据自动识别因果涌现,该框架还有很好的理论性质,其中有两个重要定理:

定理一:神经信息挤压器的信息瓶颈,即对于任意的双射 [math]\displaystyle{ \mathrm{\psi} }[/math]、投影 [math]\displaystyle{ \chi }[/math]、宏观动力学 [math]\displaystyle{ f }[/math]以及高斯噪音 [math]\displaystyle{ z_{p-q}\sim\mathcal{Ν}\left (0,I_{p-q}\right ) }[/math],

[math]\displaystyle{

I\left(Y_t;Y_{t+1}\right)=I\left(X_t;{\hat{X}}_{t+1}\right)

}[/math]

恒成立,这意味着,编码器丢弃的所有信息实际上都是与预测无关的噪声信息。

定理二:对于一个训练好的模型,[math]\displaystyle{ I\left(X_t;{\hat{X}}_{t+1}\right)\approx I\left(X_t;X_{t+1}\right) }[/math],因此,综合定理一和定理二,我们可以得到对于一个训练好的模型:

[math]\displaystyle{ I\left(Y_t;Y_{t+1}\right)\approx I\left(X_t;X_{t+1}\right) }[/math]

与经典理论的比较

NIS框架与前面章节中提到的计算力学框架存在很多相似之处,NIS 可以被视为一种 [math]\displaystyle{ \epsilon }[/math]- machine。计算力学中的所有历史过程构成的集合 [math]\displaystyle{ \overleftarrow{S} }[/math] 可以被看作是微观状态,所有 [math]\displaystyle{ R \in \mathcal{R} }[/math] 表示宏观状态,函数 [math]\displaystyle{ \eta }[/math] 可以理解为一种粗粒化函数,[math]\displaystyle{ \epsilon }[/math] 可以理解为一种有效的粗粒化策略,[math]\displaystyle{ T }[/math] 对应于有效的宏观动力学。最小随机性指标特征表征了宏观动力学的确定性,在因果涌现中可以用有效信息替代。当整个框架训练充分的时候,可以精确地预测未来的微观状态时,编码的宏观状态收敛到有效状态,而有效状态可以被视为计算力学中的因果态。

同时NIS框架与前面提到的 G-emergence 理论也有相似之处,例如,NIS同样采用了格兰杰因果的思想:通过预测下一个时间步的微观状态来优化有效的宏观状态。然而,这两个框架之间有几个明显的区别:a)在 G-emergence 理论中,宏观状态需要人工选择,而NIS则是通过自动优化粗粒化策略来得到宏观状态的;b)NIS使用神经网络来预测未来状态,而 G-emergence 使用自回归技术来拟合数据。

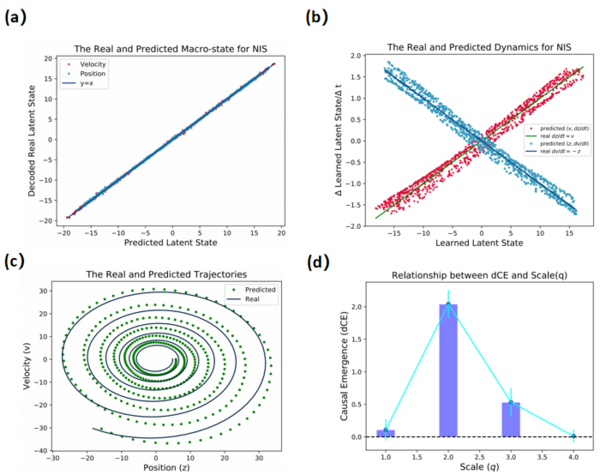

计算实例

NIS 作者在弹簧振子模型中进行了实验,结果如下图所示,图a展示下一时刻通过编码的结果与通过宏观动力学的迭代结果线性重合验证了模型的有效性,图 b 展示了学习到的两个动力学和真实的动力学同样重合,进一步验证了模型的有效性,图 c 是模型多步预测的效果,预测和真实的曲线很接近,图 d 展示了不同尺度下的因果涌现大小,发现在尺度为2时因果涌现最显著,对应了真实的弹簧振子模型也只需要两个状态(位置和速度)就可以描述整个系统。

NIS+

NIS 虽然率先提出了对 EI 进行优化,从而在数据中辨识因果涌现的方案,但是该方法存在一些不足:作者将优化过程分为两个阶段,但是并没有真正的最大化有效信息,即公式1。因此,杨明哲等人[40]进一步改进该方法,提出了 NIS+ 方案,通过引入反向动力学以及重加权技术,借助变分不等式将原始的最大化有效信息转换成最大化其变分下界来直接优化目标函数。

数学原理

具体地,根据变分不等式和逆概率加权方法,公式2所给出的带约束的优化问题可以转变为如下不带约束的最小化问题:

[math]\displaystyle{ \min_{\omega,\theta,\theta'} \sum_{i=0}^{T-1}w(\boldsymbol{x}_t)||\boldsymbol{y}_t-g_{\theta'}(\boldsymbol{y}_{t+1})||+\lambda|| \hat{\boldsymbol{x}}_{t+1}-\boldsymbol{x}_{t+1} || }[/math]

其中 [math]\displaystyle{ g }[/math] 是反向动力学,它可以通过神经网络来近似,并通过宏观态的数据对[math]y_{t+1},y_{t}[/math]训练得到。[math]\displaystyle{ w(x_t) }[/math] 为逆概率权值,具体计算方式如下所示:

[math]\displaystyle{

w(\boldsymbol{x}_t)=\frac{\tilde{p}(\boldsymbol{y}_t)}{p(\boldsymbol{y}_t)}=\frac{\tilde{p}(\phi(\boldsymbol{x}_t))}{p(\phi(\boldsymbol{x}_t))}

}[/math]

其中 [math]\displaystyle{ \tilde{p}(\boldsymbol{y}_{t}) }[/math] 是目标分布,[math]\displaystyle{ p(\boldsymbol{y}_{t}) }[/math] 是数据的原始分布。

工作流与模型架构

下图展示了 NIS+ 的整个模型框架,图 a 是模型的输入:时间序列数据,可以是轨迹序列、连续图像序列以及脑电时间序列数据等;图c是模型的输出,包括因果涌现的程度、宏观动力学、涌现模式以及粗粒化策略;图b是具体的模型架构,区别于 NIS 方法,增加了反向动力学和重加权技术两部分。

实例分析

文章对不同的时间序列数据集进行了实验,包括疾病传播动力系统模型SIR动力学、鸟群模型(Boids模型)和元胞自动机:生命游戏所生成的数据,以及真实人类被试的脑神经系统fMRI信号数据,这里我们选择鸟群和脑信号分别实验进行介绍说明。

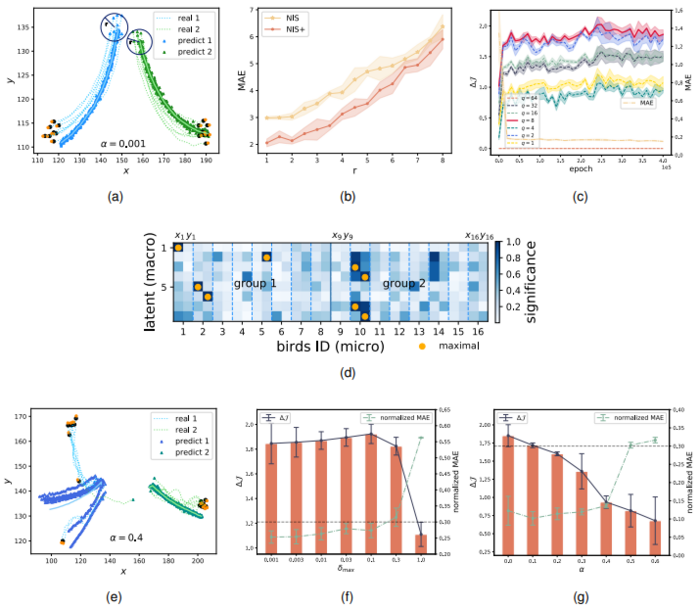

下图为 NIS+ 学习 Boids 模型的群集行为的实验结果。(a)和(e)给出了不同条件下鸟群的实际和预测轨迹。具体来说,作者将鸟群分为两个组,并且比较了在不同噪声水平([math]\displaystyle{ \alpha }[/math] 分别为 0.001 和 0.4)下的多步预测结果,在噪音比较小时预测很好,在噪音比较大时预测曲线会发散。(b)展示了多步预测的平均绝对误差(MAE)随着半径 r 的增加而逐渐上升。(c)展示了不同维度(q)下的因果涌现度量 [math]\displaystyle{ \Delta J }[/math] 与预测误差(MAE)随着训练 epoch 的变化,作者发现在宏观态维度 q = 8 时因果涌现最显著。(d)为宏观变量对微观变量进行归因分析,得到的显著性图,直观地描述了学习得到的粗粒化函数。其中,每个宏观维度可以对应到每只鸟的空间坐标(微观维度),颜色越深表示关联度越高。这里用橙色点突出了每个宏观状态维度最大关联所对应的微观坐标,这些归因显著性值是使用的积分梯度(Integrated Gradient,简称 IG)方法得到的。横轴表示 16 只鸟在微观状态下的 x 和 y 坐标,纵轴表示 8 个宏观维度。淡蓝色的虚线区分了不同个体 Boid 的坐标,而蓝色实线分隔了两个鸟群。(f)和(g)表示不同噪声水平下因果涌现度量 [math]\displaystyle{ \Delta J }[/math] 和归一化误差MAE的变化趋势,(f)表示外部噪声的变化(即观测噪音加入到微观数据)对因果涌现的影响, (g)表示内在噪声(用 [math]\displaystyle{ \alpha }[/math] 表示,通过修改 Boids 模型的动力学加入)对因果涌现的影响。在(f)和(g)中,水平线表示违反公式 1 中误差约束的阈值。当归一化 MAE 大于阈值 0.3 时,约束遭到破坏,结果不可靠。

这组实验表明,NIS+可以通过最大化EI来学习宏观状态和粗粒化策略。这种最大化增强了模型对超出训练数据范围情况的泛化能力。学习到的宏观状态有效地识别了平均群体行为,并且可以使用梯度积分方法将其归因于个体位置。此外,因果涌现的程度随外在噪声的增加而增加,而随内在噪声的增加而减少。这一观察结果表明,模型通过粗粒化可以消除外在噪声,而不能削减内在噪声。

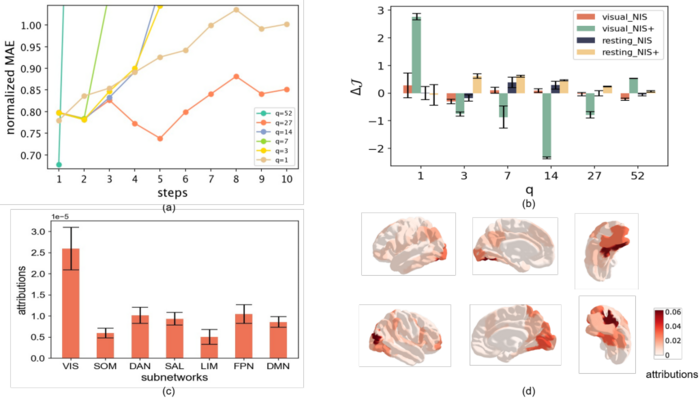

脑实验是基于真实的 fMRI 数据,该数据通过对 830 个人类被试做了两组实验得到。第一组是让被试执行看一段电影短片的视觉任务记录完成,第二组实验是让他们处于静息态下记录完成。由于原始维度比较高,作者们首先通过使用 Schaefer atlas 方法对原始的 14000 维数据降维到 100 个维度,每个维度对应一个脑区。之后,作者们通过 NIS+ 学习这些数据,并提炼出 6 个不同宏观尺度下的动力学,图 a 展示了不同尺度下的多步预测误差结果,图 b 展示了在静息态和看电影视觉任务中 NIS 与 NIS+ 方法在不同宏观维度上 EI 的对比。作者们发现在视觉任务中,宏观态维度在 q=1 时因果涌现最显著,通过归因分析发现视觉区发挥的作用最大(图 c),与真实的场景保持一致。图d展示了脑区归因的不同视角图。而在静息态下,1 个宏观维度不足以预测微观时间序列数据,因果涌现最大的维度是表现在 3-7 维之间。

这些实验表明 NIS+ 不仅可以辨识数据中的因果涌现、发现涌现的宏观动力学和粗粒化策略,而且另外的实验还表明,NIS+ 模型还能够通过 EI 最大化而增加模型的分布外泛化能力。

应用

本小节主要讲解因果涌现在各个复杂系统中的潜在应用, 包括: 生物系统、神经网络、脑神经系统、人工智能(因果表示学习、基于世界模型的强化学习、因果模型抽象)以及在一些其他的潜在应用(包括意识研究和中国古典哲学)等。

复杂网络中的因果涌现

2020 年,Klein 和 Hoel 改进马尔科夫链上定量化因果涌现的方法以应用到复杂网络中[45],作者借助随机游走子来定义网络中的马尔科夫链,将随机游走子放在节点上等价于对节点做干预,然后基于随机游走概率定义节点间的转移概率矩阵。同时作者将有效信息与网络的连通性建立联系,连通性可以通过节点的出边和入边的权重的不确定性来表征,基于此定义复杂网络中的有效信息。详细方法可以参考复杂网络中的因果涌现。

作者在随机网络(ER)、偏好依附网络模型(PA)等人工网络以及四类真实网络中进行了实验比较,发现:对于ER网络来说,有效信息的大小只依赖于连接概率 [math]\displaystyle{ p }[/math],并且随着网络规模的增大会收敛到数值 [math]\displaystyle{ -\log_2p }[/math]。同时一个关键发现表明,EI数值存在一个相变点,该相变点近似在网络的平均度([math]\displaystyle{ \lt k\gt }[/math])等于 [math]\displaystyle{ \log_2N }[/math] 的位置出现,同样对应于ER网络随着连接概率增加而出现巨连通集团的相变点位置,超过该相变点随机网络结构不会随着其规模的增加而包含更多的信息。对于偏好依附模型网络来说,当网络度分布的幂律指数 [math]\displaystyle{ \alpha\lt 1.0 }[/math] 时,有效信息的大小会随着网络规模的增加而增大;当 [math]\displaystyle{ \alpha\gt 1.0 }[/math] 时,结论相反;[math]\displaystyle{ \alpha=1.0 }[/math] 刚好对应的无标度网络则是增长的临界边界。对于真实网络来说,作者们发现,生物网络因为具有很大的噪音,所以有效信息最低。然而,我们可以通过有效的粗粒化去除这些噪音,这就使得生物网络相比于其他类型网络能够展现出更显著的因果涌现现象;而因为技术类型网络是更稀疏、非退化,因此,平均效率更高,节点关系也更加具体,所有有效信息也最高,但是难以通过粗粒化来增加因果涌现度量。

在该文章中,作者使用贪婪算法来粗粒化网络,然而对于大规模网络来说,这种算法效率很低。随后,Griebenow 等[46]提出了一种基于谱聚类的方法来识别偏好依附网络中的因果涌现。相比贪婪算法以及梯度下降算法,谱聚类算法的计算时间更少,同时找到的宏观网络的因果涌现也更加显著。

在生物网络上的应用

进一步,Klein 等人将复杂网络中的因果涌现方法扩展到了更多的生物网络中。前文已经指出,生物网络具有更大的噪音,这使得我们很难理解其内部的运作原理,这种噪音一方面来自系统的固有噪音,另一方面是由于测量或观察引入的。Klein 等[47]进一步探索了生物网络中的噪声、简并性和确定性三者之间的关系以及具体含义,得出了一些有趣的结论。

例如,基因表达网络中的高确定性可以理解为一个基因几乎肯定会导致另一个基因的表达。同时生物系统在进化过程中也普遍存在高简并性现象。这两个因素共同导致,目前人们尚不清楚应该在何种尺度上分析生物系统才能更好理解它们的功能。Klein 等[48]分析了超过 1800 个物种的蛋白质相互作用网络,发现宏观尺度的网络具有更小的噪音和简并性,同时与不参与宏观尺度的节点相比,组成宏观尺度网络中的节点更具有弹性。因此,生物网络为了适应进化的要求,需要演化出宏观尺度以提高确定性来增强网络弹性以及提高信息传输的有效性。

Hoel 等在文章[49]中借助有效信息理论进一步研究了生物系统中的因果涌现。作者将有效信息应用到基因调控网络上,以识别最能提供信息的心脏发育模型从而控制哺乳动物的心脏发育。通过量化酿酒酵母基因网络的最大联通集团中的因果涌现,文章揭示了富有信息的宏观尺度在生物学中是普遍存在的,以及生命机制本身也经常运行在宏观尺度上。该文章也为生物学家提供了一种可计算的工具来识别最具有信息的宏观尺度,并且可以在此基础上建模、预测、控制和理解复杂的生物系统。

Swain 等在文章[50]中探索了蚁群的交互历史对任务分配和任务切换的影响,使用有效信息研究噪声如何在蚂蚁之间传播。结果发现,蚁群之间历史交互程度影响任务的分配,并且具体交互中蚂蚁群体的类型决定了交互中的噪音。此外,即使当蚂蚁切换功能群时,蚁群涌现出来的凝聚力也能保证群体的稳定,同时不同功能蚁群在维持蚁群凝聚力方面也发挥着不同的作用。

在人工神经网络上的应用

Marrow 等人在文章[51]中尝试将有效信息引入神经网络,来量化和跟踪训练过程中神经网络因果结构的变化,其中有效信息用于评估节点和边对每层下游目标的因果的影响程度,这里每层神经网络的有效信息 EI 定义为:

[math]\displaystyle{

I(L_1;L_2|do(L_1=H^{max}))

}[/math]

这里的 [math]\displaystyle{ L_1 }[/math] 和 [math]\displaystyle{ L_2 }[/math] 分别表示连接神经网络的输入和输出层,这里将输入层整体do成均匀分布,然后计算因和果之间的互信息。有效信息可以被分解为灵敏性和简并性,这里的灵敏性定义为:

[math]\displaystyle{

\sum_{(i \in L_1,j \in L_2)}I(t_i;t_j|do(i=H^{max}))

}[/math]

这里 i,j 分别代表输入层和输出层的任意神经元组合,[math]\displaystyle{ t_i }[/math] 和 [math]\displaystyle{ t_j }[/math] 分别表示输入和输出层中的神经元在神经网络机制不变的条件下,干预 i 为最大熵分布后的状态组合。也就是说,如果干预输入神经元 i 为均匀分布,则输出神经元也会发生改变,那么这一数值即度量二者之间的互信息。

这里应该区别于有效信息的定义,这里是对输入层中的每一个神经元分别进行do干预,然后将每两个神经元计算出来的互信息进行累加作为灵敏性的定义,简并性通过有效信息与灵敏性的差得到,定义为:

[math]\displaystyle{

I(L_1;L_2|do(L_1=H^{max}))-\sum_{(i \in L_1,j \in L_2)}I(t_i;t_j|do(i=H^{max}))

}[/math]

通过观察模型训练过程中的有效信息,包括灵敏性和简并性的变化,就可以知道模型的泛化能力,从而帮助学者更好的理解和解释神经网络的工作原理。

在脑神经系统上的应用

脑神经系统是一个涌现的多尺度复杂系统,Luppi 等人[52]基于整合信息分解,揭示了人类意识的协同工作空间。作者构建了脑认知的三层架构,包括:外部环境、具体的模块以及协同全局空间。大脑的工作原理主要包括三个阶段:第一个阶段负责将来自多个不同模块的信息收集到工作空间中,第二个阶段负责在工作空间中整合收集到的信息,第三个阶段负责将全局信息广播到大脑的其他部分。作者在三类不同静息态的 fMRI 数据上进行实验,包括 100 个正常人、15 个参与麻醉实验的被试者(包括麻醉前、麻醉以及恢复三种不同状态)以及 22 个慢性意识障碍(DOC)的被试者。该文章使用整合信息分解得到协同信息和冗余信息,以及使用修正后的整合信息值 [math]\displaystyle{ \Phi_R }[/math],来计算每两个脑区之间的协同和冗余值,从而得到每个脑区发挥更大作用的因素是协同还是冗余。同时,他们对比有意识人的数据,发现无意识人的整合信息发生显著降低的区域都属于协同信息发挥更大作用的脑区,同时发现整合信息显著降低的区域都属于 DMN(Default Mode Network)这样的功能区,从而定位到对于发生意识具有显著作用的脑区。

在人工智能系统上的应用

因果涌现理论与人工智能领域也存在着非常强的联系,这体现为:首先,因果涌现识别问题的机器学习解决方案其实就是一种因果表示学习的应用;其次,有效信息的最大化等技术也有望应用到因果机器学习等领域。

因果表示学习

因果表示学习是人工智能中的一个新兴领域,它试图将机器学习中的两个重要领域:表示学习和因果推断结合起来,尝试结合各自的优势,自动提取数据背后的重要特征和因果关系[53]。基于有效信息的因果涌现识别可以等价于一种因果表示学习任务。从数据中识别因果关系的涌现,等价于学习数据背后的潜在因果关系与因果机制。具体来说,我们可以把宏观状态看成因果变量,宏观动力学类比为因果机制,粗粒化策略可以看作是一个从原始数据到因果变量的编码过程或表示(Representation),有效信息可以理解为对机制的因果效应强度的衡量。

由于这两者存在很多相似之处,这就使得两个领域的技术和概念可以相互借鉴。例如,因果表示学习技术可以应用于因果涌现识别,反过来,学习到的抽象因果表征可以被解释为一种宏观状态,从而增强因果表示学习的可解释性。但是两者也存在显著差异,主要包括两点:1)因果表示学习假设其背后存在一个真实的因果机制,数据是由这个因果机制产生的,然而宏观层面涌现出的状态和动力学之间可能并不存在“真正的因果关系”;2)因果涌现中的粗粒化后的宏观状态是一种低维的描述,然而因果表示学习中并没有这个要求。从认识论的视角看,两者并不存在差异,因为两者所做的都是从观察数据中提取有效信息的,从而获得具有因果效应更强的表征。

为了更好地对比因果表示学习和因果涌现识别任务,我们列出了下表:

| 对比 | 因果表示学习 | 因果涌现识别 |

|---|---|---|

| 数据 | 由真实生活中某些因果机制产生的原始数据宏观状态 | 微观状态的观测(时间序列) |

| 隐变量 | 因果表征 | 宏观状态 |

| 因果机制 | 因果机制 | 宏观动力学 |

| 数据和隐变量之间的映射 | 表征 | 粗粒化函数 |

| 因果关系优化 | 预测损失,解纠缠 | EI最大化 |

| 目标 | 寻找原始数据的最优表示,以确保通过表示可以实现独立的因果机制 | 寻找一个有效的粗粒化策略以及具有强因果效应的宏观动力学 |

有效信息在因果机器学习中的应用

因果涌现能够在分布外场景中增强机器学习的性能,[math]\displaystyle{ EI }[/math] 中引入的 do 干预捕获了数据生成过程中的因果依赖性,抑制了虚假相关,从而补充了基于关联的机器学习算法,建立了 [math]\displaystyle{ EI }[/math] 与分布外泛化(Out Of Distribution,简称OOD)的联系[54]。由于有效信息的通用性,因果涌现可以应用于监督机器学习来评估特征空间 [math]\displaystyle{ X }[/math] 与目标空间 [math]\displaystyle{ Y }[/math] 之间的因果关系强度,从而提高从原因(特征)到结果(目标)的预测准确性。值得注意的是,对观测值从 [math]\displaystyle{ X }[/math] 到 [math]\displaystyle{ Y }[/math] 的直接拟合足以满足具有 i.i.d.假设的常见预测任务,这意味着训练数据和测试数据是独立同分布的。然而,如果样本是从训练分布之外抽取的,就必须学习一个从训练到测试环境的泛化表示空间。由于人们普遍认为因果关系的泛化性优于统计相关性[55],因此,因果涌现理论可以作为表征空间中嵌入因果关系的标准。因果涌现的发生揭示了目标的潜在因果因素,从而产生了一个关于分布外泛化的鲁棒表示空间。因果涌现可能为基于因果理论的分布外泛化提供一个统一的表征度量。[math]\displaystyle{ EI }[/math] 也可以看作是分布外泛化的基于重加权的去偏技术的一种信息论抽象。此外,我们猜想,分布外泛化可以在最大化 [math]\displaystyle{ EI }[/math] 的同时实现,[math]\displaystyle{ EI }[/math] 可能会在原始特征抽象的中期阶段达到顶峰,这与 OOD 泛化的思想一致,即少即是多。理想情况下,当因果涌现发生在 [math]\displaystyle{ EI }[/math] 的峰值处,所有非因果特征被排除,因果特征被揭示,从而产生最具信息量的表示。

因果模型抽象

在复杂系统中,由于微观状态往往存在噪音,人们需要将微观状态进行粗粒化才能得到噪音更小的宏观状态,使得宏观动力学的因果性更强。同样对于解释各类数据的因果模型也一样,由于原始模型过于复杂,或者计算资源受限,所以人们往往需要得到更加抽象的因果模型,并且保证抽象的模型尽可能保持原始模型的因果机制,这就是所谓的因果模型抽象(Causal Model Abstraction)。

因果模型抽象属于人工智能的一个子领域,它特别在因果推理和模型可解释性方面发挥着重要的作用,这种抽象可以帮助我们更好地理解数据中隐藏的因果机制,以及变量之间的相互作用。因果模型抽象通过评估一个高层次模型尽可能模拟一个低层次模型的因果效应的优化来实现[56]。如果高层次模型能够概括低层次模型的因果效应,我们称这个高层次模型是低层次模型的因果抽象。

因果模型抽象讨论的也是因果关系与模型抽象(可以看成粗粒化过程)之间的相互作用[57]。因此,因果涌现识别与因果模型抽象存在很多相似之处,可以把原始的因果机制理解为微观动力学,抽象出来的机制理解为宏观动力学。在 神经信息压缩框架中(NIS),研究者对粗粒化策略和宏观动力学进行了限制,要求宏观动力学的微观预测误差要足够小以排除平凡解。这个要求也类似于因果模型抽象中希望抽象后的因果模型与原始模型要尽可能相似。但是两者也存在一些不同:1)因果涌现识别是对状态或数据进行粗粒化,而因果模型抽象是对模型进行粗粒化操作;2)因果模型抽象中考虑了混肴因子,然而这一点却被因果涌现识别的讨论所忽略。

基于世界模型的强化学习

基于世界模型的强化学习假设强化学习主体内部存在一个世界模型,从而可以模拟智能主体所面对环境的动力学[58]。世界模型的动力学可以通过智能体与环境的相互作用来学习,从而帮助智能体对不确定的环境做出计划和决策。同时为了表示复杂的环境,世界模型一定是对环境的粗粒化描述,一个典型的世界模型架构总是包含一个编码器和一个解码器。

基于世界模型的强化学习与因果涌现识别也存在很多相似之处。世界模型也可以被视为一种宏观动力学,环境中的所有状态可以看作是宏观状态,这些可以看成是压缩后的,忽略了无关信息的状态,能捕捉环境中最重要的因果特征,以便智能体可以做出更好的决策。在规划(Planning)过程中,智能体也可以使用世界模型来模拟真实世界的动力学。

两个领域之间的相似性和共同特征可以帮助我们将一个领域的思想和技术借鉴到另一个领域。例如,具有世界模型的智能体可以将复杂系统作为一个整体来进行交互,并从相互作用中获得涌现的因果规律,从而更好的帮助我们做因果涌现识别任务。反过来,最大化有效信息技术也可以被用于强化学习,使世界模型具有更强的因果特性。

其它潜在应用

除了上述应用领域之外,因果涌现理论对于其它重要问题还可能存在着巨大的潜在应用价值,例如它对于意识问题的研究以及在中国古典哲学的现代科学解释方面有一定的前景。

意识研究

首先,因果涌现理论的提出就与意识科学研究存在着巨大的联系,这是因为因果涌现理论的核心指标有效信息最早就是 Tononi 在研究意识的定量理论整合信息论中提出来的。后经过改造,才被 Erik Hoel 应用到了马尔科夫链上,并提出因果涌现概念。因此,从这个意义上说,有效信息其实是定量意识科学的副产品。

其次,因果涌现作为复杂系统中的重要概念在意识科学的研究中也起着重要的作用。例如,在意识领域中,一个核心问题是意识究竟是一个宏观尺度的现象还是微观尺度的现象?至今,尚没有直接证据表明意识发生的尺度是多大。因果涌现的深入研究,特别是结合脑神经的实验数据,有可能回答意识现象的发生尺度问题。

再次,因果涌现有可能回答自由意志(Free will)问题。人有没有自由意志?我们做出的决定真的是我们意志的自由选择吗?还是有可能它仅仅是一种幻觉?事实上,如果接受因果涌现概念,并承认宏观的变量会对微观变量产生因果力,那么人们所有的决策其实都是脑系统自发完成的,而意识仅仅是对这一复杂决策过程进行了某种层面的解释,因而自由意志是一种涌现出的向下因果。这些问题的回答都有待因果涌现理论的进一步研究。

中国古典哲学

与西方科学、哲学不同,中国古典哲学保留了一套完整而不同的对宇宙进行解释的理论框架,这包括阴阳、五行、八卦,也包括占卜、风水、中医等,并能对宇宙中的各类现象进行完全独立的解释。长久以来,东西方两套哲学始终难以融合。因果涌现思想有可能提供一套新的解释,从而弥合东西方哲学的冲突。

根据因果涌现理论,一套理论的好坏取决于因果性的强弱,也就是 [math]\displaystyle{ EI }[/math] 的大小。而不同的粗粒化方案会得到完全不同的宏观理论(宏观动力学)。很有可能,在面对同样的复杂系统研究对象的时候,西方的哲学、科学体系给出的是一套比较具体而微观的因果机制(动力学),而东方哲学则给出了一套更加粗粒化的宏观因果机制。根据因果涌现理论,或者是 Yurchenko 提出的因果等价原理(Causal Equivalence Principle),这二者完全有可能是相互兼容的。也就是说,对于同样一组现象,东西方按照不同的两套因果机制,都能够做出正确的预测,甚至是干预手段。当然,也有可能在某类问题或现象中,更加宏观尺度的因果机制更具有解释力度或得出好的方案,有的问题或现象,则更加有利于更微观的因果机制。

例如,就用东方哲学中的五行概念来说,我们完全可以将五行理解成万事万物的五种宏观态,而五行的相生相克关系就可以被理解为是这五种宏观态彼此之间的一种宏观因果机制。那么,从万事万物中提炼出五行这五种状态的认知过程,就是一种粗粒化过程,它依赖于观察者的类象能力。因此,五行理论就可以看作是对万事万物进行抽象的因果涌现理论。同样的,我们还可以将因果涌现的概念应用到更多领域,包括中医、占卜、风水等。这些应用的共同点将会是,它的因果机制相对于西方科学更加简单,也有可能因果性更强,但是得到这种抽象的粗粒化过程则更加复杂,更加依赖于有经验的抽象者。这就解释了为什么东方哲学都强调实践者自身的修为,这是因为,这些东方哲学理论将巨大的复杂性和计算量都放到了类象思维上。

批判

Erik Hoel等人最早提出基于最大化有效信息的因果涌现理论虽然很好刻画了因果涌现现象,并在许多实际系统之中得到了广泛的应用,但是有学者指出,该理论仍然存在着很多缺陷和弊端。这主要体现在哲学层面和马尔科夫动力系统粗粒化的技术层面。

哲学层面

纵观历史,关于因果关系和涌现的本体论和认识论方面一直存在长期的争论。

例如,Yurchenko 就在文献[59]中指出“因果(causation)”这一概念往往是模糊的,应区分为原因(cause)和理由(reason)两种不同的概念,它们分别符合本体论和认识论的因果。其中,原因(cause)指的是充分导致结果的真实原因,而理由(reason)则仅仅是观察者对结果的解释。理由可能没有真正的原因那么严格,但它确实提供了一定程度的可预测性。同样,关于因果涌现的本质也存在争论。

因果涌现是否是一种独立于特定观察者而存在的真实现象?这里需要强调的是,对于 Hoel 的理论,不同的粗粒化策略可以导致不同的宏观动力学机制与不同的因果效应度量结果([math]\displaystyle{ EI }[/math])。本质上,不同的粗粒化策略可以代表不同的观察者。Hoel的理论通过干预将涌现与因果关系联系起来,以定量的方式引入了因果涌现的概念。Hoel的理论提出了一个消除不同粗粒化方法影响的方案,即 [math]\displaystyle{ EI }[/math] 最大化。能够让EI最大的粗粒化方案就是唯一客观的方案。因此,对于给定的一组马尔科夫动力学,只有使 [math]\displaystyle{ EI }[/math] 最大化的粗粒化策略和相应的宏观动力学才能被认为是客观的结果。然而,当最大化 [math]\displaystyle{ EI }[/math] 的解不唯一的时候,也就是存在多种能够让 [math]\displaystyle{ EI }[/math] 最大化的粗粒化方案时,就会导致该理论的困难,一定程度的主观性就无法避免。

Dewhurst[60]对 Hoel 的理论进行了哲学上的澄清,认为它是认识论的,而不是本体论的。这表明,Hoel 的宏观因果仅仅是一种基于信息论的因果解释,而不涉及“真正的因果”。这也引起了对均匀分布假设的质疑(参见有效信息词条),因为没有证据表明它应该优于其他分布。

技术层面

不唯一性

因果涌现的结果定义为粗粒化后宏观动力学的EI 与原始微观动力学EI之差,因此,该结果明显依赖于粗粒化方案的选择。为了消除这种不确定性,Hoel 等人的引入了最大化有效信息的概念,也就是一个系统中的因果涌现判断和度量是建立在最大化宏观动力学EI的基础之上的。然而,目前尚没有理论保证这种最大化宏观动力学EI的方式能够保证粗粒化方案的唯一性。也就是说,完全有可能多个粗粒化方案会对应同样的宏观动力学 EI。事实上,对于连续映射动力系统的研究已经表明,最大化EI的解是存在着无穷多种可能性的[61]。

歧义性

同时有人指出,Hoel 的理论忽略了对粗粒化方法的约束,某些粗粒化方法可能导致歧义和不合理[62]。

首先,[62]指出,如果对粗粒化方案不加约束,有可能在对转移概率矩阵(TPM)进行粗粒化(状态的合并,以及概率的加和处理)的时候产生歧义性(Ambiguity)。例如,当被合并的两个状态所对应的TPM中的两行向量非常不相似的时候,强行合并它们(例如求平均的方式),就会引发歧义。这种歧义主要体现为,对合并后宏观状态的干预究竟是什么含义?由于行向量是不相似的,因此对合并后宏观态的干预就无法简单还原到对微观态的干预。如果强行按照平均的方式将宏观态的干预转化为微观态的干预,则忽略了微观态彼此之间的差异。同时也会引发新的不可交换性的矛盾问题。

不可交换性

如果强行将不相似的两个行向量做平均,那么得到的粗粒化的TPM就有可能破坏抽象化操作(即粗粒化)和边际化(marginalization,即时间演化算子)彼此之间的可交换性。例如假定 [math]\displaystyle{ A_{m \times n} }[/math] 是对状态进行粗粒化操作(将n个状态合并为m个状态),这里的粗粒化策略是使得宏观状态转移矩阵有效信息最大的策略,[math]\displaystyle{ (\cdot) \times (\cdot) }[/math] 是时间粗粒化操作(将两个时间步骤合并为一个)。这样 [math]A_{m\times n}(TPM_{n \times n})[/math] 就是对一个 [math]n\times n[/math] 的 TPM 做粗粒化,粗粒化过程就简化为矩阵 [math]A[/math] 与矩阵 [math]TPM[/math] 的乘积。

那么,空间粗粒化和时间粗粒化的可交换性条件,就是如下等式:

-

[math]\displaystyle{ A_{m\times n}(TPM_{n \times n}) \times A_{m \times n}(TPM_{n \times n}) = A_{m \times n}(TPM_{n \times n} \times TPM_{n \times n}) }[/math]

(3)

左边表示的是先对连续两个时间步的状态做粗粒化,再将两个时间步的动力学TPM乘到一起,得到一个两步演化的转移矩阵;方程右边表示先将两个时间步的 TPM 乘到一起,得到微观态的两步演化,再用 A 做粗粒化得到宏观的 TPM。该等式的不满足表明某些粗粒化操作会导致宏观状态的演化与微观系统演化后的粗粒化状态存在差异。这意味着需要对粗粒化策略添加某种一致性的约束,例如马尔科夫链可聚类的条件(lumpable),参见马尔科夫链的粗粒化词条。

然而,如文献[40]中指出,通过在连续变量空间中最大化EI的同时考虑模型的误差因素,上述问题可以得到缓解。

其它问题及补救

除此之外,Hoel 的 [math]\displaystyle{ EI }[/math] 计算以及因果涌现的量化,依赖于两个已知的前提因素:(1)已知的微观动力学;(2)已知的粗粒化方案。然而,在实践中,人们很少能够同时获得这两个因素,特别是在观察性研究中,这两个因素可能都是未知的。因此,这一局限性阻碍了 Hoel 理论的实际适用性。

不过,虽然机器学习技术促进了因果关系与因果机制的学习,以及对涌现属性的识别,但重要的是通过机器学习获得的结果是否反映了本体论的因果关系和涌现,或者它们仅仅是一种认识论现象?这一点则尚无定论。尽管机器学习的引入不一定能解决围绕本体论和认识论因果关系和涌现的争论问题,但它可以提供有助于减轻主观性的依赖。这是因为机器学习主体可以被视为一个“客观”的观察者,对因果关系和涌现做出判断,这种判断是独立于人类观察者的。然而,唯一解的问题在这一方法中仍然存在。机器学习的结果是本体论还是认识论的?答案是,结果是认识论的,其中认识主体是机器学习算法。然而,这并不意味着机器学习的所有结果都是无意义的,因为如果学习的主体得到了良好的训练,并且定义的数学目标得到了有效的优化,那么结果也可以被认为是客观的,因为算法本身是客观的,且透明的。结合机器学习方法可以帮助我们建立观察者的理论框架,并研究观察者与相应的被观察复杂系统之间的相互作用。

相关研究领域

存在一些相关研究领域与因果涌现理论联系比较紧密,这里我们重点介绍与动力学模型约简、动力学模态分解以及马尔科夫链的简化三个相关领域的区别和联系。

动力学模型约简

因果涌现的一个重要的指标就是粗粒化策略的选取,而如果在微观模型已知的时候,对微观态的粗粒化就等价于对微观模型进行模型约简(Model Reduction)。模型约简是控制论中的一个重要子领域,Antoulas 就曾经写过相关的综述文章[63]。

模型约简,就是要将高维的复杂系统动力学模型进行化简、降维,用低维的动力学来描述原系统的演化规律,这一过程其实就是因果涌现研究中的粗粒化过程。对大尺度动力系统的近似方法主要有两大类,即基于奇异值分解[63][64]的近似方法和基于 Krylov[63][65][66]的近似方法。前者基于奇异值分解,后者基于矩匹配。虽然前者具有许多理想的性质,包括误差界,但它不能应用于高复杂度的系统。另一方面,后者的优势在于它可以迭代实现,因此适用于高维度的复杂度系统。将这两种方法的优势相结合,就产生了第三类近似方法,即称为 SVD/Krylov 的方法[67][68]。两种方法都是基于粗粒化前后输出函数的误差损失函数来对模型约简效果做评价的,因此,模型约简的目标就是寻找能使误差最小的约简参数矩阵。

一般情况下基于模型约简前后输出函数的误差损失函数可以用来判断粗粒化参数,这一过程默认了系统约简的过程会损失信息量,因此误差最小化是判断约简方法有效性的唯一方法。但是如果从因果涌现角度考虑,有效信息会因为降维而增大,这也是因果涌现研究中的粗粒化策略和控制论中的模型约简最大的不同。当动力系统是随机系统的时候[65],直接计算损失函数会因为随机性的存在,导致其稳定性无法保证,因而约简的有效性也会无法准确测量。而本身就是基于随机动力系统的有效信息和因果涌现指标,一定程度上可以增加评判指标的有效性,使对随机动力系统的控制研究更加严谨。

动力学模态分解

除了动力学模型约简之外,动力学模态分解也和粗粒化有着密切的联系。动力学模态分解(Dynamic Mode Decomposition, DMD)[69][70]模型的基本思想是直接从数据中得到流场中流动的动态信息,根据不同频率的流场变动寻找数据映射。该方法基于把非线性无穷维动力学转化为有穷维的线性动力学的方式,并采用了Arnoldi 方法以及奇异值分解降维的思想,借鉴了 ARIMA、SARIMA 以及季节模型等许多时间序列的关键特征,被广泛的使用在数学、物理、金融等领域[71]。动态模式分解按照频率对系统进行排序,提取系统的本征频率,从而观察不同频率的流动结构对流场的贡献,同时动态模式分解模态特征值可以对流场进行预测。因为动态模态分解算法具有理论的严密性、稳定性、简易性等优点。在不断应用的同时,动态模态分解算法也在原有基础之上不断被完善,如与 SPA 检验结合起来,以验证股票价格预测对比基准点的强有效性以及通过联系动态模态分解算法和光谱研究的方式,模拟股票市场在循环经济当中的振动模式等。这些应用均能够有效地采集分析数据,并最终得到结果。

动力学模式分解,属于利用线性变换同时对变量、动力学、观测函数进行降维[72]的方法。这种方法是另一种与因果涌现中粗粒化策略相近的,将误差最小化作为主要目标来进行优化的方法。模型约简和动力学模式分解虽然都和模型粗粒化十分接近,但是它们都没有基于有效信息的优化,本质上都是默认了一定程度上的损失信息,同时也不会增强因果效应的。在文献[73]中,作者们证明了其实误差最小化解集包含了有效信息最大化的最优解集,因此如果要优化因果涌现,可以先最小化误差,在最小误差的解集中寻找最佳的粗粒化策略。

马尔科夫链的简化

马尔科夫链的简化(或叫做马尔科夫链的粗粒化)也和因果涌现有着重要的联系,因果涌现中的粗粒化过程本质上就是马尔科夫链的简化。马尔科夫过程的模型简化[74]是状态转移系统建模中的一个重要问题,它是通过将多个状态合并成一个状态以降低马尔科夫链的复杂度。

做简化的意义主要有三点,第一,我们在研究一个超大规模系统的时候,并不会关注每一个微观状态的变化。因此,在粗粒化中我们希望能过滤掉一些我们不感兴趣的噪声和异质性,而从微观尺度中总结出一些中尺度或宏观尺度的规律;第二,有些状态的转移概率非常相似,所以可以被看成同一类状态,对这种状态做聚类(也称为对状态做划分,即 Partitioning),从而得到新的更小的马尔科夫链可以减少系统表示的冗余性;第三,在用到马尔科夫决策过程的强化学习里,对马尔科夫链做粗粒化可以减少状态空间的大小,提高训练效率。在许多文献中,粗粒化(coarse-graining)和降维(dimension reduction)是等价的[75]。

其中,对状态空间做粗粒化有硬分组(Hard Partitioning)和软分组(Soft Partitioning)两种。软分组可以看作是把微观状态打散重构出一些宏观状态的过程,并允许微观态的叠加而得到宏观态;而硬分组则是严格的微观态分组,把若干个微观状态分成一个组,不允许重叠和叠加(参见马尔科夫链的粗粒化)。

马尔科夫链的粗粒化不仅要对状态空间做,也要对转移矩阵做,也就是根据状态的分组简化原转移矩阵以得到新的更小的转移矩阵。除此之外,还要对状态向量做约简。因此,一个完整的粗粒化过程需要同时考虑状态、转移矩阵、状态向量的粗粒化。于是,这就引出了一个新的问题,即状态分组得到的新马尔科夫链中的转移概率应该如何计算?同时,归一化条件是否能够得到保证?

除了这些基本保证之外,我们通常还要求对转移矩阵的粗粒化操作应该与转移矩阵是可交换的,这一条件能够保证经过粗粒化后的状态向量再经过粗粒化的转移矩阵(相当于宏观动力学)的一步演化,是等价于先对状态向量进行一步转移矩阵演化(相当于微观动力学),之后再进行粗粒化的。这就同时为状态分组(状态的粗粒化过程)以及转移矩阵的粗粒化过程提出了要求。这一可交换性的要求,就导致人们提出了马尔科夫链可聚类性的要求。

针对任意的状态硬划分,我们可以定义所谓的可聚类性(lumpability)的概念。可聚类性(Lumpability)是一种对聚类的衡量,这个概念最早出现在 Kemeny, Snell 在 1969 年的有限马尔科夫链(Finite Markov Chains)[76]中。可聚类性(Lumpability)就是一个数学条件,用来判断“对于某一种硬分块的微观状态分组方案,是否对微观状态转移矩阵是可约简的”。不管状态空间按照哪一个硬分块方案做分类,它都有对应后续的对转移矩阵和概率空间的粗粒化方案[77]。

假设对马尔科夫状态空间 [math]\displaystyle{ A }[/math] 给定了分组方法 [math]\displaystyle{ A=\{A_1, A_2, ... ,A_r\} }[/math],这里 [math]A_i[/math] 是状态空间 [math]\displaystyle{ A }[/math] 的任意一个子集,且满足 [math]A_i\cap A_j= \Phi[/math],[math]\Phi[/math] 表示空集。[math]\displaystyle{ s^{(t)} }[/math] 表示系统在 [math]\displaystyle{ t }[/math] 时刻的微观状态,微观状态空间为 [math]\displaystyle{ S=\{s_1, s_2, ... ,s_n\} }[/math] 且微观状态 [math]\displaystyle{ s_i\in A }[/math] 都是马尔科夫状态空间中的独立元素,设微观状态 [math]\displaystyle{ s_k }[/math] 到 [math]\displaystyle{ s_m }[/math] 的转移概率为 [math]\displaystyle{ p_{s_k \rightarrow s_m} = p(s^{(t)} = s_m | s^{(t-1)} = s_k) }[/math],微观状态 [math]\displaystyle{ s_k }[/math] 到宏观状态 [math]\displaystyle{ A_i }[/math] 的转移概率为 [math]\displaystyle{ p_{s_k \rightarrow A_i} = p(s^{(t)} \in A_i | s^{(t-1)} = s_k) }[/math],则可聚类的充分必要条件为,对于任意一对 [math]\displaystyle{ A_i, A_j }[/math],每一个属于 [math]\displaystyle{ A_i }[/math] 的状态 [math]\displaystyle{ s_k }[/math] 的[math]\displaystyle{ p_{s_k \rightarrow A_j} }[/math] 都是相等的,即:

-

[math]\displaystyle{ \begin{aligned} p_{s_k \rightarrow A_j} = \sum_{s_m \in A_j} p_{s_k \rightarrow s_m} = p_{A_i \rightarrow A_j}, \forall s_k \in A_i \end{aligned} }[/math]

(4)

关于具体的粗粒化马尔科夫链的方法,请参考马尔科夫链的粗粒化。

参考文献

- ↑ 1.0 1.1 1.2 1.3 1.4 1.5 1.6 1.7 Hoel E P, Albantakis L, Tononi G. Quantifying causal emergence shows that macro can beat micro[J]. Proceedings of the National Academy of Sciences, 2013, 110(49): 19790-19795.

- ↑ 2.0 2.1 2.2 2.3 2.4 Hoel E P. When the map is better than the territory[J]. Entropy, 2017, 19(5): 188.

- ↑ Meehl P E, Sellars W. The concept of emergence[J]. Minnesota studies in the philosophy of science, 1956, 1239-252.

- ↑ 4.0 4.1 Holland J H. Emergence: From chaos to order[M]. OUP Oxford, 2000.

- ↑ Anderson P W. More is different: broken symmetry and the nature of the hierarchical structure of science[J]. Science, 1972, 177(4047): 393-396.

- ↑ Holland, J.H. Hidden Order: How Adaptation Builds Complexity; Addison Wesley Longman Publishing Co., Inc.: Boston, MA, USA, 1996.

- ↑ Reynolds, C.W. Flocks, herds and schools: A distributed behavioral model. In Proceedings of the 14th Annual Conference on Computer Graphics and Interactive Techniques, Anaheim, CA, USA, 27–31 July 1987; pp. 25–34.

- ↑ Wei, J.; Tay, Y.; Bommasani, R.; Raffel, C.; Zoph, B.; Borgeaud, S.; Yogatama, D.; Bosma, M.; Zhou, D.; Metzler, D.; et al. Emergent abilities of large language models. arXiv 2022, arXiv:2206.07682.

- ↑ 9.0 9.1 Bedau, M.A. Weak emergence. Philos. Perspect. 1997, 11, 375–399. [CrossRef]

- ↑ Bedau, M. Downward causation and the autonomy of weak emergence. Principia Int. J. Epistemol. 2002, 6, 5–50.

- ↑ 11.0 11.1 Harré, R. The Philosophies of Science; Oxford University Press: New York, NY, USA , 1985.

- ↑ 12.0 12.1 Baas, N.A. Emergence, hierarchies, and hyperstructures. In Artificial Life III, SFI Studies in the Science of Complexity, XVII; Routledge: Abingdon, UK, 1994; pp. 515–537.

- ↑ Newman, D.V. Emergence and strange attractors. Philos. Sci. 1996, 63, 245–261. [CrossRef]

- ↑ 14.0 14.1 Kim, J. ‘Downward causation’ in emergentism and nonreductive physicalism. In Emergence or Reduction; Walter de Gruyter: Berlin, Germany, 1992; pp. 119–138.

- ↑ 15.0 15.1 O’Connor, T. Emergent properties. Am. Philos. Q. 1994, 31, 91–104

- ↑ Fromm, J. Types and forms of emergence. arXiv 2005, arXiv:nlin/0506028

- ↑ Bedau, M.A.; Humphreys, P. Emergence: Contemporary Readings in Philosophy and Science; MIT Press: Cambridge, MA, USA, 2008.

- ↑ Yurchenko, S.B. Can there be a synergistic core emerging in the brain hierarchy to control neural activity by downward causation? TechRxiv 2023 . [CrossRef]

- ↑ 19.0 19.1 Pearl J. Causality[M]. Cambridge university press, 2009.

- ↑ Granger C W. Investigating causal relations by econometric models and cross-spectral methods[J]. Econometrica: journal of the Econometric Society, 1969, 424-438.

- ↑ 21.0 21.1 Pearl J. Models, reasoning and inference[J]. Cambridge, UK: CambridgeUniversityPress, 2000, 19(2).

- ↑ Spirtes, P.; Glymour, C.; Scheines, R. Causation Prediction and Search, 2nd ed.; MIT Press: Cambridge, MA, USA, 2000.

- ↑ Chickering, D.M. Learning equivalence classes of Bayesian-network structures. J. Mach. Learn. Res. 2002, 2, 445–498.

- ↑ Eells, E. Probabilistic Causality; Cambridge University Press: Cambridge, UK, 1991; Volume 1

- ↑ Suppes, P. A probabilistic theory of causality. Br. J. Philos. Sci. 1973, 24, 409–410.

- ↑ 26.0 26.1 26.2 26.3 26.4 26.5 Zhang J, Tao R, Yuan B. Dynamical Reversibility and A New Theory of Causal Emergence. arXiv preprint arXiv:2402.15054. 2024 Feb 23.

- ↑ 27.0 27.1 J. P. Crutchfield, K. Young, Inferring statistical complexity, Physical review letters 63 (2) (1989) 105.

- ↑ 28.0 28.1 A. K. Seth, Measuring emergence via nonlinear granger causality., in: alife, Vol. 2008, 2008, pp. 545–552.

- ↑ 29.0 29.1 Crutchfield, J.P (1994). "The calculi of emergence: computation, dynamics and induction". Physica D: Nonlinear Phenomena. 75 (1–3): 11-54.

- ↑ Mnif, M.; Müller-Schloer, C. Quantitative emergence. In Organic Computing—A Paradigm Shift for Complex Systems; Springer: Basel, Switzerland, 2011; pp. 39–52.

- ↑ Fisch, D.; Jänicke, M.; Sick, B.; Müller-Schloer, C. Quantitative emergence–A refined approach based on divergence measures. In Proceedings of the 2010 Fourth IEEE International Conference on Self-Adaptive and Self-Organizing Systems, Budapest, Hungary, 27 September–1 October 2010; IEEE Computer Society: Washington, DC, USA, 2010; pp. 94–103.

- ↑ Fisch, D.; Fisch, D.; Jänicke, M.; Kalkowski, E.; Sick, B. Techniques for knowledge acquisition in dynamically changing environments. ACM Trans. Auton. Adapt. Syst. (TAAS) 2012, 7, 1–25. [CrossRef]

- ↑ Holzer, R.; De Meer, H.; Bettstetter, C. On autonomy and emergence in self-organizing systems. In International Workshop on Self-Organizing Systems, Proceedings of the Third International Workshop, IWSOS 2008, Vienna, Austria, 10–12 December 2008; Springer: Berlin/Heidelberg, Germany, 2008; pp. 157–169.

- ↑ Holzer, R.; de Meer, H. Methods for approximations of quantitative measures in self-organizing systems. In Proceedings of the Self-Organizing Systems: 5th International Workshop, IWSOS 2011, Karlsruhe, Germany, 23–24 February 2011; Proceedings 5; Springer: Berlin/Heidelberg, Germany, 2011; pp. 1–15.

- ↑ Teo, Y.M.; Luong, B.L.; Szabo, C. Formalization of emergence in multi-agent systems. In Proceedings of the 1st ACM SIGSIM Conference on Principles of Advanced Discrete Simulation, Montreal, QC, Canada, 19–22 May 2013; pp. 231–240.

- ↑ Szabo, C.; Teo, Y.M. Formalization of weak emergence in multiagent systems. ACM Trans. Model. Comput. Simul. (TOMACS) 2015, 26, 1–25. [CrossRef]

- ↑ 37.0 37.1 37.2 37.3 37.4 37.5 37.6 Rosas F E, Mediano P A, Jensen H J, et al. Reconciling emergences: An information-theoretic approach to identify causal emergence in multivariate data[J]. PLoS computational biology, 2020, 16(12): e1008289.

- ↑ 38.0 38.1 Williams P L, Beer R D. Nonnegative decomposition of multivariate information[J]. arXiv preprint arXiv:10042515, 2010.

- ↑ 39.0 39.1 P. A. Mediano, F. Rosas, R. L. Carhart-Harris, A. K. Seth, A. B. Barrett, Beyond integrated information: A taxonomy of information dynamics phenomena, arXiv preprint arXiv:1909.02297 (2019).

- ↑ 40.0 40.1 40.2 40.3 40.4 40.5 Barnett L, Seth AK. Dynamical independence: discovering emergent macroscopic processes in complex dynamical systems. Physical Review E. 2023 Jul;108(1):014304.

- ↑ Tononi G, Sporns O. Measuring information integration[J]. BMC neuroscience, 2003, 41-20.

- ↑ Chvykov P; Hoel E. (2021). "Causal Geometry". Entropy. 23 (1): 24.

- ↑ Liu K; Yuan B; Zhang J (2024). "An Exact Theory of Causal Emergence for Linear Stochastic Iteration Systems". Entropy. 26 (8): 618.

- ↑ 44.0 44.1 44.2 Zhang J, Liu K. Neural information squeezer for causal emergence[J]. Entropy, 2022, 25(1): 26.

- ↑ Klein B, Hoel E. The emergence of informative higher scales in complex networks[J]. Complexity, 2020, 20201-12.

- ↑ Griebenow R, Klein B, Hoel E. Finding the right scale of a network: efficient identification of causal emergence through spectral clustering[J]. arXiv preprint arXiv:190807565, 2019.

- ↑ Klein B, Swain A, Byrum T, et al. Exploring noise, degeneracy and determinism in biological networks with the einet package[J]. Methods in Ecology and Evolution, 2022, 13(4): 799-804.

- ↑ Klein B, Hoel E, Swain A, et al. Evolution and emergence: higher order information structure in protein interactomes across the tree of life[J]. Integrative Biology, 2021, 13(12): 283-294.

- ↑ Hoel E, Levin M. Emergence of informative higher scales in biological systems: a computational toolkit for optimal prediction and control[J]. Communicative & Integrative Biology, 2020, 13(1): 108-118.

- ↑ Swain A, Williams S D, Di Felice L J, et al. Interactions and information: exploring task allocation in ant colonies using network analysis[J]. Animal Behaviour, 2022, 18969-81.

- ↑ Marrow S, Michaud E J, Hoel E. Examining the Causal Structures of Deep Neural Networks Using Information Theory[J]. Entropy, 2020, 22(12): 1429.

- ↑ Luppi AI, Mediano PA, Rosas FE, Allanson J, Pickard JD, Carhart-Harris RL, Williams GB, Craig MM, Finoia P, Owen AM, Naci L. A synergistic workspace for human consciousness revealed by integrated information decomposition. BioRxiv. 2020 Nov 26:2020-11.

- ↑ B. Sch ̈olkopf, F. Locatello, S. Bauer, N. R. Ke, N. Kalchbrenner, A. Goyal, Y. Bengio, Toward causal representation learning, Proceedings of the IEEE 109 (5) (2021) 612–634.

- ↑ Yuan, B; Zhang, J; Lyu, A; Wu, J; Wang, Z; Yang, M; Liu, K; Mou, M; Cui, P (2024). "Emergence and causality in complex systems: A survey of causal emergence and related quantitative studies". Entropy. 26 (2): 108.

- ↑ Arjovsky, M.; Bottou, L.; Gulrajani, I.; Lopez-Paz, D. Invariant risk minimization. arXiv 2019, arXiv:1907.02893.

- ↑ Beckers, Sander, and Joseph Y. Halpern. "Abstracting causal models." Proceedings of the aaai conference on artificial intelligence. Vol. 33. No. 01. 2019.

- ↑ S. Beckers, F. Eberhardt, J. Y. Halpern, Approximate causal abstractions, in: Uncertainty in artificial intelligence, PMLR, 2020, pp. 606–615.

- ↑ D. Ha, J. Schmidhuber, World models, arXiv preprint arXiv:1803.10122 (2018).

- ↑ Yurchenko, S. B. (2023). Can there be a synergistic core emerging in the brain hierarchy to control neural activity by downward causation?. Authorea Preprints.

- ↑ Dewhurst, J. (2021). Causal emergence from effective information: Neither causal nor emergent?. Thought: A Journal of Philosophy, 10(3), 158-168.

- ↑ Liu, K.W.; Yuan, B.; Zhang, J. (2024). "An Exact Theory of Causal Emergence for Linear Stochastic Iteration Systems". Entropy. 26 (8): 618.

- ↑ 62.0 62.1 Eberhardt, F., & Lee, L. L. (2022). Causal emergence: When distortions in a map obscure the territory. Philosophies, 7(2), 30.

- ↑ 63.0 63.1 63.2 Antoulas A C. An overview of approximation methods for large-scale dynamical systems[J]. Annual reviews in Control, 2005, 29(2): 181-190.

- ↑ Gallivan K, Grimme E, Van Dooren P. Asymptotic waveform evaluation via a Lanczos method[J]. Applied Mathematics Letters, 1994, 7(5): 75-80.

- ↑ 65.0 65.1 CHRISTIAN DE VILLEMAGNE & ROBERT E. SKELTON (1987) Model reductions using a projection formulation, International Journal of Control, 46:6, 2141-2169, DOI: 10.1080/00207178708934040

- ↑ Boley D L. Krylov space methods on state-space control models[J]. Circuits, Systems and Signal Processing, 1994, 13: 733-758.

- ↑ Gugercin S. An iterative SVD-Krylov based method for model reduction of large-scale dynamical systems[J]. Linear Algebra and its Applications, 2008, 428(8-9): 1964-1986.

- ↑ Khatibi M, Zargarzadeh H, Barzegaran M. Power system dynamic model reduction by means of an iterative SVD-Krylov model reduction method[C]//2016 IEEE Power & Energy Society Innovative Smart Grid Technologies Conference (ISGT). IEEE, 2016: 1-6.

- ↑ Schmid P J. Dynamic mode decomposition and its variants[J]. Annual Review of Fluid Mechanics, 2022, 54(1): 225-254.

- ↑ J. Proctor, S. Brunton and J. N. Kutz, Dynamic mode decomposition with control, arXiv:1409.6358

- ↑ J. Grosek and J. N. Kutz, Dynamic mode decomposition for real-time background/foreground separation in video, arXiv:1404.7592.

- ↑ B. Brunton, L. Johnson, J. Ojemann and J. N. Kutz, Extracting spatial-temporal coherent patterns in large-scale neural recordings using dynamic mode decomposition arXiv:1409.5496

- ↑ Liu K, Yuan B, Zhang J. An Exact Theory of Causal Emergence for Linear Stochastic Iteration Systems[J]. arXiv preprint arXiv:2405.09207, 2024.

- ↑ Zhang A, Wang M. Spectral state compression of markov processes[J]. IEEE transactions on information theory, 2019, 66(5): 3202-3231.

- ↑ Coarse graining. Encyclopedia of Mathematics. URL: http://encyclopediaofmath.org/index.php?title=Coarse_graining&oldid=16170

- ↑ Kemeny, John G., and J. Laurie Snell. Finite markov chains. Vol. 26. Princeton, NJ: van Nostrand, 1969. https://www.math.pku.edu.cn/teachers/yaoy/Fall2011/Kemeny-Snell_Chapter6.3-4.pdf

- ↑ Buchholz, Peter. "Exact and ordinary lumpability in finite Markov chains." Journal of applied probability 31.1 (1994): 59-75.

编者推荐

下面是一些链接能够帮助读者更好的了解因果涌现的相关信息:

因果涌现读书会

分享近期发展起来的一些理论与工具,包括因果涌现理论、机器学习驱动的重整化技术,以及自指动力学正在发展一套跨尺度的分析框架等。

涌现现象无非是复杂系统中诸多现象中最神秘莫测的一个,而 Erik Hoel 提出的“因果涌现”理论为这种跨层次的奇妙涌现现象提供了一种新的可能解释途径。通过跨层次的粗粒化(Coarse-graining, 或称重整化 Renormalization)操作,我们便可以在同一个动力学系统上在不同的尺度得到完全不同的动力学,通过本季读书会梳理,我们希望探讨这一新兴领域的前沿进展,衍生更多新的研究课题。

涌现与因果的结合创造了因果涌现的概念。这是一套利用因果性来定量刻画涌现的理论体系,本季读书会通过阅读前沿文献,加深我们对因果、涌现等概念的理解;聚焦于寻找因果与涌现、多尺度等概念相结合的研究方向;并探索复杂系统多尺度自动建模的研究方向。第二季读书会更加集中在探讨因果科学与因果涌现之间的关系,以及对涌现进行定量刻画,聚焦于寻找因果与涌现、多尺度等概念相结合的研究方向;并探索复杂系统多尺度自动建模的研究方向。

因果涌现第三季的读书会中,将进一步围绕因果涌现的核心研究问题『因果涌现的定义』以及『因果涌现的辨识』来进行深入的学习和讨论,对 Erik Hoel 提出的 Causal Emergence,Causal Geometry 等因果涌现的核心理论进行深入的探讨和剖析,并且详细梳理其中涉及到的方法论,包括从动力学约简、隐空间动力学学习等其他研究领域中学习和借鉴相关的研究思路,最后探讨因果涌现的应用,包括基于生物网络、脑网络或者涌现探测等问题展开扩展,发掘更多的实际应用场景。

路径推荐

- 张江老师根据因果涌现读书会第一季梳理的关于因果涌现的学习路径:https://pattern.swarma.org/article/153

- 张江老师根据因果涌现前五季读书会整理的因果涌现入门路径:https://pattern.swarma.org/article/296

本词条内容源自wikipedia及公开资料,遵守 CC3.0协议。

![[math]\displaystyle{ EI }[/math]与[math]\displaystyle{ \Gamma }[/math]对比](/images/thumb/0/03/Gamma%E4%BE%8B%E5%AD%90.png/500px-Gamma%E4%BE%8B%E5%AD%90.png)